NVIDIA Geforce 570GTX GF110 Sammelthread

Impressionen der Karte:

Weitere Bilder zur Karte, Detailaufnahmen der GPU und des Speichers findet ihr im Hardwareluxx-Artikel

Technische Daten der Geforce 570 GTX - GF110

- Chip = GF110

- Fertigung = 40 nm

- Chip Größe = 530 mm²

- Transistoren = 3,0 Milliarden.

- Chiptakt = 732 MHz

- Shadertakt = 1464 MHz

- Pixel-Pipelines = keine

- Shader-Einheiten (MADD) = 480 (1D)

- FLOPs (MADD/ADD) = 1,41 T.flops

- ROPs = 40

- Pixelfüllrate = 29,3 GPix/s

- TMUs = 60

- TAUs = 60

- Texelfüllrate = 43,9 GTexell/s

- Vertex-Shader = kein

- Unified-Shaderin Hardware = √

- Pixelshader = SM 5.0

- Vertexshader = SM 5.0

- Geometryshader = √

- Memory

- Art = Samsung

- Speichermenge = 1280 MB GDDR5

- Speichertakt = 950 MHz

- Speicherinterface = 320 Bit

- Speicherbandbreite = 152,0 GB/s

- Stromaufnahme >>> 219 Watt TDP Last / -- Watt TDP idle (über einen 2x 6xPin Anschluß)

- Die Karte besitzt Shader 5.0, dass heißt sie hat DX11 Unterstützung!

- Die Karte nutzt PCIe 2.0, ist aber völlig abwärtskompatibel.

Erste Tests der Karte:

Code:

[B]Single GPU:[/B]

[url=http://www.hardwareluxx.de/index.php/artikel/hardware/grafikkarten/17116.html][b]Test: NVIDIA GeForce GTX 570 (Hardwareluxx.de)[/b][/url]

[url=http://www.guru3d.com/article/geforce-gtx-570-review/]GeForce GTX 570 review (guru3d.com)[/url]

[url=http://www.computerbase.de/artikel/grafikkarten/2010/test-nvidia-geforce-gtx-570/]Test: Nvidia GeForce GTX 570 - 07.12.2010 - ComputerBase[/url]

[url=http://www.pcgameshardware.de/aid,802725/Nvidia-Geforce-GTX-570-fuer-350-Euro-im-Test-Grafikqualitaet-mit-Leistung-ueber-GTX-480-Niveau/Grafikkarte/Test/]Nvidia Geforce GTX 570 für 350 Euro im Test (PCGH)[/url]

[url=http://www.anandtech.com/show/4051/nvidias-geforce-gtx-570-filling-in-the-gaps]NVIDIA's GeForce GTX 570: Filling In The Gaps - AnandTech :: Your Source for Hardware Analysis and News[/url]

[url=http://www.tomshardware.com/reviews/geforce-gtx-570-gf110-performance,2806.html]GeForce GTX 570 Review: Hitting $349 With Nvidia's GF110 - tomshardware.com[/url]

[url=http://ht4u.net/reviews/2010/nvidia_geforce_gtx_570_gf110_test/]NVIDIA GeForce GTX 570 - erneute Schrumpfkur[/url]

[url=http://techpowerup.com/reviews/ASUS/GeForce_GTX_570/]ASUS GeForce GTX 570 - techPowerUp[/url]

[B]

SLI:[/B]

[url=http://www.guru3d.com/article/geforce-gtx-570-sli-review/]GeForce GTX 570 SLI review (guru3d.com)[/url]Geizhals Links:

Code:

[URL=http://preisvergleich.hardwareluxx.de/?cat=gra16_512&xf=132_1024~1439_GTX+570]HWluxx Preisvergleich - 570GTX[/URL]Taktraten der werksseitig übertakteten Modelle (Reihenfolge GPU/ Shader/ VRAM):

Code:

[LIST]

[*]- [URL="http://preisvergleich.hardwareluxx.de/a596943.html"]EVGA GeForce GTX 570 Superclocked (797MHz, 1594MHz, 975MHz)[/URL]

[*]- [URL="http://preisvergleich.hardwareluxx.de/a596985.html"]Point of View GeForce GTX 570 TGT Beast Edition[/URL] (?, ?, ?)

[*]- [URL="http://preisvergleich.hardwareluxx.de/a596559.html"]Point of View GeForce GTX 570 TGT Ultra Charged Edition[/URL] (?, ?, ?)

[*]- [URL="http://preisvergleich.hardwareluxx.de/a596992.html"]Point of View GeForce GTX 570 TGT Charged Edition[/URL] (?, ?, ?)

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[*]-

[/LIST]Treiber:

Code:

Alle Infos und neuste Treiber findet ihr in diesem Thread [URL="http://www.hardwareluxx.de/community/f14/die-aktuellen-nvidia-geforce-treiber-fuer-winxp-7-und-vista-weitere-os-part-6-a-781800.htmlhtml"]hier[/URL]

[B]Aktuelle finale Treiber[/B]

Windows XP x86/x64, Windows Vista x86/x64 und Windows 7 x86/x64:

[url=http://www.nvidia.de/Download/index.aspx?lang=de]klick mich[/url]Tools:

Code:

[COLOR="Red"][B]Grafikkarten Analyse Tool Gpu-Z[/B][/COLOR] [URL="http://www.techpowerup.com/downloads/811/TechPowerUp_GPU-Z_v0.0.9.html"]hier[/URL]

[B][COLOR="Red"]

RivaTuner zum OC der Graka[/COLOR][/B] [url=http://downloads.guru3d.com/downloadget.php?id=163&file=5&evp=2d213e528fb556c354432a3976bff55a]hier[/url]

[B][COLOR="Red"]NVIDIA-Inspector zum OC der Graka[/COLOR][/B] [url=http://www.hardwareluxx.de/community/f14/tool-nvidia-inspector-1-94-a-705213.html]hier[/url]

[B][COLOR="Red"]MSI Afterburner[/COLOR][/B] [url=http://www.computerbase.de/downloads/system/grafikkarten/msi-afterburner/]hier[/url]FAQ:

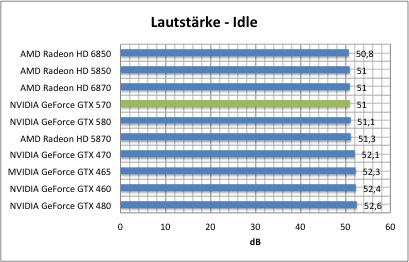

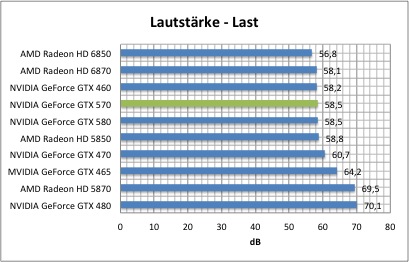

Wie laut ist die Karte?

- Im Vergleich zum großen Bruder, der 580GTX, bewegt sich die Karte sowohl unter Last, als auch ohne Belastung auf identischen Niveau. Dennoch kann man sagen, NVIDIA hat ihre Sache recht gut gemacht, denn die Karte legt zur Vorgängergeneration (470/480GTX - GF100) die Lautstärke etwas niedriger an. Im Vergleich zu den Leistungsmäßig etwas schwächeren HD58x0 sowie HD68x0 Karten von AMD liegt die 570GTX aber vorn, unter Last ist das AMD Single GPU Flackschiff etwas lauter. NVIDIAs Mittelklasse (460GTX) ist ebenso Lautstärketechnisch im gleichen Rahmen, dafür aber auch deutlich langsamer als die 570GTX.

Dennoch bleibt zu erwähnen, dass Lautstärke äußerst subjektiv ist. Man kann diese zwar einheitlich messen, aber jeder Mensch nimmt verschiedenen Frequenzen anders wahr.

Messungen zur Lautstärke

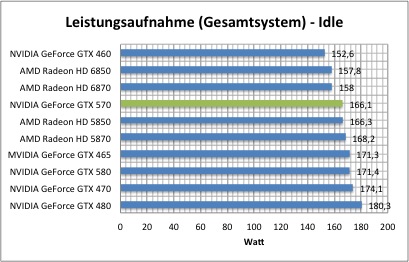

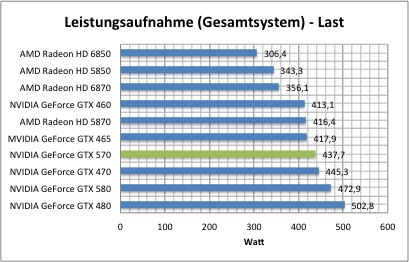

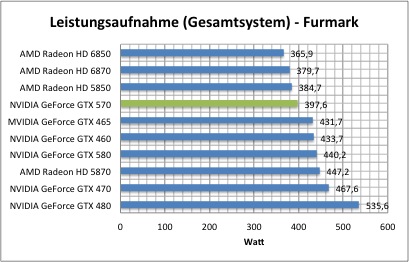

Wie hoch ist der Stromverbrauch?

- Auch beim Stromverbrauch hat NVIDIA ihre neue HighEnd Klasse wieder etwas effizienter gemacht. Im Vergleich zur 580GTX liegt man logischerweise etwas drunter. Aber die Vorgängerkarten der GF100 Reihe liegen sowohl im idle als auch unter Last ein gutes Stück drüber. Im Vergleich zu den Karten aus dem Hause AMD (HD5870/HD6870) bewegt man sich aber immernoch deutlich drüber.

Im absoluten Volllastbetrieb (Furmark) hat man deutlich abgebaut. Die Karte verbraucht nur minimal mehr als ihr direkter Vorgänger in Form der 470GTX. Es sei aber zu erwähnen, das es seit dem GF110 bei NVIDIA eine Schutzschaltung gibt, welche die Karten vor übermäßiger Last schützen soll. So erkennt die Software Programma ala Furmark und drosselt die Leistung. Auf Spiele soll das Vorgehen aber im Moment keine Auswirkung haben...

Schlussendlich kann man aber sagen, in Sachen Effizienz hat man auch hier ganz klar einen Schritt zugelegt, trotz gleichem Hestellungsprozess.

Messungen zum Stromverbrauch

(Gesamtsystemmessungen sind nicht 100% Vergleichbar)

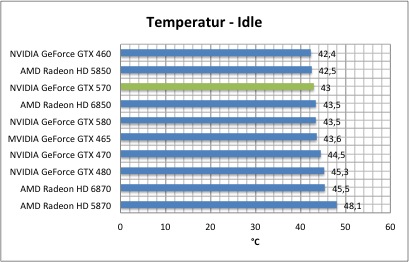

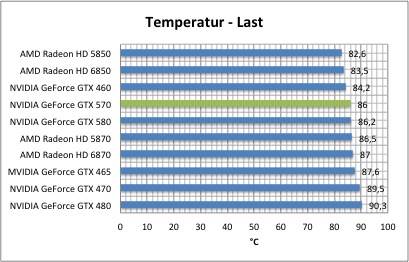

Wie heiß darf meine Karte werden?

- An der Lüftersteuerung hat man seitens NVIDIA nicht so viel getan. Die Karten werden immernoch vergleichsweise warm in Temperaturbereichen von 80°C+ unter Last. Die Temperaturen sind aber nicht krittisch, denn aktuelle GPUs sind bis über 100°C spezifiziert. Temperaturtechnisch bewegt man sich sowohl idle als auch im Lastbetrieb ca. auf gleichem Niveau mit der 580GTX. Im Vergleich zur Vorgängergeneration sind die Temperaturen etwas gesungen. Der Vergleich zu den AMD Karten ist hier etwas schwieriger. Unter Last liegt man minimal unter den AMD Karten, im idle ist der Unterschied schon etwas größer. Begründen lässt sich dies wohl durch einen langsamer drehenden Lüfter bei AMD.

Messungen zur Temperatur

Passt die Karte in mein Gehäuse?

- Mit einer Länge von exakt 27 cm ist das PCB nicht nur ähnlich der 580GTX, sondern so ziemlich identisch mit dem großen Bruder. Man geht also den Weg und nimmt ein PCB für mehrere Karten, lässt aber bei der 570GTX ein paar Bauteile weg. (RAM, Spannungsversorgung) Zum Vorgänger (470GTX) hat man aber etwas zugelegt in der PCB länge. Im Vergleich zur Konkurenz von AMD bewegt man sich aber deutlich über der HD6870 sowie HD5850. Einzig die HD5870 ist mit 1cm etwas länger. Potenzielle Käufer der Karten sollten sich dessen vorher bewusst sein und schauen, dass ihr Case auch dementsprechend Platz bietet. Die Stromanschlüsse wurden wie bei den Karten der HD58x0er Generation an die obere Kante der Karte gelegt.

Wie gut läßt sich die Karte übertakten?

- Das Übertaktungspotential der Karte scheint laut aktuellem Kenntnisstand NVIDIA typisch recht hoch auszufallen. Ohne Spannungserhöhung kann man mit einer Leistungssteigerung von guten 10-15% für GPU/Shader fast schon rechnen. Mit Spannungserhöhung geht es nochmals gut ein Stück bergauf.

Es bleibt aber abzuwarten wie man sich die Schutzschaltung schlussendlich auswirkt. Sofern NVIDIA wirklich nur die Anwendungen blockiert, wird dem Nutzer nichts auffallen. Dreht man aber irgendwann anhand des echten Verbrauchs an der Bremse, so bleibt vom Mehrtakt eventuell nicht mehr so viel übrig.

Beim Speicher lassen sich ebenso gute 10% übertakten. Speicher OC bringt aber Erfahrungsgemäß recht wenig zur Gesamtperformance. Auch ist es wie bei den GF100 GPUs üblich, das der Speichercontroller direkt an der Spannungsversorgung der GPU hängt, was bedeutet, sehr hoher Speichertakt bedarf einer Erhöhung der VGPU Spannung.

Per Bios Mod lassen sich die Spannungen auf bis über 1,2V erhöhen. Taktraten von 900MHz+ für die GPU sind damit sicherlich mit einigen Karten erreichbar.

Erste Overclocking-Versuche und Vergleichs-Benchmarks

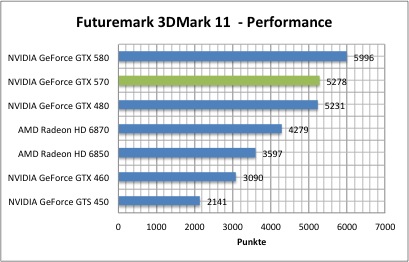

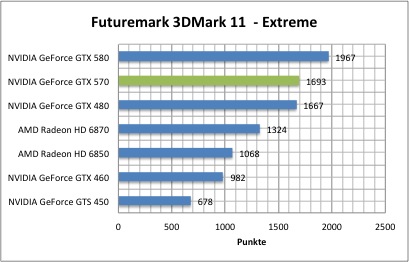

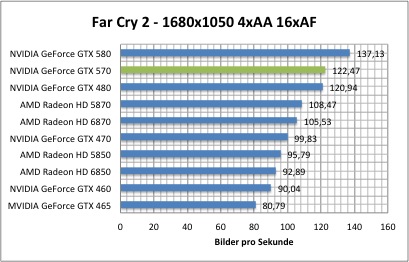

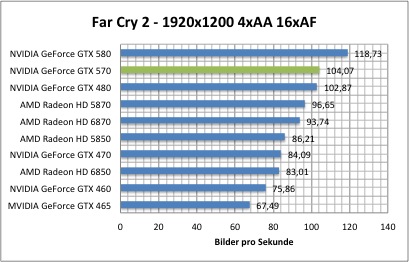

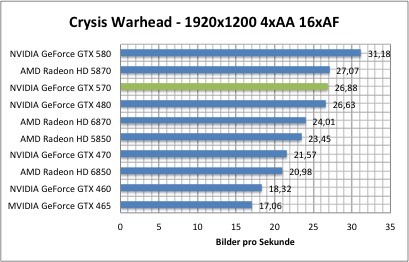

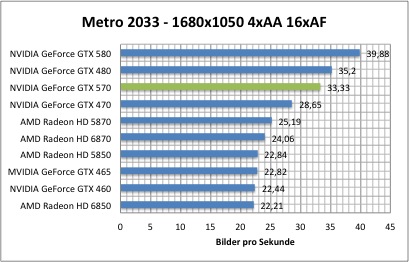

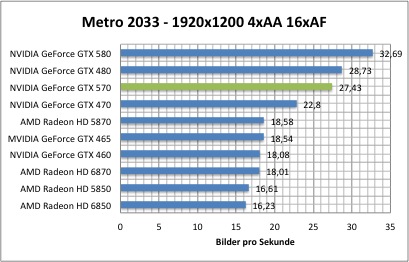

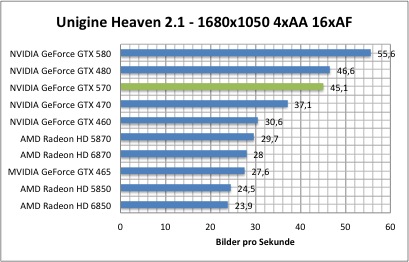

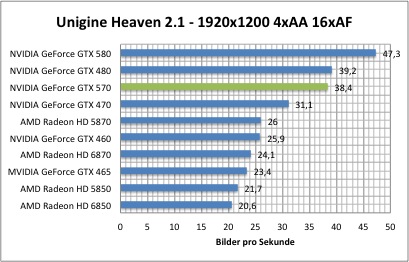

Performance

- Hier findet ihr eine kleine Auswahl von unseren Benchmarks um euch erstmal einen Überblick zu verschaffen, wo sich die Karte Leistungstechnisch einordnet. Alle weiteren Infos und Benchmarks findet ihr natürlich in unserem Online Artikel. Zu unserem Online Artikel gelangt ihr ->

Weitere Benchmarks im Hardwareluxx-Artikel zur ATI Radeon HD 6870

Andere Kühllösungen

- Wir werden sehen was uns erwartet

Allgemeine Hinweise

Um das Geflame, Gespame oder sonstige Unannehmlichkeiten zu minimieren wird gebeten, im Falle eines Verstoßes den „Beitrag-melden“ - Button (

Solche oder nicht Themenbezogene Beiträge werden dann entfernt.

Grüße, fdsonne

Zuletzt bearbeitet: