mgr R.O.G.

Urgestein

- Mitglied seit

- 05.01.2008

- Beiträge

- 8.876

- Ort

- Thüringen

- Desktop System

- Zockerkiste

- Laptop

- -

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800x3d - watercooled by HK IV Pro Black Copper

- Mainboard

- Gigabyte Aorus Master B550

- Kühler

- Mo-Ra 3 Pro @9x140 NB PK-3

- Speicher

- 2x16GB G.Skill TridentZ Neo 3600 CL14

- Grafikprozessor

- Palit RTX3090 Gaming Pro OC - watercooled by HK V Acryl Ni-Bl

- Display

- LG UltraGear 38GL950G @3840x1600

- SSD

- 2TB Corsair M.2 MP600

- HDD

- -

- Opt. Laufwerk

- -

- Soundkarte

- onboard Realtek ALC1220

- Gehäuse

- Cooler Master RC-840-KKN1-GP ATC 840 - black

- Netzteil

- be quiet! Dark Power Pro 10 650W

- Keyboard

- Logitech G213 Prodigy

- Mouse

- Logitech G400s

- Betriebssystem

- Win11 Pro x64

- Webbrowser

- Opera

- Sonstiges

- aquastream XT ultra, 16/11er BP Tüllen, 16/11er Schlauch, AC DP Ultra Red, Aquero 5 LT + AquaSuite

- Internet

- ▼GF300 MBit ▲GF150 MBit

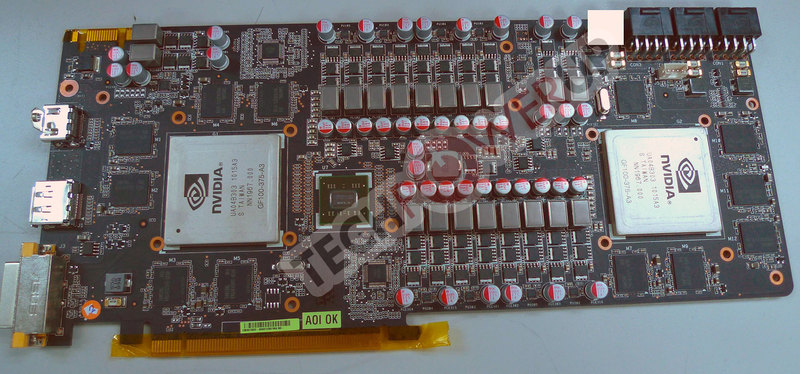

War irgendwie zu erwarten, das NV auch einen Gegner zur 6990 aus dem Hut zaubert. Man darf gespannt sein welche GF11Xer auf der GTX590 zum Einsatz kommen werden...

GTX580 = (75W +75W +150W=max.300W) -> von NV mit max. 244W angegeben

GTX590 = (75W+150W+150W= max.375W) -> von mir spekulierte theoretische 320W-340W

Das Maximum darf aber lt. Spezifikation "normalerweise" 300W nicht übersteigen oder? Bin gespannt, wie sie das hinbekommen wollen und was sie für einen Kühler entwickeln. Tippe auf Model "Fön" .

.

HD6970 und HD6990 KOMMEN erst noch (Dez/Jan)! Woher weisst du das sie "auf ganzer Linie" versagen werden ... Hellseher ?

?

PS: Fehlt da net ein "L" in deinem Namen ?

?

.

.

Sollten sich einige mal unters Kopfkissen legen oder einrahmen .

.

GTX580 = (75W +75W +150W=max.300W) -> von NV mit max. 244W angegeben

GTX590 = (75W+150W+150W= max.375W) -> von mir spekulierte theoretische 320W-340W

Das Maximum darf aber lt. Spezifikation "normalerweise" 300W nicht übersteigen oder? Bin gespannt, wie sie das hinbekommen wollen und was sie für einen Kühler entwickeln. Tippe auf Model "Fön"

.

. What?AMD hat zwar vorher schon nicht gut dagestanden, aber mit der DualGPU von NV haben die jetzt entgültig auf ganzer Linie versagt mit der HD6er.

HD6970 und HD6990 KOMMEN erst noch (Dez/Jan)! Woher weisst du das sie "auf ganzer Linie" versagen werden ... Hellseher

?

?PS: Fehlt da net ein "L" in deinem Namen

?

? Für eine GTX590 im System wird sicherlich ein gutes 650W NT ausreichen.Aber glaube wenn man die im SLI laufen lässt bzw Solo mit den recht guten Gamer rechner also X4 bzw X6 sollte man schon mindestens 650 Watt + haben besser 700 oder 800watt

So schauts ausLeute die meinen der Verbrauch verdoppelt sich haben keine Ahnung.

Eine GTX 275 hat eine TDP von 216W, also genauso viel.

Eine GTX 295 besteht aus zwei GTX 275ern, trotzdem liegt die TDP lediglich bei 289 Watt und nicht wie die meisten hier laut Milchmädchenrechnung 432 Watt vermuten würden.

.

. Sollten sich einige mal unters Kopfkissen legen oder einrahmen

.

.