NVIDIA GeForce GTX 660 Ti (GK104) Sammelthread + FAQ

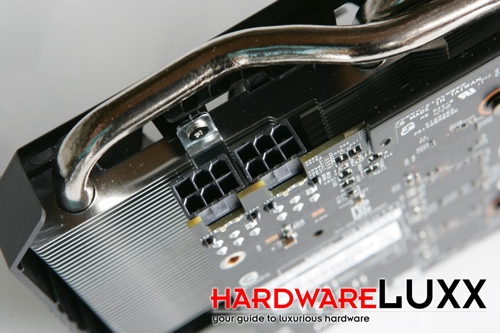

Impressionen der Karte (Beispiel Asus Direct Cu II TOP):

Technische Daten der GeForce GTX 660 Ti

- Chip = GK104

- Fertigung = 28 nm (TSMC)

- Transistoren = 3,54 Milliarden

- Die-Größe = 294 mm²

- Chiptakt = 915 MHz + Boost (980 MHz)

- Shadertakt = Chiptakt (915 MHz + Boost (980 MHz))

- Speichertakt = 1502 MHz

- Speichergröße = 2048 MB

- Speichertyp = GDDR5 (Samsung)

- Speicherinterface = 192 Bit

- Speicherbandbreite = 144,2 GB/Sek.

- Shader Model = 5.1

- DirectX = 11.1

- Shader-Einheiten = 1344 (1D)

- Texture Mapping Units (TMUs) = 112

- Raster Operations (ROPs) = 24

- Pixelfüllrate = 22 GPix/s

- Texelfüllrate = 102 GTex/s

- Leistungsaufnahme 3D (TDP) = 150 Watt

- Leistungsaufnahme 2D = 15 Watt

- Versorgung über zwei 6-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = Abhängig vom Hersteller, da Nvidia kein Referenzdesign anbietet

- Hinweis: Multi-Monitoring = Die Karte kann bis zu vier Monitore gleichzeitig ansteuern, im 3D Modus maximal drei.

- Hinweis: Je nach Taktraten können Rechenleistung, Pixelfüllrate und Texelfüllrate sowie der Stromverbrauch abweichen.

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Einzelkartentests:

- deutsch:

- EVGA/Zotac/Asus

[*]HardwareLUXX - Test: NVIDIA GeForce GTX 660 Ti- Asus/Gainward/KFA²/MSI

- Computerbase - Test: Nvidia GeForce GTX 660 Ti

- Asus

- HT4U - ASUS GTX 660 Ti DC2 Top

- Palit

- Gamestar - PALIT Geforce GTX 660 Ti Jetstream im Test

- Asus/Gainward/Gigabyte/KFA²/MSI/Palit/Zotac

- Tom's Hardware - 7 x GTX 660 Ti - Roundup und Bandbreitenanalyse

- Gigabyte

- PCWelt - Gigabyte Geforce GTX 660 Ti im Test

- Gainward/MSI/EVGA

- TweakPC - NVIDIA GeForce GTX 660 Ti - 3 Modelle im Vergleich

- -

- englisch:

- Galaxy (3 GB VRAM)

- HARD|OCP - GALAXY GeForce GTX 660 Ti GC 3GB Video Card Review

- Asus/EVGA/MSI

- Legit reviews - NVIDIA GeForce GTX 660 Ti Video Card Review

- Hardware.info - Nvidia GeForce GTX 660 Ti review

- Zotac/EVGA/Gigabyte

- Anandtech - The GeForce GTX 660 Ti Review

- Zotac/EVGA/Gigabyte/MSI

- Hothardware - NVIDIA GeForce GTX 660 Ti Round-Up Review

- -

Geizhals Link:SLI-Tests:

- deutsch:

- Tom's Hardware - 2-way SLI

- Computerbase - 2-way SLI

- -

- englisch:

- Hardware.info - 2 und 3-way SLI

- -

HardwareLUXX Preisvergleich - Geforce 660 Ti

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

Oder direkt bei Nvidia

Tools:

- Grafikkarten Analyse Tool GPU-Z hier

- MSI Afterburner hier

- FurMark VGA Stress Test hier

- Sapphire TriXX GPU Tweak Utility hier

- Futuremark 3D Mark 11 (Basic Edition) hier

- Unigine Heaven Benchmark hier

FAQ (Frequently Asked Questions):

Brauche ich nun unbedingt ein Mainboard mit PCI-E 3.0?

Laut dem Test von VR-Zone bringt der PCI-E 3.0 Slot bei einer 7970 keine Leistungssteigerung.

Auch die Messungen auf Hardwareluxx mit einer GTX 690 bestätigen dieses Ergebnis. Hardwareluxx - Seite 19: Sondertests: PCI-Express 3.0

Damit kann man die Messungen anderer Reviews der aktuellen Grafikkartengeneration, ob Single oder Dual GPU 1:1, an der Stelle übernehmen und muss für eine Grafikkarte nicht extra umrüsten. Tests zur Quad-SLI Performance sind aber noch nicht verfügbar.

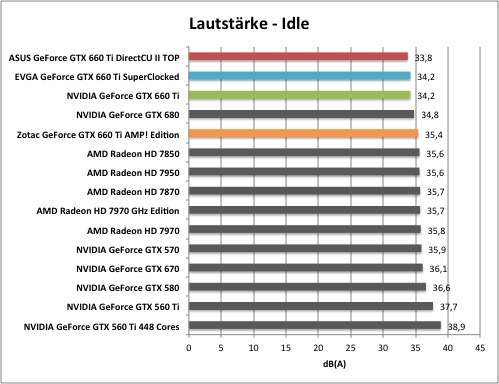

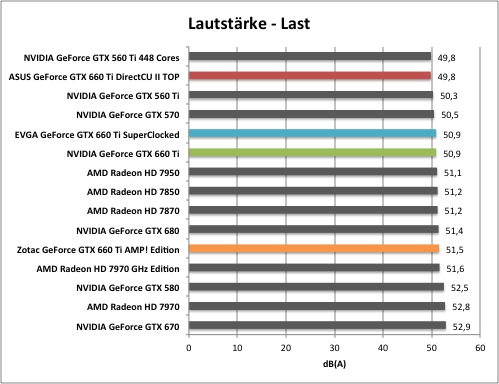

Wie laut ist die Karte?

Es gibt bei der 660 Ti kein wirkliches Referenzdesign, daher variieren hier die Messungen sehr stark, je nach Hersteller. Im Hardwareluxx-Test war die Direct Cu II unter Last am leisesten.

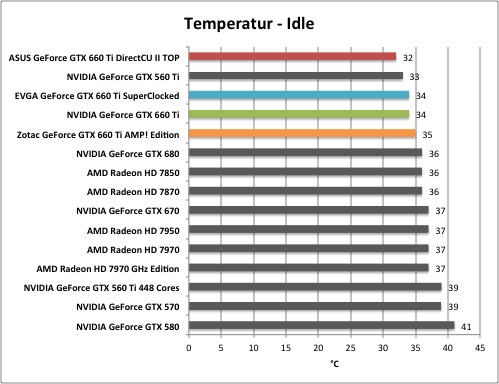

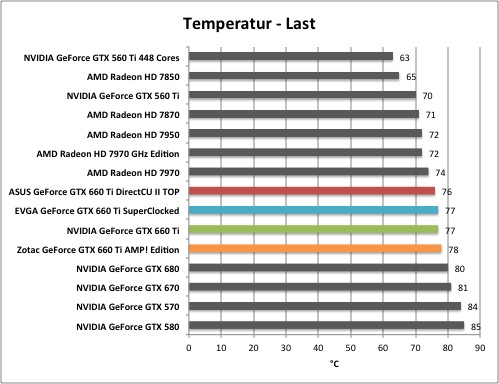

Wie hoch sind die Temperaturen der Karte?

Das hängt wieder vom verwendeten Modell ab, allerdings lagen im Hardwareluxx-Review die getesteten Varianten hier dicht zusammen.

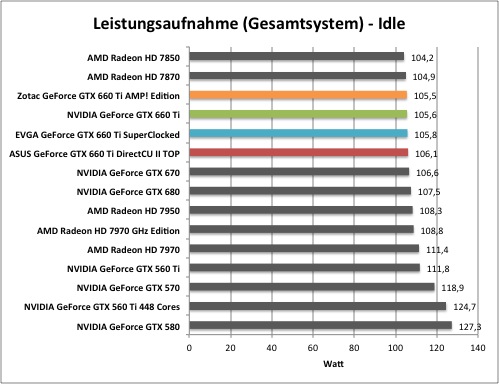

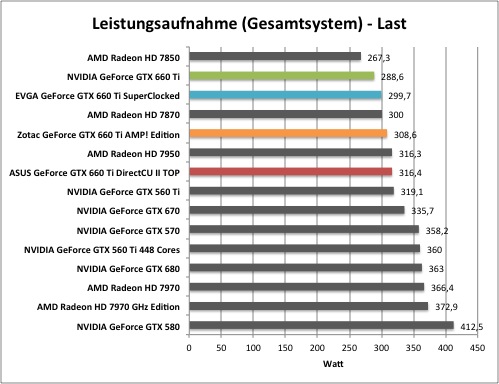

Wie hoch ist der Stromverbrauch?

Hinweis: Die Verbrauchsmessungen (Karte only) stammen von HT4U -> klick

Im Idle verbraucht die 660 Ti DC2 TOP von Asus ca. 17 Watt, was in Ordnung ist, allerdings höher ausfällt als z.B. bei der GTX670. Unter Spielelast nimmt die Karte (HT4U-Testmuster) etwa 129 Watt auf, lockert man allerdings das Power Target, so sind es 148 Watt - ebenso wie im Furmark Test. Nvidia drosselt also die maximale Leistungsaufnahme der Karte und verwehrt dem Nutzer dadurch natürlich auch ein gewisses Maß an Mehrleistung.

Hier die Messungen (gesamtes System) von Hardwareluxx:

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen!

Passt die Karte in mein Gehäuse?

Bei der Asus Direct Cu II Top misst das PCB kleine 23,1 cm. Der Kühler steht hier mit 27,1 cm deutlich über. Da es kein Referenzdesign gibt kocht hier aber jeder Hersteller sein eigenes Süppchen, es gilt also sich vorher im Luxx oder in Reviews zu informieren.

Wie gut läßt sich die Karte übertakten?

Wie bei jeder GK104 Karte lässt sich der Takt von Speicher und GPU/Shader nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate. Oben drauf gewährt NVIDIA dem Nutzer noch einen Turbo-Mode, welcher den OC Ergebnissen mal mehr, mal weniger im Weg steht.

Die Höhe der Turbotaktrate wird vollständig durch die Hardware geregelt. Es halten aber Messwerte wie Temperatur und anliegende Last in der Ermittlung der Höhe mit Einzug. So schwankt die Taktrate der GPUs ein paar MHz während der Anwendung.

Im Test liegen keine Übertaktungsergebnisse vor.

Übertaktungs-Kurzanleitung von marvinator (ursprünglich für die 670, funktioniert aber analog):

OC-Kurzanleitung:

Was wird benötigt?

Zeit, Unigine Heaven 3.0, EVGA Precision X oder MSI Afterburner, (Crysis 2, BF3, Dirt3)

Was gilt es zu beachten?

Temperatur! Liegt nicht 1.175V an ist die Temperatur zu hoch (ab 70°C oder ab 63°C). Die Spannung lässt sich nicht erhöhen und MinV anheben bringt nichts. Wer eine EVGA FTW oder GB OC 3X hat kann aber auf custom BIOS-Mods zurückgreifen.

Wie gehe ich vor?

- RivaTuner OSD von Precision/Afterburner konfigurieren (s.u.)

- Lüfterkurve mit Precision/Afterburner anpassen, sodass 70°C auf keinen Fall überstiegen werden

- im nV-Treiber unter 3D-Einstellungen "Energieverwaltungsmodus" auf "maximale Leistung bevorzugen" stellen und auf Einzel-Display-Leistungs-Modus wechseln

- Heaven mit max. Settings starten (Fenstermodus wenn man es bequem will geht auch; Auslastung ist hoch genug)

- Power Target auf max. stellen und beobachten, was der real anliegende Takt ist (1.175V) -> nur der zählt!

- probeweiser GPU Offset so einstellen, das es 1250MHz ergibt -> Heaven 5-10min laufen lassen (1-2 Benchmark runs)

- wenn das zu viel war, stürzt Heaven ab und es erscheint eine Treiber-wurde-zurückgesetzt-Meldung

- von hier aus kann man sich in +10MHz (bzw. -10MHz) Schritten und je einem Benchmark run vorantasten, das reicht zum groben ausloten

- vermutlich finalen Offset etwa 30min mit Heaven laufen lassen, danach ist die Chance hoch, dass es so passt

- beim Memory Offset mit +200MHz anfangen -> 2-3 runs testen

- in +100MHz Schritten herantasten

- MemOC (ohne GPU OC und danach mit) mit o.g. oder mindestens ähnlich anspruchsvollen Spielen 20-30min testen

- 3-4 Stunden unter hoher Spielelast müssen so nicht stabil laufen, da kann es immer noch ein wenig zu viel für sein -> ausprobieren!

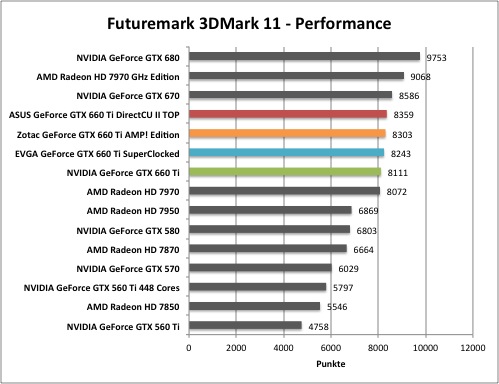

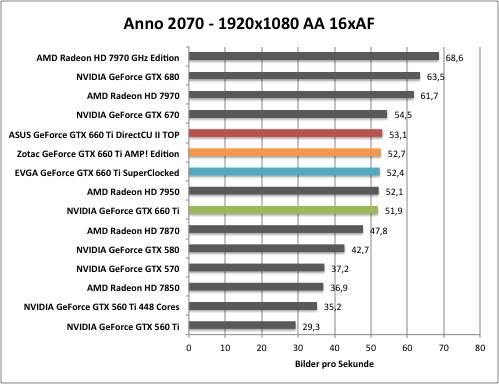

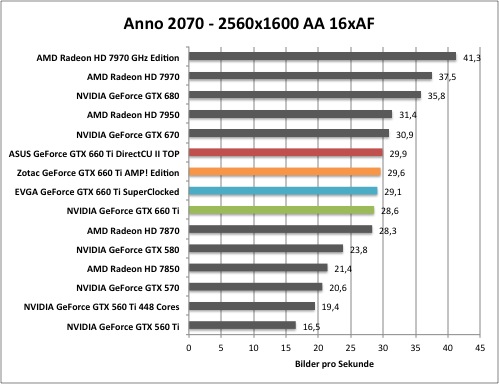

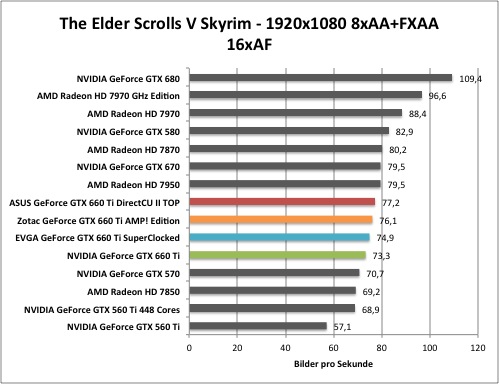

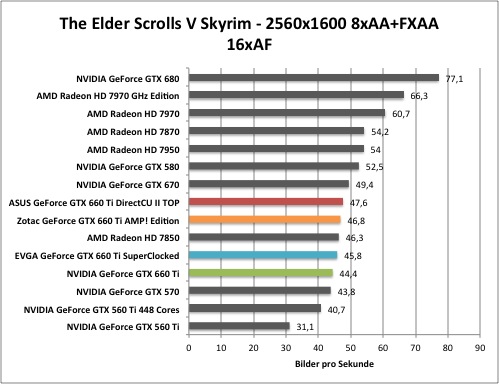

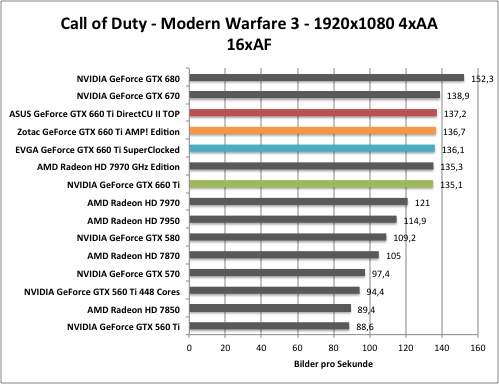

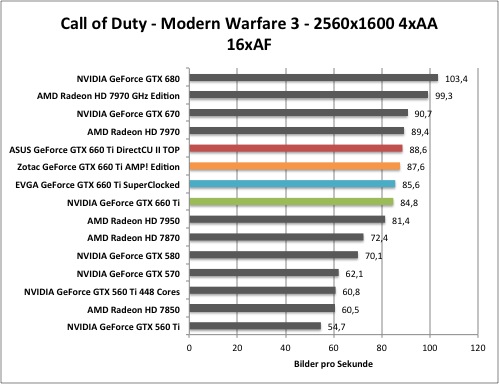

Die Performance:

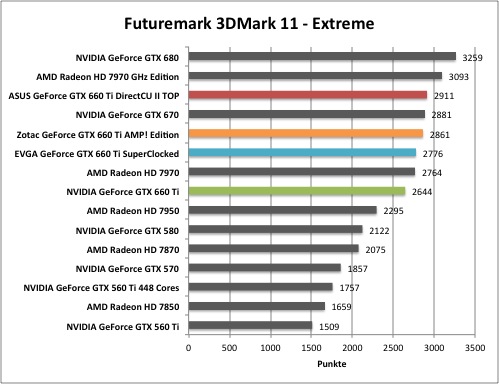

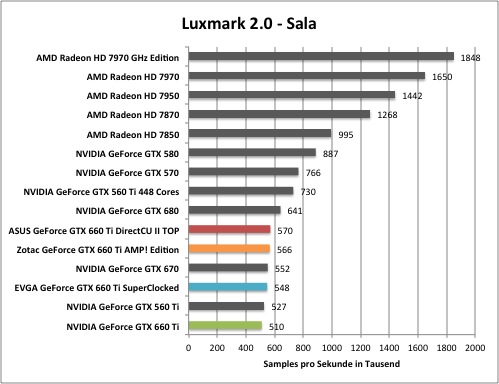

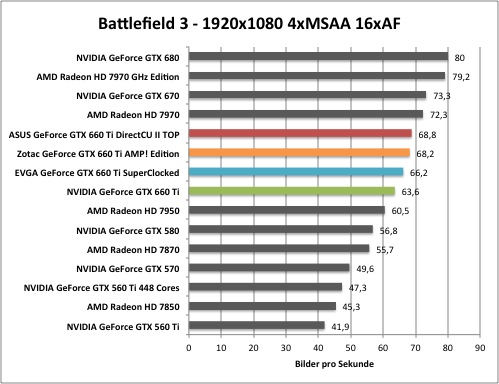

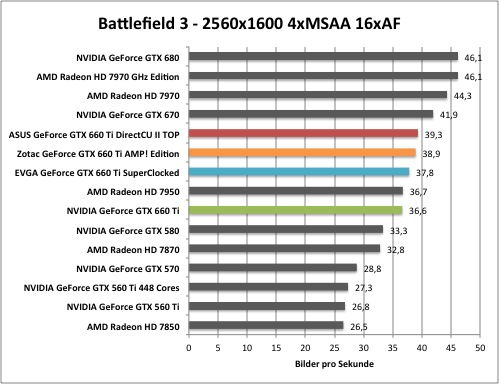

Hier findet ihr eine kleine Auswahl von unseren Benchmarks um euch erstmal einen Überblick zu verschaffen, wo sich die Karte Leistungstechnisch einordnet. Alle weiteren Infos und Benchmarks findet ihr im Hardwareluxx Artikel zur GeForce GTX 660 Ti!

Synthetische Benchmarks

Game Benchmarks

Andere Kühllösungen

Laut Arctic Cooling werden der Accelero Twin Turbo 2, der Accelero Mono Plus, der Accelero Xtreme 3 und der Accelero Hybrid zur 660 Ti kompatibel sein.

Erhältliche WaKü-Blocks für die GeForce GTX 660 Ti:

http://www.hardwareluxx.de/communit...ammelthread-bitte-startpost-lesen-895012.html

Allgemeine Hinweise

Dies ist ein Sammelthread für die Geforce GTX 660 Ti. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 6x0 und Radeon HD 7xx0 uvm.) angemessen.

Um das Geflame, Gespamme oder sonstige Unannehmlichkeiten zu minimieren wird gebeten, im Falle eines Verstoßes gegen die Forenregeln den „Beitrag-melden“ - Button (

Solche oder nicht themenbezogene Beiträge werden dann entfernt. Ggfls. können mehrmalig auffällige User auch aus dem Thread ausgeschlossen werden.

Gruß

Die Moderation des Grafikkarten-Unterforums

Zuletzt bearbeitet: