NVIDIA GeForce GTX 680 Sammelthread

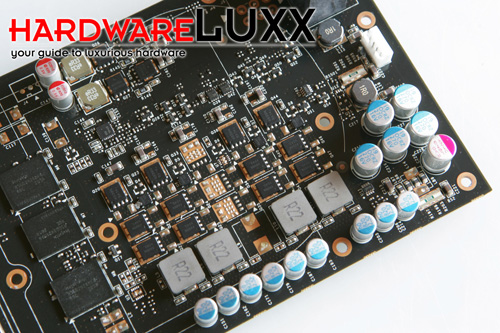

Impressionen der Karte:

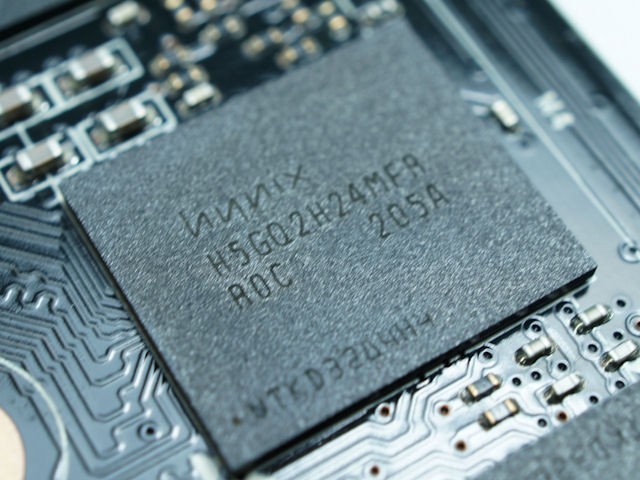

Bild und Hinweis zum verbauten GDDR5 VRAM (Hynix H5GQ2H24MFR-R0C):

Hinweise: Der Hynix GDDR5 VRAM (vermutlich 0,3 ns) ist für 1500 MHz Realtakt spezifiziert und wird mit 1,6V betrieben. Dieser fand etwa auch schon bei der Radeon HD 7970 Verwendung.

Unboxing-Bilder meiner ersten Zotac GeForce GTX 680:

Vergleich GeForce GTX 680 zu GeForce GTX 580:

Technische Daten der GeForce GTX 680

- GPU = GK104

- Fertigung = 28 nm (TSMC)

- Transistoren = 3,54 Milliarden

- Die-Größe = 294 mm²

- Chiptakt = 1006 MHz (mit Boost zwischen 1058 bis 1110 MHz)

- Shadertakt = (mit Boost zwischen 1058 bis 1110 MHz)

- Speichertakt = 1502 MHz

- Speichergröße = 2048 MB nach Referenz (8 x 256 MB; 4096 MB durch Boardpartner möglich -> 16 x 256 MB)

- Speichertyp = GDDR5 (Hynix auf 6.0 Gbps bzw. 1500 MHz spezifiziert, vermutl. 0,3 ns => effektiv 1,2 ns)

- Speicherinterface = 256 Bit

- Speicherbandbreite = 192,256 GB/s

- Shader Model = 5.0

- DirectX = 11.1

- Shader-Einheiten = 1536 (1D)

- SMX Einheiten (weiterentwickelte Streaming Multiprocessors; je 192 (1D) Shader pro SMX) = 8

- Texture Mapping Units (TMUs) = 128

- Raster Operations (ROPs) = 32

- Rechenleistung Single Precision (SP) (MADD) = 3090,432 GFlops (ohne Boost)

- Rechenleistung Double Precision (DP) (MADD) = ~ 128,768 GFlops -> 1/24 SP Leistung bei GK104

- Pixelfüllrate = 32,192 GPixel/s (ohne Boost)

- Texelfüllrate = 128,768 GTexel/s (ohne Boost)

- maximale Leistungsaufnahme 3D inkl. Boost und mit Power Target @ 100 % (TDP) = 195 Watt

- durchschnittliche Leistungsaufnahme 3D = 170 Watt (schwankt je nach Spiel/GPU-Auslastung -> Boost oder eben auch Taktabsenkung ohne manuell festgelegte Target-fps)

- maximale Leistungsaufnahme 2D = 15 Watt

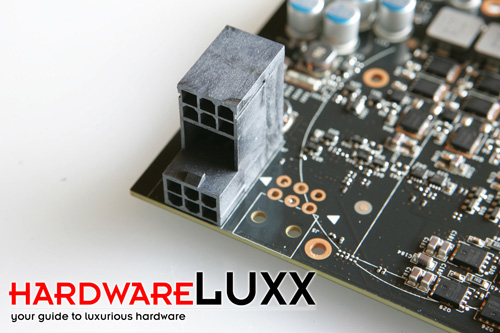

- Stromaufnahme >= 150 Watt (Versorgung über 2 x 6 Pin PCIe Anschluss)

- Anschlussmöglichkeiten = 2 x DVI (Dual-Link), 1 x HDMI 1.4a, 1 x DisplayPort 1.2 (unterstützt 4 Monitore gleichzeitig, also auch 3D Vision Surround per DVIs und HDMI und ein Monitor in Windows per DisplayPort bzw. DP-Adapter!)

- Die Karte besitzt Shader Model 5.0, das heißt sie hat volle DX11.1 und auch OpenGL 4.2 Unterstützung!

- -

- -

- 65 mm Radiallüfter

- Taktraten Idle (1 Monitor) Chip/Speicher - P8 = 324/162 MHz @ 0,987V

Taktraten Low-3D (1 Monitor) Chip/Speicher- P5 = 540/405 MHz @ 0,987V - Taktraten Idle/Low-3D (2 bis 4 Monitore) Chip/Speicher - P2 = 550/1502 MHz @ 0,987V (angeblich sogar doch nur im P8, zumindest die meiste Zeit)

Kurzvorstellung der GeForce GTX 680 seitens NVIDIA:

NVIDIA GeForce GTX 680 Release Video - YouTube

GeForce GTX 680 Wallpaper: klick

Einige Tests der Karte (SLI Tests, Einzelkartentests):

Code:

[LIST]

[*][B][COLOR="red"]SLI-Tests[/COLOR]:[/B]

[*].

[*]deutsch:

[*].

[*][url="http://ht4u.net/reviews/2012/nvidia_geforce_gtx_680_kepler_sli_evga_zotac_test/"]HT4U - GeForce GTX 680 SLI (EVGA und Zotac)[/url]

[*][url="http://www.computerbase.de/artikel/grafikkarten/2012/kurztest-gtx-680-sli-vs.-hd-7970-cf/"]ComputerBase - GeForce GTX 680 SLI gegen Radeon HD 7970 CFX (Kurztest) inkl. Surround-Gaming[/url]

[*].

[*].

[*]englisch:

[*].

[*][url="http://nl.hardware.info/reviews/2641/nvidia-geforce-gtx-680-quad-sli-review-english-version"]HardwareInfo - GeForce GTX 680 4-Way SLI und SLI[/url]

[*][url="http://www.guru3d.com/article/geforce-gtx-680-3way-sli-review/"]Guru3D - GeForce GTX 680 3-Way SLI[/url]

[*][url="http://www.guru3d.com/article/geforce-gtx-680-sli-review/"]Guru3D - GeForce GTX 680 SLI[/url]

[*][url="http://www.hardocp.com/article/2012/03/28/nvidia_kepler_geforce_gtx_680_sli_video_card_review/1"][H]ard|OCP - GeForce GTX 680 SLI[/url]

[*][url="http://www.hardwareheaven.com/reviews/1453/pg1/zotac-geforce-gtx-680-graphics-card-sli-performance-review-introduction.html"]HardwareHeaven - Zotac GeForce GTX 680 SLI inkl. Surround[/url]

[*][url="http://www.guru3d.com/article/geforce-gtx-680-sli-review/"]Guru3D - Zotac GeForce GTX 680 SLI[/url]

[*][url="http://www.techpowerup.com/reviews/ASUS/GeForce_GTX_680_SLI/"]TechPowerUp! - ASUS GeForce GTX 680 SLI[/url]

[*][url="http://www.youtube.com/watch?v=kEPL1SilkJ8"]Newegg.TV - GeForce GTX 680 Vorstellung inkl. (SLI-) Synthetische Benchmarks (3DM11, Vantage und Heaven 2.5 ab 4:30 Min.[/url]

[*].

[*].

[*].[*][B]Einzelkartentests - [COLOR="red"]Referenz-Design[/COLOR]:[/B]

[*].

[*]deutsch:

[*].

[*][url="http://www.hardwareluxx.de/index.php/artikel/hardware/grafikkarten/21816-test-nvidia-geforce-gtx-680.html"]HardwareLUXX - NVIDIA GeForce GTX 680 [/url]

[*][url="http://www.computerbase.de/artikel/grafikkarten/2012/test-nvidia-geforce-gtx-680/"]ComputerBase - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.pcgameshardware.de/aid,873907/Test-Geforce-GTX-680-Kepler-GK104/Grafikkarte/Test/"]PCGH - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.tomshardware.de/geforce-gtx-680-test-benchmarks-Kepler-GK104,testberichte-240979.html"]Tom's Hardware - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.gamestar.de/index.cfm?pid=1589&pk=65407"]GameStar - NVIDIA GeForce GTX 680 Video-Test (8:49 Min.)[/url]

[*].

[*].

[*]englisch:

[*].

[*][url="http://www.hardwarecanucks.com/forum/hardware-canucks-reviews/52616-nvidia-geforce-gtx-680-2gb-review.html"]Hardware Canucks - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.guru3d.com/article/geforce-gtx-680-review/"]Guru3D - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.anandtech.com/show/5699/nvidia-geforce-gtx-680-review"]Anandtech - NVIDIA GeForce GTX 680 [/url]

[*][url="http://www.hardwareheaven.com/reviews/1452/pg1/nvidia-geforce-gtx-680-kepler-graphics-card-review-introduction.html"]HardwareHeaven - NVIDIA GeForce GTX 680 inkl. Surround[/url]

[*][url="http://www.techpowerup.com/reviews/NVIDIA/GeForce_GTX_680/"]TechPowerUp! - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.hardocp.com/article/2012/03/22/nvidia_kepler_gpu_geforce_gtx_680_video_card_review"][H]ard|OCP - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.pcper.com/reviews/Graphics-Cards/NVIDIA-GeForce-GTX-680-2GB-Graphics-Card-Review-Kepler-Motion"]PC Perspective - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.youtube.com/watch?v=ER3nv7NTwbs"]PC Perspective - Live-Review Stream: NVIDIA GeForce GTX 680 mit Tom Petersen (Director of Technical Marketing bei NVIDIA) (1:49:52 Std.)[/url]

[*][url="http://www.overclock3d.net/reviews/gpu_displays/nvidia_gtx680_review/1"]Overclock3D - NVIDIA GeForce GTX 680[/url]

[*][url="http://www.youtube.com/watch?v=Y8RZDPjMttY&feature=player_embedded"]Overclock3D TV - NVIDIA GeForce GTX 680 (39:30 Min.)[/url]

[*][url="http://www.legitreviews.com/article/1881/1/"]Legit Reviews - NVIDIA GeForce GTX 680[/url]

[*].

[*].

[*][B]Einzelkartentests - [COLOR="Red"]OC bzw. Non-Referenz-Design (bzw. meist PCB im Referenzdesign, aber anderer Kühler) [/COLOR]:[/B]

[*].

[*]deutsch:

[*].

[*][url="http://www.hardwareluxx.de/index.php?option=com_content&view=article&id=22051 &catid=74&Itemid=170"]HardwareLUXX - Palit GeForce GTX 680 JetStream[/url]

[*][url="http://www.tomshardware.de/Gigabyte-GTX-680-Windforce-X3,testberichte-240990.html"]Tom's Hardware - Gigabyte GeForce GTX 680 OC Windforce X3 (GV-N680OC-2GD)[/url]

[*].

[*].

[*]englisch:

[*].

[*][url="http://www.hardwarecanucks.com/forum/hardware-canucks-reviews/53144-evga-geforce-gtx-680-sc-review.html"]Hardware Canucks - EVGA GeForce GTX 680 SC+ (2GB)[/url]

[*][url="http://www.guru3d.com/article/gigabyte-geforce-gtx-680-oc-edition-review/"]Guru3D - Gigabyte GeForce GTX 680 OC Edition (2GB)[/url]

[*][url="http://www.guru3d.com/article/palit-geforce-gtx-680-jetstream-review/"]Guru3D - Palit GeForce GTX 680 JetStream 2GB [/url]

[*][url="http://www.hardwareheaven.com/reviews/1461/pg3/palit-geforce-gtx-680-jetstream-edition-graphics-card-review-the-card.html"]Hardware Heaven - Palit GeForce GTX 680 JetStream 2GB[/url]

[*][url="http://www.hardwareheaven.com/reviews/1461/pg3/palit-geforce-gtx-680-jetstream-edition-graphics-card-review-the-card.html"]Hardware Heaven - Palit GeForce GTX 680 JetStream 2GB[/url]

[*][url="http://translate.google.de/translate?hl=de&sl=zh-CN&tl=en&u=http%3A%2F%2Fwww.expreview.com%2F19011.html"]EXPreview - Zotac GeForce GTX 680 Extreme Edition (Kurz-Review -> Google Translator @ englisch)[/url]

[*].

[/LIST]Geizhals Links:

Code:

[URL=" "]HardwareLUXX Preisvergleich - GeForce GTX 680[/URL]Treiber & nützliche Tools:

Alle Infos über die aktuellen Treiber für Windows XP/7/Vista sowie weitere OS und nützliche Tools findet ihr in diesem Thread hier

nVidia Techdemos:

Code:

[LIST]

[*] [URL="http://www.youtube.com/watch?v=2Fp5N-pOxKA"]NVIDIA CUDA/PhysX-Kepler-Techdemos - Pillars (dynamische Zerstörung dank PhysX) & Fur (aufwendige Echtzeit Haarsimulation)[/URL]

[*] [URL="http://www.nvidia.de/object/cool_stuff_de.html#/demos/2678"]Alien vs. Triangles[/URL]

[*] [URL="http://www.nvidia.de/object/cool_stuff_de.html#/demos/2664"]Endless City[/URL]

[*] [URL="http://www.nvidia.de/object/cool_stuff_de.html#/demos/2123"]Supersonic Sled[/URL]

[*] [URL="http://www.nvidia.de/object/cool_stuff_de.html#/demos/2122"]Design Garage[/URL]

[*] [URL="http://downloads.guru3d.com/downloadget.php?id=2541&file=4&evp=ff4e7fdf8c5ee9708ad2a45af75af3d7"]Hair-Demo[/URL]

[*] [URL="http://downloads.guru3d.com/downloadget.php?id=2542&file=4&evp=152d5d1b601f30588c6b1029baf59fb2"]Island-Demo[/URL]

[*] .

[*] [B]Noch nicht als Download verfügbar:[/B]

[*] [URL="http://www.hardwareluxx.de/index.php/downloads/software/systemutilities/doc_details/140-ragingrapidsride.html"]Raging Rapid Ride[/URL]

[*] NVIDIA GF100 Fluids (PhysX Based Water) Demo

[/LIST]Weitere DX11 Benchmarks / Techdemos:

Code:

[LIST]

[*] [URL="http://www.hardwareluxx.de/index.php/downloads/benchmarks/3d-grafik/doc_download/166-futuremark-3dmark-11.html"]Futuremark 3D Mark 11 (Basic Edition)[/URL]

[*] [URL="http://www.techpowerup.com/downloads/2111/Unigine_Heaven_DX11_Benchmark_3.0.html"]Unigine Heaven 3.0 Benchmark[/URL]

[*] [URL="http://www.hardwareluxx.de/index.php/downloads/benchmarks/3d-grafik/doc_download/170-unigine-heaven-25.html"]Unigine Heaven 2.5 Benchmark[/URL]

[*] [URL="http://www.techpowerup.com/downloads/1799/Unigine_Heaven_DX11_Benchmark_2.1.html"]Unigine Heaven 2.1 Benchmark[/URL]

[*] [url="http://www.pcgameshardware.de/aid,745728/Download-Stone-Giant-Sehenswerte-DirectX-11-Techdemo-fuer-HD-5000-und-GTX-400/Benchmark/Download/#dl_anchor"]Stone Giant 1.0 Techdemo (leider keine Benchmark Auswertung a la Heaven integriert -> per OSD via FRAPS lassen sich z.B. zusätzlich auch min. und max. fps aufzeichnen, Stone Giant kann nur current & avg. fps ! ;))[/URL]

[*] .

[*] [B]Hinweis zur Bedienung in Stone Giant: Wichtigste Tasten -> F1 (Wireframe Modus ON/OFF), F2 (Tesselation Modi), F3 (Diffusion DoF (Depth of Field = Tiefenunschärfe) ON/OFF), F4 (current & avg. fps Counter ON/OFF), Pfeiltasten + Maus = freier Flug, ENTER = Benchmark Run) [/B]

[*] .

[*] [URL="http://www.pcgameshardware.de/aid,699738/DirectX-11-Benchmark-Stalker-Call-of-Pripyat-Update-1080p-Youtube-Video-zeigt-DX9-bis-DX11-im-Direktvergleich/Benchmark/Download/#dl_anchor"]S.T.A.L.K.E.R. - Call of Pripyat Benchmark-Tool (getestet wird Day, Night (Gewitter), Rain und Sun - Ergebnisse als min., avg. und max. fps) [/URL]

[*] [url=http://downloads.guru3d.com/Aliens-vs.-Predator-DirectX-11-Benchmark-Tool-download-2553.html]Aliens vs. Predator DirectX 11 Benchmark Tool[/url]

[*] [url=http://downloads.guru3d.com/Lost-Planet-2-Benchmark-download-2607.html]Lost Planet 2 Benchmark[/url]

[/LIST]Hinweise zu nützlichen Tools:

Report zur Benutzung des NVIDIA Inspectors (Monitoring, OC & Treiberprofileinstellungen inkl. forciertem AA, SGSSAA usw.:

Report: "NVIDIA Inspector" Grafikkarten-Tweaktool | 3DCenter.org

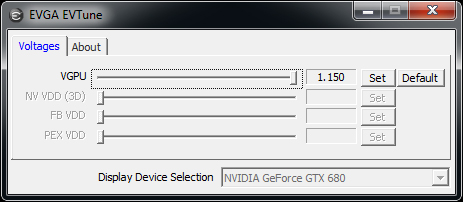

Hinweise zu EVGA PrecisionX 3.0.0 Beta 20:

Dies ist die erste Boardpartner-Software, die die GeForce GTX 680 vollständig unterstützt. Dementsprechend sehen auch die Optionen im neu gestallteten GUI aus. Zum jetzigen Zeitpunkt noch Non-Public.

Bei Power Target stellt man ein, ob die Verbrauchsgrenze höher oder niedriger sein soll. Basis ist hierbei 100 % (entspricht der TDP von 195 Watt). Man kann zwischen 70 bis 130 % (70 % = 136,5W, 100 % = 195W, 130 % = 253W) wählen. Bei CPU Clock Offset wird sowohl der Basistakt, als auch der GPU Boost erhöht. Bei Memory Offset ist zu beachten, dass der GDDR5 Realtakt genau die Hälfte ist (hier findet also wie meist bei den Tools üblich ein Vergleich auf GDDR3 statt). Das Maximum der Spannung liegt - zumindest ohne einen wohlmöglichen BIOS-Unlock - bei 1,150V. Die VCore wird über Adjust Voltage eingestellt. Die besten Overclocking-Werte werden erziehlt, wenn man Power Target auf + 30 % setzt, womit die Karte bis zu 253 Watt aufnehmen kann, und dies mit einer Erhöhung der VCore kombiniert.

OC Beispiel an unserem Testsample - höchste stabile Taktraten:

Power Target: + 30 % auf 130 % (neue Grenze nun bei 253W)

VCore: auf 1,150V (mit maximalem Boost 1,175V)

GPU Clock Offset: + 177 MHz (-> default nun: 1183 MHz, maximaler Takt inkl. GPU Boost: 1280 MHz, also + 97 MHz)

Memory Offset: + 274 MHz (-> ~ + 137 MHz GDDR5 Realtakt -> 1638 MHz GDDR5 == 3278 MHz GDDR3)

Download: EVGA Precision X 3.0.1

Hinweise zu MSI Afterburner:

Mit am 20.03.2012 erschienen Version 2.2.0 Beta 15 unterstützt der Afterburner nun auch die GeForce GTX 680. Die OC Settings selber dürften wie bei PrecisionX ausfallen - stammen beide Tools doch von Unwinder.

Voltage Regelung freischalten: Settings -> " Unlock voltage control " & "Unlock voltage monitoring" aktivieren.

Overclocking generell:

Coretakt = Shadertakt (es gibt bei Kepler keinen sogenannten Hotclock mehr)

Power Target kann unter Settings -> General eingestellt werden - dies ist in Precision X komfortabler gelöst!

Individuelle Lüftersteuerung in Windows:

NVIDIA Inspector 1.9.6.1 Beta

Von der Bedienung, bis auf die Tatsache, dass in P0-State (Volllast) und somit auch automatisch auch im P2-State noch ein Voltage Offset gesetzt werden kann, gibt es keine Unterschiede beim OC im Vergleich zu den Tools von Unwinder. Mit dem "P2-State-Trick", siehe How-To's, kann man innerhalb der gesetzten TDP einen erhöhten Base Clock ohne schwankenden GPU Boost fahren.

How To's:

Code:

[LIST]

[URL="http://www.hardwareluxx.de/community/f14/nvidia-geforce-gtx-680-faq-oc-benches-bei-fragen-erste-seite-lesen-880765-41.html#post18662033"]Overclocking: [COLOR="Green"][B]Mit NVIDIA Inspector P2-State fixieren, um GPU Boost, sofern innerhalb der TDP, zu deaktivieren[/COLOR][/URL][/B]

[URL="http://www.abload.de/img/inspectormdpsera5r.png"]Multi-Monitoring: [COLOR="Green"][B]NVIDIA Inspector MDPS (Multi Display Power Saver) nutzen (auch bei 1 Monitor und 120Hz empfehlenswert für konstanten P8-State)[/COLOR]

[/B] [/URL]

[/LIST]Aufruf in eigener Sache zum Sharing eurer GTX 680 BIOS-Files - eventuell können wir sie ja doch noch gebrauchen: klick

FAQ (Frequently Asked Questions):

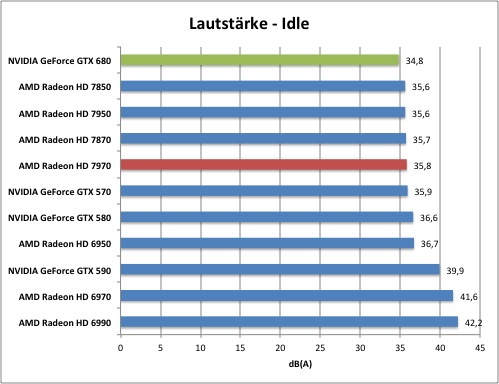

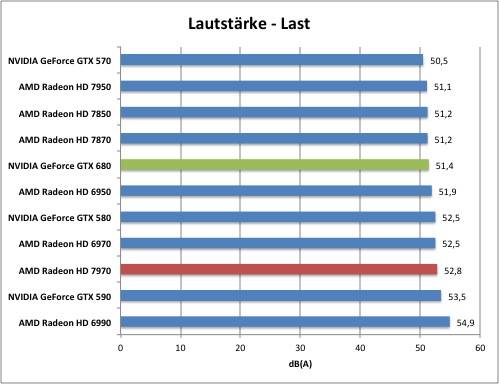

Wie laut ist die Karte?

- Standardmäßig kommt die GTX 680 mit einem Kühler, in dessen Grundplatte drei Heatpipes eingearbeitet sind - die Wärme wird dann von dieser über viele feine Aluminium-Lamellen abgegeben, die sich im Luftstrom des Radiallüfters hin zur Slotblende befinden. Die Karte verfügt außerdem über eine Grundplatte zum passiven Kühlen von VRAM und Spannungswandlern besitzt. Der Radiallüfter hat, wie bei den auf GF100 basierenden Karten, zwar nur einen Durchmesser von 65 mm - dieser soll nun aber aus lärmdämmenden Materialen gefertigt sein, was den störende Frequenzen für den User unterbinden soll. Das Referenzdesign der GTX 680 setzt gegenüber den anderen Testprobanden sogar neue Maßstäbe in Sachen Laustärke im Idle (34,8 dB(A)). Unter Last liegt man mit 51,4 dB(A) im guten Mittelfeld - nur minimal hinter beiden Radeon HD 7800 Karten (je 51,2 dB(A)).

Für die die Last-Verbrauchs- und Lautstärkemessungen nutzen wir Crysis 2. Letztere führen wir mit einer Messempfindlichkeit zwischen 30 bis 70 dB(A) im Abstand von 30 cm zu den Grafikkarten im offenen Gehäuse durch.

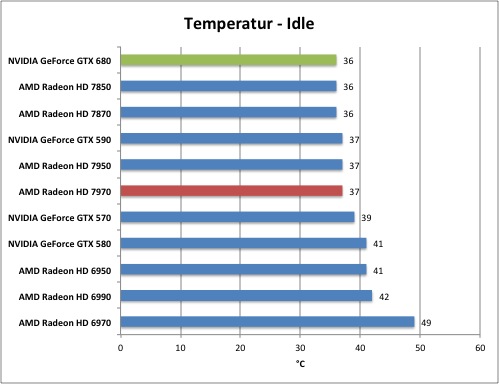

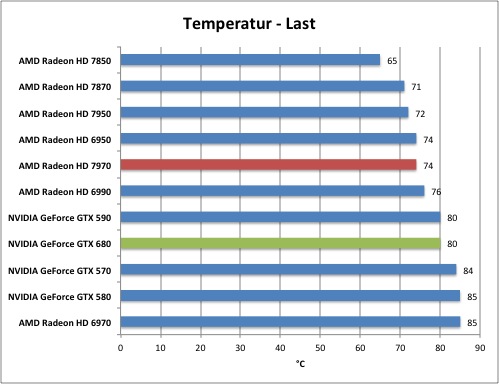

Wie hoch sind die Temperaturen der Karte?

- Im Idle wird die Karte 36 °C warm, unter Last sind es - wohl aufgrund der Lautstärkeoptimierungen - immer noch, für diese Leistungsklasse, ordentliche 80 °C.

Für die Messung der Temperaturen und Lautstärke wählten wir einen Durchlauf in Battlefield 3 in maximaler Auflösung und bei maximalen Einstellungen für die Darstellungsqualität.

Taktdomänen GTX 680:

GTX 680 - Taktdomänen:

- Idle (1 Monitor) - P8: 324/162 MHz @ 0,987V

Low-3D (1 Monitor) - P5: 540/405 MHz @ 0,987V

Idle/Low-3D (2 bis zu 4 Monitore) - P2: 550/1502 MHz @ 0,987V (E: angeblich sogar doch nur im P8, zumindest die meiste Zeit)

Volllast (1 Monitor bis 4 Monitore wenn * nicht gegeben) - P0: 1006/1502 MHz (ohne Boost)

Wie hoch ist der Stromverbrauch?

- Hinweis: Die Verbrauchsmessungen (Karte only) stammen von PCGH -> klick

Die GeForce GTX 680 hat laut NVIDIA einen Idle-Stromverbrauch von gerade einmal 15 Watt (15 Watt auch beim PCGH-Testsample). Unter Last nimmt die Karte (PCGH-Testmuster) 174 Watt auf. Dazu muss bei Kepler aber gesagt werden, dass eine Lastmessung wie bisher nicht mehr möglich ist. Standardmäßig wirkt bei vorhandenen TDP-Reserven und wichtigen Titeln oder Benchmarks der GPU Boost (1058 bis 1110 MHz), oder aber - wenn man einen Titel mit extrem hohen fps hat - wird der Coretakt gedrosselt um den Verbrauch zu senken, sofern man dies nicht über den optional vorhandenen Framelimiter verhindert.

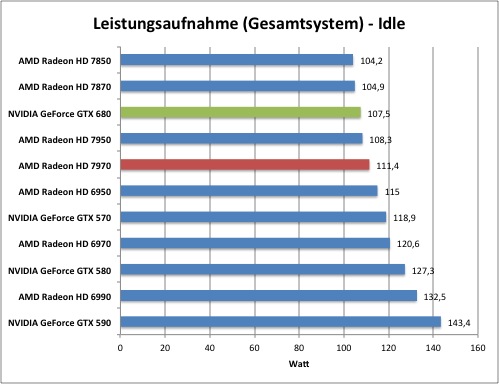

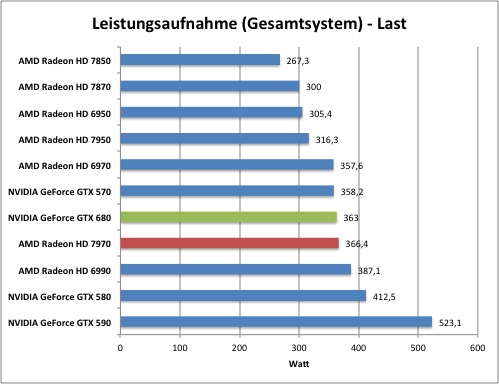

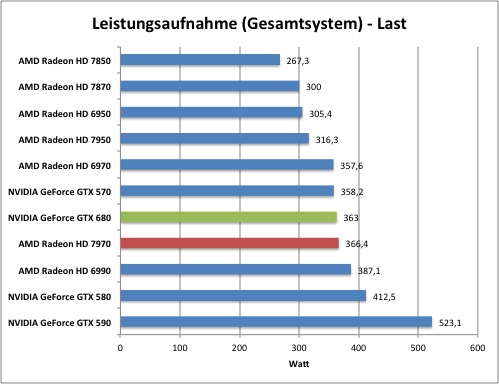

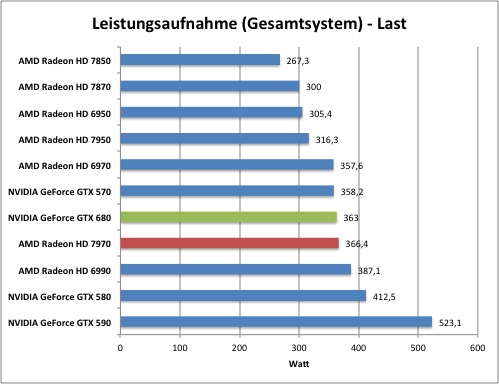

Hier unsere Messungen (gesamtes System):

Das System verbraucht im Idle mit der GTX 680 recht wenig und liegt knapp hinter der HD 7870. Unter Last fällt der Systemverbrauch mit der GTX 680 (363 Watt) minimal geringer als mit der Radeon HD 7970

(366,4 Watt) aus. Somit kann gesagt werden, dass NVIDIA die Effizienz im Vergleich zu Fermi deutlich steigern konnte und nun auf einem Level mit der Konkurrenz liegt.

NVIDIA spricht von der doppelten Performance/Watt im Vergleich zur GeForce GTX 580.

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen.

Verwendetes Testsystem:

Passt die Karte in mein Gehäuse?

- Die Länge der Karte ist genau 10" (Zoll), also 25,4 cm, und damit ist die GeForce GTX 680 etwas länger als die Radeon HD 7870 (9,5", also 24,13 cm). Somit dürfte die GeForce GTX 680 ohne Probleme in die meisten User-Gehäuse passen. Wie üblich, setzt man auf ein Dual-Slot-Design, allerdings sitzen beide PCI-E 6-Pin Buchsen nun treppenartig übereinander, was Single-Slot-Lösungen auf Basis einer Wasserkühlung nicht zulässt - es sei denn manche Boardpartner bringen Karten mit konservativen PCI-E-Buchsen nebeneinander.

Ist es möglich, die Tonformate Dolby TrueHD und DTS HD per Bitstream wiederzugeben?

- Die GTX 680 (GK104) unterstützt die Wiedergabe der HD-Tonformate im Bitstream über den HDMI-Ausgang.

Dafür ist aber unter Umständen die passende Software - etwa die neuste Version von Cyberlinks PowerDVD notwendig.

Update: Das kostenlose ffdshow (die aktuelle Version ist das erweiterte ffdshow tryouts) ermöglicht ebenfalls die Ausgabe per Bitstream -> Guide

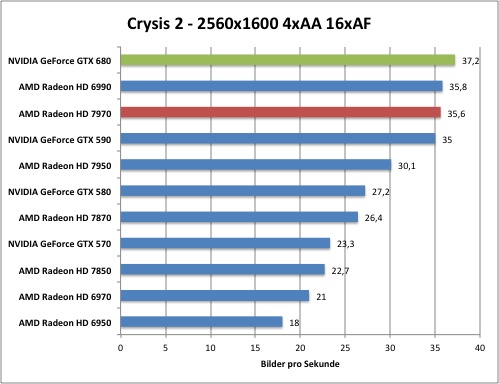

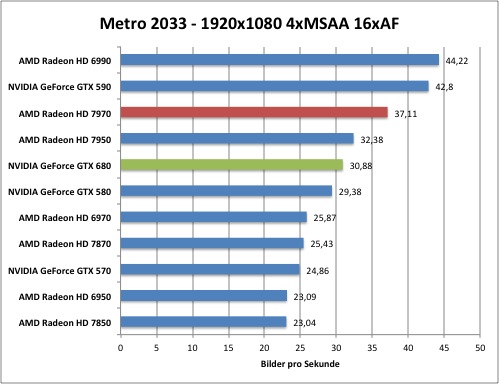

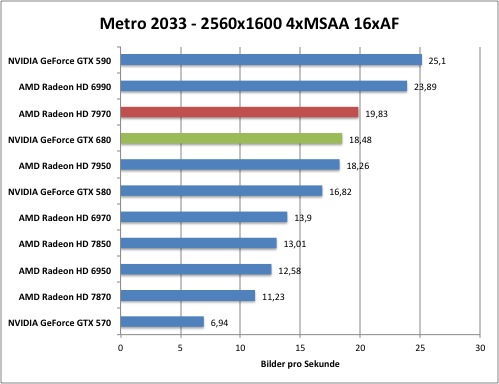

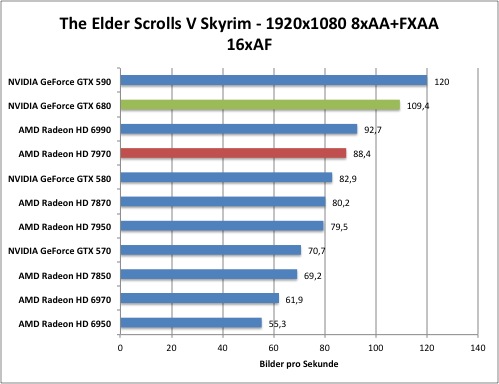

Die Performance:

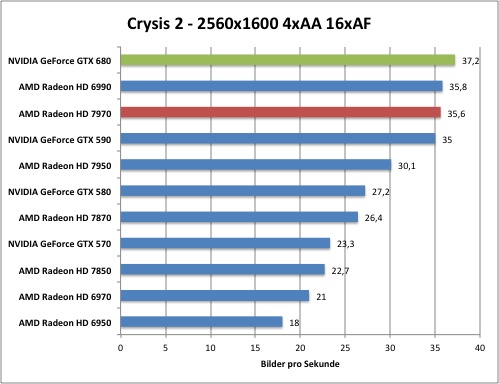

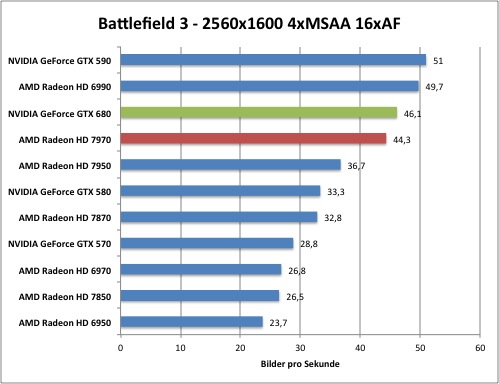

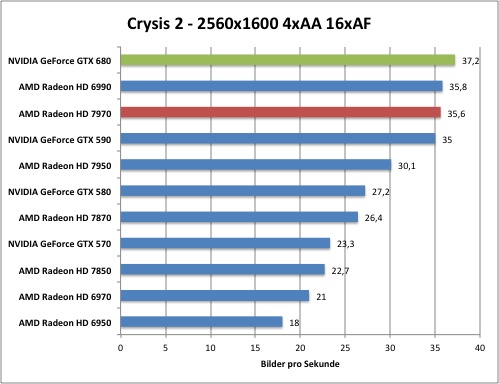

- Wie man sieht, ordnet sich die GeForce GTX 680 aktuell im High-End-Segment ein und beerbt damit die GeForce GTX 580 offiziell. Die Performance liegt in unseren Benchmarks zumeist oberhalb der Radeon HD 7970. Somit ist die Karte für User geeignet, die keine Kompromisse in den einstellbaren Qualitätssettings haben möchten und könnte auch Enthusiasten, die lieber zur GeForce als ezwa zu einer HD 7970 greifen möchten, als Übergangslösung bis zum GK110-Launch dienen. Später soll es durch die Boardpartner auch Modelle mit 4 GB GDDR5 geben.

Weitere Details zur Ausführung der Benchmarks aus dem aktuellen HardwareLUXX-Review:

Der Artikel basiert auf folgenden Karten seitens der GeForce GTX 680:

NVIDIA GeForce GTX 680 (Referenz).

Benutzte Auflösungen sind 1680x1050 4xAA/16xAF & 8xAA/16xAF, über 1920x1200 4xAA/16xAF & 8xAA/16xAF

bis hin zu 2560x1600 4xAA/16xAF & 8xAA/16xAF. Teilweise kam auch 1xAA/16xAF zum Einsatz, Rage unterstützt asu Grünen der Kompatibilität nur 4xAF.

Gebencht wird auf folgendem System:

Im Artikel vertreten sind folgende synthetische Benchmarks & Game-Benchmarks:

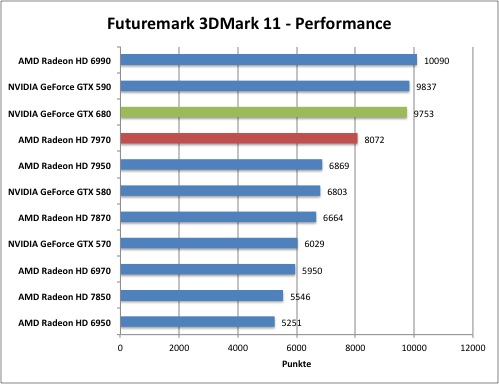

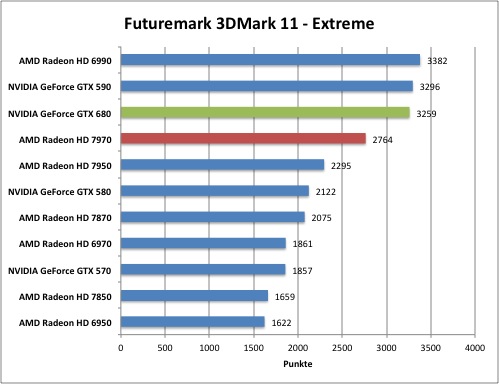

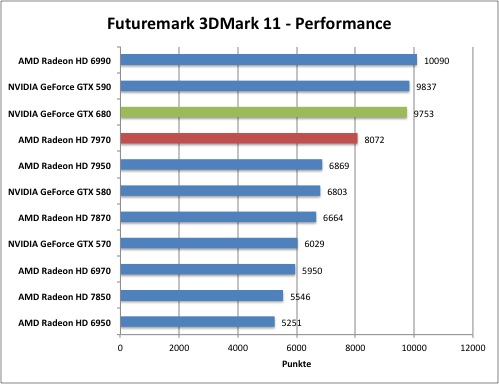

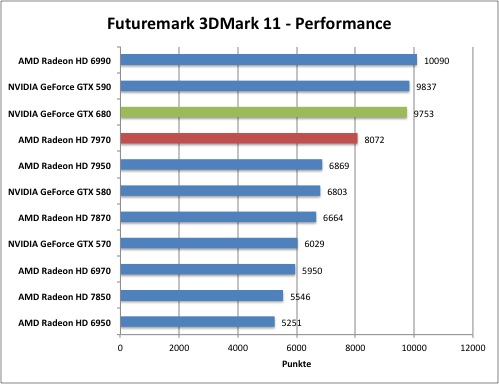

Synthetische Benchmarks: Futuremark 3D Mark 11 sowie LuxMark 2.0

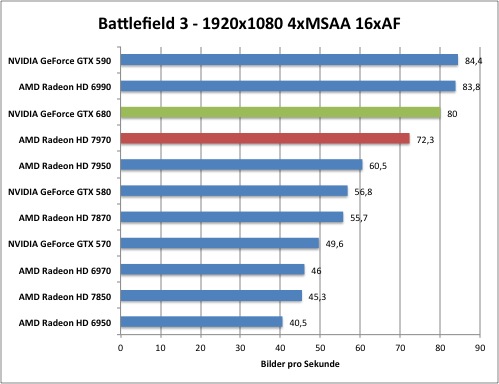

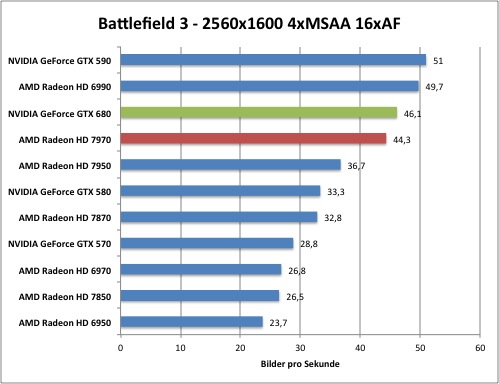

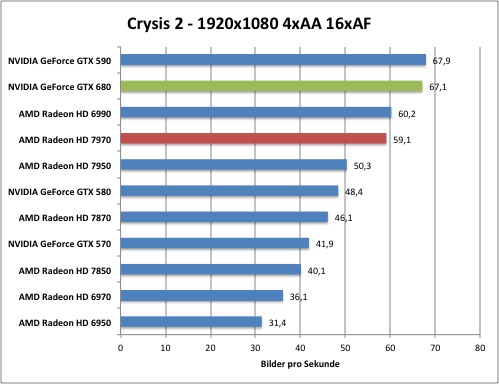

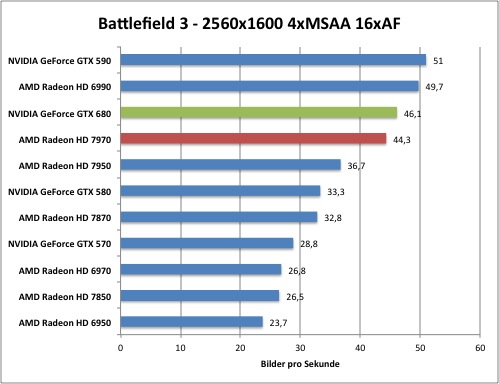

Game-Benchmarks: Anno 2070 (DX11), Battlefield 3 (DX11), Call of Duty: Modern Warfare 3 (DX9), Crysis Warhead (DX10), Crysis 2 (DX11),

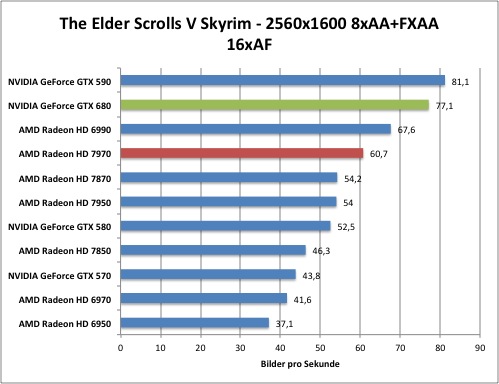

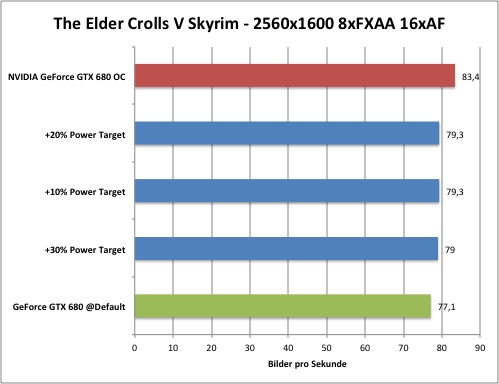

Metro 2033 (DX11), Rage (OpenGL), The Elder Scolls V: Skyrim (DX9) sowie The Witcher 2 (DX9)

Hier gibt es alle Benchmarks -> klick -> HARDWARELUXX-Artikel-Linkhttp://www.hardwareluxx.de/index.ph...karten/21816-test-nvidia-geforce-gtx-680.htmlhttp://www.hardwareluxx.de/index.ph...karten/21816-test-nvidia-geforce-gtx-680.htmlhttp://www.hardwareluxx.de/index.ph...karten/21816-test-nvidia-geforce-gtx-680.html

Kleiner Ausschnitt aus dem Artikel:

Synthetische Benchmarks:

Game-Benchmarks:

Overclocking-Tests

Generelles zum Overclocking:

Die Karten sind, wie auch schon die Vorgänger auf Fermi-Basis sehr taktfreudig. Der neue 28nm-Prozess trägt hier seinen Teil bei.

Bei Power Target stellt man ein, ob die Verbrauchsgrenze höher oder niedriger sein soll. Basis ist hierbei 100 % (entspricht der TDP von 195 Watt). Man kann zwischen 70 bis 130 % (70 % = 136,5W, 100 % = 195W, 130 % = 253W) wählen. Bei CPU Clock Offset wird sowohl der Basistakt, als auch der GPU Boost erhöht. Bei Memory Offset ist zu beachten, dass der GDDR5 Realtakt genau die Hälfte ist (hier findet also wie meist bei den Tools üblich ein Vergleich auf GDDR3 statt). Das Maximum der Spannung liegt - zumindest ohne einen wohlmöglichen BIOS-Unlock - bei 1,150V. Die VCore wird über Adjust Voltage eingestellt. Die besten Overclocking-Werte werden erziehlt, wenn man Power Target auf + 30 % setzt, womit die Karte bis zu 253 Watt aufnehmen kann, und dies mit einer Erhöhung der VCore kombiniert.

OC Beispiel an unserem Testsample - höchste stabile Taktraten:

Power Target: + 30 % auf 130 % (neue Grenze nun bei 253W)

VCore: auf 1,150V (mit maximalem Boost 1,175V)

GPU Clock Offset: + 177 MHz (-> default nun: 1183 MHz, maximaler Takt inkl. GPU Boost: 1280 MHz, also + 97 MHz)

Memory Offset: + 274 MHz (-> ~ + 138 MHz GDDR5 Realtakt -> 1638 MHz GDDR5 == 3278 MHz GDDR3)

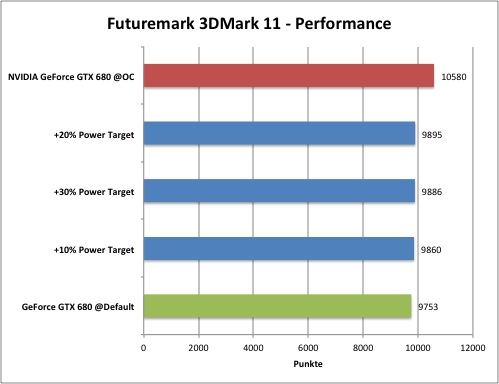

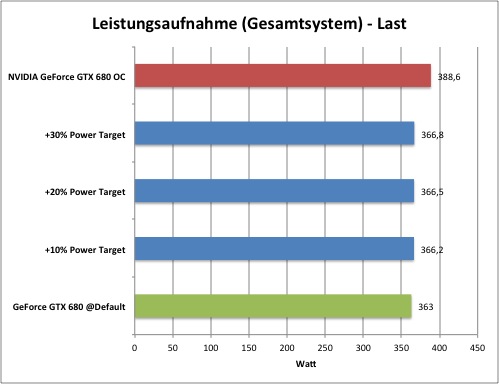

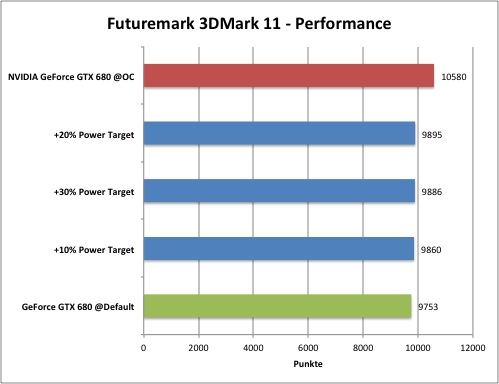

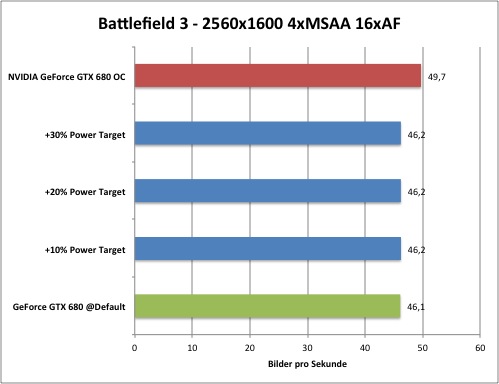

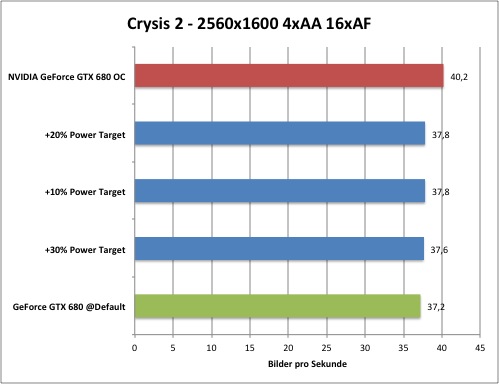

Overclocking-Benchmarks mithilfe von EVGA PrecisionX 3.0.0 Beta 20:

Referenztakt bei den Benchmarks: 1006/1502 MHz (mit Boost zwischen 1058 und maximal 1110 MHz Coretakt)

Stabile Taktraten unseres Testsamples: 1280/1638 MHz (inkl. maximalen GPU Boost)

Unterschied der Taktraten in %:

Coretakt (default bis max. Boost per OC): + 27,2 % (Minimum + 17,6 % ausgehend von 1006 MHz + 177 MHz; ohne aktiven GPU-Boost)

VRAM-Takt: + 9,1 %

Fazit: Wie man sieht, steigt die Performance etwas an, aufgrund der schon recht hohen Basistaktraten, hält sich der Gewinn aber in Grenzen - hier wird sich zeigen, ob mit OC-Versionen und aufgewerteten PCBs sowie alternativen Kühlmethoden mehr drin ist :

Synthetische Benchmarks:

vs.

vs.

Performance: + 8,5 %

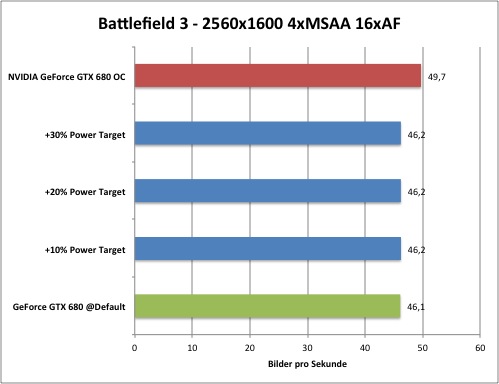

Game Benchmarks:

vs.

vs.

Performance: + 7,8 %

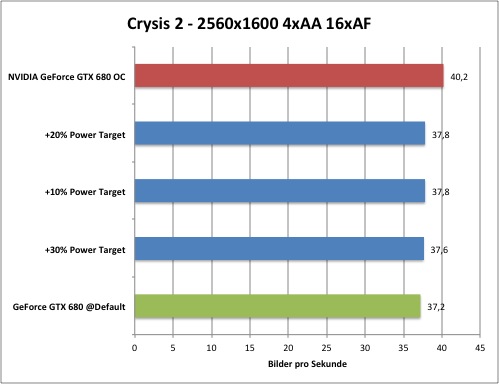

vs.

vs.

Performance: + 8,1 %

vs.

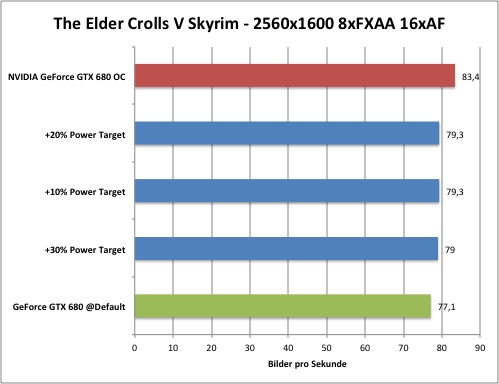

vs.

Performance: + 8,2 %

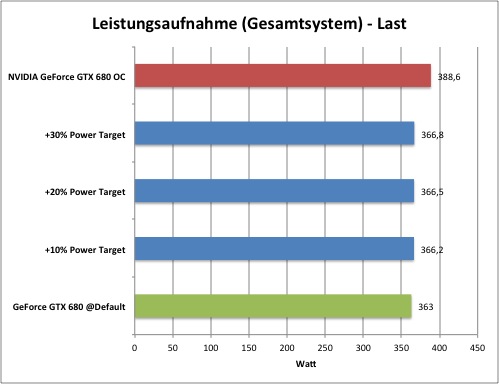

Unterschied beim Lastverbrauch (gesamtes System):

vs.

vs.

Verbrauch: + 7,1 %

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen

- so ist es möglich, dass die Verbrauchswerte von anderen Redaktionen unterschiedlich ausfallen, selbst wenn auch ein ähnliches LGA 2011 System verwendet wurde.

Die Karten sind, wie auch schon die Vorgänger auf Fermi-Basis sehr taktfreudig. Der neue 28nm-Prozess trägt hier seinen Teil bei.

Bei Power Target stellt man ein, ob die Verbrauchsgrenze höher oder niedriger sein soll. Basis ist hierbei 100 % (entspricht der TDP von 195 Watt). Man kann zwischen 70 bis 130 % (70 % = 136,5W, 100 % = 195W, 130 % = 253W) wählen. Bei CPU Clock Offset wird sowohl der Basistakt, als auch der GPU Boost erhöht. Bei Memory Offset ist zu beachten, dass der GDDR5 Realtakt genau die Hälfte ist (hier findet also wie meist bei den Tools üblich ein Vergleich auf GDDR3 statt). Das Maximum der Spannung liegt - zumindest ohne einen wohlmöglichen BIOS-Unlock - bei 1,150V. Die VCore wird über Adjust Voltage eingestellt. Die besten Overclocking-Werte werden erziehlt, wenn man Power Target auf + 30 % setzt, womit die Karte bis zu 253 Watt aufnehmen kann, und dies mit einer Erhöhung der VCore kombiniert.

OC Beispiel an unserem Testsample - höchste stabile Taktraten:

Power Target: + 30 % auf 130 % (neue Grenze nun bei 253W)

VCore: auf 1,150V (mit maximalem Boost 1,175V)

GPU Clock Offset: + 177 MHz (-> default nun: 1183 MHz, maximaler Takt inkl. GPU Boost: 1280 MHz, also + 97 MHz)

Memory Offset: + 274 MHz (-> ~ + 138 MHz GDDR5 Realtakt -> 1638 MHz GDDR5 == 3278 MHz GDDR3)

Overclocking-Benchmarks mithilfe von EVGA PrecisionX 3.0.0 Beta 20:

Referenztakt bei den Benchmarks: 1006/1502 MHz (mit Boost zwischen 1058 und maximal 1110 MHz Coretakt)

Stabile Taktraten unseres Testsamples: 1280/1638 MHz (inkl. maximalen GPU Boost)

Unterschied der Taktraten in %:

Coretakt (default bis max. Boost per OC): + 27,2 % (Minimum + 17,6 % ausgehend von 1006 MHz + 177 MHz; ohne aktiven GPU-Boost)

VRAM-Takt: + 9,1 %

Fazit: Wie man sieht, steigt die Performance etwas an, aufgrund der schon recht hohen Basistaktraten, hält sich der Gewinn aber in Grenzen - hier wird sich zeigen, ob mit OC-Versionen und aufgewerteten PCBs sowie alternativen Kühlmethoden mehr drin ist :

Synthetische Benchmarks:

Performance: + 8,5 %

Game Benchmarks:

Performance: + 7,8 %

Performance: + 8,1 %

Performance: + 8,2 %

Unterschied beim Lastverbrauch (gesamtes System):

Verbrauch: + 7,1 %

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen

- so ist es möglich, dass die Verbrauchswerte von anderen Redaktionen unterschiedlich ausfallen, selbst wenn auch ein ähnliches LGA 2011 System verwendet wurde.

HardwareLUXX - User-OC-Werte (nicht nur Furmark stable) in MHz - inkl. 3D Mark Vantage & 3D Mark 11 User-Liste

Beispielschema von OliverM84:

1200 GPU | 1502 Speicher | 1,150V | VID 1,100V | EVGA | WaKü/LuKü | Username

12xx GPU | 17xx Speicher | 1,150V | VID 1,100V | Gigabyte | LuKü | Hardware LUXX

3DMark Vantage - Performance (PhysX On)

Vantage Score | GPU Takt | Speicher Takt | GPU VCore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

52791 | 1006 | 1502 | 1,150V | 1,087V + 1,125V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

3DMark Vantage - Performance (PhysX Off)

Vantage Score | GPU Takt | Speicher Takt | GPU vcore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

41955 | 1121 | 1617 | 1,150V | 1,087V + 1,125V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

41008 | 1006 | 1502 | 1,150V | 1,087V + 1,125V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

3DMark Vantage - Extreme (PhysX On)

Vantage Score | GPU Takt | Speicher Takt | GPU vcore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

1xxxx | 1200 | 1700 | 1,150V | 1,1xxV | MSI | LuKü | HardwareLUXX | 301.10 WHQL

3DMark Vantage - Extreme (PhysX Off)

Vantage Score | GPU Takt | Speicher Takt | GPU VCore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

xxxxx | 1200 | 1700 | 1,150V | 1,1xxV | MSI | LuKü | HardwareLUXX | 301.10 WHQL

3DMark11 - Performance

3DMark11 Score | GPU Takt | Speicher Takt | GPU VCore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

14967 | 1121 | 1617 | 1,150V | 1,087V + 1,125V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

14166 | 1006 | 1502 | 1,150V | 1,087V + 1,125V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

9682 | 1156 | 1627 | 1,150V | 1,087V | Zotac | LuKü | Edgecrusher86 | 301.10 WHQL

8847 | 1006 | 1502 | 1,150V | 1,087V | Zotac | LuKü | Edgecrusher86 | 301.10 WHQL

3DMark11 - Extreme

3DMark11 Score | GPU Takt | Speicher Takt | GPU VCore | VID | Hersteller | WaKü oder LuKü | Username mit Link | Treiber

6483 | 1121 | 1617 | 1,150V | 1,087V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

5924 | 1006 | 1502 | 1,150V | 1,087V | Zotac SLI | LuKü | Edgecrusher86 | 301.10 WHQL

3522 | 1156 | 1627 | 1,150V | 1,087V | Zotac | LuKü | Edgecrusher86 | 301.10 WHQL

3179 | 1006 | 1502 | 1,150V | 1,087V | Zotac | LuKü | Edgecrusher86 | 301.10 WHQL

Andere Kühllösungen

Karten im Referenzdesign:

Anscheined dürfte es etwas dauern, bis erste eigene Lösungen durch die Boardpartner zu erwarten sind, bis dahin kommen generell alle Karten ausschließlich im Referenzdesign.

Angekündigte Non-Referenz-Karten bzw. Karten mit Werks-OC:

Colorful iGame Kudan (xxxx/xxxx MHz, 3 x 80 (?) mm Axiallüfter (Triple Slot Kühler) + 10 Heatpipes, 8 Phasen + 4 per SO-DIMM, BIOS-Switch, Acryl-Farben(!), 8+8 Pin PCI-E)

EVGA GeForce GTX 680 FTW 4GB (xxxx/xxxx MHz, 4 GB)

EVGA GeForce GTX 680 FTW (xxxx/xxxx MHz)

EVGA GeForce GTX 680 Superclocked Signature 2 (1058/1552 MHz, 2 x 80 mm Axiallüfter, 5+2 Phasen, 8+6 Pin PCI-E)

Gainward GeForce GTX 680 Phantom 4GB (1084/1150/1575 MHz , 2 x 80 mm Axiallüfter und 5 Heatpipes, 2,5 Slot Phantom II Kühler, 4GB, 5+2 Phasen, 8+6 Pin PCI-E)

Gainward GeForce GTX 680 Phantom (1084/1150/1575 MHz , 2 x 80 mm Axiallüfter und 5 Heatpipes, 2,5 Slot Phantom II Kühler, 5+2 Phasen, 8+6 Pin PCI-E)

Galaxy/KFA² GeForce GTX 680 4GB (~ 1100/xxxx MHz, 2 x 90 mm Axiallüfter, 4 GB, 5+2 Phasen, 8+6 Pin PCI-E)

Galaxy/KFA² GeForce GTX 680 Hall of Fame Edition (xxxx/xxxx MHz, 3 x 90 mm Axiallüfter, xx Phasen, 8+8 Pin PCI-E - konventionelle Buchsen, weißes PCB)

Galaxy/KFA² GeForce GTX 680 Single Slot (xxxx/xxxx MHz, xx mm Radiallüfter, xx Phasen, Single-Slot Design)

Gigabyte GeForce GTX 680 OC Windforce X3 (GV-N680OC-2GD) (1071/1137/1502 MHz, 3 x 80mm Axiallüfter - Windforce X3-Kühler, 5+2 Phasen, 8+6 Pin PCI-E - konventionelle Buchsen)

Inno3D iChiLL Arctic Cooling GeForce GTX 680 (xxxx/xxxx MHz, ~75 mm Axiallüfter + 120 mm Axiallüfter und Radiator - Arctic Accelero Hybrid (Luft/Kühlmittel-Lösung ähnlich Asetek- oder Cool-IT CPU-Lösungen), 8+6 Pin PCI-E - konvetionelle Buchsen)

Guru3D Forum: schrieb:The iChill GeForce GTX 680 features a pre-fitted water-cooling loop which consists of a GPU Core base plate and two individual tubes which would transfer the coolant through the reservoir pump which is cooled by a 120mm fan. The Cooler shroud also features a fan which cools down the Power and Memory Area. Display is provided through two DVI, HDMI, DisplayPort, the GPU would cover two expansion slots.

As far as performance goes, The cooler is said to drop temperatures down to 44 ℃ at load which is much better than the stock cooling design and at only 10% noise of air cooled models. Inno3D hasn’t yet detailed the frequencies but the core is expected to reach 1.2GHz. Pricing and launch date have not been detailed.

Inno3D GeForce GTX 680 TwinFan (xxxx/xxxx MHz, 2 x 90 mm (?) Axiallüfter)

MSI N680GTX Twin Frozr III/OC (1056/1108/1505 MHz, 2 x 80mm Axiallüfter, 3 x 6 mm + 2 x 8 mm Heatpipes, Twin Frozr III-Kühler (27 cm Kartenlänge))

Palit GeForce GTX 680 JetStream 4GB (1084/1150/1575 MHz , 3 Axiallüfter - 1 x 90 mm mit blauer LED & 2 x 80mm abgewinkelt, 2,5 Slot JetStream Lüfter, 5+2 Phasen, DrMos, 4GB, 8+6 Pin PCI-E)

Palit GeForce GTX 680 JetStream (1084/1150/1575 MHz , 3 Axiallüfter - 1 x 90 mm mit blauer LED & 2 x 80mm abgewinkelt, 2,5 Slot JetStream Lüfter, 5+2 Phasen, DrMos, 8+6 Pin PCI-E)

Zotac GeForce GTX Extreme Edition (1202/1502 MHz, 2 x 90 mm Axiallüfter mit bis zu 3500 U/Min.+ und 5 x 6 mm Heatpipes, ingesamt 12 Phasen (AIO Ferrit-Spulen), 3 FPCAP Kondensatoren sowie USB-OC+ Modul für Zotac Firestorm OC-Tool und verbreitertes PCB samt 8+6 Pin PCI-E, 1,212V default, mit LN2 DIP-Schalter und bis zu 1,500V VCore per OC+ (USB)! - Spannungsmesspunkte und Status LEDs, anscheinend leider nur für China geplant)

Chinesisches Video - Zotac GeForce GTX 680 Extreme Edition: (10:13 Min.)

Chinesisches Video Zotac GeForce GTX 680 Extreme Edition - OC auf 1,4 GHz Coretakt: (5:57 Min.)

1,5 GHz wäre kein Problem gewesen, sofern es die Kühlung mitgemacht hätte - bei 1,41 GHz @ 1,375V hatte der Kühler bei nicht unerheblicher Lautstärke schon 95 °C unter Last auf dem Buckel.

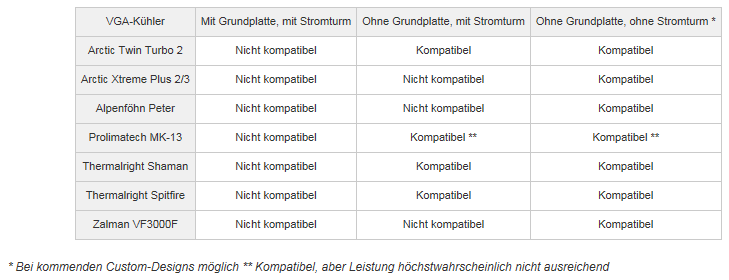

Alternative Kühler (Luft):

Kompatible Kühler zum Referenzdesign (Liste nach Launch)

PCGH - Geforce GTX 680: Diese VGA-Kühler passen plus Test des Arctic Twin Turbo 2 und Thermalright Shaman

Arctic Accelero Twin Turbo II (2 Slot - Maße: 220 (L) x 125 (B) x 54 (H) mm - 2 x 92mm PWM Lüfter - 900 bis 2000 U/Min - 0,3 Sone - 5 x 6 mm Heatpipes) - kompatibel zum Referenzdesign! Preis: ab ~ 31€

Links:

Hardwareluxx - User-Review Arctic Twin Turbo II auf Gigabyte GeForce GTX 680 (Referenzdesign) (THX @ derredbaron)

Hauptseite

Download - PDF Spezifikationen

Download - PDF Handbuch (Sprachenauswahl)

Download - PDF Maße und Bauhöhen

Arctic Accelero Twin Turbo 2 auf GeForce GTX 680 (THX @ Naennon):

http://www.hardwareluxx.de/communit...erste-seite-lesen-880765-38.html#post18660287

Arctic Accelero Xtreme III (3 Slot - Maße: 288 (L) x 104 (B) x 54 (H) mm - 3 x 92mm PWM Lüfter - 900 bis 2000 U/Min - 0,5 Sone - 5 x 6 mm Heatpipes) - aufgrund der PCI-E Buchse im Tower-Design ist das GTX 680 Referenzdesign inkompatibel - somit bedarf es einer Non-Referenzkarte! Preis: ab ~ 58€

Links:

Hardwareluxx - Test des Arctic Accelero Xtreme III anhand der Gigabyte GeForce GTX 670 OC (identisches PCB wie GTX 680 OC)

KitGuru - Review Arctic Accelero Xtreme III @ ASUS GeForce GTX 680 DirectCUII

Hauptseite

Download - PDF Spezifikationen

Download - PDF Handbuch (Sprachenauswahl)

Liste der zum Arctic Accelero Xtreme III kompatiblen, hierzulande lieferbaren Karten (mit klassischen PCI-E Buchsen - ohne Tower-Design)

Karten ohne Backplate

Gigabyte GeForce GTX 680 OC (GV-N680OC-2GD)

Inno3D iChill GeForce GTX 680 Herculez 3000

Inno3D iChill GeForce GTX 680 Herculez 3000 (4GB)

KFA² GeForce GTX 680 EX OC

KFA² GeForce GTX 680 EX OC (4GB)

KFA² GeForce GTX 680 LTD OC V2

Karten mit Backplate (evtl. weitere Umbaumaßnahmen - Schrauben <-> Abstandshalter - notwendig, sofern die Backplate weiterhin verwendet werden soll)

ASUS GTX680-DC2-2GD5 (DirectCUII)

ASUS GTX680-DC2O-2GD5 (DirectCUII OC)

ASUS GTX680-DC2T-2GD5 (DirectCUII TOP)

EVGA GeForce GTX 680 Classified (4GB)

Gigabyte GeForce GTX 680 Super Overclock (SOC)

MSI N680GTX Lightning

Point of View GeForce GTX 680 Exo

Point of View GeForce GTX 680 Exo (4GB)

Point of View GeForce GTX 680 TGT Charged Triple Fan + TGT Backplate

Point of View GeForce GTX 680 TGT Charged Triple Fan + TGT Backplat (4GB)

Point of View GeForce GTX 680 TGT Ultra Charged + TGT Backplate

Point of View GeForce GTX 680 TGT Ultra Charged Low Leakage Selection (LLS) + TGT Backplate (4GB)

Arctic Accelero Hybrid (2 Slot - Maße: Grafikkarten-Modul: 243 (L) x 112 (B) x 44.2 (H) mm - Maße: Radiator und Lüfter: 150 (L) x 120 (B) x 52.8 (H) mm - GPU-only-Flüssigkeitskühlung inkl. Pumpe, 120mm Radiator und F12 PWM Lüfter (400 bis 1350 U/Min) + 80 mm Lüfter (900 - 2000 U/Min) für Spannungswandler und VRAM - max. 0,4 Sone (2000 U/Min + Pumpe)) - anders als Accelero Xtreme III kompatibel zum GTX 680 Referenzdesign (siehe Thumbnail & Review-Link)! Preis: ab ~ 106€

Links:

Review - KitGuru - Arctic Accelero Hybrid auf Palit GeForce GTX 680 (Referenzdesign)

Hauptseite

Download - PDF Spezifikationen

Download - PDF Handbuch (Sprachenauswahl)

Erhältliche WaKü-Blocks für die GTX 680 & weitere Infos:

Aquacomputer aquagrafx GTX 680 (gelistet für 93,99€ bei Aquatuning)

Montage-Video: http://www.youtube.com/watch?v=iZyT8fKW0L0&feature=player_embedded

http://forum.aquacomputer.de/wasser...d-aquagratix-hd-7950-mit-3d-flow-technologie/

Bei Aquacomputer für 94,90€ lieferbar.

Ebenso gibt es eine schwarze Backplate für 29,90€.

EK Water Blocks EK-FC680 GTX (Kupfer + Plexiglas, Kupfer + Acetal, Acetal + Nickel (vern. Kupfer) sowie Nickel (vern. Kupfer) + Plexiglas geplant - zwischen 83,99 € bis 93,99€ gelistet)

Installationsanleitung: http://www.ekwaterblocks.com/shop/EK-IM/EK-IM-3831109856321.pdf

Der EK-FC680 GTX (Plexiglas + Kupfer) und der EK-FC680 GTX Acetal (Kupfer + Acetal) sind für jeweils 84,95€ im EK-Shop schon als lieferbar gelistet!

Das komplette Lineup wird laut Aquatuning für den 05.04. erwartet.

http://www.ekwaterblocks.com/shop/blocks/vga-blocks/fc-geforce/geforce-gtx-6x0-series.html

EVGA Waterblock GTX 680 Hydro Copper (Swiftech 400-CU-G680-B1) - gelistet für 159,99$ im EVGA Shop

Installationsanleitung: http://www.evga.com/products/pdf/400-CU-G680-B1.pdf

Link EVGA Shop (159,99$)

Karten mit WaKü-Blocks ab Werk:

EVGA GeForce GTX 680 Hydro Copper Classified (xxxx/xxxx MHz, Swiftech 400-CU-G680-B1 WaKü-Block)

EVGA GeForce GTX 680 Hydro Copper (xxxx/xxxx MHz, Swiftech 400-CU-G680-B1 WaKü-Block)

Point of View TGT GeForce GTX 680 Beast (xxxx/xxxx MHz, Aquacomputer aquagrafx GTX 680 WaKü-Block)

Das Layout der Karte:

Ein Vergleich zwischen der GeForce GTX 680 PCB- gegenüber der GeForce GTX 580 PCB-Rückseite

Alle weiteren Infos zu den WaKü-Lösungen findet ihr hier (THX @ Guapa):

GeForce GTX 680 WaKü-Sammelthread

Allgemeiner Hinweis

Dies ist ein Sammelthread für die GeForce GTX 680, das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen. Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (etwa HD 7000 und GTX 500) angemessen.

Was allerdings nicht hier rein gehört:

Offtopic Beiträge (beispielsweise eine Technikdiskussion über die Architektur des R1000 a la HD 79x0), Gespamme oder "Privatkriege -> NV vs. AMD".

Es ist nur im Interesse des Forums, dass es hier gesittet abläuft.

Bei Postings, die zu sehr OT sind oder etwa nur reine Provokation, am Besten gar nicht darauf eingehen, sondern durch Benutzen des "Beitrag melden-Buttons" (

Sollte es zu mehrmaligem Verstoß gegen die Regeln kommen, so können auffällige User eine Auszeit von diesem Thread erhalten.

Gruß

Edge

Zuletzt bearbeitet:

Wäre dementsprechend auch "Krum"

Wäre dementsprechend auch "Krum"