NVIDIA GeForce GTX 780 (GK110) Sammelthread + FAQ

Impressionen der Karte:

Technische Daten der GeForce GTX 780

- Chip = GK110-300-A1

- Fertigung = 28 nm (TSMC)

- Transistoren = 7,1 Milliarden

- Die-Größe = 561 mm²

- Shader-Einheiten = 2304 (1D) (12 SMX)

- Texture Mapping Units (TMUs) = 192

- Raster Operations (ROPs) = 48

- Pixelfüllrate = 41,4 GPixel/s (real 27,6 oder 34,5 GPixel/s)

- Texelfüllrate = 165,7 GTexel/s

- Chiptakt = 863 MHz Baseclock + Boost (902 MHz) + Estimated Boost

- Shadertakt = Chiptakt (863 MHz Baseclock + Boost (902 MHz)+ Estimated Boost)

- Speichertakt = 1502 MHz

- Speichergröße = 3072 MB

- Speichertyp = GDDR5 (Samsung)

- Speicherinterface = 384 Bit

- Speicherbandbreite = 288,4 GB/Sek.

- Shader Model = 5.0

- DirectX = 11.0

- Leistungsaufnahme 3D (TDP) = 250W (PCGH hat bei ihrem Sample 222W in BF: Bad Company 2 gemessen)

- Leistungsaufnahme 2D = 15 Watt

- Versorgung über jeweils einen 8-Pin & 6-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = 2 x DL-DVI (1 x DVI-D, 1 x DVI), 1 x HDMI 1.4a, 1 x DisplayPort 1.2

- Hinweis: Multi-Monitoring = Die Karte kann bis zu vier Monitore gleichzeitig ansteuern, im Surround-Modus (2D und 3D) maximal drei.

- Hinweis: Je nach Taktraten können Rechenleistung, Pixelfüllrate und Texelfüllrate sowie der Stromverbrauch abweichen.

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Introducing the GeForce GTX 780 | GeForce

NVIDIA GeForce GTX 780 Announcement Video

Einzelkartentests:

- PCGH - Nvidia Geforce GTX 780 im Test

- Computerbase - Nvidia GeForce GTX 780 im Test

- HT4u - NVIDIA GeForce GTX 780 im Test

- Tom's HardwareTestbericht Nvidia GeForce GTX 780

- -

- englisch:

- AnandTech | NVIDIA GeForce GTX 780 Review: The New High End

- GeForce GTX 780 review - Article

- NVIDIA GeForce GTX 780 Review

- HARDOCP - GeForce GTX 780 - NVIDIA GeForce GTX 780 Video Card Review

- ZOTAC NVIDIA GeForce GTX 780 Graphics Card Review - Introduction

- NVIDIA GeForce GTX 780 3GB Graphics Card Review - GK110 Mini | PC Perspective

- -

- SLI-Tests

- HardwareLUXX - Test: NVIDIA GeForce GTX 780 SLI

- Techpowerup - NVIDIA GeForce GTX 780 SLI

- Guru3D - GTX 780 SLI

- -

- Custom-Karten

- HardwareLuxx Test: 3x GTX 780

- EVGA GTX 780 Superclocked w/ ACX Cooler 3 GB Review | techPowerUp

- EVGA GeForce GTX 780 SC ACX review - Article

- Gigabyte GeForce GTX 780 WindForce 3x OC review - Graphics card temperatures

- Gigabyte GTX 780 WindForce OC 3 GB Review | techPowerUp

- Overclock3D :: Review :: Gigabyte GTX780 Windforce Review :: Introduction and Up Close

Geizhals Link:

GeForce GTX 780 | Deutschland - Hardwareluxx - Preisvergleich

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

oder direkt bei Nvidia

Tools:

Grafikkarten Analyse Tool GPU-Z hier

NVIDIA Inspector (Analyse Tool, OC, erw. Treibersettings) hier

EVGA Precision X hier

MSI Afterburner hier

FurMark VGA Stress Test hier

Futuremark 3D Mark (2013 - Basic Edition) hier

Futuremark 3D Mark 11 (Basic Edition) hier

Unigine Heaven 4.0 Benchmark (Basic Edition) hier

Unigine Valley 1.0 Benchmark (Basic Edition) hier

FAQ (Frequently Asked Questions)

Wie laut ist die Karte?

Die GeForce GTX 780 erzeugt sowohl im Idle, als auch unter Last eine für einem Referenzdesign niedrige Lautstärke und ist immer leiser als die GeForce GTX 680.

Für eine bessere Vorstellung ein Video der Karte unter Furmark. Das maximum des Lüfters liegt bei rund 56% und hält die Karte bei rund 83°C.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Wie hoch sind die Temperaturen der Karte?

Die Temperaturen der Karte entsprechen in etwa denen der GeForce GTX Titan -sowohl im Idle, als auch unter Last (dank des Temp-Targets von 80°C).

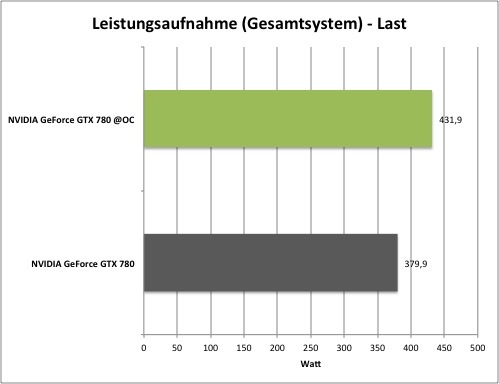

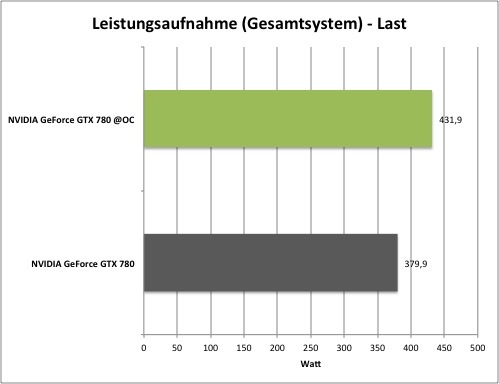

Wie hoch ist der Stromverbrauch?

Im Idle verbraucht die GeForce GTX 780 laut NVIDIA ca. 15 Watt, was auf einem Level mit der GeForce GTX 680 und GTX TITAN ist. Unter Spielelast nimmt die Karte um die 200-220 Watt (Messung von PCGH bei BF: Bad Company 2). Dies liegt also deutlich unter dem TDP, das wie auch das 100% Power-Target auf 250W spezifiziert ist.

Hier die Messungen (gesamtes System) von HardwareLUXX:

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen!

Passt die Karte in mein Gehäuse?

Bei der GeForce GTX 780 misst wie die GTX Titan das PCB 26,67 cm, was vielen High-End Karten vergangener Generationen wie etwa der GeForce 400- oder 500-Serie entspricht.

Wie viele GPCs sind bei meiner Karte aktiviert?

Da die GTX 780 über 12 SMX verfügt gibt es zwei möglichkeiten, wie die Karte ausgeliefert wird. Entweder alle 5 GPCs sind aktiv (in jedem GPC ist mindestens ein aktiver SMX) und man erhällt die reele Pixelfüllrate von 34,5 GPixel/s. Allerdings kann die möglichkeit bestehen, dass bei einer Karte auch ein ganzes GPC deaktiviert wurde (ein GPC besitzt keine funktionierenden SMX) und die Karte somit 20% weniger Pixelfüllrate besitzt (27,6 GPixel/s). Wie sich das in der Praxis auswirkt ist noch nicht bekannt. Allerdings ist dieser Unterschied wohl nicht spür- und auch nur selten Messbar.

Eine genaue Feststellung, wie viele GPCs aktiv sind lässt sich nur durch das messen der Füllrate testen.

Fillrate Tester | 3DCenter.org

Die Performance:

Eine Performanceeinordnung findet ihr im Hardwareluxx-test zur GeForce GTX 780. Im Schnitt erreicht die GTX 780 zwischen 90 und 95% der absoluten Leistung der GTX Titan und ist somit zwischen 20 und 30% schneller als die GTX 680 und rund 15% schneller als die HD 7970 GHz Ed.

Einige Messwerte:

Eine genauere Einordnung über mehrere Benchmarks findet ihr hier:

Launch-Analyse: nVidia GeForce GTX 780

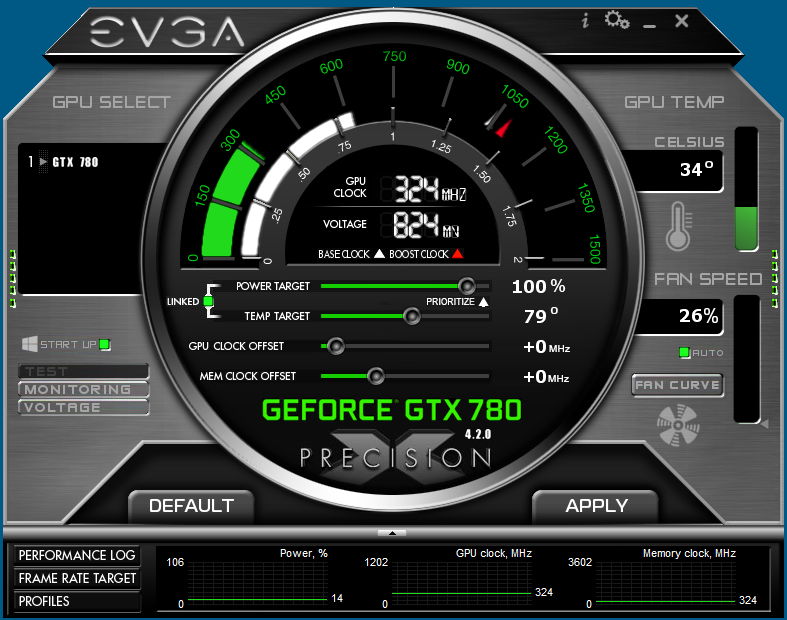

Overclocking:

Wie bei jeder Karte, die auf der Kepler-Architektur basiert, lässt sich der Takt von GPU/Shader und VRAM nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate, welcher sowohl den Basistakt, als auch den Boost-Takt gleichermaßen anhebt.

(Seit der GTX 680 nimmt die GPU immer nur noch 13MHz schritte an. Wenn man z.B. +50MHz Offset angibt, erhält man aber nur +39MHz mehr GPU-Takt, da in den +50MHz nur drei +13MHz Stufen drin sind. Die nächst höhere Stufe wären +52MHz.)

Die Höhe des GPU Boostes wird vollständig durch die Hardware geregelt. Es halten aber Messwerte wie Temperatur und anliegende Last in der Ermittlung der Höhe mit Einzug. So schwankt die Taktrate der GPUs ein paar MHz während der Anwendung. Hardwareluxx erreichte bei eingestellten 1,200V, Temperatur-Target von 90 °C und Power-Target von 106% eine maximale Taktrate von 1150/1625MHz. Das Overclocking wirkt sich wie folgt aus:

Performance:

Speicherbandbreite-Abhängigkeit

Geforce GTX 780 Taktskalierung im Test - 9 Games, 3 Auflösungen

Geforce GTX 780 Skin für EVGA Precision X (by me)

Custom BIOSe und flashen

Die GTX 780 lässt sich wie alle anderen Kepler-Karten ebenfalls mit andere BIOSe und eigenkreationen flashen. Das Vorgehen ist dabei das selbe wie schon bei der GTX 600er oder GTX 400/500er. Für mehr Informationen den passenden Thread aufsuchen:

GTX 700/600 - BIOS-Files

Geforce-Karten allgemein flashen unter Windows/DOS

Probleme mit ASUS/ASRock/Gigabyte Mainboards

Sporadisch sollen Probleme mit GTX 700-Karten bei der verwendung von ASUS/ASRock/Gigabyte Mainboards vorkommen. Falls man von solch einem Problem betroffen ist, kann dies helfen:

http://www.hardwareluxx.de/communit...x-780-oc-windforce-967164-3.html#post20864765

http://www.hardwareluxx.de/community/f300/asus-p8z68-deluxe-fehlercode-62-bei-770gtx-967392.html

http://www.hardwareluxx.de/community/f219/gigabyte-ga-x79-ud3-ud5-intel-x79-865610-27.html

https://forums.geforce.com/default/...-ti-wont-get-pc-past-motherboard-load-screen/

Custom-Karten

Anders als bei der GTX Titan erlaubt Nvidia bei der GTX 780 eigendesigns der Boardpartner. Da die GTX 780 über beinahe das selbe PCB wie die Titan verfügt, dürften alle verfügbaren Wasserkühler für die Titan auch auf die 780 passen.

Zurzeit sind schon auch schon einige neue Designs, wie das ACX-Design von EVGA verfügbar. Weitere Custom-Designs anderer Partner sind ebenfalls vorhanden, wie die sehr leise MSI GTX 780 Gaming und die extrem schnelle Inno iChill HerculeZ 2000. Dazu kommen schon bekannte Designs wie etwa von ASUS, Gainward und Palit (Direct CU II, Jetstream (Super Jetstream) und Phantom).

Da einige Besitzer des EVGA ACX-Designs sich über ein unrundes Laufverhalten des Lüfters im Idle beschwert haben, hat EVGA ein neues erstellt:

http://www.hardwareluxx.de/community/f300/gtx-780-acx-bios-mit-neuer-luefterregelung-969007.html

Der Vorteil dieser Designs ist nicht nur die teilweise niedrigere Lautheit der Karte, auch die niedrigen Temperaturen unter Last sorgen dafür, dass solche Custom GTX 780-Karten meistens den vollen GPU-Boost nutzen. Bei einigen Karten bedeutet das Taktraten von knapp über 1.100MHz und somit deutlich mehr Performance als mit den von Nvidia als Durchschnitt angegebenen 902MHz.

Allgemeine Hinweise

Dies ist ein Sammelthread für die GeForce GTX 780. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 6x0 und Radeon HD 7xx0 uvm.) angemessen.

Dieser Thread wird in zukunft erweitert.

(Dank an Edgecrusher86 für den Titan-Sammelthread - da die 780 sehr ähnlich ist, habe ich einiges aus seinem Sammelthread zitiert.)

Zuletzt bearbeitet:

aber is auch ne schicke

aber is auch ne schicke