NVIDIA GeForce GTX TITAN X (GM200) Sammelthread + FAQ

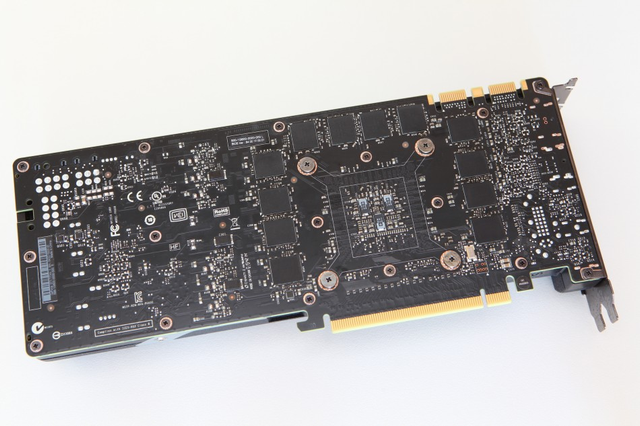

Impressionen der Karte:

Technische Daten der GeForce GTX TITAN X

- Chip = GM200-400-A1

- Fertigung = 28 nm (TSMC)

- Transistoren = 8,0 Milliarden

- Die-Größe = 601 mm²

- Shader-Einheiten = 3.072 (1D) (24 SMM)

- Texture Mapping Units (TMUs) = 128

- Raster Operations (ROPs) = 96

- Pixelfüllrate = 96,0+ GPixel/s

- Texelfüllrate = 192,0+ GTexel/s

- Chiptakt = 1.000 MHz Baseclock + Boost (1.076 MHz) + Estimated Boost

- Shadertakt = Chiptakt (1.000 MHz Baseclock + Boost (1.076 MHz)+ Estimated Boost)

- Speichertakt = 1.753 MHz

- Speichergröße = 12.288 MB

- Speichertyp = GDDR5

- Speicherinterface = 384 Bit

- Speicherbandbreite = 336,5 GB/Sek.

- Shader Model = 5.0

- DirectX = 12.1

- Leistungsaufnahme 3D (TDP) = 250W

- Leistungsaufnahme 2D = ~14W

- Versorgung über jeweils einen 8-Pin und einen 6-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = 1 x DL-DVI, 1 x HDMI 2.0, 3 x DisplayPort 1.2

- Hinweis: Multi-Monitoring = Die Karte kann bis zu fünf Monitore gleichzeitig ansteuern, im Surround-Modus (2D und 3D) maximal drei. !!

- Hinweis: Je nach Taktraten können Rechenleistung, Pixelfüllrate und Texelfüllrate sowie der Stromverbrauch abweichen.

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Introducing the GeForce GTX TITAN X at GTC 2015

NVIDIA GeForce GTX TITAN X Unveiled, Powering GDC

Einzelkartentests:

- deutsch:

- NVIDIA GeForce GTX Titan X im Test

- Nvidia GeForce GTX Titan*X im Test - ComputerBase

- Geforce GTX Titan X im Test: Top, aber teuer

- Nvidia GeForce GTX Titan X im Test: Kommt eine einzelne GPU mit 4K klar? - Einleitung

- -

- englisch:

- NVIDIA GeForce Titan X 12 GB Review | techPowerUp

- AnandTech | The NVIDIA GeForce GTX Titan X Review

- The NVIDIA GeForce GTX TITAN X 12GB GM200 Review | PC Perspective

- Nvidia GeForce GTX Titan X Review - Introduction

- Review: Nvidia GeForce GTX Titan X 12GB - Graphics - HEXUS.net

- NVIDIA GeForce GTX Titan X Video Card Review - Legit ReviewsThe GeForce GTX Titan X is The Baddest GPU of The Land

- The NVIDIA TITAN X Performance Review

- -

Geizhals Link:

GeForce GTX TITAN X | Deutschland - Hardwareluxx - Preisvergleich

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

oder direkt bei Nvidia

Tools:

Grafikkarten Analyse Tool GPU-Z hier

NVIDIA Inspector (Analyse Tool, OC, erw. Treibersettings) hier

EVGA Precision X hier

MSI Afterburner hier

FurMark VGA Stress Test hier

Futuremark 3D Mark (2013 - Basic Edition) hier

Futuremark 3D Mark 11 (Basic Edition) hier

Unigine Heaven 4.0 Benchmark (Basic Edition) hier

Unigine Valley 1.0 Benchmark (Basic Edition) hier

FAQ (Frequently Asked Questions)

Wie laut ist die Karte?

Die GeForce GTX TITAN erreicht im Leerlauf mit 0,3 Sone das Niveau der GTX 980. Der Radiallüfter dreht zwar ebenfalls mit ~1.100 RPM, aber anders als bei den anderen Karten mit Titan-Kühler nun schon mit 22% PWM-Stärke. Unter Last steigt die Lautheit auf bis zu 4,3 Sone (Anno 2070; 52% PWM @~2.550 RPM), was ähnlich Laut wie die bis zu 4,6 Sone der GTX 780 Ti ist (62% PWM @~2.600 RPM). Die Maximale Drehzahl des Radiallüfter beträgt nicht mer wie bei den anderen Referenzkarten 4.200, sondern 4.800 RPM - und ist somit klar stärker. (Werte aus dem BIOS der Karte)

Geforce GTX Titan X im Test: Top, aber teuer

Wie hoch sind die Temperaturen der Karte?

Die Temperatur der GTX TITAN X beträgt im Leerlauf vollkommen unbedenkliche 32 °C. Unter Last (Games) steigt die Temperatur bis auf 84 °C, wobei das Temperatur-Target genau 83°C beträgt. Sobald die 83°C überschritten werden, wird die Taktrate und Spannung gesenkt, sodass die Karte bei 83°C verweilt. Die Karte verhält sich also genau so wie die erste GTX TITAN mit GPU Boost 2.0 auch.

NVIDIA GeForce GTX Titan X im Test

Ganz interessant ist dieses Video von TechPowerUp:

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Wie hoch ist der Stromverbrauch?

Die GTX TITAN X verbraucht im Leerlauf um die 14 Watt. Bei der Verwendung von zwei Monitoren oder einer Blu-Ray-Wiedergabe steigt die Verlustleistung auf rund 18 Watt an. Unter Last limitiert das Power-Target den maximalen Verbrauch. So verbraucht eine Referenz-GTX TITAN X, egal ob in Games oder im Furmark, maximal 250 Watt (100% PT). Die Effizienz der Karte ist dabei immer noch gut, erreicht aber die die Effizienz der GM204 Referenz-Karten nicht ganz. PCGH misst in Anno 2070 242 Watt und in Risen 3 245 Watt, also Werte knapp unterhalb des Power Targets.

Geforce GTX Titan X im Test: Top, aber teuer

Passt die Karte in mein Gehäuse?

Bei der GeForce GTX TITAN X misst das PCB 26,67 cm, wie bei der GTX 770, 780, 780 Ti, Titan, Titan Black und 980.

Die Performance:

Launchanalyse der GTX TITAN X | 3DCenter.org

Die Karte ist gegenüber einer Stock GTX 980 zwischen 25 und 35% schneller. Je höher die Auflösung, desto weiter kann sich die neue Titan von der GM204-Basierenden Karte absetzen. In 4K oder Games mit sehr hohen Speicheranforderungen profitiert die TITAN X vom Plus an Vram, ohne aber wirklich satte 12 GiB zu benötigen.

Overclocking:

Wie schon bei jeder Karte, die auf der Kepler-Architektur basiert, lässt sich der Takt der neuen Maxwell-GPU nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate, welcher sowohl den Basistakt, als auch den Boost-Takt gleichermaßen anhebt.

Die GTX TITAN X lässt sich wie schon die anderen Maxwell-GPUs gut übertakten. So soll man ohne weitere Erhöhung der Spannung bis zu 1.300-1.400 MHz (max. boost) erreichen, was in etwa ein GPU-Offset von rund +150 bis +250 MHz darstellt. Der Speicher soll meistens 1.900 MHz schaffen, ab und zu auch über die 2.000 MHz (Ergebnisse, welche man schon von der GTX 770, 780 Ti, Titan Black, 970 und 980 kennt). Entsprechende OC-tests in den Reviews.

Allerdings limitiert das Power-Target von 250 Watt (+10% einstellbar = 275 Watt) beim Übertakteb doch deutlich. Dagegen wird erst ein Mod-BIOS helfen, damit die Karte ihre Taktraten konstant auf die Straße fahren kann.

Allgemeine Hinweise

Dies ist ein Sammelthread für die GeForce GTX TITAN X. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 780 Ti, Titan (Black), GTX 970, 980 und Radeon R9-290(X) uvm.) angemessen.

Custom-Designs

Laut nVidia wird es keine Custom-Designs geben, man fährt also auf der selben Schiene wie schon mit der GTX TITAN und GTX TITAN Black. In wieweit sich das möglicherweise ändern wird, bleibt abzuwarten.

Zuletzt bearbeitet: