@Majohandro Kann man so sehen. Denke ist individuell je nach Setup und Ansprüchen.

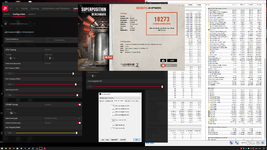

Ich habe das Spiel nicht, aber die RX 6800. Wenn ich das dann so interpoliere, komme ich bei 2500 MHz auf 109,3 FPS und mal realistisch prognostiziert auf 108 FPS. 108 / 99 = ~9 %. Scheint auf den ersten Blick nicht allzu viel, aber mit mehr Auflösung (in meinem Fall 3440 * 1440 oder gar je nach Anwendung 2160p) sind knapp 10 % Mehrleistung doch nicht übel.

Linear berechnet würde man mit 4k dann mit UV auf 44 FPS kommen (dürfte in der Praxis deutlich mehr sein, kommt mir jedenfalls sehr niedrig vor) und mit OC auf 48 FPS (+ 9 %). Das könnte schon bei einem 4k60-Freesync-Monitor den Unterschied zw. spielbar und nicht spielbar bedeuten. Ab 48 FPS fängt die Freesync-Range an.

Mit 3440 * 1440 und der linearen Interpolation sind es 74 FPS mit UV und 81 FPS (+ 9 %), was den Unterschied zwischen "gut flüssig" und "sehr gut flüssig" ausmacht. Als ich bei Forza Horizon 4 von 85 FPS-Frame-Limit auf 97 FPS-Frame-Limit gestellt habe, habe ich den Unterschied auch schon gut gespürt.

Ich hätte halt eine Nummer größer kaufen sollen damals, aber bin soweit relativ zufrieden. Die 25 % on-top sind ja auch etwa der Unterschied zw. RX 56 und VII gewesen und das war es mir damals auch wert und spürbar. Leider kann ich nicht alles "sorgenfrei" auf dem Ultra-Preset unter 3440 * 1440 mit "fluffiger" Frame-Rate (würde ab etwa 80 FPS als akzeptabel ansehen bei einem 100 Hz Monitor - mehr ist besser und merkbar wie gesagt) spielen. Ich hätte diese Generation gerne keine Kompromisse gemacht.

Bei RT sieht man das z.B. auch. In mittleren Details sind oft auch über 80 FPS drin, aber bei manchen NV-gesponsorten Titeln (Control, Quake 2 RTX, Cyberpunk ist leider noch fast unspielbar) muss ich auf die volle Breite des Monitors verzichten mit RT. Daher hoffe ich mal auf die Verwendung der AMD-optimierten Wave32-Instruktionen (da hat NV wohl aus dem Grund den Entwicklern die Empfehlung gegeben bei ihren Engines Wave64-Instruktionen zu bevorzugen - ein Schelm), die bis zu 20 % mehr Leistung in RT bringen sollen und auf FiFx SuperResolution.

Und ich will hoffen, dass SuperResolution meinen empfindlichen Augen zusagt. Wird auch nur ersichtlich, dass da etwas schlechtere Bildqualität dargestellt wird, werde ich das nicht anschalten. Meine Kumpels waren auch super enttäuscht von DLSS (Qualität) in Warzone und haben das ausgeschaltet (ok, da sind natürlich auch ohne DLSS viele FPS drin). Man muss sagen, dass die beiden absolute NVidia-Fans sind (, daher trotz Voreingenommenheit ihrerseits wohl zu schlecht für sie, was mich stark erstaunte, zumal sie auch nicht die sensibelsten Personen sind).

Ich werde da rage-quitten, wenn AMD das nicht in "von nativ ununterscheidbarer" Qualität hinbekommt. Ok, NV scheint das auch nicht ganz zu schaffen, aber falls die RT-Performance mit Super-Resolution sonst für genug FPS sorgen würde (auf einem Niveau mit NV etwa), aber ohne Super-Resolution auf jetzigem Niveau verbleiben würde dann bei schlechterer Bildqualität, würde ich mich getäuscht fühlen, denn es hieß von Anfang an: wartet auf unser DLSS-Pendant [, denn, ja die RT-Performance ist nicht soo super (oder so ähnlich)] (letzteres wurde nur in Benches gezeigt).