- Mitglied seit

- 30.03.2010

- Beiträge

- 5.991

- Ort

- Südpfalz

- Details zu meinem Desktop

- Prozessor

- Intel i5-13600K

- Mainboard

- MSI MPG Z790 EDGE WIFI DDR4

- Kühler

- AC cuplex kryos next (CPU), EKWB Monarch X4 (RAM), ALC Core (GPU), Mips RAM Cooler (Backplate)

- Speicher

- G.Skill Trident Z Neo 2x 16GB DDR4-4300 CL16

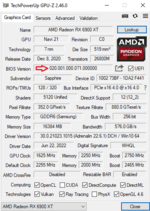

- Grafikprozessor

- MSI RTX 4080 Super Suprim X

- Display

- Samsung C49RG9 5.120 x 1.440

- SSD

- 8 TB M.2/SSD

- Soundkarte

- Beyerdynamic MMX 300, Klipsch ProMedia 2.1@Creative Sound Blaster Audigy FX V2

- Gehäuse

- Bitfenix Shinobi XL

- Netzteil

- Corsair HX1500i

- Keyboard

- Corsair K100 RGB Air Wireless

- Mouse

- Corsair M75 Air Wireless, Microsoft Xbox Elite Wireless Controller 2

- Betriebssystem

- Win 11 Pro

- Sonstiges

- Steuerung: AC Octo, AC farbwerk 360, AGB/Pumpen: EKWB XRES 140 D5 + 2x AC D5, Radiatoren: 2x 360, Mo-Ra 420

- Internet

- ▼250 MBit ▲50 MBit

Bin wieder zurück auf 21.11.3. Neuere Spiele hab ich noch nicht, und auf so einen Score mit Standard-Gaming-Einstellungen kann ich mit Adrenalin 22.x.y lange warten. Hatte in letzter Zeit größte Schwierigkeiten, 24/7 25K zu erreichen. Mit dem richtigen Treiber geht's wieder.

Da dies das Gaming- und nicht das Benchsystem ist, liefen alle Hintergrund- und Nebenprogramme und die Windows-Energieverwaltung war auf "Ausbalanciert". Man beachte bitte den CPU-Takt in GT2. Vor allem diejenigen, die dem 9900K gern ein CPU-Limit an die Backe labern würden.

Da dies das Gaming- und nicht das Benchsystem ist, liefen alle Hintergrund- und Nebenprogramme und die Windows-Energieverwaltung war auf "Ausbalanciert". Man beachte bitte den CPU-Takt in GT2. Vor allem diejenigen, die dem 9900K gern ein CPU-Limit an die Backe labern würden.

Zuletzt bearbeitet:

)

)