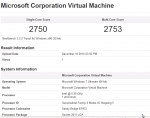

Ich habe einen ganz simplen Geekbench durchgeführt. Das mach ich eigentlich schon seit Jahren auf all meinen Rechnern und spiegelt doch recht genau auch meine "gefühlte" Performance wider.

Inzwischen habe ich diesen "Test" auch mit Hyper-V 2012 R2 durch. Langsamer als XenServer und ESXi aber immer noch deutlich schneller als Proxmox.

Prinzipiell sind KVM und ESXi in der Performance führend, XenServer und Hyper-V hinken aber nur marginal hinterher, das sollte nicht spürbar sein, nur messbar.

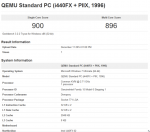

Sorry, aber da muss irgendetwas mit deinem Versuchsaufbau nicht ganz stimmen, die Treiber hast du schon installiert? Und du verwendest hoffentlich auch einen aktuellen Kernel (3er aus RHEL7 nicht den 2.6.32)mit Proxmox? Ansonsten funktioniert bei deiner CPU sicherlich nicht mal der Turbomodus richtig und auch grundsätzlich ist vieles anderes langsamer als es sein könnte.

https://alt.fedoraproject.org/pub/alt/virtio-win/latest/images/

Der CPU-Typ stimmt auch nicht, es wird bei dir ein Pentium aus dem Jahre 1997 emuliert, der reicht dann natürlich auch nicht alle neuen CPU-Features der letzten 17-Jahre durch.

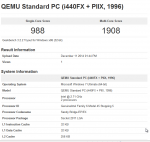

Es sollte etwas so wie bei mir hier angezeigt werden:

Achtung, Turbo-Mode ist hier nicht aktiv, daher niedriges Rating. Außerdem auch nicht die neust-mögliche Kernel/KVM-Kombination bzw. Konfiguration.

No offense, aber wenn dir solche Dinge nicht sofort auffallen, besonders nicht wenn du dich fragst warum die Ergebnisse so verschieden sein könnten, kann man deinem gesamten Versuchsaufbau nicht trauen da du vermutliche wo anders auch noch Fehler gemacht hast und die Ergebnisse damit recht wertlos sind.

Dann sollte man aber noch dazu sagen dass Kombinationsbenchmarks wie Geekbench eher weniger für solche Tests geeignet sind weil hier einfach viel zu viele verschiedene Dinge getestet werden die in den unterschiedlichen Virtualisierungslösungen durch viele Einstellungen und Aufbauten beeinflusst werden können und so das Ergebniss total verfälschen.

Beispiel Encryption-Tests: Wenn dann irgendwo AES-NI nicht durchgereicht wird hat man plötzlich gleich mal 100 Punkte weniger. Ähnliches gilt für viele andere Tests.

Wenn teste bitte etwas wie x264 (hier ist Xen z.B. meist etwas schneller als KVM oder Hyper-V) oder MySQL (mit I/O rein im Memory, ansonsten nicht ganz vergleichbar), alles andere ist zu komplex und bedarf einer intensiveren Betrachtung. Bei einem richtigem Aufbau werden sich dort alle von dir getesteten Lösungen nicht großartig unterscheiden, ESXi und Proxmox/KVM werden wahrscheinlich die schnellsten sein da sie am "nativsten" arbeiten, siehe beispielsweise den Unterschied in der Funktionsweise KVM zu Xen.

Es wird aber auch einige Überraschungen geben als dass beispielweise Software virtualisiert "schneller" läuft, oder zumindestens der Benchmark einem dies glauben lassen will, oder das ESXi/KVM plötzlich extrem langsam sind und Hyper-V etwas viel besser macht. Dies gilt aber nur für einzelne spezifische Disziplin, nicht für die Wald-und-Wiesen Tasks eines Servers.

Siehe z.B.

[Phoronix] Intel Haswell Linux Virtualization: KVM vs. Xen vs. VirtualBox

Bei Recherchen im Internet bei Benchmarks und Aussagen bitte auch immer auf das Datum gucken. KVM heute ist nicht dass was es vor 5 Jahren mal war und hat sich rasant entwickelt und zu anderen Lösungen aufgeschlossen oder sie überholt.

Dennoch danke für deine Mühen und Screenshots, auch wenn sie nicht ganz korrekt sind.