Hallo zusammen und frohe Weihnachen in die Runde,

ich habe gerade mal ein wenig mit meinem Proxmox Host rumgespielt und bin auf ein Problem oder vermutlich einfach

nur falsches Vorgehen von mir gestossen.

Ich war so naiv zu denken, dass ich 'ne Mellanox ConnectX-3 pro ja sicher ohne Probleme unter einem aktuellen PVE 8.3.2

(EFI und Secure boot) bertreiben kann. Aber offenbar ist es doch nicht so trivial.

Ich hatte bereits die MFT Tools von der nvidia Seite installiert (auch in der Version 4.22, wie empfohlen, da die letzte Version

mit ConnectX-3 und ConnectX-3 pro suport). Beim starten des tools mit mst start bricht er schon mit dem Fehler ab 'mst_pci driver not found'.

Ein lspci zeigt die Karte aber ohne Problem an. Wird die Karte überhaupt noch out of the box unterstützt, muss eventuell

manuell Treiber installieren oder ist das ganze zum scheitern verurteilt. Wobei er ja irgendwas zu finden und zu machen scheint.

Dec 25 12:12:14 pve kernel: mlx4_core: Mellanox ConnectX core driver v4.0-0

Dec 25 12:12:14 pve kernel: mlx4_core: Initializing 0000:01:00.0

Dec 25 12:12:14 pve kernel: mlx4_core 0000:01:00.0: DMFS high rate steer mode is: disabled performance optimized steering

Dec 25 12:12:14 pve kernel: mlx4_core 0000:01:00.0: 63.008 Gb/s available PCIe bandwidth (8.0 GT/s PCIe x8 link)

Dec 25 12:12:14 pve kernel: mlx4_en: Mellanox ConnectX HCA Ethernet driver v4.0-0

Dec 25 12:12:14 pve kernel: mlx4_en 0000:01:00.0: Activating port:1

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 1: Using 8 TX rings

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 1: Using 8 RX rings

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 1: Initializing port

Dec 25 12:12:14 pve kernel: mlx4_en 0000:01:00.0: registered PHC clock

Dec 25 12:12:14 pve kernel: mlx4_en 0000:01:00.0: Activating port:2

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 2: Using 8 TX rings

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 2: Using 8 RX rings

Dec 25 12:12:14 pve kernel: mlx4_en: 0000:01:00.0: Port 2: Initializing port

Dec 25 12:12:14 pve kernel: <mlx4_ib> mlx4_ib_probe: mlx4_ib: Mellanox ConnectX InfiniBand driver v4.0-0

Dec 25 12:12:14 pve kernel: <mlx4_ib> mlx4_ib_probe: counter index 2 for port 1 allocated 1

Dec 25 12:12:14 pve kernel: <mlx4_ib> mlx4_ib_probe: counter index 3 for port 2 allocated 1

Dec 25 12:12:14 pve kernel: mlx4_core 0000:01:00.0 enp1s0: renamed from eth0

Dec 25 12:12:14 pve kernel: mlx4_core 0000:01:00.0 enp1s0d1: renamed from eth1

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: /dev/mem,kmem,port is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: /dev/mem,kmem,port is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:18:55 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:49:20 pve kernel: mlx4_core 0000:01:00.0 enp1s0: entered allmulticast mode

Dec 25 13:49:20 pve kernel: mlx4_core 0000:01:00.0 enp1s0: entered promiscuous mode

Dec 25 13:49:20 pve kernel: mlx4_en: enp1s0: Steering Mode 1

Dec 25 13:49:20 pve kernel: mlx4_en: enp1s0: Link Down

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: /dev/mem,kmem,port is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: /dev/mem,kmem,port is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:54:50 pve kernel: Lockdown: mlxfwmanager: direct PCI access is restricted; see man kernel_lockdown.7

Dec 25 13:56:17 pve kernel: mlx4_core 0000:01:00.0 enp1s0: left allmulticast mode

Dec 25 13:56:17 pve kernel: mlx4_core 0000:01:00.0 enp1s0: left promiscuous mode

/EDIT

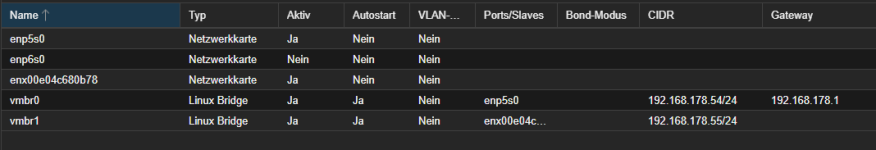

Hat sich mittlerweile soweit aufgeklärt. Der Zugriff mit den Mellanox Tools ging erst gar nicht, weil wohl secure boot im BIOS

akitivert war. Hat man es ausgeschaltet, liessen sich diese auch verwenden. Einzig die etwas merkwürdige unterschiedliche

Bezeichnung der beiden Ports war erst noch etwas irritierend. Aber ein zuweisen zur Bridge und er konnte dann

verwendet werden. Nun muss noch ein passendes Bracket gedruckt werden, damit die Karte dauerhaft drin bleiben kann.

root@pve:/etc/network# mlxfwmanager

Querying Mellanox devices firmware ...

Device #1:

----------

Device Type: ConnectX3Pro

Part Number: 779793-B21_0A

Description: HP Ethernet 10G 2-port 546SFP+ Adapter

PSID: HP_1200111023

PCI Device Name: /dev/mst/mt4103_pci_cr0

Port1 MAC: 9cdc714cb7a0

Port2 MAC: 9cdc714cb7a1

Versions: Current Available

FW 2.42.5044 N/A

CLP 8025 N/A

PXE 3.4.0754 N/A

UEFI 14.11.0048 N/A

Status: No matching image found

root@pve:/etc/network# mlxconfig -d /dev/mst/mt4103_pciconf0 q

Device #1:

----------

Device type: ConnectX3Pro

Device: /dev/mst/mt4103_pciconf0

Configurations: Next Boot

SRIOV_EN True(1)

NUM_OF_VFS 16

PHY_TYPE_P1 XFI(2)

XFI_MODE_P1 _10G(0)

FORCE_MODE_P1 False(0)

PHY_TYPE_P2 XFI(2)

XFI_MODE_P2 _10G(0)

FORCE_MODE_P2 False(0)

LOG_BAR_SIZE 5

BOOT_OPTION_ROM_EN_P1 False(0)

BOOT_VLAN_EN_P1 False(0)

BOOT_RETRY_CNT_P1 0

LEGACY_BOOT_PROTOCOL_P1 None(0)

BOOT_VLAN_P1 1

BOOT_OPTION_ROM_EN_P2 False(0)

BOOT_VLAN_EN_P2 False(0)

BOOT_RETRY_CNT_P2 0

LEGACY_BOOT_PROTOCOL_P2 None(0)

BOOT_VLAN_P2 1

IP_VER_P1 IPv4(0)

IP_VER_P2 IPv4(0)

CQ_TIMESTAMP True(1)

STEER_FORCE_VLAN False(0)

root@pve:~# lspci | grep Mellanox

01:00.0 Ethernet controller: Mellanox Technologies MT27520 Family [ConnectX-3 Pro]