ich hab 1994 mit 486 DX2 66MHz angefangen. Zudem Zeitpunkt kam Doom raus, was wir damals alle begeistert spielten *g*Hatte mit die ersten 3d Beschleuniger bei mir zum Unrealrealse in meinem Amd drin. eine Diamond Vipter V330 zusammen mit einer Miro Media Highscore 6MB Voodoo 1 Karte. Forsaken, Unreal, GTA, kamen paar richtig geile Spiele raus.

Jetzt etwa 10-15 Jahre später hat man keine 300mhz mehr, sondern inzwischen um die 3000Mhz und das auch mal 4 genommen ;-)

Grafikkarten hab nicht mehr 4 MB Speicher, sonderen teilweise 2048MB, 1024MB dürften fast schon normal sein.

Vor 10 Jahren war noch der Stand da, das ein Spielen auf dem PC eigentlich Sekundär ist, mitlerweile ist ein Spiele Pc als Primäres Daddelgerät durchaus gebräuchlich und häufig vertreten.

Egal wie das realisiert wird, über Rechenleistung braucht ihr euch absolut keine Gedanken machen. 6 -8 Cores sind ja von AMD bereits angekündigt. INtel virtualisiert mal eben 4 Cores und aus einem I7 wird dann mal eben ein virtueller 8 Core.

Tripple SLI Lösungen sind möglich, teuer aber möglich.

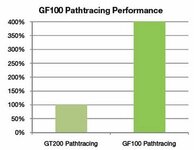

Was in 5-10 Jahren passieren wird, kann keiner Vorraussehen, aber ich gehe stark davon aus, das irgendwann die Technik und Rechenleistung soweit ist, dass Fotorealisitische Spielgrafik und Geometrie möglich sind. Raytracing ist da ein Schritt in die richtige Richtung.

viele Entwickler werden sich damit auch beschäftigen und letztendlich wenn es soweit sein wird auf den MArkt werfen. Fast kein anderer Markt im PC bereich ist so schnelllebig wie der PC Spiele Markt. ein aktueller Daddelrechner, entwickelt für eine relativ große Zielgruppe greift auf gebräuchliche PC Komponenten zurück, geparrt mit Grafikkarten, deren Markt wiederum von lediglich 2 Herstellern im Moment kontrolliert wird. Nvidia und ATI, was wiederum heißt, dass das Geld, was durch diese Märke fließt gigantisch groß ist.

Spekuliert, Misstraut, oder macht sonstwas, aber ich warte einfach nur ab und freue mich auf die kommende Technik, weil ich weiß, dass diie Entwickler Ihren Arsch hoch bekommen.