Also ich kann zumindest für mich sagen der 10900K 5 GHZ mit 4000er C19 B-Die Ramkit läuft für 4K 144 HZ ziemlich gut mit der RTX 4090.

Habe die Karte an Release gekauft und gut 4 Wochen im Rechner.

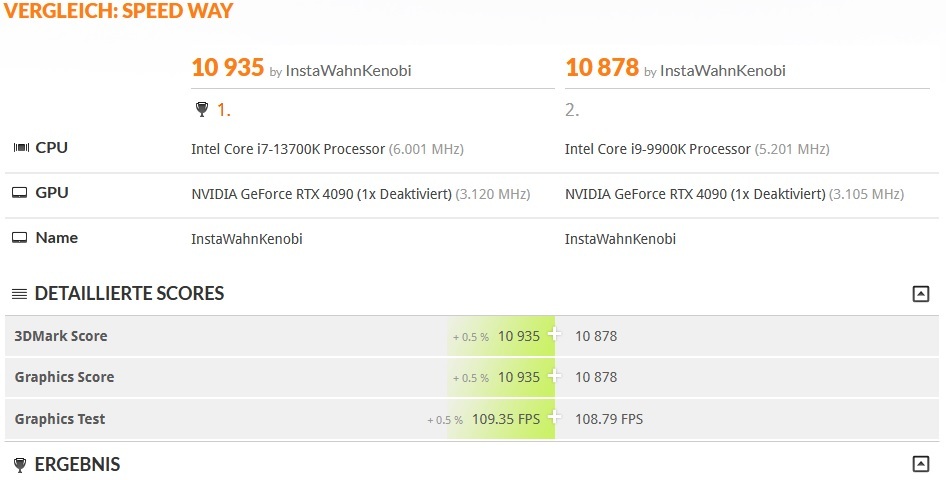

Hier mal aktuelle Ergebnisse in Timespy Extreme und Timespy normal.

Bei Timespy normal ist ein CPU Limit vorhanden , aber das Ergebnis ist dennoch ganz ordentlich.

Der Treiber wurde nicht modifiziert um bessere Ergebnisse zu haben.

www.3dmark.com

www.3dmark.com

So in CP 2077 ist kein CPU Limit vorhanden und GPU voll ausgelastet. 420 Watt Verbrauch @ Stock.

4K DLSS Qualität @ max. RT Ultra = 70-80 FPS etwa in der Stadt.

Bei DLSS Performance stiegen die FPS auf 120 FPS und GPU voll ausgelastet.

Kann man jetzt wirklich brauchbar zocken gegenüber RTX 3090.

Bei BF2042 ist das FPS limit bei 138 bei mir und wird meistens erreicht.

Portal Maps meistens schon aber auch im GPU Limit.

Bf2042 Maps haut die Map Ausrangiert an manchen stellen der Map ordentlich auf die GPU .

CPU limit kann vorkommen , wenn extrem viel los ist und die FPS fallen dann mal auf 115 kurz ab , obwohl die GPU nicht voll ausgelastet.

Bei Manifest oben auf dem Berg öfters festgestellt. Bisher aber nur im Conquest mit 128 Spieler.

Dying Light 1 the Following DLC durchgezockt (30 Stunden Spielzeit) mit der 4090 immer konstant 144FPS (framelimit)

Sieht echt schick aus das Game mit Auto HDR und max. Setting für das Alter.

PUBG lief bis gestern hervorragend @ 4K max. setting und 141 FPS Framelimit ohne Einbrüche.

Seit gestern war ein Update von PUBG und NZXT Cam Software zuvor glaube auch für Windows 22H2 und nun

nach 10 min. Gaming massive Einbrüche bis auf 20 FPS runter und wieder hoch auf 141 FPS und wieder runter in dauerschleife.

Keine Ahnung was das Game nun hat ich habe es runtergeschmissen und kein bock nach Fehlersuche mehr.

Takt blieb stabil und Temps im grünen , aber Leistungsaufnahme sank mit den FPS .

Alle anderen Games nach wie vor Fehlerfrei.

So ein Spiel wo ich nicht viel gezockt habe , aber mal getestet habe ist Ready or Not @ DX12 und DX 11 @ max. Setting @ 4K und DLSS/FSR etc. aus und da habe ich CPU Limit.

40% GPU Auslastung und FPS wecheln von 110-138 FPS (limit) je nach Situation. Vielleicht muss da noch optimiert werden. Meine da war ich insgesamt mit der 3090 besser dran.

Ansonsten Left 4 Dead 2 gespielt und Dead by Daylight , aber klar die Spiele haben keine Anforderungen , aber laufen Problemlos.

Also DX 9 Titel wie L4D 2 laufen auch Fehlerfrei.

Joa sehe auch kein Probem mit PCI E 3.0 und habe den Bandbreitenverbrauch im Gaming mit im Overlay von AB integriert und die ist meistens bei 15% von der max. PCI E 3.0 Bandbreite.

Ich denke das passt mit 1-2% Leistungsverlust den man aber vernachlässigen kann im Alltag.

Ich selber möchte upgraden mit Meteorlake und sehe da kein Problem mit der z490 Plattform , weil hatte sonst keine Bugs und Fehler wie Blackscreen beim booten oder

spontane rebbots beim surfen oder Video schauen. Habe auch Netflix und Amazon Prime viel am PC geschaut und auch HDR Inhalte via Netflix oder Edge Browser und das läuft auch bestens alles.

Da haben andere auf den neuen Plattformen wohl deutlich mehr Probleme und daher tuts für mich auch erstmal die z490 Plattform weiterhin.

Wer natürlich mehr als 144 FPS anpeilt braucht dann ggf. schon eine neue CPU , aber für 4K Gaming passt das Verhältnis noch soweit meiner Meinung nach.