Igor hatte ja mehrere Vermutungen geäußert, da wir einfach noch zu wenig gesicherte Erkenntnisse hatten um das Problem genauer einzugrenzen. Ich sehe nichts verwerfliches daran... Schlimmer wäre wenn er aus dem Gefühl heraus Problem X benannt und damit falsch gelegen hätte... Das die Caps nun laut EVGA "Schuld" sind ist halt dumm gelaufen  Tja, zeigt a) mal wieder das EVGA ein guter Laden ist (auch wenn die zugegeben in den lettzten Jahren nachgelassen haben) und man b) nicht am Launch kauft.

Tja, zeigt a) mal wieder das EVGA ein guter Laden ist (auch wenn die zugegeben in den lettzten Jahren nachgelassen haben) und man b) nicht am Launch kauft.

Ich denke es liegt effektiv an einer Kombination aus mehreren Dingen:

1. Boost der Karten sprengt unter Teillast die 2ghz - das Bios lässt zu viel Takt zu

2. Chipgüte schwankt durch Samsungs 8nm Prozess zu stark

3. Partner hatten kaum/wenig Möglichkeiten die Chips vernünftig zu testen und so die Güte einzuschätzen

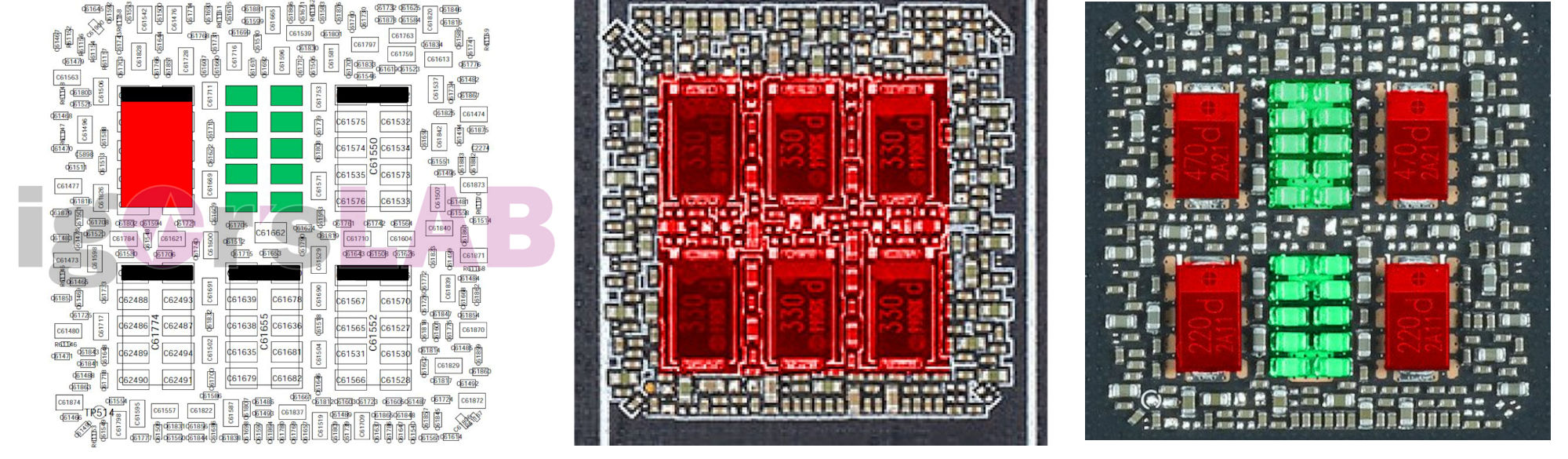

4. Die oben benannten Caps

Wenn man dann eine Karte mit schlechtem Chip und schlechtem Design erwischt UND die boostet dann noch hoch, ja dann gibts nen Crash. Effektiv wirds wohl entweder einen Rückruf geben oder man bringt ein Biosupdate um den Boost unter Teillast auf 1950-2000Mhz zu deckeln. Das das hilft haben ja schon einige Käufer mit Custom Taktkurven gezeigt.

Tja, zeigt a) mal wieder das EVGA ein guter Laden ist (auch wenn die zugegeben in den lettzten Jahren nachgelassen haben) und man b) nicht am Launch kauft.

Tja, zeigt a) mal wieder das EVGA ein guter Laden ist (auch wenn die zugegeben in den lettzten Jahren nachgelassen haben) und man b) nicht am Launch kauft.Ich denke es liegt effektiv an einer Kombination aus mehreren Dingen:

1. Boost der Karten sprengt unter Teillast die 2ghz - das Bios lässt zu viel Takt zu

2. Chipgüte schwankt durch Samsungs 8nm Prozess zu stark

3. Partner hatten kaum/wenig Möglichkeiten die Chips vernünftig zu testen und so die Güte einzuschätzen

4. Die oben benannten Caps

Wenn man dann eine Karte mit schlechtem Chip und schlechtem Design erwischt UND die boostet dann noch hoch, ja dann gibts nen Crash. Effektiv wirds wohl entweder einen Rückruf geben oder man bringt ein Biosupdate um den Boost unter Teillast auf 1950-2000Mhz zu deckeln. Das das hilft haben ja schon einige Käufer mit Custom Taktkurven gezeigt.

Zuletzt bearbeitet:

nach dem desaster. Das einzig gute an der ganzen Geschichte is die Nachfrage gewesen und da man die garnicht decken kann, kippt die Stimmung.

nach dem desaster. Das einzig gute an der ganzen Geschichte is die Nachfrage gewesen und da man die garnicht decken kann, kippt die Stimmung. .

.