Hallo zusammen,

nachdem ich als stiller Mitleser eine Menge an Ideen und Vorschlägen durch diesen Bereich des Forums erhalten habe, möchte ich demnächst mein altes QNAP TS-239 Pro durch ein leistungsfähigeres, selbstgebautes NAS ersetzen. Von FreeNAS als All-In-One-Lösung bin ich mittlerweile abgerückt. Stattdessen möchte ich eine dedizierte Storage-VM unter ESXi laufen lassen, zu der ich den SATA-Controller durchreiche.

Folgende Hardware stelle ich mir vor:

4 Western Digital WD Red 10TB, 3.5", SATA 6Gb/s (WD100EFAX)

1 Kingston ValueRAM DIMM 16GB, DDR4-2400, CL17-17-17-32, ECC (KVR24E17D8/16)

1 Supermicro A2SDi-8C-HLN4F retail (MBD-A2SDi-8C-HLN4F-O)

1 be quiet! Silent Wings 3, 140mm (BL065)

1 Lian Li PC-Q25B schwarz, Mini-DTX/Mini-ITX

1 be quiet! Pure Power 10-CM 400W ATX 2.4 (BN276)

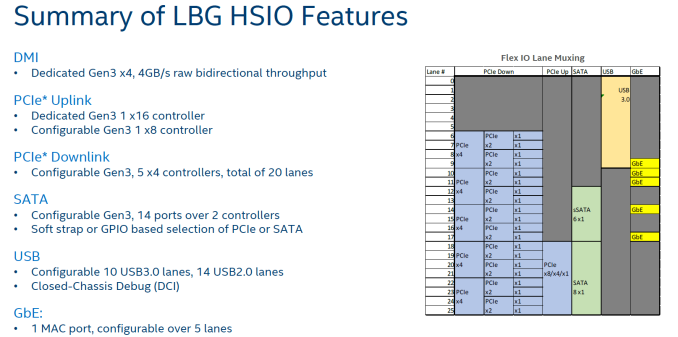

Das Board verfügt definitiv über genügend SATA-Ports, aber ich konnte bislang keine zuverlässigen Informationen darüber finden, ob sich der Onboard-Controller wohl problemlos durchreichen lässt, und (falls ja) in welcher Konstellation. Perfekt wäre es natürlich, wenn die 8 mini-SAS-Anschlüsse an einem separaten Controller hängen, sodass ich die vier normalen Anschlüsse sowie den m.2-Slot unter ESXi-Kontrolle belassen könnte. Die Optionen im BIOS deuten an, dass es so sein könnte (siehe Handbuch ab S. 73).

Gibt es hier Erfahrungswerte oder hat jemand von euch sogar eins der Denverton-Boards bereits selbst ausprobiert?

nachdem ich als stiller Mitleser eine Menge an Ideen und Vorschlägen durch diesen Bereich des Forums erhalten habe, möchte ich demnächst mein altes QNAP TS-239 Pro durch ein leistungsfähigeres, selbstgebautes NAS ersetzen. Von FreeNAS als All-In-One-Lösung bin ich mittlerweile abgerückt. Stattdessen möchte ich eine dedizierte Storage-VM unter ESXi laufen lassen, zu der ich den SATA-Controller durchreiche.

Folgende Hardware stelle ich mir vor:

4 Western Digital WD Red 10TB, 3.5", SATA 6Gb/s (WD100EFAX)

1 Kingston ValueRAM DIMM 16GB, DDR4-2400, CL17-17-17-32, ECC (KVR24E17D8/16)

1 Supermicro A2SDi-8C-HLN4F retail (MBD-A2SDi-8C-HLN4F-O)

1 be quiet! Silent Wings 3, 140mm (BL065)

1 Lian Li PC-Q25B schwarz, Mini-DTX/Mini-ITX

1 be quiet! Pure Power 10-CM 400W ATX 2.4 (BN276)

Das Board verfügt definitiv über genügend SATA-Ports, aber ich konnte bislang keine zuverlässigen Informationen darüber finden, ob sich der Onboard-Controller wohl problemlos durchreichen lässt, und (falls ja) in welcher Konstellation. Perfekt wäre es natürlich, wenn die 8 mini-SAS-Anschlüsse an einem separaten Controller hängen, sodass ich die vier normalen Anschlüsse sowie den m.2-Slot unter ESXi-Kontrolle belassen könnte. Die Optionen im BIOS deuten an, dass es so sein könnte (siehe Handbuch ab S. 73).

Gibt es hier Erfahrungswerte oder hat jemand von euch sogar eins der Denverton-Boards bereits selbst ausprobiert?

Zuletzt bearbeitet:

), aber wenn 16 GB sicher ausreichen, nehme auch gerne die kleinere Optane.

), aber wenn 16 GB sicher ausreichen, nehme auch gerne die kleinere Optane.