shavenne

Enthusiast

- Mitglied seit

- 02.07.2008

- Beiträge

- 936

- Ort

- OWL

- Desktop System

- Deep-Thought

- Laptop

- MacBook Pro (14", 2021, M1 Pro) & Lenovo ThinkPad T14 Gen1

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Ultra

- Kühler

- NZXT Kraken X63

- Speicher

- G.Skill Trident Z Neo 4x 16GB DDR4-3600 CL16

- Grafikprozessor

- NVIDIA GeForce RTX 4090 Founders Edition

- Display

- Dell S2721DGFA + Dell P2217H

- Soundkarte

- Focusrite Scarlett 4i4

- Gehäuse

- Fractal Meshify 2 XL

- Netzteil

- Corsair HX1500i (2022)

- Keyboard

- Ducky One 2 RGB PBT schwarz

- Mouse

- Razer DeathAdder V2 Pro

- Betriebssystem

- Windows 11

- Internet

- ▼1000 MBit ▲500 MBit

Betriebssystemtechnisch wäre ich da glaube ich flexibel.

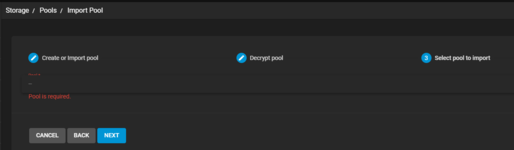

Unter Linux würde ich jetzt nämlich auch Staggered erwarten. Hat da wer Erfahrungswerte? Dann müsste ich in der Hinsicht zumindest mein aktuelles Datengrab nicht umstellen, falls ich da tatsächlich mal ein ZFS umsetze.

Wäre im Moment wohl schwierig aufgrund verschiedener Kapazitäten in meinem Datengrab (1x 6TB, 5x 4TB, 3x 3TB, 2x 2TB, 1x 1.5TB, dazu eine 6TB als Parität für snapraid und eine 500GB SSD als bcache), also ohne größere Investition erstmal nicht machbar. Aber man kann ja mal "rumspinnen"

Unter Linux würde ich jetzt nämlich auch Staggered erwarten. Hat da wer Erfahrungswerte? Dann müsste ich in der Hinsicht zumindest mein aktuelles Datengrab nicht umstellen, falls ich da tatsächlich mal ein ZFS umsetze.

Wäre im Moment wohl schwierig aufgrund verschiedener Kapazitäten in meinem Datengrab (1x 6TB, 5x 4TB, 3x 3TB, 2x 2TB, 1x 1.5TB, dazu eine 6TB als Parität für snapraid und eine 500GB SSD als bcache), also ohne größere Investition erstmal nicht machbar. Aber man kann ja mal "rumspinnen"

Zuletzt bearbeitet:

Und auch noch Rechner am Remote Standort wo man nicht schauen konnte.

Und auch noch Rechner am Remote Standort wo man nicht schauen konnte.