Werbung

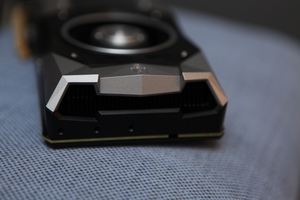

Moderne Grafikkarten bzw. die darauf verwendeten GPUs sind in ihrer Leistung extrem von den äußeren Bedingungen abhängig. Werden diese nicht eingehalten, kann die GPU nicht ihre maximale Leistung erreichen. GPU-Boost und PowerTune sind die Namen für solche Technologien von NVIDIA und AMD. Früher arbeiteten GPUs immer mit dem identischen Takt, heute werden variable Basis- und Boost-Taktraten vorgegeben. Dadurch wird die Kühlung einer Grafikkarte enorm wichtig, weshalb alle Hersteller ihre Kühllösungen in den Mittelpunkt stellen. Welche Vorteile solche Custom-Lösungen bieten, schauen wir uns im Beispiel der Gigabyte GeForce GTX 1080 Xtreme Edition an.

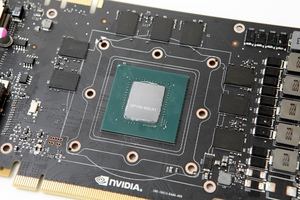

Die Gigabyte GeForce GTX 1080 Xtreme Gaming ist das aktuelle Spitzenmodell des taiwanesischen Herstellers. Wir haben uns die Karte bereits kurz nach dem Start der neuen Pascal-Serie genauer angeschaut und noch immer gehört sie zu den schnellsten Modellen am Markt. Gigabyte bietet wie einige andere Hersteller auch unterschiedliche Modi per Software an. Den Basis-Takt hebt Gigabyte von 1.607 auf 1.749 bzw. 1.784 MHz (Gaming- bzw. Boost-Mode) an. Für den Boost-Takt geht es von 1.733 auf 1.898 bzw. 1.932 MHz. Damit bewegt sich Gigabyte auf Niveau der ASUS ROG Strix GeForce GTX 1080, ist aber auf dem Papier zunächst einmal nicht so schnell wie eine KFA2 GeForce GTX 1080 HOF. Die 8 GB GDDR5X-Speicher übertaktet Gigabyte um 50 MHz auf 2.550 MHz. Damit steigt auch die Speicherbandbreite etwas an.

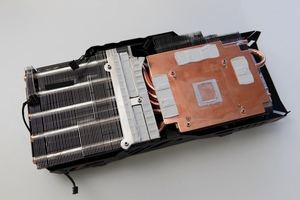

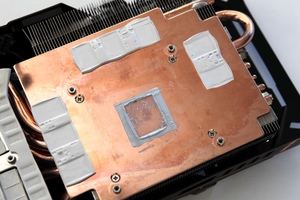

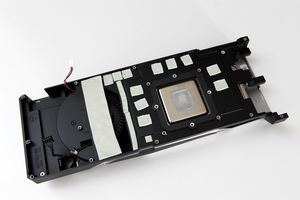

In unserem Test erreichte die Karte einen Boost-Takt von 1.987 MHz und bot damit ein paar Megahertz mehr, als es der Hersteller selbst angibt. Grund hierfür ist, dass sowohl das Powerbudget wie auch das Temperaturbudget größer ist, als es die Karte zunächst vorgibt. Bei 69 °C konnte die Kühlung überzeugen und eine zu hohe Temperatur stellte kein Limit dar. Doch wie kommt es zu den Unterschieden im Boost-Takt des Herstellers und in der Praxis und wie funktionieren Mechanismen wie GPU-Boost überhaupt? Was hat NVIDIA mit den Founder Editions für Pläne und warum sind diese nicht immer die beste Wahl?

[h2]GPU-Boost und die Abhängigkeiten[/h2]

Zusammen mit der aktuellen Pascal-Architektur führte NVIDIA auch eine neue Iteration des GPU-Boost-Mechanismus ein. GPU-Boost 3.0 unterscheidet sich vom Vorgänger GPU Boost 2.0 vor allem durch die Tatsache, dass nun kein fixer Offset für den Takt mehr angegeben wird, sondern ein Takt-Offset pro Spannungs-Punkt. 30 dieser Punkte sind bei der GP104-GPU auf der GeForce GTX 1080 vorhanden. Der Takt passt sich damit besser dem theoretisch maximalen Takt an, weil sich die Taktkurve genauer dem Maximum annähern kann.

GPU Boost 3.0 ermöglicht drei Modi: Im Basic Mode kann der Takt weiterhin standardmäßig als Offset eingestellt werden. Für den Nutzer ändert sich dabei im Vergleich zu GPU Boost 2.0 wenig. Im Linear Mode werden die Anfangs- und Endpunkte der Kurve gesetzt. Zwischen diesen Werten wird nur interpoliert. Der 3. Modus ist der Manuell Mode. Bei diesem wird jeder einzelne Spannungs-Punkt manuell angepasst.

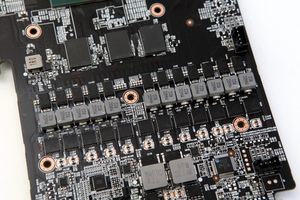

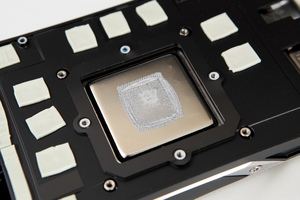

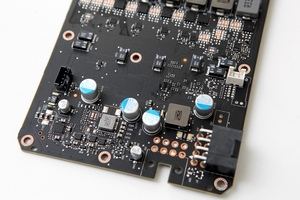

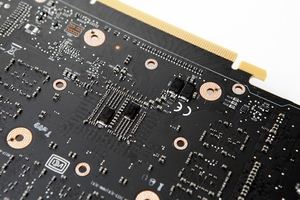

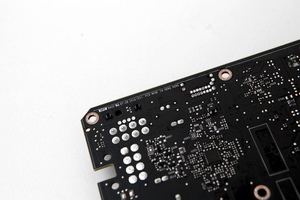

Bei einer Fertigung in 16 nm bei mehreren Milliarden Transistoren rücken die Strom- und Spannungsversorgung mehr und mehr in den Fokus. Jeder einzelne Bereich der GPU muss mit einer möglichst stabilen Spannung versorgt werden, weshalb dedizierte Schaltkreise vorhanden sind. Je umfangreicher diese Versorgungs-Infrastruktur in der GPU ausgebaut wird, desto stabiler sind die Spannungen. NVIDIA hat bei der Entwicklung der Pascal-Architektur bzw. der GP104-GPU tausende von Simulationen durchgeführt, um das letztendlich effizienteste Verhältnis zwischen der Spannungsversorgung und dem Takt der GPU zu finden. All diese Arbeiten liegen noch auf Seiten von NVIDIA, schon anders sieht dies bei der Strom- und Spannungsversorgung aus.

NVIDIA hat die Anforderungen an die beteiligten Komponenten angezogen und die Hersteller müssen dies umsetzen. So muss das GPU-Package ebenso gleichmäßig mit den notwendigen Spannungen versorgt werden. NVIDIA hat dazu das Board Channel Design optimiert, was vor allem das Layout des PCBs betrifft und von den Boardpartner umgesetzt werden muss. Wieder einen Schritt näher an die GPU-Architektur selbst rückt man mit einem Redesign der GPU Circuit Architektur – also den spannungsversorgenden Komponenten, die sich direkt auf der GPU selbst befinden. Damit haben die Boardpartner aber nichts zu tun.