Werbung

Auf der Google I/O hat der Suchmaschinen-Gigant nicht nur ein erstes faltbares Pixel-Smartphone, neue Mittelklasse-Geräte sowie ein Tablet vorgestellt, sondern außerdem ein paar Details zu seiner AI-Hardware verraten, welche für die eigenen Suchmaschine zum Einsatz kommen soll.

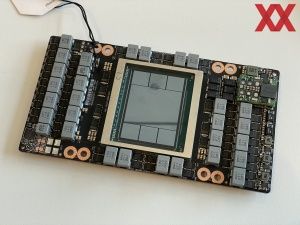

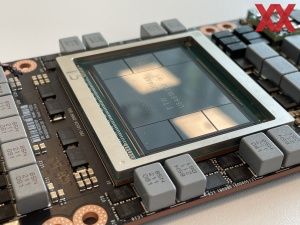

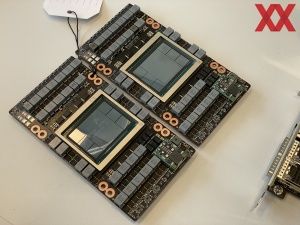

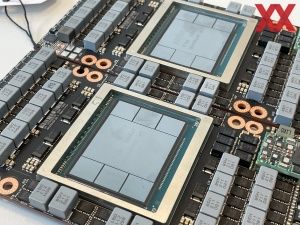

Das Compute Engine A3 getaufte System ist nicht ein einzelner Supercomputer, der sich in einem der vielen Rechenzentren von Google befindet. Es handelt sich vielmehr um A3-Instanzen, die über mehrere Rechenzentren verteilt sind. Diese bestehen aus mehreren DGX-H100-Systemen, welche wiederum einen Xeon-Prozessor (Sapphire Rapids) mit jeweils acht H100-GPUs verwenden. Hinzu kommen 2 TB an DDR5-4800. Wenn man alle A3-Instanzen zusammennimmt, redet man für die Compute Engine A3 von 26.000 GPUs. Der aktuell schnellste Supercomputer, der Frontier, hat 37.000 Radeon-Instinct-MI250X-GPUs. Facebook verwendet einen AI-Supercomputer mit 16.000 A100-GPUs, den Vorgängern des H100-Beschleunigers.

Google erlaubt es seinen Kunden, die A3-Instanzen zu nutzen. Man selbst braucht das volle System mit seinen 26.000 GPUs nicht ständig und daher macht die Aufteilung in mehrere Datacenter durchaus Sinn. Bei den Vorgänger-Instanzen, den A2, kommen NVIDIAs A100-GPUs zum Einsatz.

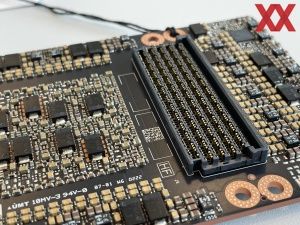

Innerhalb des SGX-Systems kommen die acht H100-GPUs auf eine Bandbreite von 3,6 TB/s an Interconnect-Datendurchsatz. Die DGX-System sind untereinander mit einem 200 GBit/s-Netzwerk miteinander verbunden. Hier kommen auch Googles eigene IPUs (Infrastructure Processing Unit) zum Einsatz, welche die Host-Systeme entlasten sollen, indem sie das Management des Datenverkehrs im Netzwerk übernehmen.

Der A3-Supercomputer kommt auf eine Rechenleistung von 26 ExaFLOPS bei niedriger Genauigkeit (AI-Rechenleistung). Damit gehört er zu den schnellsten AI-Systemen, die aktuell betrieben werden.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

Aber selbst mit dieser enormen Rechenleistung dauert es Tage und Wochen, um große Sprachmodelle (Large Language Model oder kurz LLM) zu trainieren. Erst in dieser Woche veröffentlichte MosaicML die MPT-7B-Modelle als Open-Source. Dieses wurden auf einem DGX-System mit acht H100-GPUs über 21 Tage trainiert. Das LLaMA (Large Language Model Meta AI) von Facebook benötigte ebenfalls 21 Tage und das Training kostete 2,2 Millionen US-Dollar.

GPT-4 von OpenAI soll über Monate trainiert worden sein und hat vermutlich hundert Millionen US-Dollar an Trainings-Kosten verursacht.