Werbung

Auf dem OCP Summit des Open Compute Project hat NVIDIA einerseits verkündet, dass sich die Blackwell-GPU "in full production" befindet und damit sollen einmal mehr Berichte eventuelle Probleme in der Fertigung gekontert werden. In der vergangenen Wochen nahmen die ersten Großkunden wie OpenAI und Microsoft ihre ersten Blackwell-Systeme in Empfang. Die Produktion wird in den kommenden Wochen und Monaten hochgefahren.

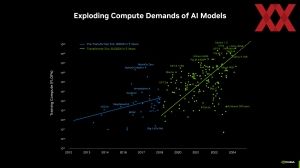

Aktuell spricht NVIDIA davon, dass die Nachfrage nach GPU-Beschleunigern ungebrochen ist. Die bisherigen Quartalsergebnisse belegen dies. Ende November werden die Zahlen für die letzten drei Monate erwartet. Für Blackwell soll die Nachfrage sogar noch höher sein – so wurde NVIDIAs CEO Jensen zuletzt in Interviews immer wieder zitiert.

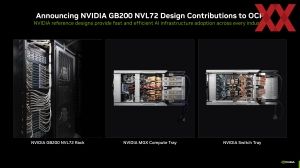

Zum OCP Summit: Neben der Produktion der Blackwell-GPUs ist NVIDIA als Teil des Open Compute Project daran interessiert, den offenen Standard weiter zu unterstützen – hier in Form dessen, dass das GB200 NVL72 Rack sowie das MGX Compute und NVIDIA Switch Tray als Design zum OCP-Standard hinzugefügt werden.

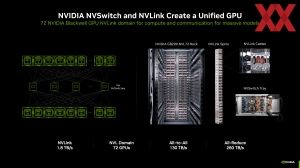

Seine Beschleuniger bietet NVIDIA bereits seit einiger Zeit als OAM (OCP Accelerator Module) an. Somit können Hyperscaler wie Meta ihre Server bauen und sich darauf verlassen, dass die Beschleuniger von AMD und NVIDIA darauf auch eingesetzt werden können. Die Wichtigkeit des NVIDIA Switch und des dazugehörigen Netzwerks unterstrich NVIDIA bereits vor einigen Wochen.

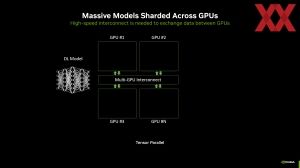

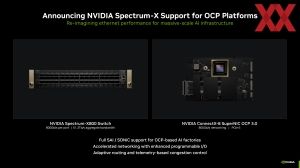

Neben der Kollaboration im OCP mit dem GB200 NVL72 Rack sowie dem MGX Compute und NVIDIA Switch Tray verkündet NVIDIA, dass man den eigenen Spectrum-X800-Switch sowie den dazugehörigen ConnectX-8 SuperNIC mit jeweils 800 GbE zur OCP-Plattform kompatibel macht. Dies beinhaltet unter anderem, dass diese die volle Unterstützung für SAI und SONiC erhalten. Letztendlich geht es hier darum, solche Netzwerke deutlich intelligenter und flexibler zu machen, sodass Daten aufbereitet und effizienter verteilt werden können.

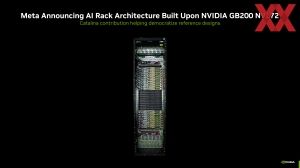

Meta verkündet in Zusammenarbeit mit NVIDIA, dass man ein eigenen AI-Rack namens Catalina entwickelt hat, welches auf dem GB200 NVL72 Rack basiert. Als GB200 NVL72 bezeichnet NVIDIA sein modulares KI-Rack bestehend aus 36 GB200-Beschleunigern mit jeweils 36 Grace-CPUs und 72 Blackwell-GPUs. Allesamt sind diese GPUs mittels NVLink miteinander verbunden.

Weitere Informationen zum GB200 NVL72 Rack finden sich in unserem Artikel zur GTC24.

Update:

Auch Google zeigt ein Custom-Rack auf Basis des GB200-NVL72-Designs. Der grundsätzliche Aufbau des linken Racks ist aber ganz ähnlich. In der Mitte befinden sich die Netzwerk-Switches, darüber und darunter die Compute-Trays. Oben und unten sind die notwendigen Netzteile zu sehen.