Werbung

NVIDIA weitet seine AI-Initiative immer weiter aus. Über die NVIDIA GPU Cloud (NGC) ist es Entwicklern nicht nur möglich, ihre Anwendungen schnell und einfach auf verschiedenen Cloud-Instanzen zu verlegen, sondern auch die Konfiguration für das Ersttraining deutlich zu vereinfachen. NVIDIA hat die Unterstützung der NGC-Container nun auf die Titan Xp ausgeweitet und auch GPU-Beschleuniger auf Basis der Volta-Architektur werden nun direkt unterstützt.

Damit haben die Nutzer von Deep-Learning-Anwendungen nun drei Möglichkeiten, die sich auf schnell und einfach ineinander überführen und damit skalieren lassen: Erstens ein Training auf eigner Hardware – relativ kostengünstig auf Titan-Grafikkarten. Zweitens kann größere Hardware entweder angeschafft oder in der Cloud angesprochen werden. NVIDIA selbst bietet dazu entsprechende Instanzen in den eigenen DGX-1-Datencentern an. Soll oder muss die Rechenleistung weiter ansteigen, können diese NGC-Container zusammen mit der eigenen Anwendung auf Amazon EC2-P3-Instanzen überführt werden, wo inzwischen auch Tesla V100 mit Volta-Architektur eingesetzt werden.

TensorRT 3 ab sofort verfügbar

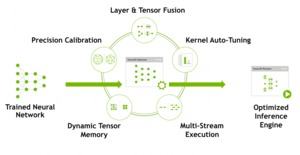

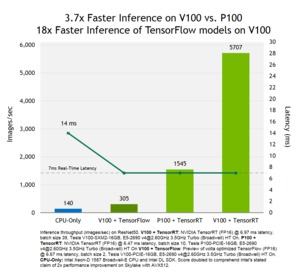

Entwicklern steht nun auch die dazugehörige neue Runtime namens TensorRT 3 zur Verfügung. Diese ist auf Deep-Learning-Anwendungen und die dazugehörige NVIDIA-Hardware hin optimiert und hilft bei der entsprechenden Beschleunigung. Kommt es auf eine besonders geringe Latenz an, soll TensorRT 3 bei INT8- und FP16-Berechnungen weiter beschleunigen. NVIDIA selbst spricht von einem um den Faktor 3,7 schnelleren Inferencing im Vergleich einer Tesla V100 gegen eine Tesla P100. Der Einsatz von TensorRT 3 soll einen um den Faktor 40 höheren Durchsatz ermöglichen, entsprechende Modelle werden damit um den Faktor 18 schneller.

Trainierte Modelle können auch von anderen AI-Netzwerken, zum Beispiel aus Caffe und TensorFlow in TensorRT 3 importiert werden. Nun ebenfalls integriert wird eine Optimierung und Validierung der Python API.

Mitglieder des Developer-Programms bei NVIDIA können TensorRT 3 ab sofort direkt bei NVIDIA herunterladen.