Werbung

In Zusammenarbeit mit MLPerf hat NVIDIA nun erste Leistungsdaten des A100-Beschleunigers auf Basis der Ampere-Architektur bzw. der GA100-GPU veröffentlicht. Vorgestellt hatte man diesen auf der GPU Technology Conference Mitte Mai. Neben der Datacenter- gibt es inzwischen auch eine PCI-Express-Variante.

MLPerf soll eine Vergleichbarkeit zwischen den verschiedenen Machine-Learning-Systemen ermöglichen, denn echte Benchmarks wie wir sie von unseren Tests kennen, gibt es nicht. Dies liegt vor allem daran, dass entsprechende Anwendungen an die Hard- und Software hochangepasst sind – dies macht eine Vergleichbarkeit nicht einfach.

Alle großen Chip-Hersteller arbeiten mit MLPerf zusammen. Auch die OEMs beteiligen sich daran. Ergebnisse können bei MLPerf nicht einfach nur eingereicht werden, sondern es gibt auch ein sogenanntes "Peer Review", bei dem mehrere Augen auf die Ergebnisse schauen und diese gegebenenfalls noch einmal testen, um sie zu belegen. Es gibt aber noch weitere Bedingungen, an die die Einreichung von Ergebnissen geknüpft ist. So muss es eine Möglichkeit geben, dass Kunden auf die Hardware Zugriff haben – sei es über Cloud-Instanzen oder aber man kann die Hardware direkt erwerben. Bei den A100-Beschleunigern gibt es sowohl die Möglichkeit die Hardware in der Cloud zu verwenden, die auch DGX-A100-Systeme zu erstehen.

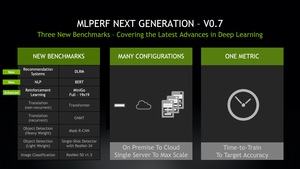

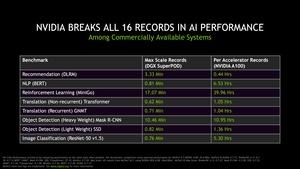

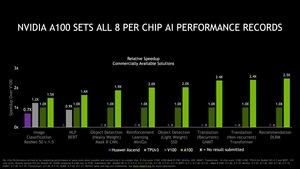

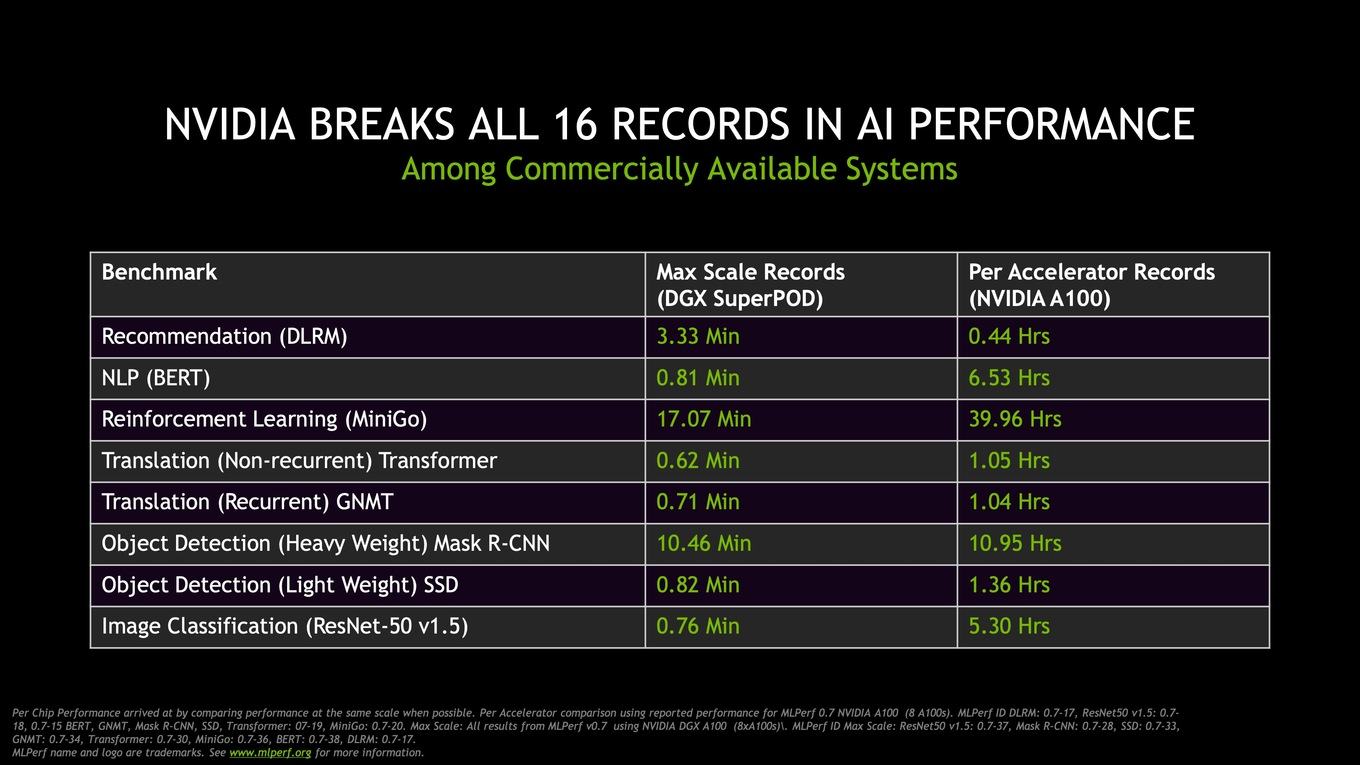

MLPerf stellt in der Version 0.7 eine Reihe Benchmarks zusammen. Insgesamt vorhanden sind 16 Benchmarks – in allen sieht sich NVIDIA mit dem A100-Beschleuniger nun in führender Position. Die betrifft sowohl den Betrieb eines einzelnen A100-Beschleunigers, als auch hochskalierte Systeme wie den DGX SuperPOD. Es handelt sich dabei erst einmal nur im Trainings-Benchmarks, in denen Deep-Learning-Syteme trainiert werden. Der andere Bereich, das Inferencing, spielt für MLPerf 0.7 zunächst einmal keine Rolle.

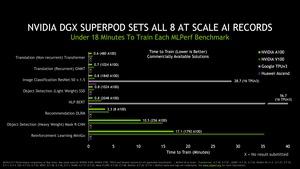

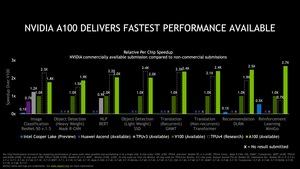

Kommen wir nun zu den weiteren Systemen, die in den Vergleichen herangezogen werden. Dies wäre ein V100-Beschleuniger aus eigenem Hause, also der direkte Vorgänger, aber auch ein Huawei-Ascend-System sowie ein Google TPU der dritten Generation.

Die eigene V100-Lösung als Referenzwert genommen soll ein System mit A100-Beschleunigern um den Faktor 1,5 bis 2,5 schneller sein. Die Konkurrenzsysteme bewegen sich in einem ähnlichen Bereich wie die Vorgängerlösung V100 (Faktor 0,7 bzw. 1,2), werden aber alle vom A100-System überflügelt. Allerdings sei an dieser Stelle erwähnt, dass die Konkurrenzsysteme teilweise keine Ergebnisse eingereicht haben.

Auch einen Blick in die Zukunft wagt NVIDIA, da auch Preview-Daten einpflegt werden können. Hier bezieht man dann auch Intels Xeon-Prozessoren der 3. Generation alias Cooper Lake mit ein. Auch die 4. Generation der TPUs von Google werden projeziert und liegen je nach Benchmarks mal auf Niveau des A100-Systems, mal sind sie aber auch deutlich langsamer oder leicht schneller. In den Fußnoten wird erläutert, ob die Leistungsdaten auf einen Chip normalisiert wurden oder ob hier eine Skalierung auf 8, 32, 64 oder gar 512 Beschleuniger vorgenommen wurde.

Die Leistungswerte im Vergleich richtig einordnen zu können, ist nicht immer ganz einfach. Man muss sich schon sehr genau anschauen, welche Werte hier im Rahmen der Erhebung durch MLPerf miteinander verglichen werden. Zumindest mittels der Leistungsdaten der vorherigen MLPerf-Tests mit eigener Hardware kann NVIDIA für sich proklamieren, dass die Leistung in den vergangenen 18 Monaten um den Faktor vier gestiegen ist.

Werte zum Inferencing liefert MLPerf 0.7 nicht. Auch hier soll der A100-Beschleuniger von NVIDIA durch die Tensor Cores der 3. Generation besonders schnell sein. Die Structural Sparsity kann hier neben den reinen Leistungswerten durch eine entsprechende Optimierungen einen weiteren Leistungsschub bedeuten.

MLPerf will neuer Standard werden

Anhand der Lücken in den Diagrammen ist zu erkennen, dass es zunächst einmal noch etwas dauern wird, bis die Vergleichsbasis flächendeckend ist. MLPerf gibt in der Version 0.7 aber schon einmal die Richtung vor. Für den A100-Beschleuniger kann NVIDIA die Leistung der Systeme verdoppeln bis vervierfachen – je nach Anwendung. Der Vergleich zur Konkurrenz ist jedoch nicht immer ganz einfach, da hier eben noch die Daten fehlen.

Auf www.mlperf.org können aktuell die Ergebnisse der Version 0.6 eingesehen werden. In Kürze dürften auch die Zahlen aus 0.7 komplett veröffentlicht werden.