Werbung

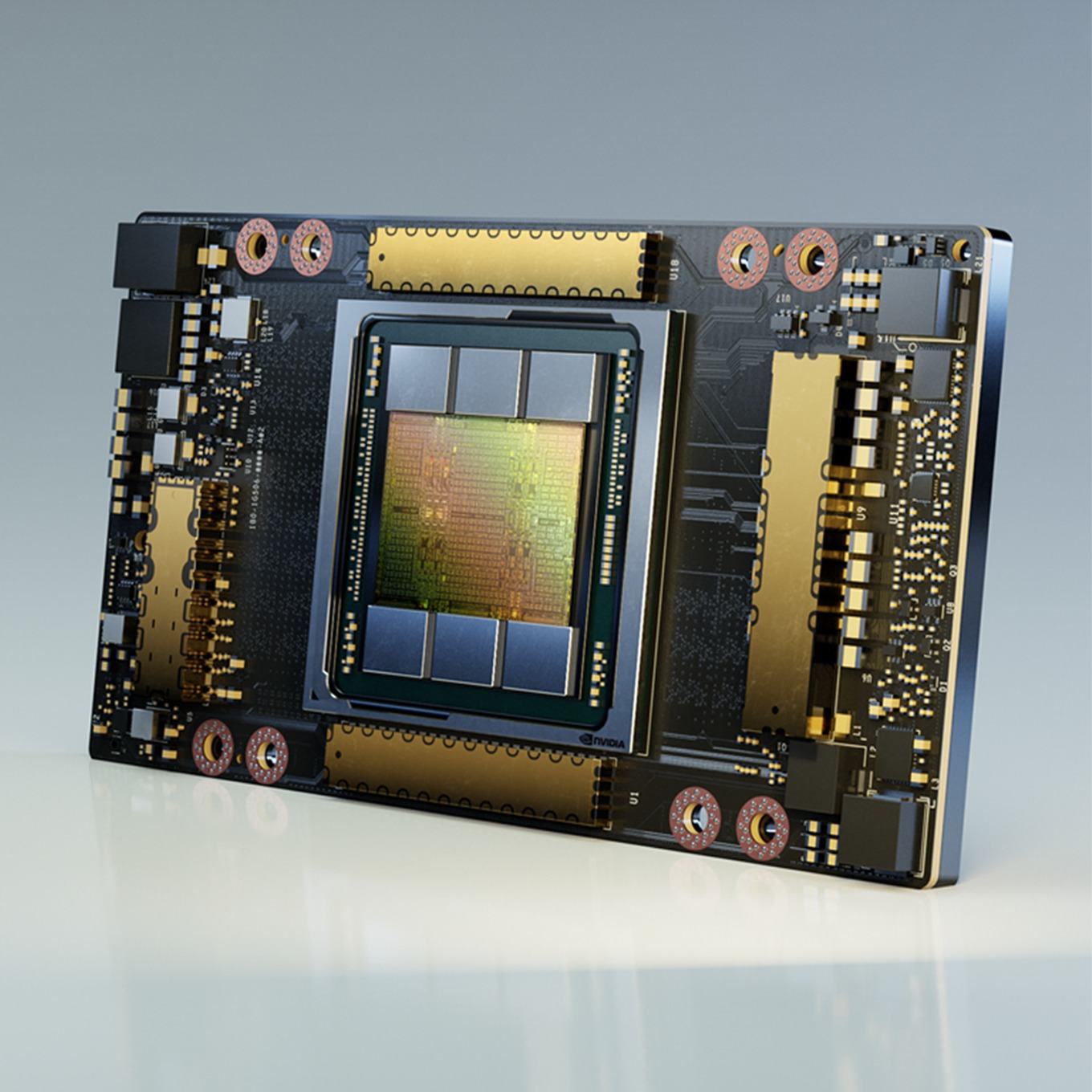

Die im Frühjahr auf der GPU Technology Conference vorgestellte A100 wird um ein weiteres Modell erweitert. Die A100 80GB GPU besitzt, wie der Name schon verrät, den doppelten Speicherausbau gegenüber der vorherigen Variante und bekommt zudem den schnelleren HBM2e spendiert.

Es bleibt allerdings beim GPU-Ausbau mit 108 SMs und damit 3.456 FP64- und 6.912 FP32-Recheneinheiten und auch das Speicherinterface verbleibt bei 5.120 Bit – ein Speicherchip der sechs vorhandenen wird also weiterhin nicht angesprochen und es handelt sich auch weiterhin nicht um den Vollausbau der A100-GPU. Durch den Einsatz von HBM2e steigt die Speicherbandbreite von 1,5 TB/s auf 2 TB/s. Die Thermal Design Power verbleibt ebenfalls bei 400 W, denn theoretisch ist es möglich bestehen DGX-Systeme mit den neuen Modulen auszustatten und dazu muss eine thermische Kompatibilität natürlich weiterhin gewährleistet werden.

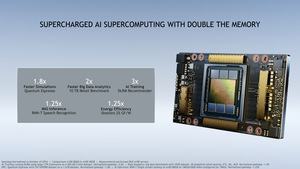

Durch den größeren und schnelleren Speicher steigt die Leistung – vor allem in Machine-Learning-Anwendungen, in denen große Modelle trainiert wird. Bis zu Faktor drei gibt NVIDIA in der Leistungssteigerung an, auch wenn die GPU-Rechenleistung identisch ist. Der schnellere und größere Speicher hat hier gerade bei größeren Modellen einen wesentlichen Einfluss auf die Leistung, was sich in den per NVLink verbundenen Systemen aus bis zu acht A100-GPU besonders deutlich zeigt.

Auch in der Aufteilung in bis zu sieben MIG (Multi Instance GPU) mit dann jeweils 10 GB anstatt 5 GB an schnellem Speicher kann die x je nach Anwendung ihre Vorteile ausspielen. Allerdings sind dies typischerweise Inferencing-Workloads und auch mit den größeren Batch-Sizes steigt die Leistung um "nur" 25 %.

NVIDIA hat bereits damit begonnen die ersten DGX-Systeme mit den A100 80GB GPUs auszuliefern. Angeboten werden sie von den OEMs und ODMs, die auch jetzt schon Systeme mit A100 40GB GPUs ausliefern.

DGX Station A100

Neben den DXG-Supercomputer-Systemen wird die A100 80GB GPU auch als erste Ampere-Lösung in einer Workstation verfügbar sein. Die neue DGX Station A100 bietet vier A100 80GB GPUs oder vier A100 40GB GPUs und damit einen per NVLink verbundenen Speicher mit einer Kapazität von 160 oder 320 GB. Mit der DGX Station A100 richtet sich NVIDIA vor allem an Entwickler, die an Software für AI- und Data-Science-Anwendungen arbeiten. Bisher war die DGX Station mit Volta V100 GPU-Beschleunigern ausgestattet. Abgesehen von PCI-Express-Variante der A100 GPU ist dies also nun die einfachste Möglichkeit ein solches System auf Basis der neuesten Ampere-GPU aufzubauen.

Zusammen mit den vier A100 GPUs verbaut sind ein AMD EPYC-Prozessor mit 64 Kernen und bis zu 512 GB an Arbeitsspeicher. An Speicher stehen 1,92 TB an NVMe-Speicher für das Betriebssystem und die Anwendungen sowie bis zu 7,68 TB NVMe-Speicher für die Daten zur Verfügung. Über zwei 10-GbE-Anschlüsse kann das System in das Netzwerk eingebunden werden. Vier Mini-DisplayPorts dienen der Möglichkeit entsprechende Monitore anschließen zu können.

Zur Kühlung verwendete NVIDIA bisher eine "einfache" Wasserkühlung. Für die DGX Station mit A100 GPUs hat man ein neues Kältemittel-Kühlsystem entwickelt, denn alleine die vier GPUs produzieren bereits eine Abwärme von 1.600 W.

Die DGX Station A100 wird noch in diesem Jahr verfügbar sein. Der Vorgänger kostete zuletzt ab 50.000 Euro.

Nur fünf Speicherstacks – Yield weiterhin problematisch

NVIDIA verwendet für alle A100 GPU-Beschleuniger nicht den Vollausbau der GA100-GPU. Dieser bestünde aus acht GPCs (GPU Processing Clusters), acht TPCs (Texture Processing Clusters) pro GPC, zwei SMs (Streaming Multiprocessors) pro TPC bzw. 16 SMs pro GPC und somit insgesamt aus 128 SMs (8.192 CUDA-Kerne). Hinzu kommen sechs jeweils 1.024 Bit breite Speichercontroller für den HBM2 und nun HBM2e. Theoretisch möglich wäre damit ein Speicherausbau von 48 bzw. mit HBM2e 96 GB.

Alle aktuellen Ausführungen der A100 GPU-Beschleuniger verwenden aber nur sieben GPCs und sieben oder acht TPCs bzw. GPC und kommen somit auf nur 108 SMs (6.912 CUDA-Kerne). Zudem sind nur fünf der sechs Speichercontroller aktiv, was bedeutet, dass wir nur einen Speicherausbau von 40 bzw. nun 80 GB sehen.

NVIDIA lässt die GA100-GPU bei TSMC in 7 nm (7N) fertigen. Auf die Frage warum es noch immer keine größere Ausbaustufe gibt sagte NVIDIA, dass man dies zur Steuerung der Ausbeute so vorsieht. Im Umkehrschluss bedeutet dies aber auch, dass man nicht ausreichend viele gute GA100-GPUs aus der Fertigung bekommt, um eine solche Option überhaupt zu erwägen. Es bleibt also weiterhin dabei das NVIDIA nur GA100-GPUs anbieten kann, bei denen etwa 10 % der Funktionseinheiten auf dem Chip deaktiviert sind und bei denen ein kompletter HBM2-Speicher ungenutzt brach liegt.

Für einen Chip mit 54 Milliarden Transistoren auf 826 mm², der an der Grenze dessen gefertigt wird, was aktuell möglich ist, bedeutet dies einen hohen Grad an ungenutztem Potenzial. In der Fertigung bezahlt NVIDIA diesen Overhead natürlich, kann ihn in den Produkten aber nicht nutzen. Womöglich ist man in der Entwicklung der GA100-GPU etwas über die Grenzen hinaus geschossen.