Werbung

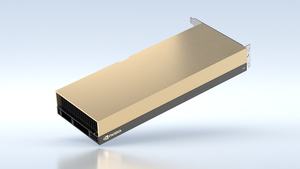

Ebenfalls auf der GPU Technology Conference vorgestellt werden neue Datacenter-GPUs auf Basis der Ampere-Architektur. Diese ergänzen die A100 als High-End-Variante sowie die A40, die bereits im Oktober 2020 zusammen mit der RTX A6000 vorgestellt wurde.

Der Blick auf die Ampere-Architektur zeigt: Große Zuwachsraten für die FP32- und INT32-Rechenleistung zahlen sich im Rendering aus. Davon profitieren die professionellen RTX-Karten (ehemals Quadro) ebenso wie die GPU-Beschleuniger für das Datacenter. Neu sind die A30, A16 und A10. Während zur A30 und A10 bereits einige technische Details bekannt sind, wissen wir von der A16 aktuell nur, dass sich hier gleich vier GPUs auf einem PCB befinden. Die A10 und A16 sind vor allem für virtuelle Workstations vorgesehen, während die A30 dank GA100-GPU auch noch eine ausreichende Rechenleistung über alle Genauigkeit zu bieten hat.

| A100 | A40 | A30 | A10 | |

| GPU | GA100 | GA102 | GA100 | GA102 |

| Transistoren | 54 Milliarden | 28 Milliarden | 54 Milliarden | 28 Milliarden |

| Fertigung | 7 nm | 8 nm | 7 nm | 8 nm |

| Chipgröße | 826 mm² | 628,4 mm² | 826 mm² | 628,4 mm² |

| FP32-ALUs | 13.824 | 10.752 | - | 9.216 |

| INT32-ALUs | 6.912 | 5.376 | - | 4.608 |

| SMs | 108 | 84 | - | 72 |

| Tensor Cores | 432 | 336 | - | 288 |

| RT Cores | - | 84 | - | 72 |

| INT4-Leistung | 1.248/2.496 TOPS | - | 661/1.321 TOPS | 500/1000 TOPS |

| INT8-Leistung | 624/1.248 TOPS | - | 330/661 TOPS | 250/500 TOPS |

| FP16-Leistung | 312/624 TFLOPS | - | 165/330 TFLOPS | 125/250 TFLOPS |

| Bfloat16-Leistung | 312/624 TFLOPS | - | 165/330 TFLOPS | 125/250 TFLOPS |

| FP32-Leistung | 19,5 TFLOPS | - | 10,3 TFLOPS | 31,2 TFLOPS |

| FP64-Leistung | 9,7/19,5 TFLOPS | - | 5,2/10,3 TFLOPS | - |

| Speicherkapazität | 40/80 GB | 48 GB | 24 GB | 24 GB |

| Speichertyp | HBM2 | GDDR6 | HBM2 | GDDR6 |

| Speicherinterface | 5.120 Bit | 384 Bit | 3.072 Bit | 384 Bit |

| Speicherbandbreite | 2.039/1.555 GB/s | 969 GB/s | 933 GB/s | 600 GB/s |

| TDP | 400/250 W | 300 W | 165 W | 150 W |

*Bei den Leistungsdaten sind die mit getrennten Werte Angaben zur nativen Leistung der Shader sowie der mit Sparsity-Unterstützung der Tensor Cores. Beim Speicher und der TDP muss man für die A100 zwischen der SMX4- und PCIe-Variante unterscheiden, was wir hier getan haben, in dem wir zwei Werte angeben, wobei der letztgenannte der für die PCIe-Karte ist.

Zur im vergangenen Herbst vorgestellten A40 hat NVIDIA noch immer keine Leistungsdaten veröffentlicht. Wir wissen aber, dass diese auf der GA102-GPU basiert, genau wie die nun neue A10. Fangen wir auch bei dieser an. Da NVIDIA 72 RT Cores nennt, wissen wir, dass hier 288 Tensor Cores und ebenso 72 SMs zum Einsatz kommen. Daraus lässt sich auf 4.608 INT32- und 9.216 FP32-Recheneinheiten schließen. Auf die Rohleistung bezogen dürfte die A10 also etwa 15 % langer als die A40 sein. Allerdings darf sich die A40 mit 300 W das doppelte an Leistungsaufnahme genehmigen, sodass diese zudem höher taktet, was die Leistungsdaten deutlich nach oben schraubt. Mit 24 GB und einer Speicherbandbreite von 600 GB/s muss die A10 auch mit insgesamt weniger und vor allem weniger schnell angesteuertem Speicher auskommen als die A40.

Zweites neues Modell ist die A30, die nicht auf einer GA10X-GPU basiert, sondern offenbar die GA100-GPU mit HBM2-Speicher verwendet. Hier kennen wir wiederum die Leistungsdaten für INT8 bis FP64, dafür aber macht NVIDIA keine Angaben zur Ausbaustufen. Die Anzahl der INT32- und FP32-Recheneinheiten sowie RT und Tensor Cores ließe sich theoretisch zurückrechnen, wir warten hier aber, bis wir von NVIDIA die offiziellen Angaben bekommen.

Grob gesagt leistet die A30 in etwa halb so viel wie eine A100. Dafür benötigt sie im Vergleich zur PCIe-Variante aber auch deutlich weniger Leistung. Einen größeren Unterschied gibt es auch beim Speicherausbau und Speicherinterface. Auf 24 GB HBM2 kann die GA100-GPU hier zurückgreifen. Diese sind über ein 3.072 Bit breites Speicherinterface angebunden und liefern 933 GB/s. NVIDIA verwendet hier also nur drei der sechs möglichen Speicherchips und kommt so auf die entsprechende Kapazität und Anbindung.

Dritter neuer GPU-Beschleuniger der A-Serie ist die A16. Die A16 stellt aber eine gewissen Besonderheit dar, denn hier nennt NVIDIA die wenigsten Details, verbaut aber offenbar gleich vier Ampere-GPUs auf einem PCB. Diesen stehen jeweils 16 GB an GDDR6 zur Verfügung – insgesamt also 64 GB. Die A16 dürfte vor als Media-Beschleuniger oder als vGPU-Karte interessant sein. Entsprechend lassen sich den virtuellen GPUs 1, 2, 4, 8 oder 16 GB an Grafikspeicher zuordnen. Außerdem stehen vier NVENC-Encoder bzw. acht NVDEC-Decoder auf der A16 zur Verfügung.

Allesamt unterstützen die bestehen und neuen Modelle der A-Serie PCI-Express 4.0. Die A100, A40 und A30 können mittels NVLink modellgleich zusammengefasst werden. Die A10 und A16 bieten keinerlei NVLink. Als Datacenter-Karten verzichten alle Modelle auf Display-Ausgänge, die in diesem Anwendungsbereich auch nicht notwendig sind. Die Kühlung erfolgt passiv über den Luftstrom des Servers. Mit Strom versorgt werden alle Modelle über einen EPS12V mit acht Pins.

Während die A30 und A10 noch im April diesen Jahres verfügbar sein sollen, wird die A16 erst im Verlaufe des aktuellen Jahres verfügbar sein.