Werbung

Bisher kannten wir nur die wichtigsten Kenngrößen der größten Ada-Lovelace-GPU, der AD102 wie sie auf der GeForce RTX 4090 zum Einsatz kommen. Inzwischen aber hat NVIDIA auch für die AD103-GPU der GeForce RTX 4080 mit 16 GB und für die AD104-GPU der GeForce RTX 4080 mit 12 GB einige technische Details nachgereicht.

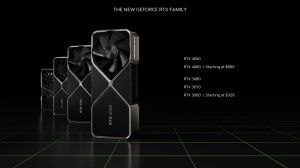

Bevor wir dazu kommen noch der Hinweis auf die bisherige Berichterstattung zur GeForce-RTX-40-Serie. Ab dem 12. Oktober wird die GeForce RTX 4090 erhältlich sein. Spätestens dann ist auch mit einem entsprechenden Testbericht zu rechnen. Die beiden Modelle der GeForce RTX 4080 werden im Oktober folgen.

| AD102 | AD103 | AD104 | |

| verwendet für | GeForce RTX 4090 | GeForce RTX 4080 16 GB | GeForce RTX 4080 12 GB |

| Die-Größe | 608,3 mm² | 378,6 mm² | 294,5 mm² |

| Anzahl der Transistoren | 76 Milliarden | 45,9 Milliarden | 35,8 Milliarden |

| Transistordichte | 124,9 MTr/mm² | 121,2 MTr/mm² | 121,6 MTr/mm² |

| SMs | 144 | 80 | 60 |

| FP32-Recheneinheiten | 18.432 | 10.240 | 7.680 |

| RT Cores | 144 | 80 | 60 |

| Tensor Cores | 576 | 320 | 240 |

| L2-Cache | 96 MB | 64 MB | 48 MB |

| ROPs | 192 | 112 | 80 |

| Speicherinterface | 384 Bit | 256 Bit | 192 Bit |

Die Abstufungen für die einzelnen GPUs und deren Ausbaustufen folgen einem fast linearen Verlauf. Wir sprechen hier immer vom Vollausbau, der auf den GeForce-Karten so aber nicht vorkommt. Einzig die AD104-GPU wird 1:1 so auf der GeForce RTX 4080 mit 12 GB verwendet. Als kleinster Chip scheint die Ausbeute hier gut genug zu sein.

NVIDIA gibt an, dass die Fertigung bei TSMC in 4N stattfindet. Dies ist nicht mit N4 zu verwechseln, wie der Taiwanesische Auftragsfertiger seinen eigenen Prozess nennt. Bei 4N handelt es sich um eine für NVIDIA angepasste Fertigung in 5 nm. Die Namen sind hier wie immer Schall und Rauch. Man dürfte von einer Fertigung in der 4-nm-Klasse sprechen dürfen. Die Transistordichte liegt bei knapp über 120 Millionen Transistoren pro Quadratmillimeter.

Speicherinterface wächst nicht, L2-Cache dafür umso größer

Ein Trend ist in den letzten GPU-Generationen deutlich zu spüren: Das Speicherinterface wird nicht immer breiter, stattdessen setzen die Hersteller auf immer größere Caches. AMD vermarktet dies sogar offensiv als Infinity Cache, der im Fall der größten Navi-GPU 128 MB groß ist.

Bisher war der L2-Cache bei NVIDIA mit 6 MB für die GA102-GPU vergleichsweise klein. Nun wird diese Kapazität bereits von der AD104 mit ihren 48 MB um das achtfache überboten. Bei der AD102-GPU kommen wir sogar auf 96 MB. Für NVIDIA sind die größeren Caches eine Möglichkeit die Beschränkungen durch das Speicherinterface zu umgehen. Mit 384 Bit ist man hier sogar noch vergleichsweise "breit" aufgestellt. AMD setzte zuletzt auf ein 256 Bit breites Interface. Die Daten sollen größtenteils auf dem Chip verbleiben können – daher die großen Caches. Zugriffe auf den Speicher sollen minimiert werden. Diesen Weg schlägt man nun auch offenbar bei NVIDIA sein, vermarktet dies aber nicht ganz so offensiv, wie dies AMD tut.

Womöglich tut man auch gut daran, denn in den Foren brodelt es schon bezüglich der GeForce RTX 4080 mit 12 GB Grafikspeicher. Die Karte unterscheidet sich nicht nur durch fehlende 4 GB von der GeForce RTX 4080 mit 16 GB, sondern durch 20 % weniger Funktionseinheiten, ein schmaleres Speicherinterface (192 zu 256 Bit) sowie damit verknüpft eine geringere Speicherbandbreite (504 zu 720 GB/s). Beide firmieren aber unter dem Label "GeForce RTX 4080", was den weniger informierten Käufer dazu verleiten könnte zum günstigeren Modell zu greifen.

Ob sich NVIDIA damit einen Gefallen getan hat, werden die Käufer letztendlich entscheiden. Uns missfällt diese Entscheidung natürlich, da hier eine "GeForce RTX 4070" mit einem eigentlich falschen Label versehen wird – die Einordnung in der Modellreihe ist in dieser Form einfach nicht richtig. Alles was uns nun bleibt ist möglichst gut darüber zu informieren, damit der Käufer auch eine gut informierte Entscheidung fällen kann. Die dazugehörigen Benchmarks und Einschätzungen werden dann im Oktober folgen.