Werbung

Im November des vergangenen Jahres zeigte Intel erstmals die eigenen Ambitionen hinsichtlich spezieller Hardware für das Training von Neuronalen Netzen. An dieser Stelle sei noch einmal auf die Unterscheidung zwischen dem Training eines solches Netzwerkers und der Nutzung bzw. Auswertung der dort enthaltenen Daten hingewiesen. Beide Prozesse haben unterschiedliche Anforderungen hinsichtlich der Hardware und um diesen gerecht zu werden unterschiedet NVIDIA auch in der Hardware – Tesla P100 für das Training und Tesla P4 und P40 für das sogenannten Inferencing.

Auch bei Intel unterscheidet man in der Hardware zwischen den verschiedenen Verwendungszwecken. Intel hat dazu in den vergangenen Jahren einige Unternehmen aufgekauft, um sich die entsprechende Expertise anzueignen. Zwar kann ein Training und Inferencing auch mit einem Xeon-Prozessor oder einem Knights-Landing-Beschleuniger ausgeführt werden, durch die spezielle Ausrichtung der Hardware auf einen Verwendungszweck, können die Zeiträume für die Berechnungen aber deutlich verkürzt werden.

Für das Inferencing verwendet Intel einen FPGA von Arria. Erste Samples dieser Hardware wurden bereits ausgeliefert und noch in diesem Jahr soll sie auch für alle verfügbar sein. Auf einem AI-Event in München zeigte Intel nun weitere Details zum Lake-Crest-Beschleuniger. Golem.de war vor Ort und hat die Details in einem Artikel aufbereitet.

[h2]Schneller Interconnect und HBM2[/h2]

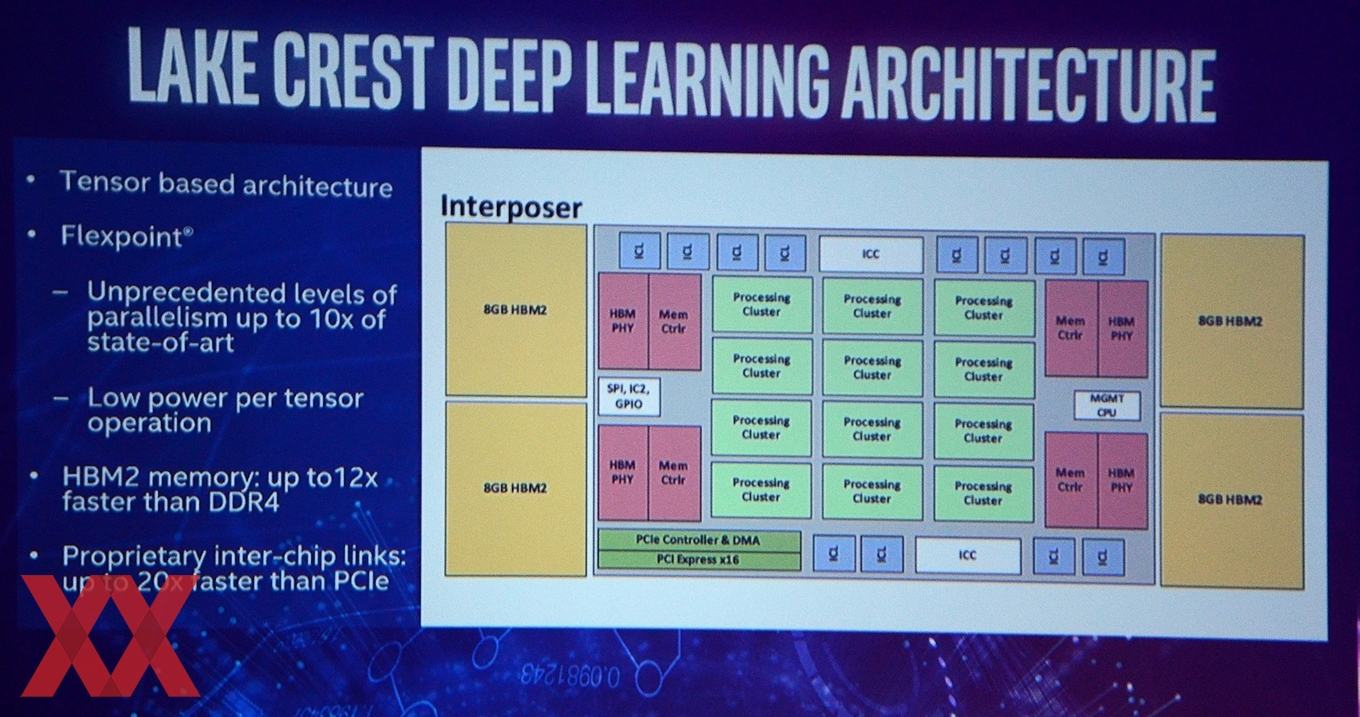

Die Hardware von Lake Crest setzt vor allem auf einen schnellen Datenaustausch. Zwischen den zwölf Processing Cluster in Lake Crest ist ein bidirektionaler Interconnect implementiert, der 100 GBit/s erreicht. Zusammengenommen erreicht der Interconnect also 1,2 TBit/s. Wie wichtig ein schneller Interconnect ist, hat auch AMD zuletzt noch einmal deutlich unterstrichen und auf den Infinity Fabric als das Grundgerüchst für die Zen- und Vega-Architektur genauer erläutert. Wie schnell der Data-Teil des Infinity Fabric aber nun sein soll, ist derzeit nicht bekannt. AMD erwähnte nur, dass mindestens die Übertragungsrate von HBM2 in Form der dort gebotenen 512 GB/s erreicht wird.

Ein weiterer wichtiger Bereich ist die Anbindung eines möglichst schnellen Speichers. Hier sieht Intel die Verwendung von HBM2 vor. In vier Speicherstacks sollen jeweils 8 GB mit 256 GB/s pro Chip verwendet werden. Insgesamt soll Lake Crest demzufolge über 32 GB HBM2 verfügen, der eine Bandbreite von 1 TB/s bereitstellt. Zusammen mit den Recheneinheiten befindet sich der Speicher auf einem Interposer.

[h2]Processing Cluster für Berechnungen[/h2]

Zweites wichtiges Standbein eines solchen Beschleunigers sind die Recheneinheiten. Intel bezeichnet diese nur als Processing Cluster, ohne genauer auf die Fähigkeiten einzugehen. Die Processing Cluster teilen sich sicher noch einmal in kleinere Recheneinheiten auf. Wie viele dieser Recheneinheiten letztendlich in Lake Crest arbeiten, ist nicht bekannt. Intel spricht bei der Rechenleistung auch nicht mehr von Floating Point Operations (FLOPS), sondern von Flex Point Operations. Bei NVIDIA spielen im Zusammenhang mit der Rechenleistung vor allem die INT8-Berechnungen eine wichtige Rolle. Bei Intel dürfte dies nicht anders sein.

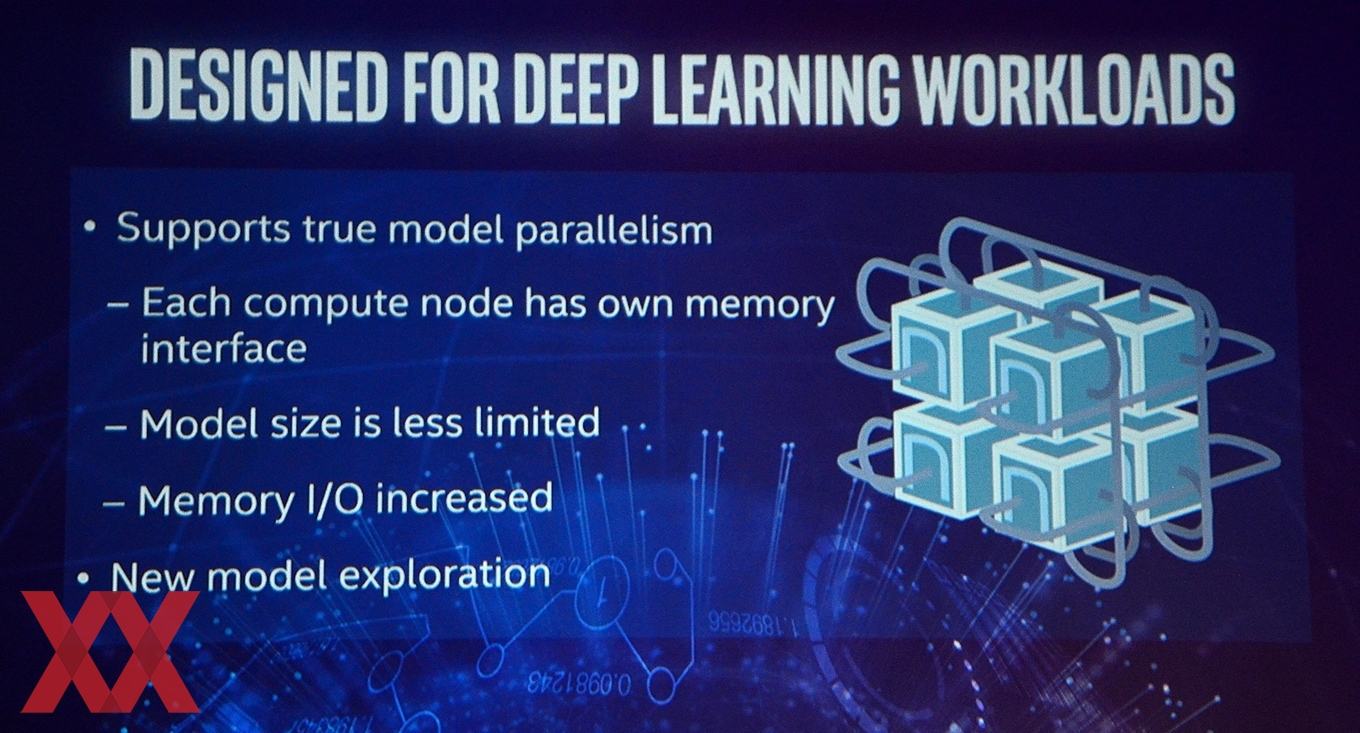

Lake Crest ist eine spezielle Hardware, die auf eine spezielle Anwendung ausgelegt ist. Das Training von Deep-Learning-Netzwerken und Neuronalen Netzen setzt bei einer gewünschten Rechenleistung für das Training eine bestimmte Hardware voraus. Bei NVIDIA sind dies der Tesla P100, bei AMD soll die Radeon Instinct MI25 mit Vega-GPU und Google hat sich mit der TPU ebenfalls eine eigene Hardware entwickelt. Noch in diesem Jahr sollen die ersten Partner die Samples von Lake Crest erhalten.