Werbung

Auf der GPU Technology Conference stellt NVIDIA mit Grace einen eigenen HPC-ARM-Prozessor vor, welcher in zukünftigen Supercomputern zum Einsatz kommen soll. Benannt ist der Prozessor nach Grace Hopper. Hopper war eine Informatikerin und Computerpionierin, die sich vor allem mit ihrer Arbeit, Computerprogramme in einer verständlichen Sprache zu verfassen, einen Namen gemacht hat.

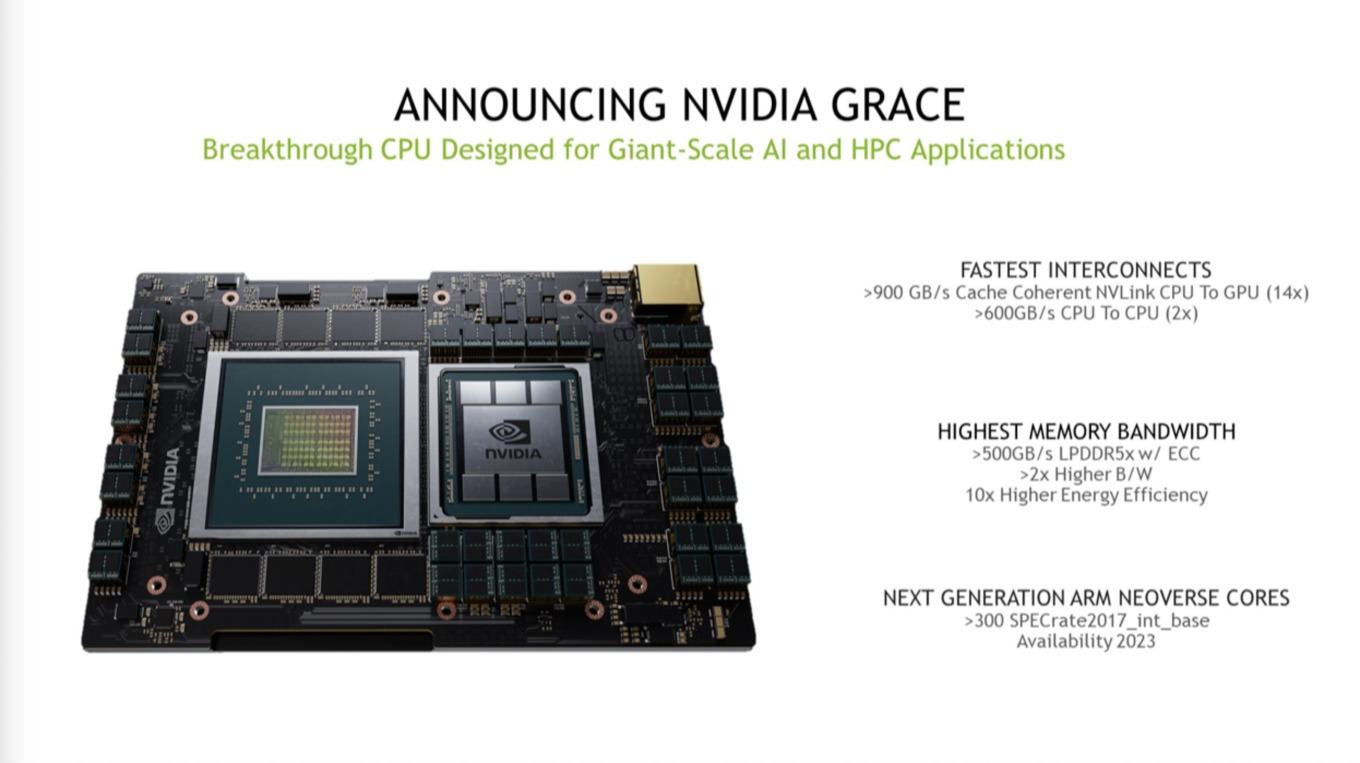

Der Grace-Prozessor soll als Basis eine kommenden Neoverse-Generation verwenden, die man seit einigen Jahren intern entwickelt – so NVIDIA. Kombiniert wird der Prozessor mit einer GPU, wie beispielsweise der GA100. Verbunden sind alle Komponenten dabei über einen schnellen Interconnect, denn die Bandbreite der verschiedenen Speicherebenen sieht NVIDIA als limitierenden Faktor. Grace soll ab 2023 in den ersten Systemen zum Einsatz kommen.

Detaillierte technische Details zum Prozessor (Anzahl der Kerne, Einsatz des Neoverse V1- und N2-Designs, TDP, Taktraten, etc. pp.) sowie zur mit diesem kombinierten GPU nennt NVIDIA nicht. Auf dem gezeigten Rendering ist ein GA100-GPU auf Basis der Ampere-Architektur mit sechs HBM2-Speicherchips zu sehen. In den Details nennt NVIDIA auch den A100-GPU-Beschleuniger, sodass es durchaus sein kann, dass man diese im Zusammenspiel mit Grace einsetzen wird.

Mit einer genannten Leistung von mehr als 300 Punkten im SPECrate2017_int_base läge das Grace-Design auf Niveau zweier Graviton2-CPUs mit jeweils 64 Kernen.

Aber kommen wir noch einmal zurück zum Thema der Anbindung. Die GA100-GPU bindet den HBM2 mit 1,5 TB/s an. Mit dem eigenen NVLink-3.0-Interconnct kommt NVIDIA zwischen den GPUs inzwischen auf 600 GB/s. Die aktuell eingesetzten x86-Prozessoren verwenden DDR4-Speicher, der bei acht Speicherkanälen auf 190 GB/s kommt. Und dann wäre da noch PCI-Express, was verwendet wird, um die GPUs an den Prozessor anzubinden. Bei 16 Lanes kommen wir hier auf jeweils 32 GB/s, mit PCI-Express 5.0 dann auf etwa 64 GB/s. An diesen Zahlen lässt sich aber ganz leicht erkennen: Während die GPUs sich untereinander und ihren Speicher extrem schnell anbinden, gibt es Engpässe bei der Anbindung der GPUs an den Prozessor und auch im Speicherinterface des Prozessors. Den gesamtem Speicher als kohärent anzusehen macht daher aktuell nur zwischen den GPUs Sinn, sobald der Systemspeicher hinzukommt, bildet das PCI-Express-Interface einen Flaschenhals.

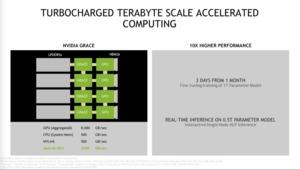

All dies will NVIDIA mit Grace angehen. Wie bei den IBM-Prozessoren bindet NVIDIA den Grace-Prozessor per NVLink an die GPUs an. Dabei zum Einsatz kommt NVLink 4.0, das doppelt so schnell wie das Vorgänger-Protokoll sein soll. NVIDIA spricht von mehr als 900 GB/s bidirektionaler Verbindung. Die Prozessoren untereinander, Grace kommt als Compute-Modul zu mehreren zum Einsatz, sind mit mehr als 600 GB/s untereinander angebunden. Dies öffnet den Flaschenhals, der durch die Anbindung durch PCI-Express aktuell besteht.

Grace wird aber ebenfalls eigenen Speicher verwenden. Dabei handelt es sich um LPDDR5, mehr als 500 GB/s liefern soll und dabei auch noch deutlich effizienter ist. Mit mehr als 500 zu aktuell etwa 200 GB/s schafft es NVIDIA auch hier die Bandbreite mehr als zu verdoppeln.

In einem DGX A100 mit acht A100-GPU-Beschleunigern kommt NVIDIA aktuell auf eine NVLink-Gesamtbandbreite von 4,8 TB/s. Mit Grace sollen es 8 TB/s sein. Außerdem spricht NVIDIA davon den Speicher schneller anzubinden. Von aktuell 1,5 TB/s soll die Bandbreite hier auf 2 TB/s gesteigert werden. Vermutlich wird man den sechsten HBM2-Speicherchip endlich aktivieren können, so dass die Bandbreite hier entsprechend ansteigt.

Warum sind die Bandbreite der Speicherebene immer wichtiger? Die Modelle, die in solchen System berechnet werden, werden immer größer. Von ein paar Hundertmillionen Parametern auf inzwischen einige Milliarden wachsen die Modelle in den kommenden Jahren auf einige Billion Parameter an. Diese massiven Datenmengen müssen möglichst effizient durch das System übertragen und so nahe und schnell wie möglich an den eigenen Recheneinheiten gespeichert werden. Hier kommt dann eben die schnelle Anbindung ins Spiel.

Auch wenn man nicht allzu viel in ein Rendering interpretieren sollte, wollen wir noch einmal darauf zurück. Laut der Fußnoten kommt zusammen mit dem ARM-Prozessor tatsächlich ein A100-GPU-Beschleuniger zum Einsatz. Der Prozessor selbst verfügt laut Rendering über 84 oder 76 Kerne, was durchaus im Bereich des Möglichen für ein Neoverse-Design liegt. Darunter und darüber sind jeweils vier LPDDR5-Speicherchips zu sehen.

Ab dem dritten Quartal 2021 will NVIDIA die ersten Dev-Kits zur Entwicklung auf Basis der neuen Hardware ausliefern. Diese Dev-Kits verwenden einen Altra-Prozessor von Ampere mit 80 Kernen. Hinzu kommen zwei NVIDIA A100 sowie zwei Bluefield-2 DPUs.

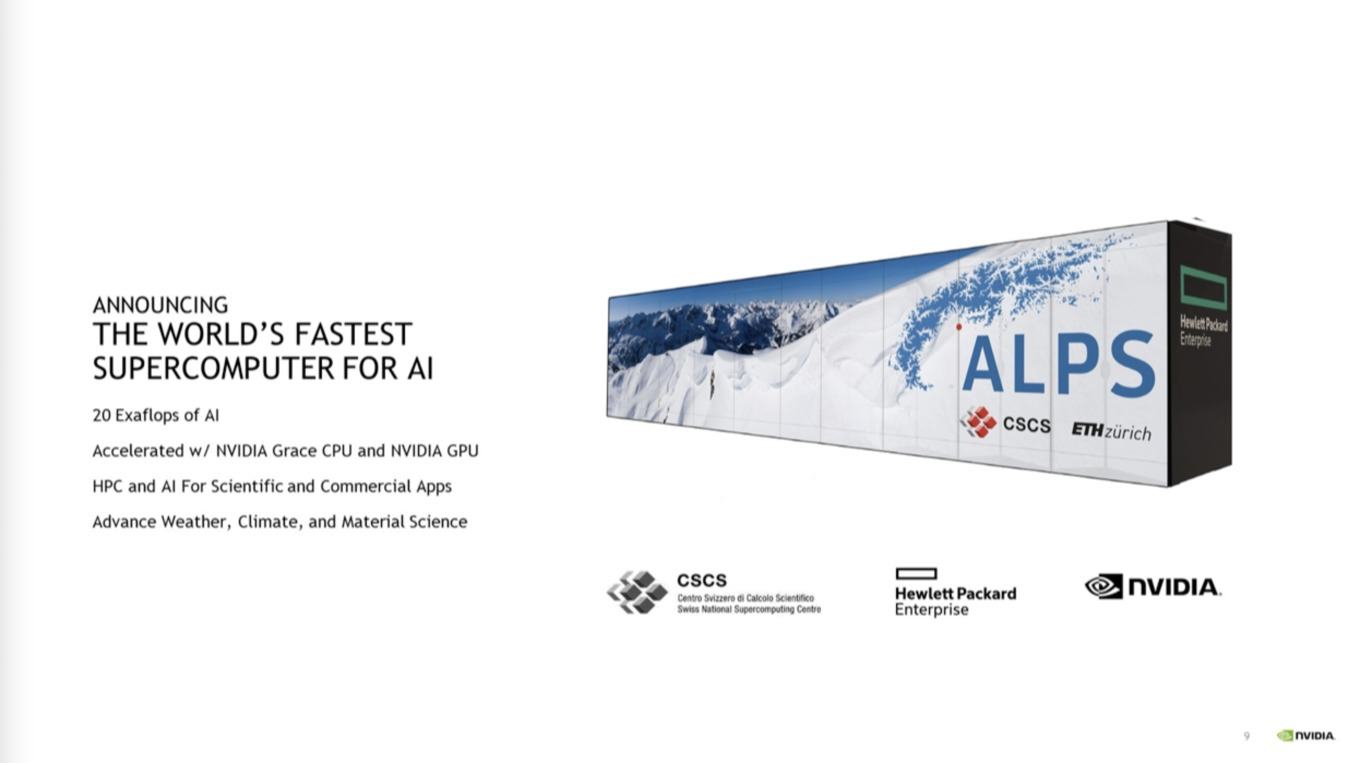

Erste Grace-Supercomputer in der Schweiz und den USA

Die ersten Supercomputer, die einen Grace-Prozessor samt dazugehöriger GPU verwenden werden, sind der ALPS des Swiss National Computing Centre (CSCS) und auch auch das Los Alamos National Laboratory in den USA plant den Einsatz. ALPS soll eine um den Faktor 7 höhere AI-Rechenleistung im Vergleich zu Selene bieten. Selene ist ein Supercomputer von NVIDIA, der auf 2,795 PetaFLOPS an HPC- und 2,8 ExaFLOPS an AI-Rechenleistung kommt.

2023 soll ALPS fertiggestellt sein – NVIDIA plant Grace ebenfalls für das Jahr 2023. Weitere Details zu Grace werden sicherlich in den kommenden Monaten folgen.