Werbung

In all unseren Tests versuchen wir über Benchmarks und Messungen unter gleichen Bedingungen des korrekte Leistungsbild der Hardware darzustellen. Für Prozessoren, Grafikkarten, Speicher, aber auch für Lüfter und Kühler stellt sich dies noch recht einfach und nachvollziehbar dar.

Schon anders sieht dies für Serveranwendungen, die weitaus komplexer und weniger einfach nachvollziehbar sein können. Auf die Spitze getrieben wird dies mit AI-, bzw. ML-Anwendungen, die zahlreiche weitere Komplexitäten mitbringen. Die MLCommons hat sich unter dem Label MLPerf zur Aufgabe gemacht, die Leistungsdaten in diesem Segment untereinander vergleichbar zu machen. Nachdem bereits im vergangenen Jahr die Resultate für MLPerf Training v0.7 veröffentlicht wurden, in denen NVIDIAs neuer A100 die Führungsrolle übernommen hatte, sind kurz darauf die Ergebnisse für das MLPerf Inference v0.7 online gegangen. Aufgrund der COVID-Pandemie verzögerten sich weitere Resultate.

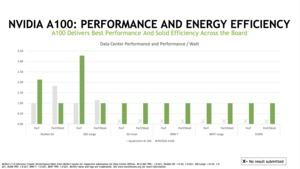

Neben den reinen Leistungsdaten im Training und Inferencing spielt die Effizienz solcher Systeme eine Rolle. Noch viel mehr, wenn sich die Hardware nicht mehr nur im Rechenzentrum befindet, sondern im sogenannten Edge-Betrieb, also beispielsweise direkt in der 5G-Basisstation – nur um einen Anwendungsbereich zu nennen.

Entsprechend wurden nun auch die Leistungsdaten für die Effizienz erhoben, die als MLPerf Inference 1.0 Power aufgeführt werden. Ein paar Daten wollen wir dabei einmal herausnehmen:

- Dell EMC PowerEdge R7525: 2x AMD EPYC 7502, 2x NVIDIA A100 – 93.371 Samples/s bei 1.101 W (84,8 Samples/s/W)

- Dell EMC PowerEdge XE2420: 2x Intel Xeon Gold 6252, 2x NVIDIA T4 – 23.309 Samples/s bei 794 W (29,3 Samples/s/W)

- NVIDIA DGX-A100: 2x AMD EPYC 7742, 8x NVIDIA A100 – 270.706 Samples/s bei 3.459 W (78,3 Samples/s/W)

- Gigabyte R282-Z93: 2x AMD EPYC 7282, 5x Qualcomm AI 100 – 100.077 bei 562 W (178,1 Samples/s/W)

Schaut man sich die Leistungsdaten für ImageNet an, werden die Unterschiede deutlich: 23.000 Samples/s bei fast 800 W sind eben weniger effizient als 100.000 Samples bei 562 W. Wir haben die Ergebnisse daher auf Samples pro Sekunde pro W mit einem Index versehen. Am Ende spielen die jeweiligen Anforderungen eine Rolle und nicht die reine Effizienzbetrachung.

Noch deutlicher wird dies im bereits erwähnten Edge-Bereich, wo nicht immer ein System mit mehreren hundert Watt infrage kommt. Hier wird ein Qualcomm Snapdragon 865 genannt, der 7.806 Samples/s bei 36,4 W (214,4 Samples/s/W) erreicht.

Zudem gibt es neue Inferecing-Ergebnisse. Diese beziehen sich in der Vorschau vor allem auf die neuen A30- und A10-GPU-Beschleuniger. Ansonsten sehen wir hier die üblichen Verdächtigen, aber auch ein paar neue AI-Beschleuniger (Qualcomm Cloud AI 100 PCIe).

Genau wie die Ergebnisse der A30- und A10-GPU-Beschleuniger sind auch erste Ergebnisse für die Ice-Lake-Prozessoren von Intel erhalten – auch hier allerdings nur in einer Vorschau, da noch keine finalen Ergebnisse vorliegen.

MLPerf Inference und MLPerf Inference Power enthält Anwendungen wie Bilderkennung auf Resnet50-v1.5, Objekterkennung mit SSD-ResNet34, Segmentierung medizinischer Bilder mit 3D UNET, Texterkennung mit RNNT, Spracherkennung mit BERT und eine AI-Empfehlungsengine auf Basis von DLRM. Damit werden die wichtigsten Anwendungsbereiche im AI-Bereich abgedeckt und in gewisser Weise ein Standard gesetzt, der eine Vergleichbarkeit ermöglicht.