Werbung

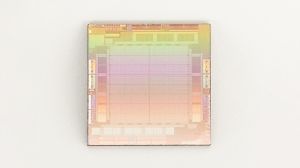

Eigentlich bereits für 2022 geplant, hat Meta nun damit begonnen, eine eigene Inferencing-Hardware in den Rechenzentren zu verbauen. Der Artemis getaufte Chip stellt die zweite Generation der Eigenentwicklung dar, die erste Generation MTIA (Meta Training and Inference Accelerator) konnte 2022 die Erwartungen nicht erfüllen.

Wie genau Artemis aufgebaut ist, ist nicht bekannt. Zu MTIA wissen wir hingegen, dass Meta einen ASIC mit einer Taktfrequenz von 800 MHz und einer Rechenleistung von 102,4 TOPS für INT8-, bzw. 51.,2 TFLOPS für FP16-Operationen zum Einsatz brachte. Der Chip soll eine TDP von 25 W aufweisen. 128 GB LPDDR5, 128 MB SRAM und 68 Processing Elements (PEs) mit jeweils 128 kB eigenem Cache sind die weiteren Ausstattungsmerkmale des MTIA. Gefertigt wird MTIA in 7 nm bei TSMC.

MTIA war rein auf das Inferencing ausgelegt, für Artemis gilt das gleiche. Gegenüber Reuters sagte ein Sprecher von Meta: "Wir sind der Ansicht, dass unsere intern entwickelten Beschleuniger die handelsüblichen GPUs in hohem Maße ergänzen, da sie bei metaspezifischen Workloads die optimale Mischung aus Leistung und Effizienz bieten."

Meta ist einer der größten Kunden für KI-Hardware. Alleine in 2024 will das Unternehmen 350.000 H100-Beschleuniger von NVIDIA kaufen. Insgesamt soll das Volumen an KI-Hardware für 2024 dem Äquivalent von 600.000 H100-GPUs entsprechen. Neben dem Inferencing, beispielsweise in Form einer Ausgabe eines KI-Assistenten, ist das Training ein wichtiger Faktor. Dieses kann von Metas eigener Hardware nicht durchgeführt werden, dazu wird Meta noch immer die Hardware eines anderen Herstellers verwenden müssen.

Mit dem Artemis-Chip dürfte es Meta vor allem darum gehen, das Inferencing effizienter zu machen. In diversen seiner Empfehlungsmodelle – egal ob bei Facebook, Instagram oder Threads – ist Meta auf ein schnelles Inferencing angewiesen.