Werbung

Zur GTC22 stellte NVIDIA den Grace-Hopper-Superchip vor. In diesem Jahr werden die ersten Supercomputer mit GH200-Beschleuniger in Betrieb genommen. Für Grace Hopper arbeiten eine Grace-ARM-CPU mit 72 Kernen und 480 GB an LPDDR5X und eine Hopper-GPU mit 96, bzw. 141 GB an HBM3(E) zusammen auf einem Modul.

Ein erstes großes System mit GH200 wird das bereits angekündigte Boost-Modul für den ersten europäischen Exascale-Supercomputer JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) sein. Hier zum Einsatz kommen werden die GH200-Beschleuniger mit 96 GB HBM3. Insgesamt fast 24.000 GH200 werden verbaut sein. In der sogenannten Bring-Up-Phase des Systems testen zahlreiche Wissenschaftler ihre Projekte auf der neuen Hardware. Ein Vortrag auf der GTC24 gab nun einen Einblick in diese Arbeit und wie Grace Hopper möglichst effektiv genutzt werden kann.

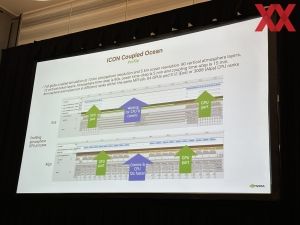

Die Grace-CPU des Beschleunigers ist vorrangig als Host-CPU dafür verantwortlich, einige wichtige Management-Aufgaben zu übernehmen. Dazu gehört der Datentransfer über das Netzwerk. Zwar können insgesamt 32 Hopper-GPUs über ein NVLink-Netzwerk miteinander verbunden werden, darüber hinaus kommuniziert das Cluster weiterhin per PCIe mit 512 GB/s, bzw. über daran gekoppelte InfiniBand- oder Ethernet-Schnittstellen.

Ein Großteil der wissenschaftlichen Berechnungen findet dann auf den GPUs statt. Je nach Datenaufkommen kann es dazu kommen, dass die Datenübertragung zum limitierenden Faktor wird. Befinden sich die Daten einmal auf dem Grace-Hopper-Superchip, stehen 480 GB an LPDDR5X zur Verfügung, die mit 500 GB/s angebunden sind. Hinzu kommen je nach Variante 96 oder 144 GB an HBM3E, die wiederum mit 4 oder 4,9 TB/s angebunden sind. Der Memory Pool von maximal 624 GB steht sowohl der CPU als auch der GPU zur Verfügung. Daten im Speicher der CPU können auch von der GPU und umgekehrt angefragt werden.

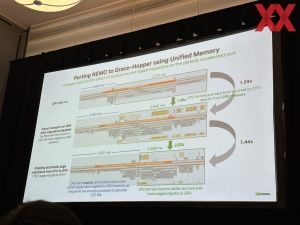

Die Kommunikation zwischen der CPU und GPU erfolgt über ein C2C-Interface mit 900 GB/s. Diese 900 GB/s können zu einem limitierenden Faktor werden und aufgrund der bis zu 4,9 TB/s sollten Daten, die von der GPU verarbeitet werden, auch im GPU-Speicher liegen. NVIDIA sieht daher einen Migrationsprozess vor, der Daten, die von der GPU benötigt werden, automatisch verschiebt.

Am Beispiel einer NEMO-Anwendung sorgt die Ausführung dieser auf der GPU für eine Beschleunigung von 33 %. Die Daten liegen in diesem Beispiel jedoch noch immer im CPU-Speicher. Nach der automatischen Migration werden die Berechnungen noch einmal um 44 % beschleunigt. Gleichzeitig bleibt die CPU voll ausgelastet.

Diese Verdopplung der Leistung steht natürlich nicht exemplarisch für die Leistungssteigerung einer Anwendung durch die Ausführung auf der GPU. Hier gezeigt werden sollte welchen Einfluss die Migration der Daten hin zur GPU hat.

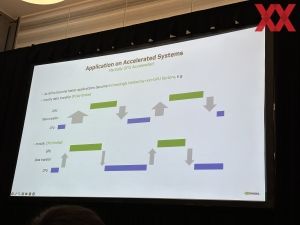

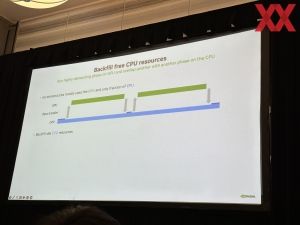

Doch der Prozessor muss ja nicht zwangsläufig nur Management-Aufgaben übernehmen. Als Grace Grace Superchip kommt er auch als alleiniger Beschleuniger zum Einsatz. Steht ein GH200-System zur Verfügung, gilt es also herauszufinden, wie man die Grace-CPU weiterhin auslasten kann. Beispiele zeigen bereits, dass dies gelingen kann und entsprechend arbeitet NVIDIA auch mit den Betreibern und Nutzern der GH200-Systeme daran, dass diese möglichst effizient genutzt werden können.