Werbung

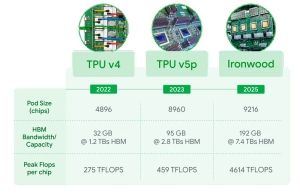

Auf der Google Cloud Next 25 hat der Internetriese Google - oder besser: dessen Cloud-Sparte - die nächste Generation seiner eigenen Tensor Processing Unit (TPU) präsentiert. Der Ironwood genannte Prozessor bietet eine Spitzen-Rechenleistung von 4.614 TFLOPs an FP8-Rechenleistung. Nach NVIDIA und AMD richtet Google die eigene Hardware klar auf das Inferencing von KI-Modellen aus. Die Hardware kommt also weniger für das Training neuer Modelle zum Einsatz, sondern soll vielmehr von Google-Nutzern für das Inferencing verwendet werden. Das Inferencing beschreibt grob den Vorgang der Nutzung eines Large Language Models oder eines KI-Bildgenerators.

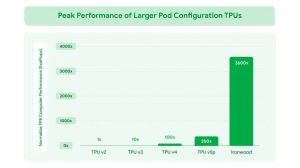

Über die Architektur verrät Google an dieser Stelle noch nicht so viel, bekannt ist nur, dass Google den HBM-Speicher, vermutlich HBM3E, von 95 auf 192 GB ausbaut. Zudem steigt die Speicherbandbreite von 2,8 auf 7,4 TB/s und liegt damit auf Niveau der aktuellen KI-Beschleuniger aus dem Hause AMD und NVIDIA. Zudem kann Google nun Pod-Cluster von bis zu 9.216 TPUs zusammensetzen, die zusammengenommen auf eine Rechenleistung von 42,5 Exaflops für FP8-Datensätze kommen. Die Chips kommunizieren dazu untereinander mit einem Inter-Chip Interconnect (ICI) mit bis zu 1,2 TBit/s bidirektional.

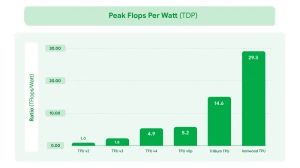

Spitzenleistung, Speicherkapazität, Speicherbandbreite, Pod-Leistung und Effizienz – in allen Belangen soll TPU v7 alias Ironwood seinem Vorgänger überlegen sein.

Zum Einsatz kommen wird Ironwood für das Einsatz bzw. das Inferencing von Large Language Models (LLMs), Mixture of Experts (MoEs) und hier eben konkret den Google-Services Gemini. Google-Cloud-Kunden sollen später in diesem Jahr auf Instanzen mit Ironwood-TPU zurückgreifen können.