Werbung

Wer sich schon einmal mit den Möglichkeiten in der Generierung von Texten, der Übersetzung, Transkription oder der Erstellung von Code über KI-Systeme und Large Language Models (LLM) beschäftigt hat, wird das Potential dieser Technik ebenso erfahren haben, wie die Grenzen. Zu den Grenzen gehört auch, dass einige der Systeme aktuell zur sogenannten Halluzination neigen oder es mit den Fakten nicht immer so genau nehmen.

In Extrembeispielen geht dies sogar so weit, dass Personen Straftaten zugesprochen werden, die es gar nicht gegeben hat. Setzen sich solche Informationen in den Systemen fort, könnte es extrem schwer werden, gegen diese Fehlinformation vorzugehen. Fragt man ChatGPT nach einer Zusammenfassung eines erfundenen Buchtitels, so kann es vorkommen, dass dem Nutzer dennoch eine Zusammenfassung zu einem Buch geliefert wird, die es gar nicht gibt.

Neben der technischen Weiterentwicklung der LLMs wird es zukünftig also immer wichtiger werden, dass man den Aussagen der KI-Systeme nicht vollends vertraut und auch immer hinterfragt. In erster Linie gilt es zu vermeiden, dass diese Systeme überhaupt Falschinformationen oder erfundene Inhalte produzieren. Aber es liegt wohl in der Natur der Sache und in den Parametern des Trainings, dass es zu solchen Ergebnissen kommt.

Genau wie das Aufkommen immer mehrere Services rund um diese KI-Systeme hat sich auch eine kleine an Unternehmen und Entwicklern bereits daran versucht diesen Falschinformationen auf die Schliche zu kommen. Dies reicht vom Abgleich zweier leicht veränderten Anfragen bis hin zu einem möglichst weit automatisierten Fact Checking. Letztgenanntes stellt natürlich einen Mehraufwand dar, der im Falle eines Services mit mehrere hunderte oder tausenden Anfragen an ein solches KI-System nicht mehr praktikabel ist.

NVIDIA ist hinsichtlich der Nachfrage nach Hardware für das Training und Inferencing solcher KI-Systeme sicherlich der große Gewinner. Ähnlich wie bei CUDA will man sich aber auch gleich als Gesamtplattform etablieren und begleitet die aktuelle Entwicklung auch im Bereich der Software.

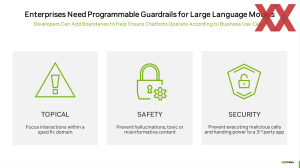

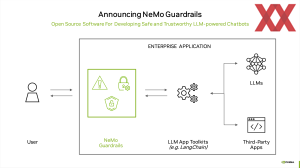

Nun hat man die NeMo Guardrails, eine Open-Source-Software bzw. ein Framework vorgestellt, welches die Interaktion mit den Chatbots in gewisse Schranken weisen soll. Einerseits soll verhindert werden, dass die KI-Systeme unangemessene Antworten geben und andererseits sollen die KI-Systeme auch davor geschützt werden auf unangemessenen Fragen reagieren zu müssen.

Vorstellen kann man sich dies einerseits wie eine Art Blacklist, die bestimmte Begriffe enthält, die dann weder als Ein- noch als Ausgabe verwendet werden können. Eingaben, die auf der Blacklist stehen, werden gar nicht erst an die LLMs weitergegeben. Informationen, die vom KI-System ausgegeben werden, die in den NeMo Guardrails aber als unangemessen deklariert sind, werden im Front-End nicht an den Nutzer weitergegeben. Über eine ähnliche Mechanik lässt sich der Themenbereich des Gesprächs mit einem Chatbot auch auf ein bestimmtes Thema beschränken.

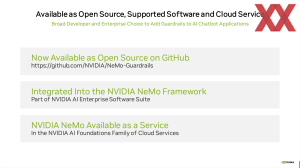

NeMo Guardrails wird als Open-Source verfügbar sein, auch damit eventuelle Lücken in diesem System besser gefunden werden können. Enterprise Nutzer können NeMo Guardrails aber auch als Teil der Enterprise Software Suite von NVIDIA nutzen.

Das Verhindern halluzinierender KI-Systeme und ein Fact Checking sind aktuell eine große Herausforderung in der Entwicklung der KI-Systeme. Bisher beschränkt man sich aber noch auf besagte Leitplanken in der Interaktion mit dem Nutzer, statt die Systeme von vornherein so zu trainieren, dass es gar nicht erst zu Fehlinformationen, Halluzination und dergleichen kommt. Dies wird zukünftig eine große Herausforderung sein, für die NVIDIA mittels NeMo Guardrails zumindest eine gewisse Hilfestellung leistet.

NeMo Guardrails ist hier auf GitHub zu finden.