Werbung

NVIDIA hat mit Chat with RTX bereits ein Werkzeug veröffentlicht, welches LLMs lokal ausführen kann und den Einstieg dazu einfach soll. Nun hat man ChatRTX veröffentlicht, welches eine Sprachkomponente bekommen hat und um die Large-Language-Modelle Gemma und ChatGLM3 erweitert wurde. Letztgenanntes LLM arbeitet bilingual und kann in Englisch und Chinesisch angesprochen werden. NVIDIA hatte in der Vergangenheit bereits angekündigt, dass Chat with RTX um weitere LLMs und Funktionen erweitert werden wird.

Die Eingabe in ChatRTX kann mit der neuen Version nicht mehr nur in schriftlicher Form über die Tastatur erfolgen (wie bei Chat with RTX), sondern nun auch per Whisper – nichts anderes als eine Spracherkennung bzw. ein Speech to Text. Neu ist zudem die Integration von OpenAIs CLIP (Contrastive Language-Image Pre-training). Nutzer von ChatRTX können eigene Bilder in CLIP werfen und diese werden dann entsprechend ihres Inhaltes analysiert und indexiert. Später kann der Nutzer dann mithilfe von einfachen Begriffen nach den Merkmalen in den Bildern suchen.

ChatRTX ausprobiert

Mit Chat with RTX haben wir herumgespielt und ebenso wollten wir auch ChatRTX ausprobieren. Mit dieser ersten Version haben wir uns etwas intensiver beschäftigt. So haben wir das LLM Mistral mit sieben Milliarden Parametern hergenommen und sämtliche PDFs unserer alten Hardwareluxx-Printed-Ausgaben als Eingabewerte hinzugegeben. Der Datensatz umfasst 8,4 GB und fast 2.500 einzelne PDFs. Das Training der zusätzlichen Daten dauerte mit einer GeForce RTX 4090 nur ein paar Minuten.

Wir konnten daraufhin spezifische Fragen zu den Inhalten der Artikel stellen, die online nicht verfügbar waren und damit nicht Teil der Daten von Mistral werden konnten. Genau hier liegt auch das Potential von ChatRTX, denn man kann das LLM schnell und einfach mit eigenen Daten füttern und diese werden dann auch per Retrieval-Augmented Generation (RAG) mit einbezogen.

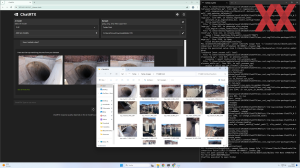

Der zweiten Neuerung namens CLIP haben wir ein paar Urlaubsbilder gegeben, die bisher noch ohne jegliche Metadaten waren. Einzig die von der Kamera hinterlegten Daten sind hier vorhanden, aber keinerlei Beschreibungen zum Inhalt. CLIP hat für etwa 5 GB an Daten und knapp unter 1.000 Bildern ebenfalls ein paar Minuten des Trainings bzw. der Indexierung benötigt und danach waren die Bildern durchsuchbar.

Natürlich ist auch CLIP in dieser Form keine Neuheit und steht Nutzern von iOS und der Fotos-Bibliothek oder auch in Google Photos schon länger zur Verfügung. Solch ein System lokal arbeiten zu haben könnte zum Beispiel für Fotografen aber eine sinnvolle Ergänzung zu den Metadaten sein, die er ohnehin hinzufügt.

ChatRTX setzt eine Grafikkarte der GeForce-RTX-30 oder GeForce-RTX-40-Serie sowie mindestens 100 GB an freiem Speicherplatz voraus. Der Download ist direkt bei NVIDIA möglich.