News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

HBM3E

-

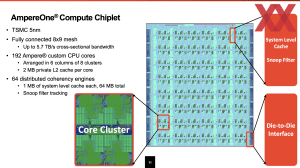

5 nm, HBM3E und aufwändiges Packaging: Hersteller protzen mit High-End-Chips

Nicht kleckern, sondern klotzen – so könnte das Motto der diesjährigen Hot-Chips-Konferenz lauten. Die Hersteller überbieten sich mit immer größeren und letztendlich auch schnelleren Chips, doch der Aufwand der betrieben wird ist ebenfalls enorm. Über NVIDIAs Blackwell-GPU haben wir ebenfalls bereits berichtet wie über den Telum II von IBM, der mit gigantischen Caches aufwarten kann. Auch Intels Xeon 6 SoC alias Granite Rapids-D ist mit zwei... [mehr]

Nicht kleckern, sondern klotzen – so könnte das Motto der diesjährigen Hot-Chips-Konferenz lauten. Die Hersteller überbieten sich mit immer größeren und letztendlich auch schnelleren Chips, doch der Aufwand der betrieben wird ist ebenfalls enorm. Über NVIDIAs Blackwell-GPU haben wir ebenfalls bereits berichtet wie über den Telum II von IBM, der mit gigantischen Caches aufwarten kann. Auch Intels Xeon 6 SoC alias Granite Rapids-D ist mit zwei... [mehr] -

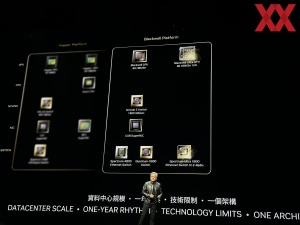

NVIDIAs Roadmap: NVIDIA präsentiert Blackwell Ultra, Rubin und Rubin Ultra

Auf der Keynote auf der Computex in Taipei gab NVIDIA einen Ausblick auf die zukünftige Datancenter-Roadmap. Die in diesem Jahr vorgestellte Blackwell-GPU mit Blackwell-Architektur wird um Blackwell Ultra ergänzt. Dabei handelt es sich vermutlich um den B200-Beschleuniger mit Blackwell-GPU, aber HBM3e mit 12 Stacks anstatt acht Stacks, wie es im ersten Schritt geplant ist. Damit steigt der Speicherbaus von 192 auf 244 GB an. Die... [mehr]

Auf der Keynote auf der Computex in Taipei gab NVIDIA einen Ausblick auf die zukünftige Datancenter-Roadmap. Die in diesem Jahr vorgestellte Blackwell-GPU mit Blackwell-Architektur wird um Blackwell Ultra ergänzt. Dabei handelt es sich vermutlich um den B200-Beschleuniger mit Blackwell-GPU, aber HBM3e mit 12 Stacks anstatt acht Stacks, wie es im ersten Schritt geplant ist. Damit steigt der Speicherbaus von 192 auf 244 GB an. Die... [mehr] -

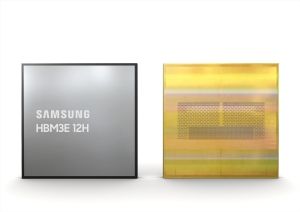

HBM3E 12H: Micron und Samsung sind bereit für den weiteren KI-Boom

Innerhalb von zwei Tagen haben Micron und Samsung unabhängig voneinander die baldige Verfügbarkeit von HBM3E angekündigt, der einerseits größere Kapazitäten, aber auch eine höhere Bandbreite bieten soll. Beide Unternehmen proklamieren für sich, bei der HBM3E-Technik Vorreiter zu sein, im Grunde aber liegen beide Hersteller in den wichtigsten Aspekten wie Kapazität und Bandbreite in etwa gleichauf. Die Hersteller stapeln inzwischen 12... [mehr]

Innerhalb von zwei Tagen haben Micron und Samsung unabhängig voneinander die baldige Verfügbarkeit von HBM3E angekündigt, der einerseits größere Kapazitäten, aber auch eine höhere Bandbreite bieten soll. Beide Unternehmen proklamieren für sich, bei der HBM3E-Technik Vorreiter zu sein, im Grunde aber liegen beide Hersteller in den wichtigsten Aspekten wie Kapazität und Bandbreite in etwa gleichauf. Die Hersteller stapeln inzwischen 12... [mehr] -

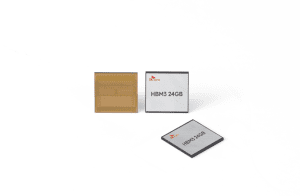

HBM4 von Sk hynix: 2026 soll es mit 32 GB losgehen

Aktuell werden die ersten AI-Beschleuniger mit HBM3 bestückt. Dazu gehören NVIDIAs H100, aber auch der Radeon Instinct MI300A und MI300X von AMD. Lieferanten des schnellen Speichers sind Samsung und Sk hynix – beides in Südkorea ansässige Unternehmen. Laut BusinessKorea hat Sk hynix auf einem Investoren-Event seine Bestrebungen bestätigt, diesen Speicherbereich in diesem und dem kommenden Jahr weiter auszubauen. Zwar macht der HBM... [mehr]

Aktuell werden die ersten AI-Beschleuniger mit HBM3 bestückt. Dazu gehören NVIDIAs H100, aber auch der Radeon Instinct MI300A und MI300X von AMD. Lieferanten des schnellen Speichers sind Samsung und Sk hynix – beides in Südkorea ansässige Unternehmen. Laut BusinessKorea hat Sk hynix auf einem Investoren-Event seine Bestrebungen bestätigt, diesen Speicherbereich in diesem und dem kommenden Jahr weiter auszubauen. Zwar macht der HBM... [mehr]