special_fx

Enthusiast

Netter Thread.

Kann zu der Intelkarte im Startpost eine Kompatibilitätsbestätigung für das Asus Board M4A89GTD in Verbindung mit Debian 6.0 machen.

Vor knapp 2 Monaten hatte ich bei einem Bekannten mit einem Fotostudio zwei Systeme mit der oben genannten Konfiguration und je 18TB Brutto im Raid 0+1 zum Spiegel konfiguriert.

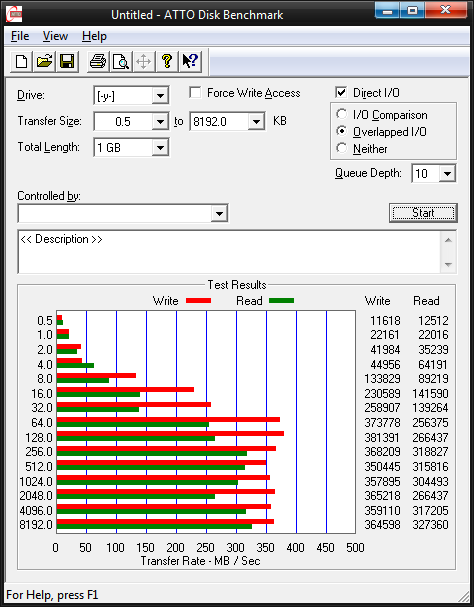

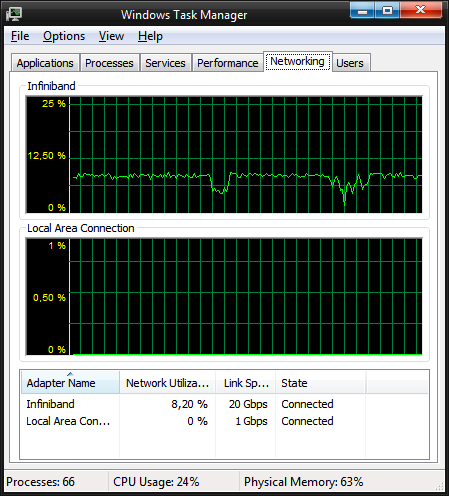

Dafür lohnt es sich schon auf 10Gbit Adapter zu setzten die Transferrate ist dabei um Faktor 3,5 höher als bei 1Gbit.

Kann zu der Intelkarte im Startpost eine Kompatibilitätsbestätigung für das Asus Board M4A89GTD in Verbindung mit Debian 6.0 machen.

Vor knapp 2 Monaten hatte ich bei einem Bekannten mit einem Fotostudio zwei Systeme mit der oben genannten Konfiguration und je 18TB Brutto im Raid 0+1 zum Spiegel konfiguriert.

Dafür lohnt es sich schon auf 10Gbit Adapter zu setzten die Transferrate ist dabei um Faktor 3,5 höher als bei 1Gbit.