Schönes Argument, sehr objektiv, unpersönlich und sehr gut begründet.

Lass mal gucken?

Nö, ist eine Feststellung... Und die muss ich nicht begründen

Mal davon ab, du verdrehst die Faktenlage... ICH sagte, dass der Profitreiber alles andere als Gamingoptimiert ist und der Gamingtreiber Sachen aus dem Profibereich nicht inkludiert hat. DAS ist die Ausgangslage.

Wie kommst du nun auf das schmale Brett die Reihenfolge zu drehen? Bleibt doch bitte bei der Faktenlage.

Linux/OpenSource spielen dabei immernoch keine Rolle. Ebenso wenig wie es eine Rolle spielt wer hier was und in welcher Art nutzt.

Aber genau das ist das Problem. Ihr wollt hier auf biegen und brechen recht haben und dreht die Aussagen solange bis es passt... Dabei merkt ihr noch nichtmal, das A) die Aussage selbst irrelevant im Kontext ist und B) gar nicht zur Diskusion stand. Das nervt einfach nur. Mal davon ab, kennst du Game of Thrones?

-> "

Any man who must say, "I am the king" is no true king"

Ich sag nur

"ich habe mehr Ahnung von der Linux-Performance von AMD Karten als du - denn ich nutze sie unter Linux."

Sorry Sonnenschein, was du von mir denkst ändert nichts an den Fakten und ja, ich denke ich habe mehr Ahnung von der Linux-Performance von AMD Karten als du - denn ich nutze sie unter Linux.

schön für dich... Und es ändert immernoch nix an der Aussage, dass der Profi-Treiber alles andere als Gamingoptimiert ist sowie der Gamertreiber idR nicht alle Profimarktrelevanten Sachen im Bauch hat. Ebenso wenig, dass allein dieser Umstand reichen könnte um die Aussage von AMD, nämlich Gaming-Vega hat mehr Performance als der gezeigte Profi-Ableger, zu bestätigen...

Um es dir nochmal zu verdeutlichen. Der OpenSource Treiber war nie Thema!!! Weder pro noch kontra... WAS willst du also bitte bezwecken!?

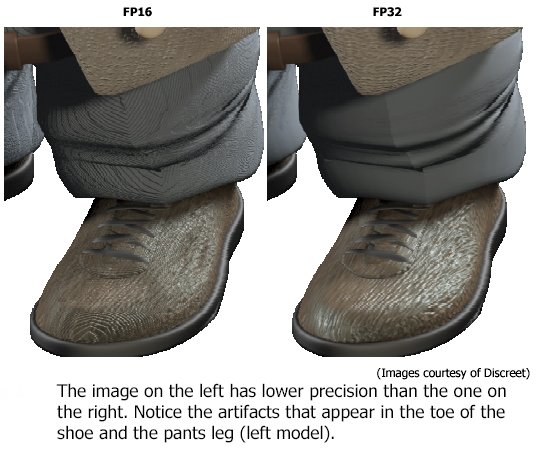

Sorry, Bullshit. Je mehr Leistung ich zur Verfügung habe, desto mehr mehr Effekte kann ich in eine Szene werfen, welche die BQ erhöhen. Gibt mir FP16 mehr Leistungsreserven, kann ich mehr Effekte in eine Szene bringen, was die BQ erhöht.

Zum Markierten, Richtig... Das _kannst_ du tun.

War aber nicht die Aussage... Deine Aussage war "

Wenn du dank FP16 2x so viele Effekte einfügen kannst als bei FP32, dann hast du auf einmal gefühlt 3 Generationen Grafikpracht-GPU-Aufrüstung durch Software realisiert."

Weder kannst du 2x so viele Effekte einfügen noch steigt zwangsweise die BQ durch das reine "mehr" an Effekten...

Warum das so ist, habe ich ausgeführt -> ich nenne es einfach mal den "PhysX Effekt", mehr Effekte, mehr Partikel, mehr Bewegung heist nicht zwangsweise mehr BQ. Es kann auch übertrieben viel und damit unstimmig sein -> was zu einer schlechteren BQ im Gesamten führt.

Denn Qualität ist subjektiv. Und etwas subjektives misst sich nicht nach der Anzahl von irgendwas. Wenn doch, dann dürfte es dir bestimmt leicht fallen, entsprechende Messmethoden, Ergebnise, Studien oder ähnliches dazu vorweisen zu können!? Ich halte es aber für äußerst schwierig, subjektives Empfinden über BQ anhand von Effektanzahl zu bestimmen... Und jede Wette, was MIR gefällt, musst nicht zwangsweise auch DIR gefallen

Müsste es aber, wenn Effektanzahl = mehr BQ bedeutet/bedeuten würde... -> ergo, Aussage mal wieder widerlegt.

Mit solchen Aussagen habe ich halt ein Problem. Und danke auch an Shevchen für die Erklärung. Ich sehe das eigentlich genauso.

Wie soll ich da noch sachlich argumentieren? - Du verlangst Sachlichkeit, und wenn eine Grafikkarte mit 2 8GiB-HBM2-Stacks auftaucht, war Deine vorher geäußerte Skepsis bezüglich der 8GiB-Stacks plötzlich auf die Gamerversion beschränkt gewesen. Ich habe mit knapp über 300€ für den kleinsten Ryzen-Oktacore spekuliert, Du hast es für absolut unrealistisch gehalten und mindestens 800€ für den i7 6900K-Gegner angegeben. Der kleinste kostet jetzt 320€, der teuerste 470€. Ich wette, Du hast jetzt auch schon wieder eine Erklärung parat, wie Du das eigentlich gemeint hast, damit es wieder stimmt.

Trenn doch mal die Themenfelder... Eine Spekulation über Preise ist das eine -> und ja, Ryzen ist überraschend niedrig gestartet. Im Nachgang aber auch ein Stück weit "nachvollziehbar", denn es ist nicht der Überryzen, der den 6900k in den Arsch tritt, sondern der solide Ryzen ohne EE-Aufschlag. Der hochpreise Ryzen mit AMDs "EE" Aufschlag kommt ja erst noch

Und Niemand hat damals einen Dual NUMA Ryzen mit 12-16C auf dem direkten Schirm gehabt... AMD wird das Preissegment also besetzen, wie seinerzeit angenommen. Nur mit anderen Produkten. Was ja auch kein Problem ist...

Was die 8-Hi Stacks angeht, niemand hat diese ausgeschlossen... Erfinde doch nicht einfach irgendwas, was dir in den Kram passt. Ich sprach die ganze Zeit von Warscheinlichkeiten. Und die ganze Zeit schon davon, dass dies für das Gamermodell eben unwarscheinlich ist. Da du ja so davon überzeugt ist, kannst du mir doch auch die Beiträge zeigen, wo ich da nun anders argumentiere!?

Übrigens mal was aus dem Nähkästchen:

"

Auch bei Vega erwarte ich deshalb mindestens 16GiB VRAM, sonst ist der alte Vorteil vom größeren VRAM bei AMD hinüber und ein Hauptkriterium für mich verflogen." -> Deine Aussage am 07.01.2017

"Es wäre bei HBM bspw. technisch denkbar, dass man anstatt wie heute bei Fiji 4x HBM Stacks zu je 1GB Größe einfach nur einen, oder zwei verbaut. Die Bandbreite wäre geringer, das ist klar, allerdings ist diese bei so einem vierer HBM Stack schon derart groß, dass selbst die Fiji GPU mit 4096 ALUs daraus wenig bis keinen direkten Vorteil ziehen kann. In der nächsten HBM "Generation" aka Marketingtechnisch HBMv2 geschimpft, sind variable Größen der HBM Stacks geplant. Bis zu 32GB auf vier Stacks in Summe.

Macht bei einem Stack immernoch 8GB, welcher dann mit (je nach Taktrate) ca. 256GB/sec angebunden wäre." -> Meine Aussage 05.12.

2015

Zwar in einem leicht anderen Kontext, aber soviel zum Thema mit deinen 16GB auf zwei Stacks!

Nicht immer ist das, was nicht da steht auch automatisch das, was angenommen wird! Solltest du mal beherzigen

Wahrscheinlich mehr als Du denkst, aber das ist mein privater Account, der Nickname ist mindestens 15 Jahre alt und damit habe ich auch einiges an Zeug geschrieben, das ich nicht mit meiner aktuellen Tätigkeit in Verbindung bringen kann.

Vielleicht habe ich Dir ja in dem Punkt, den Du ansprichst, gar nicht widersprochen. Diese ständige Grundunterstellung stört mich einfach.

Zum ersten, halte ich für ein Gerücht... Denn sonst würdest du nicht so einen Unsinn hier zum Teil ablassen. Sorry, aber man merkt schon wenn jemand einen gewissen Bezug bei Softwareentwicklung hat oder nur irgendwelche aufgeschnappten Sachen nachplappert.

Zum zweiten, ja doch... Sagte ich doch oben bereits. Kein Mensch stört sich an Diskusionen über Themen im gegenseitigen Gespräch. Aber es macht die Art und Weise die Musik. Wenn ich (siehe oben) sage, dass der Treiber für Leistungsunterschiede sorgen kann, ohne dies konkret (und das war mit voller Absicht) auf ein Beispiel runterzupressen und du mit der Aussage, unter Linux mit OpenSource und diesen und jenen Bedingungen ist das

warscheinlich!!! nicht so kommst, ist das nunmal ein Widerspruch. Bringt auch nix, das nun abzustreiten... Genau aus den genannten Gründen bezweifel ich übrigens auch, dass du irgendwas mit Softwareentwicklung am Hut hast geschweige denn, irgendwas mit Treiberprogrammierung und schon gleich gar nicht mit VRAM Management. Dir wären es schlicht und ergreifend geläufig, dass es da Unterschiede in den verschiedenen Treibern, auch bei AMD!!! gibt... Und um nichts anders ging die Aussage. Völlig allgemein, völlig wertungsfrei. Ohne Vorurteil und vor allem, ohne irgendwie AMD dumm dastehen zu lassen...

So genug OT.

Analyse: AMD und die Kunst des Benchmarkings | heise online

Was haltet ihr hiervon? Ist mir beim Lesen von heise.de News über den Weg gelaufen... Mir stellt sich die Frage, hat Vega wirklich so eine Trickersei nötig? Im Vergleich zu Ryzen ist das schon arg hingekünstelt... Von Rechenfehlern beim Zusammenzählen ganz zu schweigen!?

Wäre relevant wenn es um die Marktsättigung gehen würde, der Streitpunkt war aber Versteckte Features in bestimmten Treibern und warum CS-Treiber angeblich besser sein sollen als offene.

NEIN, ganz klar NEIN. Das war nie der Standpunkt... Genau deswegen ist es so häufig der Fall, warum man hier aneinander vorbei redet. Erfinde(t) doch nicht immer irgendwelche Standpunkte, die überhaupt nicht Aussage waren!!!

Mal davon ab, dass es mal wieder weit weit am Thema vorbei geht... Das Thema war AMDs Aussage, Gamer-Vega wird schneller als der gezeigte Profiableger. Und wie (in meinem Fall zumindest) man das erreichen kann. Nämlich unter Umständen schon mit verschiedenen Treibern anstatt mit Takterhöhungen.

OpenSource und Linux ist/war NIE Thema!!!

Wenn du dich über OpenSource Treiber und Linux auslassen willst. Bitte. Mach das, aber nicht hier... Es ist OT

EDIT: Entferne zudem den Bilderquote!

hier

hier