Induktor

Enthusiast

Thread Starter

- Mitglied seit

- 03.11.2019

- Beiträge

- 3.186

- Laptop

- Lenovo Yoga Pro 7 - Ryzen AI 9 365 - Radeon 880M - 32GB LPDDR5x-7500 - 14,5" OLED (2880*1800) 120Hz - Intel AX210

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen-7 9800X3D (+200/ -42)

- Mainboard

- MSI X870E Carbon Wifi (A3)

- Kühler

- Arctic LF III 280 & 2x Toughfan 14 Pro

- Speicher

- 32GB - 6200 MT/s (CL26-8-36-30 - tRFC 120ns)

- Grafikprozessor

- MSI RTX 4080 Gaming X Trio (Shroud Mod 3x T30 + 400w vBIOS)

- Display

- Alienware AW2725DF (OLED 360Hz)

- SSD

- Samsung 990 Pro & 980 Pro

- Gehäuse

- Open Benchtable V2 (vertikal)

- Netzteil

- Corsair AX850 (Titanium)

- Sonstiges

- Thermal Grizzly AM5 Frame

Wie der Titel es bereits verrät, soll es in diesem Thread um Erfahrungswerte zum Thema Undervolting/ Sweetspot bei Ryzen 5000 CPUs gehen. Eigentlich kommt dieser Thread viel zu spät, da AM5 schon fast vor der Tür steht, aber ich denke dennoch, dass Ryzen 5000 CPUs noch lange in Benutzung sein werden. Daher könnte das hier für den ein oder anderen möglicherweise hilfreich sein, insbesondere wenn man mit hohen Temperaturen kämpft. Vielleicht ist es auch zukünftig in gewisser Weise für AM5 von Vorteil.

---------------------------------------------->

Gleich schon mal das Wichtigste vorweg, um etwaige Diskussionen diesbezüglich zu vermeiden.

Jeder muss seinen Sweetspot selbst definieren und das, was ich als sinnvoll und "Sweetspot" bezeichne, muss nicht auf andere Systeme, Einstellungen oder Anforderungen zutreffen. Ich will hier lediglich meine Erfahrungen zu diesem Thema teilen und wie ich die ganze Geschichte sehe. Auch weise ich ganz klar darauf hin, dass die vorgenommenen Settings primär für Gaming in meinen Einstellungen ausgelegt sind und nicht für irgendwelche synthetischen Benchmarks oder Stresstests. Das gilt auch für das Thema Stabilität. Dieses teste ich nur nach meinen persönlichen Bedürfnissen und soll keineswegs eine allgemeine Empfehlung oder so sein, aber dazu dann später im Detail mehr. Selbiges gilt auch für das Testen an sich. Man kann nie so testen, dass man damit hier jeden zufriedenstellt. Deshalb kann ich nur so testen, wie das für mich am aussagekräftigsten/ sinnvollsten ist und sich in der Vergangenheit gut bewährt hat. Wer damit nichts anfangen kann, muss halt selbst investigativ tätig werden und seine eigenen Tests machen. Konstruktive Kritik und Verbesserungsvorschläge sind natürlich jederzeit willkommen, genauso wie weitere Erfahrungswerte.

---------------------------------------------->

Mit Ryzen 5000 (anfangs 5800X, später dann 5900X) bin ich seit Anfang März 2021 unterwegs und habe mich immer so ein bisschen an dem orientiert, was man hier im Forum so mitbekommt + immer ein wenig selbst getestet. Wie man's halt kennt, ist der Standard für Optimierungen bei Ryzen CPUs der Precision Boost Overdrive (PBO) in Verbindung mit dem Curve Optimizer (CO). Das kann man dann idealerweise pro Kern machen oder einfach ein Setting, was für die gesamte CPU angelegt wird. Zweiteres funktioniert bei mir besser und zuverlässiger. Trotz dessen, dass ich mein 5900X via PBO und CO mit +100/ -19 eingestellt habe, empfand ich den Verbrauch im Gaming mit rund 110-120w durchschnittlich schon etwas hoch. Temperaturprobleme hatte ich jetzt nicht, aber irgendwie ließ mich nicht das Gefühl nicht los, dass das deutlich besser/ effizienter gehen muss.

Bereits im Testing mit Cinebench R23 (CB) zeigte sich, dass der 5900X oberhalb der empfohlenen Limits von AMD nicht mehr wirklich toll performt/ effizient ist. Hier mal ein kurzer Vergleich, den ich damals gemacht:

Abgesehen davon, dass man relativ viel Energie reinstecken muss, um noch ein wenig mehr Leistung rauszukitzeln, wird die ganze Geschichte zunehmend schwieriger zu kühlen. Allerdings zeigte das Testing mit CB, wie gut der PBO mit dem CO auf die Ryzen CPUs abgestimmt wurde. Problematisch waren bei Ryzen CPUs immer händische Settings wie beispielsweise das Absenken von Vcore (wie man es bei Intel kennt), weil man dadurch schnell ins Clock-Stretching lief und die CPU nicht mehr optimal arbeitete. Zwar steigt der Nominal-Takt und auch die Temperaturen inkl. Verbrauch fallen besser aus, jedoch sinkt gleichzeitig der Effektive-Takt, der ausschlaggebend für die tatsächliche Leistung ist. Deswegen sind Optimierungseinstellungen außerhalb vom PBO immer ein wenig kritisch bei Ryzen CPUs, weil man im Idealfall bessere Leistung (zu stock), bei gleichzeitig kühleren Temperaturen und geringerem Verbrauch anstrebt.

Nun hat CB aber nicht wirklich viel mit einer realistischen Gaminglast zu tun, jedenfalls habe ich noch nie derartige Werte in einem Spiel erreicht. Deshalb teste ich nur echte Spiele mit realistischem Verbrauch, die ich auch selbst tatsächlich spiele. Denn schließlich ist Gaming auch das, womit ich am meisten Zeit verbringe und entsprechend ist das Einsparpotenzial nicht unerheblich. Jeder, der seine GPU undervoltet betreibt und mal die Verbräuche verglichen hat zu stock, wird mir da sicherlich zustimmen. Und natürlich ist es auch irgendwo der Spaß am Optimieren/ Verbessern, zumal das BIOS dafür eine Vielzahl an Möglichkeiten bereitstellt. Wäre doch schade, wenn man sie nicht nutzt. Muss ja nicht immer reines OC sein.

Kommen wir zu den Ergebnissen. Zunächst einige Eckdaten, was Hardware und Testparameter betrifft:

- offener Aufbau (vertikaler Benchtable)

- X570 Aorus Master (BIOS F36e)

- 5900X (geschliffen)

- 280er AIO (geschliffen)

- 4x 8GB G.Skill 3.800 @ CL16-16-16-30

- 6900XT UV: 2.350 Mhz @ 1,110v + 2080 FT

- AIO-Pumpe fix bei 20% (~1.130 rpm)

- AIO-Lüfter fix bei 900 rpm (870-930 rpm)

- GPU-Lüfter unter 1.000 rpm (avg 970 rpm)

- Native Auflösung: 2.560 x 1.440p

- Radeon-Treiber: 22.5.1

- Raumtemperatur: 21-23°C

Damit man besser nachvollziehen kann, auf welche Daten ich mich immer referenziere, hier mal ein Beispiel-Log von HWinfo mit den markierten Daten:

Getestet wurde nur zunächst nur AC Valhalla, weil ich unheimlich viele Optionen durchtesten wollte/ musste. Um die Genauigkeit der Messergebnisse zu erhöhen, bin ich folgendermaßen vorgegangen. Zunächst wurde das System auf Temperatur gebracht (Warmlaufphase) und das Spiel mindestens 10 Minuten lang gespielt. Dann wurde während das Spiel läuft auf HWinfo gewechselt und alle Werte dort geresettet (Uhr-Symbol) und erst ab da wurde der Log aufgezeichnet. Gemessen wurde immer min. 45 Minuten. Auch das Speichern der Werte erfolgte während das Spiel noch lief. So konnte ich mir relativ sicher sein, dass ich meine Ergebnisse nicht durch irgendwelche idle-Werte oder kühlen Warmlauftemperaturen verfälsche/ schönige und wirklich nur die reine Gaming-Last teste. Gerade wenn man sehr viel testet und einen sauberen/ aussagekräftigen Vergleich möchte, ist ein Vorgehen, welches immer auf die gleiche Weise reproduzierbar ist, unabdingbar.

Natürlich ist Gaming nur bis zu einem gewissen Grad reproduzierbar, aber so teste ich meine Settings halt immer. Ich habe einfach keine Lust das System stundenlang irgendeiner Last auszusetzen und zuzugucken wie ich sinnlos Strom verbrate. Da kann ich die Zeit auch nutzen und gleich das Game zocken. So teste ich auch übrigens die Stabilität. Wenn's abschmiert, regelt Auto-Save oder ich hole wenige Minuten Spielzeit nach. Es ist nur ein Spiel und nichts wichtiges. Ich weiß, dass bei diesem Thema die Meinungen weit auseinander gehen, aber ich vertrete klar die Meinung, dass mein System nur für das stabil sein muss, was ich täglich damit mache und nicht für dauerhaft 48h Prime95 mit 200w+ Heatoutput. Mir ist da das Optimierungs-/ Einsparpotenzial wesentlich wichtiger und bislang läuft das System sehr zuverlässig ohne WHEAs oder BSODs (Test-/ Auslotphasen jetzt mal außen vor).

Eine Sache muss ich an der Stelle leider noch ergänzen, da ich in der Vergangenheit den ein oder anderen Kommentar bezüglich Takt bekommen habe. Da ich immer nur bereinigte Ingame-Werte poste, wo dauerhaft Last anliegt, wurde mir schon vorgeworfen, dass meine CPU relativ niedrig boostet und sonst was alles. Effecitive Clock, Package Power, Logging-Dauer usw. wurde sowieso völlig ignoriert. Deshalb vorsorglich schon mal ein Bild, wo meine CPU boostet:

Jetzt einfach vorstellen, dass ich so 2-3h vorher im idle sitze und die Werte mit in den Gaming-Log reinnehme. Dann stimmen auch Boostraten und Durchschnittswerte.

Zurück zum Thama. In AC Valhalla habe ich dann drei Szenarien gemessen/ getestet:

- Kurzer Test in der Stadt, wo viel los ist (höhere CPU-Last), um das Profil grob einzuschätzen. Dort dann immer auf die gleiche Stelle gestellt, immer gleich ausgerichtet und 10 Minuten geloggt.

- Den Ingame-Benchmark, teilweise mehrfach mit dem gleichen Profil, um Schwankungen und FPS-Einbrüche einzuschätzen.

- Die Profile, die im kurzen Test vielversprechend aussahen, habe ich dann ausgiebig im Gaming getestet (wie oben beschrieben).

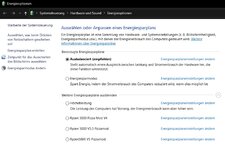

Im ersten Testing habe mich dafür entschieden erstmal die verschiedenen Powermodi durchzugehen. Das habe ich sowohl für idle/ light load-, als auch für den Gaming-Betrieb gemacht. Vor allem haben mich die hochgelobte Pizzamods interessiert, denn bislang fand ich den Energiesparmodus für den Nicht-Gaming-Betrieb unschlagbar gut. Unter 35w schafft kein anderes Powerprofil. Entsprechend fallen auch die Temperature gut aus:

Das habe ich zuerst mit Auto-Settings durchgeführt und im zweiten Anlauf mit manuell eingestelltem Vcore. Wollte einfach mal wissen, wie sich das im Betrieb äußert. Im Gaming (Testszenario: Stadt 10 Minuten) habe ich dann alle sechs Profile mit Auto- und manuellen Vcore-Settings durchgetestet. Das habe ich dann beginnend von 1,275v bis 1175v gemacht. Anfangs war die Idee, dass solange der Effective Clock nicht absinkt, ist erstmal alles gut. Das bestätigten auch die Ingame-FPS, sowie der Ingame Benchmark:

Mit sinkendem Vcore, verbesserte sich auch der Verbrauch geringfügig, aber irgendwie war alles nicht das richtige bzw. irgendwie hatte ich mir mehr erhofft. Auch die Pizzamods haben mich nicht wirklich überzeugt. Weder im idle, noch im Gaming. Ich wusste, dass ich irgendwas mit dem PBO anstellen muss, weil es die einzige Einstellung ist, die nachweislich gut mit den Ryzen CPUs funktioniert. Also bin ich wieder auf mein altes Profil gewechselt (+100/ -19) und hab ein wenig rumexperimentiert. Immerhin hat sich im Testing gezeigt, dass selbst das Energiesparprofil die FPS im Durchschnitt halten kann, trotz dessen dass der effektive Takt leicht abgefallen ist. Wenig verwunderlich, wenn man die meiste Zeit im GPU-Limit sitzt, aber dennoch bin ich davon ausgegangen, dass die FPS-Leistung in dem Profil weiter einbrechen würde.

Mir war klar, dass ich den Vcore irgendwie runterbekommen muss, um den Verbrauch zu senken, aber ohne dass der Effective Clock sich großartig verändert. Im Ausgangsprofil (PBO +100/ -19) pendelte sich der Eff. Clock bei 1.1xx MHz durchschnittlich ein. Vcore bei 1,382v und einem Verbrauch von 110-120w. Da ich größtenteils im GPU-Limit sitze, habe ich es einfach mal mit'm negativen Offset im Takt probiert (im PBO). Das hat zum Teil besser funktioniert als erwartet. Gleichzeitig habe ich auf den reduzierten Takt das Undervolting im CO erhöht + ein dynamisches Vcore Offset (DVO), weil der CO allein gar nicht so viel rausholt (siehe Vergleich -19 auf -23). Bei mir kann ich das nur anlegen, wenn ich Vcore von Auto auf Normal stelle.

Mit diesen ganzen Settings und Optimierungen konnte ich den Verbrauch von knapp 120w auf 70w reduzieren. Das ist für CPU-Verhältnisse schon verdammt viel und das schöne ist, dass die FPS-Leistung sich kaum verändert hat, zumindest in diesem Spiel nicht. So sehen die Ergebnisse aus:

Ein paar Dinge muss ich direkt klarstellen. Zum einen ist die FPS-Angabe in dem Gaming-Chart mit Vorsicht zu genießen, weil sie im Spiel natürlich sehr schwankt, je nachdem wo man sich aufhält und wie viel Action man gerade hat. Deswegen habe ich min. 45 Minuten getestet und versucht nach Möglichkeit Menüs, Ladezeiten usw. zu vermeiden und einigermaßen immer das gleiche zu machen (einfach in der Welt looten). Dann habe ich mich im Gaming nicht zu sehr auf die FPS-Werte konzentriert, sondern einfach das Spiel gespielt und auf mich wirken lassen, ob ich objektiv wirklich einen spürbaren Unterschied merke. Mein angestrebter Sweetspot in dem Spiel ist zwischen 90 und 120-130 FPS. Mehr brauche ich in dem Spiel nicht und genieße lieber die schöne Grafik. Temperaturwerte hab ich bei dem Ingame-Benchmark bewusste weggelassen. Die Logdauer beträgt dabei nicht mal 1:50 und ist einfach viel zu kurz, um irgendwas über Temperaturentwicklung zu sagen.

Dann wollte ich wissen, wie zuverlässig der Ingame-Benchmark eigentlich ist und habe etliche Male das gleiche Profil getestet, weil ich jedesmal leicht andere Werte bekommen habe. Dafür habe ich das alte PBO-Profil vs. das stärkste UV-Profil genommen. So sehen die Ergebnisse im Vergleich aus:

Zumindest der Benchmark zeigt einen reproduzierbaren Unterschied, was durchaus auf den leicht reduzierten Eff. Clock im UV-Profil zurückzuführen ist. Möglicherweise ist es schon ein Tick zu viel mit dynamic Offset. Dennoch, im Gaming selbst merkt man keinen Unterschied in der Darstellung. Dafür aber sehr deutlich die Einsparung im Verbrauch und Temperatur. Das ist halt auch ein wenig das Problem vom PBO (Overdrive = OC). Sobald er aktiviert ist, erhöht es den Vcore und damit den Verbrauch, insbesondere wenn man ein positives Takt-Offset anlegt. Der Unterschied im Vcore von +100 zu -500 ist massiv, holt aber keinen spürbaren FPS-Vorteil raus, zumindest nicht in AC Valhalla.

Ich werde die Profile nun in weiteren Titeln testen und gucken wie die Unterschiede dort ausfallen. Gut möglich, dass das in anderen Spielen nicht so gut funktioniert wie in AC Valhalla. Spiele, die ich noch testen würde sind:

- God of War

- Horizon Zero Dawn

- Cyberpunk 2077

- Far Cry 6

- Forza Horizon 5

- GR Breakpoint

- Shadows of the Tomb Raider

---------------------------------------------->

---------------------------------------------->

Informationen und Undervolting speziell zum Ryzen 5800X3D findet sich im Beitrag #99

Zuletzt bearbeitet: