audioslave

Experte

Das sind doch jedes mal die selben Diskussionen.

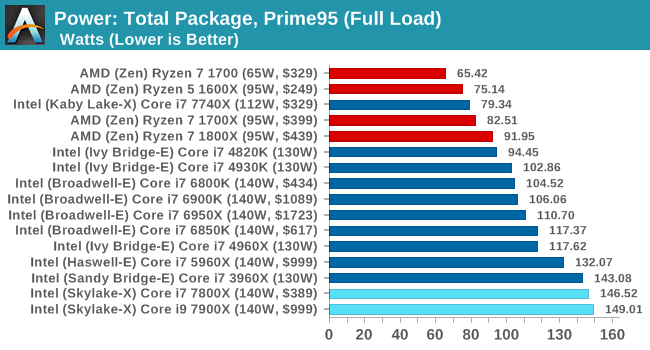

Am Ende wird es wieder zwei Sieger geben, wie immer.

Intel wird Sieger sein in der Leistung und AMD ist wiederholt "Sieger der Herzen".

Grüße

So ist das mit Menschen. Du hast dein Geld ja auch in fashion apfel gesteckt statt in vernünftige Hardware. (Aber den Irrtum immerhin vier Jahre später bemerkt)

Und mal nebenbei, in dem ewig anhaltenden Kindergarten wird es schlicht und ergreifend keinen Gewinner geben, ich weiß also nicht was dein Kommentar soll.

Die Intel fanbois sind ja erst glücklich sobald sie eine Monopolstellung haben (und zwar gänzlich, nicht so knapp davor wie bisher) und 500 Euro für 4c4t@ 5,1GHz zahlen müssen. Das Gegenstück auf amd Seite kann ich mir nicht ausmalen, wer weiß was die wollen. Ich für meinen Teil bin für sehr rege Konkurrenz so dass sich jeder was zum Daddeln zusammenbauen kann. Oder zum Benchen. Und wenn sogar ein paar wenige Leute, die tatsächlich damit arbeiten und nich nur den virtuellen riesen Lachs auf den Tisch legen wollen, profitieren und günstig an kürzlich noch undenkbare Hardware kommen - ja bidde!

Zur aktuellen Diskussion kann man eigentlich nur sagen: Es suchen sich doch beide Lager immer irgendwelche random benches raus, die genau ihr Lager gut dastehen lassen. Nichts desto trotz kann man zwischendurch auch immer mal wieder interessante Ansätze rauslesen udn selber recherchieren. Also macht ruhig weiter so, ist mein voller Ernst.

Es ist doch alles gut wie es ist.