Ob man heutzutage als Neuanschaffung einen IvyBridge, Haswell oder Skylake kauft, spielt in meinen Augen,

Neu kauft dch heute keiner mehr Sandy- oder IvyBridge, entweder Haswell oder Skylake und bald nur noch Skylake, wenn der erst etabliert ist und die anfänglichen Aufpreise entfallen sind.

Das können sie bei allen Generation mit der richtigen CPU und dem passenden Board. Wieso tun immer alle so, als wenn das heute gar nicht mehr gehen würde? Oder als ob man damit eine alte CPU generell auf das Leistungsniveau einer vergleichbaren aktuellen CPU bringen könnte?

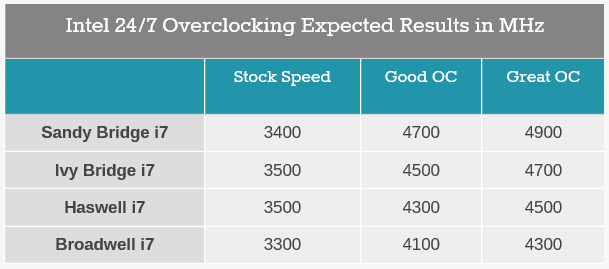

Nimmt man mal Anandtechs Tabelle als Grundlage, dann wird es zwar immer weniger was da geht, auch weil der maximale Takt den man zu erreichen erwarten kann immer gefallen, die Werkstakte aber eher gestiegen sind, aber ein Sandy den man um 45% übertaktet bringt deswegen eben keine 45% Mehrleistung, die Leistung skaliert ja nicht linear mit dem Takt. Außerdem hat Anandtech seine 3 Engineering Samples auf über 4,6GHz und die eine Retail CPU auf 4,5GHz bekommen, normale Retail CPUs können das also auch schaffen oder wenigstens 4,4GHz, was auch noch mal wenigstens 10% mehr Takt wären.

aber die CPU Leistung ist ja exakt gleich geblieben (siehe 4790k vs 6700k).

Das ist doch so nicht richtig, egal wie oft es wiederholt wird, die Steigerung ist nicht bei allen Anwendungen vorhanden, aber z.B. bei

allen die Anandtech unter Linux getestet hat und bei NPB, Fluid Dynamics oder Redis Memory-Key Stor 10x bei fast 20% für den 6700k gegenüber dem 4790k.

Klar wird das einen Gamer nicht interssieren und bei den

Game Tests mit High-End Grakas liegen die i5 und i7 seid SandyBridge mehr oder weniger gleichauf, aber das ist doch eben kein Beleg für den angeblich nicht vorhandenen Leistungszuwachs, sondern nur dafür das die Games diese Mehrleistung nicht brauchen bzw. nutzen können. GRID: Autosport ist da eines der wenigen bei denen die CPUs überhaupt einen Unterschied jenseits der Messgenauigkeit ausmachen und schon liegt der 2600k auch mit 77,2 Frame (R9 290X) zu 112,24fps des 4790k zurück, genau um die 45% die man vielleicht bei einer gut übertaktbare CPU vielleicht beim Takt rausholen kann.

Aber einen gut gehenden 4790k bekommt man auch auf 4,8GHz und die besten auf 5GHz, dann sieht der 2600k doch wieder alt aus. Warum also einen guten übertaktbaren 2600k also gegen einen 4790k@Stock antreten lassen? Nur damit These stimmt die Leistung würde stagnieren? Das kann es ja wohl nicht sein, also entweder bei @Stock oder beide OC und dann entweder nach dem was viele können und das sind dann eben bei beim 2600k keine 5GHz oder nach dem was die besten Exemplare schaffen, dann muss man auch einem 4790k die 5GHz zugestehen, die so etwa 5% von ihnen schaffen sollen.

gesehen.

gesehen.