Hallo liebe Hardwareluxx Community,

vielen Dank für die Möglichkeit, das QNAP NAS ausgiebig testen zu dürfen.

Ich habe eine kleine Navigationshilfe in Form eines Inhaltsverzeichnisses erstellt mit Sprungmarken zu den einzelnen Kapiteln.

In meine Bewerbung habe ich zudem noch folgendes geschrieben:

Mein Name ist Sascha, ich bin 36 Jahre jung, habe Frau und zwei Kinder und als Systemadministrator mein Hobby zum Beruf gemacht.

Schon als Kind haben mich Computer begeistert und so habe ich seit meinem 10. Lebensjahr einen eigenen Computer. Dabei habe ich auch einige Tiefs durchlebt, bei denen mir aber mein Vater immer geholfen hat (Windows zerstört, eine CPU falsch eingebaut, usw.). Deshalb habe ich das Ganze dann später auch als AG in der Schule belegt und danach noch ein Studium in der technischen Informatik absolviert. Seit 2008 bin ich hauptberuflich Systemadministrator und durfte in der Laufbahn viele spannende Projekte in vielen Bereichen durchführen: Firewalls, Netzwerke, VMware, Windows, Linux, Citrix, Infrastruktur (Strom, Klima, etc.), Storage-Netzwerke, Storage-Administration, ISO- & TÜV-Zertifizierung, Shell-Scripting, usw.

Dokumentationen der Tätigkeiten sind mein tägliches Brot und werden auch immer gewissenhaft durchgeführt und mit Screenshots ergänzt, so dass diese auch allgemeinverständlich sind.

Aber Hobbys wären keine Hobbys, wenn man sich nicht auch in seiner Freizeit damit beschäftigt.

Ich habe mich sehr gefreut, dass ich für den Lesertest ausgewählt wurde, da ich nach viel Erfahrung mit Synology NAS Geräten nun endlich mal ein QNAP testen darf. Hier hat sich seit meinen letzten QNAP-Berührungspunkten vor über 10 Jahren denke ich einiges getan. Umso mehr freue ich mich darauf nun direkt mit dem Test loslegen zu dürfen.

alle Infos auch auf der Webseite von QNAP zu finden.

In dem großen Paket waren 2 Pakete vorhanden, eines mit den von Hardwareluxx gesponsorten 2x WD RED Plus 4 TB Festplatten sowie der Originalkarton mit dem eigentlichen NAS. Beides, sowohl die Festplatten als auch das NAS waren super verpackt mit genügend Schutzmaterial.

Folgende Inhalte lagen dem Paket außerdem noch bei:

Das NAS selbst kommt in einem weißen Grundkörper mit goldenen Applikationen. Damit soll das Gerät auch dafür geeignet sein, um es z.B. direkt neben den Fernseher im Wohnzimmer aufstellen zu können.

An der Vorderseite kann man klein geschrieben das Firmenlogo lesen und findet außerdem die Status-LEDs für Power, Netzwerk, Copy & die beiden HDDs sowie 2 kleine Knöpfe, einmal den Powerbutton und ein USB-Copy-Button. Ein USB 3.2 Gen 2 Port.

Auf der Rückseite befinden sich der Netzteilanschluss, ein 2,5 Gbit/s Netzwerk Port, 2 USB 2.0 Ports, ein USB 3.2 Gen 2 Port, ein HDMI-Port und der obligatorische Kensington Lock.

Innen findet man wie bei vielen 2-bay NAS-Systemen die beiden Festplattenkäfige, in die sich sowohl 3,5 Zoll als auch 2,5 Zoll Festplatten einbauen lassen. Für letztere kann man die mitgelieferten Schrauben nutzen. 3,5 Zoll Festplatten lassen sich mit dem einfachen Klicksystem einfach einsetzen. Dazu werden die Festplatten in die Festplattenkäfige eingelegt und dann einfach mit den Klemmen befestigt.

Hat man beide Festplattenkäfige entfernt kann man einen Blick auf die Backplane mit den 2 SATA-Ports erhaschen. Außerdem sieht man auf dem Mainboard die beiden Slots für die NVMe SSDs im M.2 Format, die allerdings nur mit PCIe Gen 3 x1 angebunden sind und damit nur ca. 1 GByte/s an Durchsatz liefern.

Für den Arbeitsspeicher gibt es keinen Erweiterungsslot und damit auch keine Erweiterungsmöglichkeit.

Die Erweiterungsmöglichkeit mittels eine PCI-Karte mit PCIe Gen 3 x2 angebunden ist und damit ca. 16 Gbit/s an Durchsatz schafft finde ich eine klasse Sache. Allerdings kann dort leider nicht jede Karte verbaut werden, da die Blende zwar Low-Profile ist, allerdings am Montage-Ende gerade sein muss und nicht wie üblich um 90° geknickt.

Die Festplatten von Western Digital, in diesem Fall die WD Red Plus 4TB stelle ich hier nicht explizit vor, da der Fokus auf dem NAS liegt. Außerdem wurden die Festplatten schon anderswo ausgiebig getestet, so wie ich es vermutlich nie hinbekommen würde 😊, z.B. hier: Western Digital Red Plus, 4 TB, WD40EFZX im Test. WDs aktuelle Red Plus mit Luft. – Firebls wunderbare Welt der Hardware (fireblsblog.de).

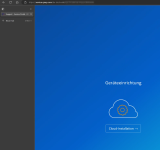

Die Installation des NAS gestaltet sich denkbar einfach. Hierbei gibt es 2 Varianten:

Hierbei startet sich ein Webassistent, bei dem man im weiteren Verlauf auf die myQNAPcloud umgeleitet wird.

Hier ist nun allerdings ein Cloud Account nötig, um die Einrichtung weiter durchführen zu können. Ich selbst bin ein Freund dieser Cloud-Anbindungen, da man so auch von extern auf das NAS zugreifen kann, ohne einen Port auf dem Router bzw. der Firewall öffnen zu müssen. Sollte man das später nicht mehr wollen kann der Zugang auch einfach wieder deaktiviert werden.

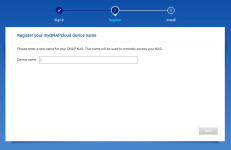

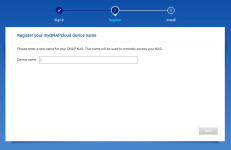

Im nächsten Schritt vergibt man nun einen eindeutigen Namen für das NAS, mit dem es später auch über myQNAPcloud-Adresse erreichbar sein wird.

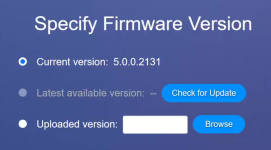

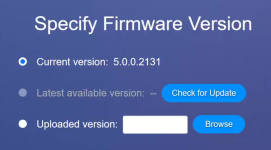

Klickt man sich weiter durch den Assistenten kommt man irgendwann an die Stelle, an der man die entsprechende QTS-Version auswählen soll. QTS ist das Betriebssystem für die QNAP-NAS-Modelle.

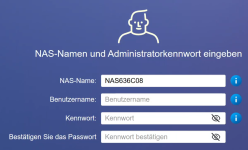

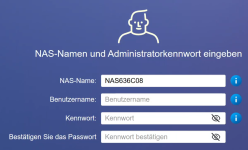

Im folgenden Schritt muss noch der Systemname für das NAS, ein Benutzername und ein Kennwort vergeben werden. Damit wird der erste Admin für das NAS angelegt mit dem man sich auch nach der Fertigstellung der Installation direkt anmelden kann.

Die restlichen Schritte sind weitestgehend selbsterklärend: Zeit einstellen, IP-Adresse vergeben (DHCP oder statisch), Zusammenfassung prüfen, Initialisierung starten.

Die Initialisierung hat bei mir ca. 8 Minuten gedauert. Das Ganze lief bei meinem Synology-NAS etwas flotter (3:30 Minuten), ist aber dennoch aus meiner Sicht im Rahmen.

Nach Ablauf der Zeit befindet man sich im Anmeldefenster und kann sich mit dem vorher angelegten Admin-Account einloggen.

Allerdings wird für die lokale Installation eine Software mit dem Namen Qfinder pro benötigt, um das NAS im lokalen Netzwerk aufzuspüren und sich damit zu verbinden.

Ansonsten läuft die Installation ähnlich ab, außer dass die die Punkte für das myQNAPcloud Konto wegfallen. Bedeutet man startet direkt mit der Auswahl des Betriebssystems. Die Schritte dazu können im Detail einen Punkt weiter oben nachgelesen werden.

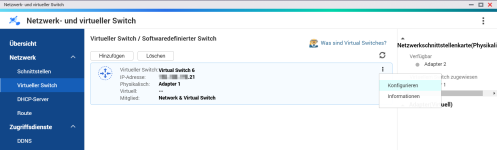

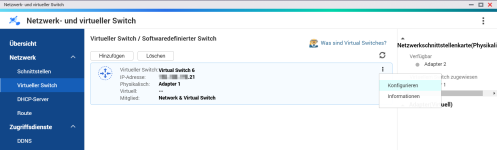

Ich habe mich dazu entschlossen dem NAS eine statische IP-Adresse außerhalb des DHCP-Bereiches meines Routers zu geben. Dazu startet man die App „Netzwerk- und virtueller Switch“ > Virtueller Switch und klickt dann in der Mitte auf das 3-Dot-Menü und wählt dort konfigurieren aus.

Hier wird man nun von einem Wizard durch die Netzwerkkonfiguration begleitet und kann die gewünschten Daten hinterlegen.

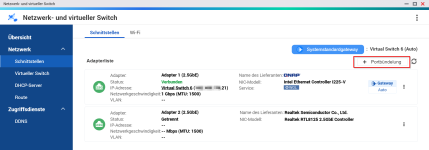

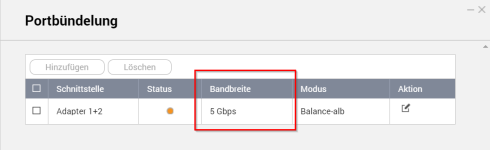

Da das QNAP TS-262-4G nur einen Netzwerk-Anschluss hat kann hier ohne eine zusätzliche Karte keine Portbündelung eingerichtet werden. Ich habe mir extra dafür eine solche Karte besorgt (diese landet später dann in meinem PC) um die Portbündelung testen zu können.

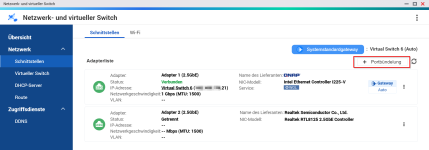

Die Einrichtung gestaltet sich denkbar einfach. Man verbindet beide Netzwerkanschlüsse des NAS mit einem oder auch mit unterschiedlichen Switchen und öffnet wieder die App „Netzwerk- und virtueller Switch“ und wählt unter Schnittstellen rechts oben den Punkt Portbündelung aus.

Hier wird man nun wieder von einem Wizard begleitet.

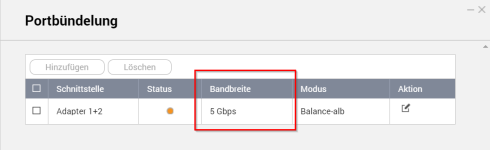

Das Ergebnis sieht dann wie folgt aus:

Alle Einstellmöglichkeiten dazu findet man in der gleichnamigen App myQNAPcloud. Hier lässt sich die über einen Wizard die Verbindung des NAS mit der Cloud herstellen. Der Wizard besteht aus 5 Schritten, in denen man sich zuerst an der Cloud anmeldet (und ggfs. einen Account erstellt), einen Namen für das QNAP NAS vergibt, die Dienste und Berechtigungen vergibt und etwas wartet.

Hat man die myQNAPcloud eingerichtet kann man noch ein Zertifikat mittels Let’s Encrypt installieren und den myQNAPcloud Link einrichten, mit dem man von extern auf das NAS ohne Portfreigabe zugreifen kann.

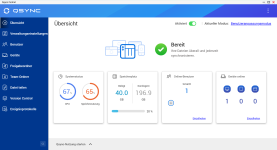

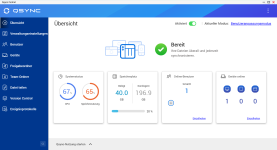

Hat man alles eingerichtet sieht das Dashboard wie folgt aus:

Ergänzend möchte ich noch erwähnen, dass bei einer Verbindung über den DDNS-Namen an erster Stelle versucht eine Direktverbindung zwischen dem User und der QNAP herzustellen. Dies ist aber nur an Anschlüssen mit einem IPv4 oder IPv6 bzw. Dual Stack möglich. Bei einem Dual Stack Lite wird die Verbindung über die QuickConnect Server aufgebaut, natürlich SSL-verschlüsselt.

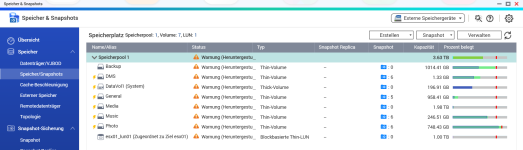

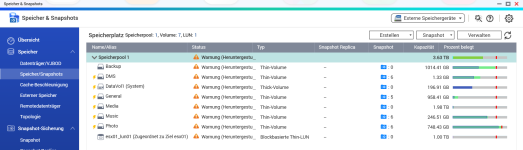

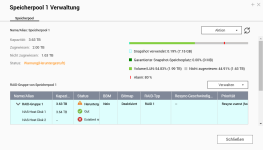

Damit die NAS genutzt werden kann, muss aus den Festplatten zuerst ein Speicherpool erstellt werden, in den man im Anschluss das oder die Volumes platzieren kann. Die Einrichtung dazu wird mit der App Speicher & Snapshots durchgeführt. In dieser App kann man sich auch die verbauten Festplatten und deren Zustand anschauen sowie einen Leistungstest durchführen.

Die Erstellung eines Speicherpools sollte man gewisser Weise planen, da QNAP einem mehrere Optionen zur Wahl lässt:

Nach der Erstellung des Storage-Pools wird man wiederum mit einem Wizard durch die Erstellung des ersten Volumes geführt. Bei einem Volume kann man auswählen zwischen folgenden Einstellungen:

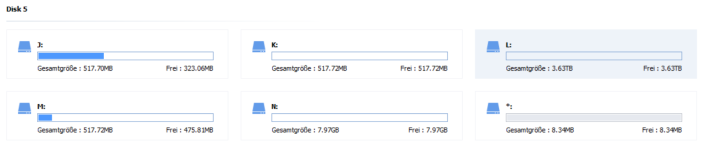

Dasa hat aber auch einen Nebeneffekt: Man sollte die Speicherauslastung immer im Blick behalten. Durch das sogenannte Thin Provisioning ist es möglich, Volumes mit mehr Speicherplatz anzulegen als das NAS physikalisch zur Verfügung hat. In der hier getesteten Konfiguration sind zwei 4 TB Festplatten verbaut, mit einem RAID1 habe ich ca. 3,83TB zur Verfügung. Nun kann ich allerdings problemlos 8 Volumes mit je 1TB anlegen. Gelange ich aber an den Punkt, dass der Speicher voll ist, kann ich auf den anderen Volumes keine Daten mehr ablegen, obwohl mir noch freier Speicher angezeigt wird.

Beim Thick Provisioning hingegen wird der gewünschte Speicher direkt allokiert und steht nicht mehr für andere Volumes zur Verfügung. Damit kann man hier auch immer Daten ablegen, egal ob der physikalische Speicher durch andere Volumes aufgebraucht wurde oder nicht. Außerdem erhält man eine bessere Festplattenperformance. Das liegt daran, dass hier nicht wie bei der Thin-Variante die Speicherblöcke vor dem Schreiben zuerst allokiert werden müssen.

Weiter im Wizard kann ich nun die Größe angeben und ob ich das Volume verschlüsseln möchte.

Der letzte Schritt besteht nun darin die Snapshots zu aktivieren oder auch nicht. Damit wird in regelmäßigen Abständen ein Snapshot des Volumes erstellt. Dieser sorgt dafür, dass die Daten festgehalten werden und man jederzeit auf diesen Snapshot zurückspringen kann oder Daten aus diesem Wiederherstellen kann, sofern man versehentlich etwas gelöscht hat. Das ist super, wenn man eine große Bildergalerie hat und ggfs. ein wichtiges Bild gelöscht hat. Diese Snapshots lassen sich schnell anlegen, so dauert die Erstellung meistens nur wenige Sekunden. Dennoch sollte man zusätzlich ein Backup der Daten erstellen, denn die Snapshots liegen auf denselben Datenträgern. Sollte diesen etwas passieren wären die Daten trotzdem verloren. Zu den Backups aber später mehr.

Eine Auswahl eines Filesystems gibt es hier nicht, alle Volumes werden ausschließlich mit ext4 angelegt. Das schränkt zwar einige Funktionen ein, allerdings ist ext4 ein langjähriges, stabiles Filesystem.

Dazu habe ich mir 2 günstige SSDs auf Amazon ohne DRAM-Cache besorgt und diese eingebaut. Die SSDs haben jeweils nur 256GB, das sollte aber als Cache Laufwerk mehr als ausreichend sein, es sei denn man bewegt regelmäßig mehr als 250GB über das NAS. Das sollte aber im normalen Tagesbetrieb nicht der Fall sein.

Der Wizard empfiehlt zwar eine Verteilung von 1:3 (also pro 100GB HDD sollten 33GB SSD-Cache verfügbar sein), das halte ich allerdings für etwas übertrieben.

Mit meinen 2 bestückten NVMe Slots (welche übrigens mit den Clips perfekt gelöst sind, so benötigt man keine Schrauben um die SSD in dem M.2 Slot zu fixieren) habe ich mir also über den Menüpunkt Cache-Beschleunigung einen Lese-/Schreibcache eingerichtet. Dazu werden beide SSDs automatisch mindestens zu einem RAID1 zusammengefasst. Es wäre auch ein RAID0 möglich, aber im Falle des Ausfalls einer der beiden SSDs wären die Daten futsch, bevor diese auf die HDDs geschrieben werden können.

Man wird nun noch nach dem SSD Overprovisioning gefragt und zum Schluss noch für welches Volume der Cache aktiviert werden soll. Ist der SSD-Cache dann aktiviert kann man den Füllgrad sowie die Volumes mit aktiviertem SSD-Cache in einem Dashboard beobachten.

Und da Bilder bekanntlich mehr als tausend Worte sagen, gibt es zu jedem Test auch mind. einen Screenshot.

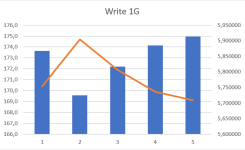

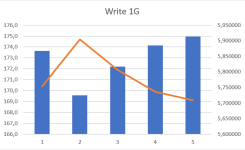

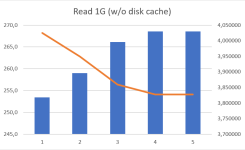

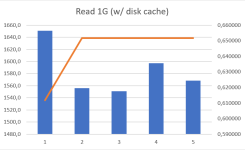

Alle Tests wurden im RAID1 und einer Blockgröße von 1K durchgeführt. Jeder Test wurde 5x durchgeführt mit einer Pause von 10 Sekunden zwischen jedem Test und habe den Mittelwert davon gebildet (Excel sei Dank 😊). Die Befehle dazu, falls es ebenfalls jemand testen möchte, waren die folgenden:

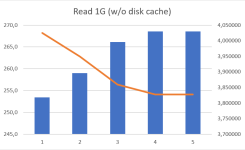

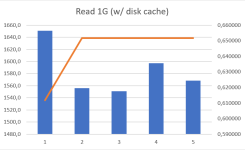

Die Werte ohne Cache und Encryption waren hier konstant auf einem Niveau. Hier merkt man allerdings die nur mit 5400 rpm drehenden Festplatten, mehr als 174,7 MB/s waren beim Schreiben nicht drin. Beim Lesen waren es immerhin 268,2 MB/s in der Spitze. Den integrierten ca. 2 GB großen der Cache der Festplatte habe ich dabei übersprungen. Mit aktiviertem Cache kletterte der Wert auf ca. 1,6 GB/s.

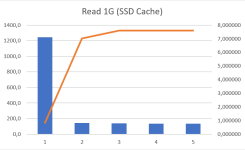

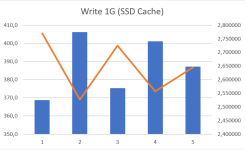

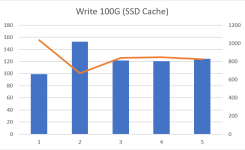

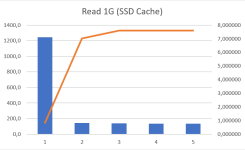

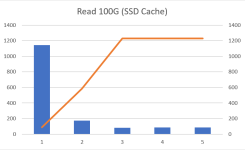

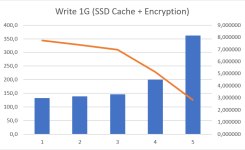

In dem Diagramm ist die orangene Linie (linke Reihe) die Übertragungsgeschwindigkeit und die blauen Balken (rechte Reihe) die Zeit in Sekunden.

Mit aktivierter Encryption sieht das Bild sehr ähnlich aus, lediglich die Leseperformance war etwas geringer mit 235,6 MB/s in der Spitze.

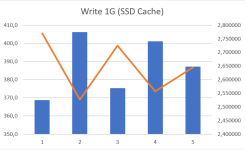

Interessanter gestaltet sich ganze, wenn ich die eingebauten SSDs als Cache dazuschalte. Hier ergibt sich auch ein sehr spannendes Bild, je nachdem wie viel ich den SSDs zumute. Ich habe hier recht billige SSDs hergenommen, dazu nachher noch ein Satz dazu.

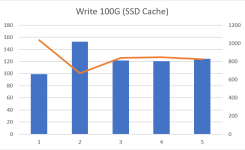

Schreibe ich nun das 1GB große Test File habe ich Spitzenwerte von 405,5 MB/s, das ist ganze 2,32x so flott. Das funktioniert auch mit den 10GB großen Testfiles noch super. Bei den 100GB Testfiles merkt man aber, dass die Performance der SSDs stark einbricht. Hier konnte ich dann nur noch einen Maximalwert von 155 MB/s verzeichnen, Tendenz zu weniger. Hier bringt der SSD-Cache also nichts. Das liegt aus meiner Sicht an dem ca. 60 GB großen SLC-Cache, der hier verbaut ist. Sobald dieser erschöpft ist, bricht die Performance massiv ein. Bei den Random Schreibzugriffen gibt es keinen Unterschied zu den reinen Festplatten.

Wenn alle Daten auf die SSD geschrieben wurden werden diese natürlich im Hintergrund auf die Festplatten geschrieben. Das kann je nach Menge auf den SSDs etwas Zeit in Anspruch nehmen, da wir hier wieder nur mit den oben gemessenen ca. 170 MB/s insgesamt schreiben.

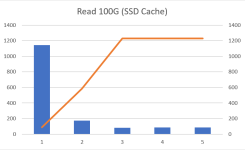

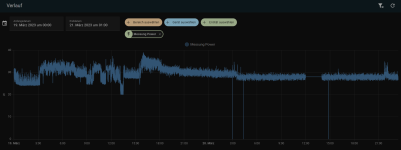

Beim Lesenden Zugriff merkt man dann aber die Stärken des SSD-Cache. In den Diagrammen sieht man schon, wie der erste Zugriff noch recht langsam ist, alle folgenden Zugriffe dann aber extrem Flott von statten gehen. Gerade bei den Zugriffen auf das 100G File merkt man wie die Geschwindigkeit mit jedem Zugriff zunimmt. Der Erste Lesezugriff dauert noch knapp 20 Minuten bei ca. 90 MB/s, der Zweite Zugriff dauert noch nur noch etwas über 2 Minuten mit fast 600 MB/s und restlichen Zugriffe sind in jeweils 84 Sekunden erledigt bei 1,2 GB/s.

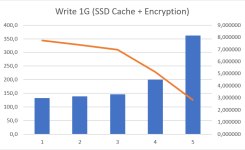

Bei dem Test mit SSD-Cache + Encryption habe ich die Tests mehrfach wiederholt, aber das Ergebnis war immer dasselbe: Die Verschlüsselung fordert hier ihren Tribut und lässt die Schreibleistung selbst bei den 5 Durchläufen von 344 MB/s auf 125,9 MB/s einbrechen.

Beim Lesen allerdings sieht das Bild wieder genauso aus wie ohne Encryption, auch wenn ich hier statt 1,2 GB/s nur auf ca. 900 MB/s komme. Das ist aber schon der ganze Unterschied dabei.

Mein Fazit aus diesen synthetischen Tests: Ich werden den Cache auf jeden Fall nutzen, da er mir im „normalen“ Alltagsbetrieb ein besseres Look-and-Feel für das QNAP beschert. Auch sollten viele der Random-Zugriff schneller über die Bühne laufen. Das wird aber die Zeit erst wirklich zeigen.

Nachtrag: Den SSD-Cache habe ich zwischen jedem Test komplett geleert, damit die Werte nicht verfälscht werden.

Mit schnelleren SSDs wäre sicher ein besseres Ergebnis möglich, vielleicht tausche ich diese noch in Zukunft aus. Aber die SSDs haben mich pro Stück 21€ gekostet, also quasi geschenkt 😊

Einen Test der SSD gibt es bei Tom’s Hardware (zwar die 512GB Variante, aber die sollten sich nicht so viel schenken): 512GB Performance Results - Silicon Power P34A60 M.2 NVMe SSD Review: Mid-Range Performance at Rock-Bottom Pricing | Tom's Hardware (tomshardware.com)

Beim Cache musste ich etwas warten, da die Daten erst von den HDDs auf die SSDs kopiert wurden und im Anschluss wieder von den SSDs auf die HDDs (für den Fall None -> Cache+Enc)

Generell kann man festhalten, dass die Übertragungsraten in alle Richtungen recht ähnlich ausgefallen sind. Das liegt in diesem Test daran, dass ich mich direkt auf dem NAS bewegt habe und hier die Daten von einem Volume auf das andere kopiert habe. Am Ende mussten die Daten aber immer von den HDDs gelesen und auch wieder darauf geschrieben werden.

Lediglich das Kopieren von und auf den Cache war etwas seltsam, da hier selbst ein 100GB großes File innerhalb von 1s fertig kopiert war. Hierzu habe ich leider keine Erklärung und auch wiederholte Tests haben immer wieder das Gleiche erbracht.

Zusätzlich habe ich mir eine 2,5 GBit/s Netzwerkkarte besorgt und werde hier auch mit einer Direktverbindung die Übertragungsraten prüfen. 2,5 GBit/s ist zwar immer mehr im Kommen, aber die Infrastruktur dazu muss auch passen. Da vermutlich die allermeisten hier im Forum noch kein 2,5 GBit/s Netzwerk flächendeckend besitzen werde ich diesen Test auch kurz und knapp halten und mich auf ein 1 GBit/s Netzwerk konzentrieren.

Ich werde die reinen Transferraten testen mit großen Dateien aber auch mit vielen kleinen Dateien, um die IOS zu testen.

Als Pendant in meinem Rechner werkelt eine Samsung 970 Evo mit 512 GB.

Die Transferraten beim lesenden Zugriff können sich sehen lassen. Sowohl mit als auch ohne SSD-Cache liegen die Leseraten nahe an den bei 2,5 GB/s theoretisch möglichen 320 MB/s. Zieht man den ganzen Overhead usw. ab sind 271 MB/s ohne bzw. 283 MB/s mit SSD-Cache ein super Wert. Der SSD-Cache kann technisch bedingt seine komplette Leistung erst beim 2. Durchgang entfalten, wenn die Daten ausschließlich von den SSDs gelesen werden.

Bei den verschlüsselten Volumes sieht es ähnlich aus, nur ist hier die Leseperformance direkt von der HDD nicht so hoch wie ohne Verschlüsselung. Bei den SSDs gibt es keine Veränderung nach ab dem 2. Durchgang.

Etwas enttäuscht hat mich die Schreibe-Performance, diese war ohne SSD-Cache besser als mit. Wie schon weiter oben erwähnt liegt das vielleicht an meinen günstigen SSDs, aber ich wollte hier nicht noch mehr ausgeben für einen Test dessen Ergebnis ich beim Kauf noch nicht kannte.

In diesem Test wurde ein Ordner mit einer Größe von 1,4 GB bei 7154 Dateien gewählt. Diese sind unterschiedlich groß, von wenigen KB bis hin zu einigen MB.

Hier ist wie zu erwarten kein konstanter Datenstrom möglich. Hier hätten die 2,5 Gbit/s keinen Mehrwert gebracht.

In der folgenden Tabelle habe ich die Unterschiede nochmal aufgeschrieben.

Interessanterweise spielt der SSD-Cache hier nicht wirklich eine Rolle. Ich habe den Test auch noch ein 3. Und 4. Mal durchgeführt ohne Änderung an der Zeit.

Warum mehrere Volumes statt nur eines? Ganz einfach: Ich würde gerne entscheiden welches Volume den SSD-Cache erhält, wie die Snapshots erstellt werden sollen usw. Das geht nur auf Volume-Basis, deshalb gibt es eben mehrere Volumes statt nur eines großen Volumes.

Auf den Volumes müssen nun noch Freigabeordner erstellt werden, in diesen landen dann die effektiv die Daten. Ohne diese Freigabeordner wäre das Volume nur eine leere Hülle.

Die Daten selbst habe ich ganz einfach per Freigabe von meinem Synology auf das QNAP kopiert. Dabei hat mir eine App mit dem Namen HybridMount geholfen. Damit lassen sich recht einfach externe Speicher einbinden, egal ob CIFS, Google Drive, OneDrive, usw. Details zu der App folgen weiter unten.

Für die Migration habe ich einfach die CIFS-Freigaben eingebunden und diese dann mit der File Station einfach per Drag&Drop kopiert. Fertig.

Mit der Software allerdings kann das NAS zusätzlich noch eine Sync-Station, Medienserver, SetTopBox, Backupserver, etc. werden.

Der App Center wirkt recht strukturiert, allerdings sind die Namen der Apps mit den eingebetteten Versionsnummern manchmal etwas verwirrend.

Ich werde hier bei vielen der Apps nicht auf die Details eingehen, sondern nur grob den Funktionsumfang umreisen und beschreiben. Außerdem werde ich hier auch nicht alle Apps vorstellen (können), das würde den Rahmen sprengen.

Dabei kann man auswählen, ob man das Laufwerk direkt einbinden möchte oder mit eine Cache Funktion. Direkt eingebunden werden alle Änderungen direkt in die Cloud geschrieben oder von dort gelesen.

Mit dem Cache Modus, der allerdings auf die zwei verfügbaren Lizenzen für die App angerechnet wird, werden die Daten in einem eigens dafür erstellten Speicher zwischengespeichert und asynchron geschrieben oder werden lokal einfach weiter vorgehalten sollte man öfter darauf zugreifen müssen. Die Größe des Cache Laufwerks lässt sich dabei einstellen, kann aber nach der Erstellung nicht mehr verkleinert werden.

Da mein Cloud-Laufwerk nur als Backup genutzt wird verzichte ich hier auf das Cache Laufwerk.

Mit dieser Funktion lässt sich das NAS quasi zu einem Multi Cloud Portal aufrüsten, mit dem sich die Daten von z.B. Dropbox auf OneDrive kopieren oder verschieben lassen, ohne dass man sich auf dem jeweiligen Portal anmelden muss.

Weiterhin lassen sich einzelne Mounts dediziert ein- oder aushängen, wenn man sie nicht mehr braucht oder das Quellsystem nicht mehr existieren sollte. Für mich allerdings war es die perfekte Methode meine Daten von meinem Synology auf das QNAP zu migrieren, da es sich am Ende nur um einen einfachen Kopierprozess handelt. Man sollte allerdings in der Zeit darauf achten, dass sich im Quellordner keine Dateien mehr verändern. Anderenfalls muss man den Kopiervorgang nochmal starten.

Nach Aktivierung sieht die Startoberfläche wie folgt aus und erinnert ein bisschen an die frühen Smart TVs:

Von hier aus können nun die installierten Apps gestartet werden. Die Bedienung kann dabei entweder über eine lokal am NAS angeschlossene Maus und Tastatur erfolgen oder mittels einer Fernbedienung, die man separat erwerben kann. Vermutlich funktioniert das auch mit einer Universalfernbedienung, aber das konnte ich leider mangels USB-B Datenkabel für meine alte Logitech Harmony One nicht testen ☹.

Was ich allerdings etwas schade fand: Sie internen Apps wie MusicStation und PhotoStation wurden immer über einen Browser geladen. Es handelt sich also um reine Webapps, was ich persönlich etwas schade finde, diese kann ich auch direkt von meinem PC aus starten oder über den eingebauten Browser meines SmartTV, das läuft auch deutlich flüssiger.

Ansonsten die HD Station das getan, was sie sollte: Bilder, Music und Videos direkt über HDMI abspielen. Das war es aber leider auch schon. Ich werde hier vermutlich eher ein Ubuntu installieren und über HDMI ausgeben lassen, hier habe ich dann ein volles Betriebssystem im Hintergrund und kann ebenfalls alle Apps öffnen wie mit der HD Station und mehr.

Hier hätte ich mir etwas mehr Flexibilität gewünscht, um zum Beispiel auch Apps wie Netflix oder dergleichen installieren zu können ohne auf die Browser-Variante davon zurückgreifen. Das macht heute jeder SmartTV besser und auch schneller. Meinen Enigma2-Receiver wird er aber wie ich ursprünglich die Hoffnung hatte damit nicht ablösen können.

Leider ist es mir nicht gelungen, einen Clouddienst erfolgreich zu verbinden während des Testzeitraums. Ich habe meine Logindaten eingegeben, habe auch eine Mail bekommen, dass ein neues Gerät auf mein Konto zugreift, aber das NAS hat mir leider teilweise über 4 Stunden lediglich „bitte warten“ angezeigt. Also habe ich beschlossen diesen Teil zu übersprungen, da ich es einfach nicht testen konnte.

Also habe ich einen kleinen Ordner genommen und diesen auf das lokale NAS gesichert. Hier konnte ich dann die möglichen Funktionen testen. Dazu zählen:

Gerne hätte ich hier auch die Möglichkeit der Synchronisation mit einem Clouddienst getestet, z.B. meine Daten in den externen Speichern automatisch auf mein NAS herunterzuladen und so auch lokal vorzuhalten. Ich hätte dann die Möglichkeit über ein lokales Netzlaufwerk oder einen iSCSI Mount auf meinen PC „indirekt“ auf die Daten in der Cloud zuzugreifen und diese damit lokal bei mir im Netzwerk zu bearbeiten. Nach erledigter Arbeit werden diese dann im Hintergrund und ohne das mein PC laufen muss mit der Cloud synchronisiert.

Zu dem Thema werde ich noch ein Ticket bei QNAP eröffnen und hoffe hier auf eine rasche Hilfe.

Es lässt sich auch ein USB-Backup mittels Tastendruckes einrichten, TimeMachine Backups konfigurieren usw. Also ein vielseitiges Programm mit dem alle seine Daten sicher entweder im Netzwerk oder in der Cloud verteilen kann.

Nach der Installation lässt sich die App einfach starten und öffnet sich in einem neuen Fenster. Hier wird man von einem übersichtlichen Dashboard begrüßt, das einem gleich anzeigt, dass ein Repository Speicherplatz angelegt werden muss. Hierzu muss lediglich ein Ordner auf einem bestehenden Volume ausgewählt werden. Ich empfehle hier allerdings ein Volume ohne Cache oder Encryption zu nutzen, da hier beim Backup zum einen eine eigene Verschlüsselung zum Tragen kommen kann und zum anderen sowohl Deduplizierung als auch Komprimierung gleichzeitig genutzt werden. Die dadurch entstehenden Schreibzyklen würden die SSD unnötig belasten.

Deduplizierung bedeutet, dass die Speicherblöcke auf dem Filesystem verglichen werden und gleichartige Blöcke wie ein Block behandelt werden. Bei einem Duplikat wird dann lediglich noch ein Verweis zum originalen Block erstellt.

Ich habe hier bei mir zu Hause nur einen ESX und leider keinen Hyper-V-Server, lediglich einen Hyper-V auf einem Windows-Client. Deshalb dachte ich von Anfang an das würde nicht klappen, aber weit gefehlt. Ich kann einfach den Windows-Client mit der Hyper-V Rolle hinzufügen und die dort installierten VMs sichern. Das ist super und liegt hiermit auch vor der Backuplösung von Synology.

Ansonsten läuft die Sicherung nach Schema F ab. Snapshot der VM erstellen à Daten wegkopieren à Snapshot löschen. Das Ganze noch gekoppelt mit einem Change Block Tracking sorgt dafür, dass nach dem initialen Backup nur noch die geänderten Blöcke gesichert werden. Dadurch wir die Sicherungszeit massiv reduziert. Das ist aber Standard und wird bei jeder auf Snapshot basierenden Sicherungslösung so durchgeführt.

Hier kann man sehr schön sehen, wie die Deduplizierung arbeitet. In 4 Tagen Woche habe ich 1,61 TB an Daten gesichert. Der belegte Speicherplatz für alle Sicherungen auf dem Datenstore ist aber nur 426,12 GB. Somit wurde durch die Deduplizierung 73% Speicherplatz eingespart. Mein Backup-Volume hat nur 1 TB an Kapazität, dieses hätte ich ohne die Deduplizierung schon beinahe überschritten.

Generell werden alle Sicherungen nach der ersten initialen Sicherung nur noch inkrementell übertragen.

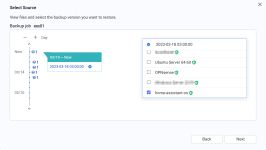

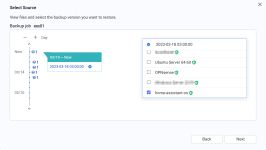

Aber jeder gute Backup-System benötigt auch eine Möglichkeit die Daten wiederherzustellen. Hierzu öffnet man einfach im Inventory den gesicherten Server, wählt eine der gesicherten VMs aus und startet dann über das 3-Punkte-Menü des entsprechenden Jobs die Wiederherstellung. Hier kann man nun an einem Zeitstrahl den Sicherungszeitpunkt auswählen und noch einmal die gewünschte VM anhaken. Man erhält nun eine Übersicht welche VM wo hin wiederhergestellt werden soll.

Ergänzt wird die Abfrage durch einen Zeitplan und ob die VM überschrieben oder unter anderem Namen wiederhergestellt werden soll.

Ich hatte auch sehr viele nicht nachvollziehbare Fehler bei den Backups, die ich auch leider nicht genauer untersuchen konnte, da entsprechende Logeinträge nicht vorhanden waren. So war nicht herauszulesen ob ggfs. der Snapshot nicht erstellt werden konnte, die Festplatten ausgelastet waren oder andere Probleme. Es steht lediglich da: „Error“. Hier würde ich mir gerne detaillierte Informationen wünschen um dem Error auch nachgehen zu können.

Eine Wiederherstellungsmöglichkeit einzelner Dateien existiert leider auch nicht. Hier muss ich sagen, dass die Backup-Lösung von Synology besser abschneidet.

QSync beherrscht außerdem das von OneDrive bekannte „Files-on-Demand“, um lokal Speicherplatz einzusparen, indem Dateien nur dann heruntergeladen werden, wenn diese auch benötigt werden. Anderenfalls findet sich auf dem Datenträger nur ein Platzhalter. Dadurch wird kein Speicherplatz benötigt, die Datei kann aber wie eine normale Datei behandelt werden. Ich habe damit begonnen sämtliche Daten, die ich sonst auf einem Netzlaufwerk vorhalten würde, in die Sync-Lösung zu überführen. Und sollte der Platz auf meinem Laufwerk im PC einmal eng werden so kann über das Kontextmenü der Speicher wieder freigegeben werden. Die Daten bleiben dann auf dem NAS aber weiterhin verfügbar.

Bei der Verbindung von QSync mit dem NAS kann man dies entweder im lokalen LAN mit der IP-Adresse des NAS herstellen, oder man geht über die QNAP-Cloud und hat dann auch einen Weg von extern zum Synchronisieren der Daten. Das ist vor allem dann praktisch, wenn man häufig mit dem Laptop unterwegs ist.

Ein zusätzlicher Pluspunkt ist die Versionierung der Dateien. Damit werden von den Dateien automatisch Versionen angelegt sollte sich etwas daran verändern. Wenn man dann feststellt, dass die Änderung falsch war, kann man über die Versionsverwaltung einfach die alte Version wiederherstellen. ABER: Die Versionsverwaltung funktioniert nicht für Freigabeordner, die im Zuge der Einrichtung des NAS erstellt wurden, sondern nur für den Standard QSync Ordner, der angelegt wird, wenn man die App zum ersten Mal einrichtet. Ist Sie aber vorhanden können die vorherigen Versionen einfach über die FileStation aufgerufen werden.

Allerdings sollte man im Hinterkopf behalten, dass diese Versionen auf Dauer einiges an Speicher belegen können, da sie ähnli8ch funktionieren wie ein Snapshot, den man aber nicht wegwirft. So können je nach Anzahl und Größe der Dateien schnell mal 100GB an Daten zusammen oder mehr.

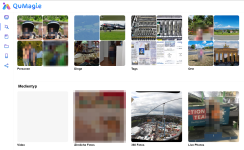

Das komplette Einlesen meiner 67712 Fotos und 2211 Videos hat ca. 4 Tage gedauert. Man sollte sich also etwas Zeit einplanen bei der Erkennung durch die Software.

In der Zeitleiste werden alle Fotos und Videos an einem Zeitstrahl ausgerichtet. Damit hat man einen schnellen chronologischen Überblick über die Bilder.

Die Erkennung ist ebenfalls sehr zuverlässig und ich habe auf die Schnelle keine „falschen“ Erkennungen wie z.B. Comic-Charaktere gefunden. Personen auf Geldscheinen wurden ebenfalls als solche erkannt.

Bei den Objekten hat sich die KI schon etwas schwerer getan und z.B. eine Tafel Schokolade als Flugblatt erkannt. Oder eine Giraffe als Eule eingeordnet hat. Vielleicht braucht es hier noch ein paar tausend Bilder um die KI besser zu trainieren. Selbst mein Sohn wurde mal als Katze, als Eule oder als Kaninchen erkannt. Und nein, er hatte nie ein passendes Kostüm dazu an 😊

Eine Ordneransicht ist ebenfalls vorhanden. Hier werden die Ordner in derselben Struktur dargestellt wie auf dem Dateisystem. Hilfreich für alle, die gerne ihre eigene Ordnung beibehalten möchten.

Es lassen sich ebenfalls eigene Alben erstellen und benennen, per Link kann das erstellte Album mit externen Personen, wie Familie oder Freunde, geteilt werden. Man kann das freigegeben Album ebenfalls mit einem Passwort versehen, wenn nicht ganze Welt auf die Bilder Zugriff haben soll.

Auch kann man ein geöffnetes Bild noch im Nachgang drehen, sich die EXIF-Informationen dazu anzeigen lassen, einen Personenmarkierung ein- bzw. ausschalten und natürlich das Bild löschen.

Leider dauert die Zuweisung der Namen zu den Personen sehr lange. Für eine Person mit ca. 5000 Fotos hat es mehr als 15 Minuten gedauert. Dabei wurden die Fotos ja schon entsprechend erkannt und eingeordnet, es wird nur noch der Name darübergelegt, also quasi der „virtuelle Ordner“ umbenannt. Das sollte aus meiner Sicht deutlich schneller gehen. Bei der Geschwindigkeit wird die Ersteinrichtung ein bisschen zur Qual, wenn man immer pro Person mehrere Minuten warten muss. Bei mir wurden 2270 Personen erkannt (sicherlich auch viele doppelt, diese müssen dann gemerged werden). Wenn ich auch nur mit 2 Minuten pro Person rechne, dann dauert mich das ganze über 4000 Minuten bzw. grob 2,5 Tage am Ball bleiben und benennen. In Arbeitstagen wären das etwas über 7 Arbeitstage. Auch hat nach dem Benennen der Personen kein automatischer Reload stattgefunden, so dass ich erst nach einem manuellen Reload der Seite weiß, ob die Zuweisung erfolgreich war.

Hier kann QNAP sicher noch etwas nachbessern und die Performance erhöhen. Auf meinem Synology habe ich ebenfalls die Zuweisung der Personen vorgenommen, das hat bei einer Person mit über 5000 Bildern nur wenige Sekunden gedauert und wurde direkt angezeigt. Es ist also möglich.

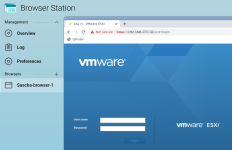

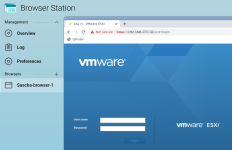

Den erstellten Browsern kann man auch eigene Namen zuweisen und so etwas Ordnung schaffen. Jede Sitzung ist wie ein eigenes Browserprofil in einem Browser eurer Wahl, man könnte damit z.B. auch 3 verschiedene WhatsApp Web Sitzungen öffnen (sofern man so viele Nummern hat 😊).

Es lassen sich beliebig viele Browser starten, so lange bis der RAM oder die CPU nicht mehr hinterherkommt. Bei ca. 500MB pro Browsersitzung wird das aber recht schnell der Fall sein.

Dennoch finde ich die Möglichkeit perfekt, wenn man keinen PC im internen Netzwerk hat oder der PC ausgefallen ist. So erhält man immerhin noch weiter Zugriff auf die internen Webdienste.

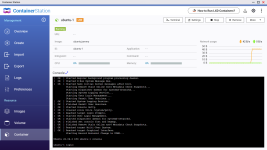

Der Vorteil der Virtualisierung ist, dass man ein Programm oder Server restlos wieder entfernen kann, da keine Änderungen am System vorgenommen werden. Möchte man beispielsweise eine Datenbankserver testen, kann man sich das Image herunterladen, die Datenbank starten und alles darin testen und nach Abschluss das Image einfach wieder entfernen.

Kurz zu den Unterschieden von LXD zu Docker: ein LXD-Container ist ein System Container, bedeutet hier wird ein komplettes Betriebssystem darin virtualisiert. Docker Container sind Application Container, hier werden lediglich die Prozesse verpackt. Eine gute Beschreibung dazu findet sich hier: Klick

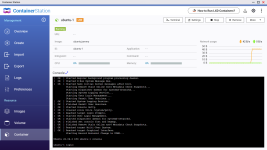

Hier kann man unkompliziert aus den vorgeschlagenen Apps auswählen oder sich einfach eine App suchen, installieren klicken und kurz warten. Natürlich können die Container noch den eigenen Wünschen angepasst werden, aber ein Ubuntu als LXD-Container ist innerhalb von ca. 10 Sekunden fertig heruntergeladen und gestartet.

Einfacher kann man wirklich keine Systeme bereitstellen. Die erstellten Container können auch exportiert werden, um diese auf anderen x86 Systemen wieder bereitzustellen. Hier werde ich in naher Zukunft versuchen die hier erstellten Container in Proxmox zu importieren und vice versa.

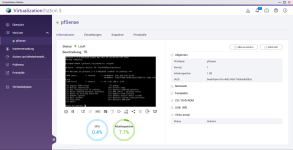

Hier dauert die Erstellung einer Maschine deutlich länger als bei den Containern, dies liegt aber in der Natur der Sache selbst. Ein komplettes Betriebssystem benötigt deutlich mehr Ressourcen, dafür ist es aber auch komplett losgelöst vom darunter liegenden Betriebssystem.

Die hier erstellte VM kann man nun genauso nutzen wie einen nativ installierten Rechner, allerdings mit einigen Vorteilen wie Ressourcenanpassungen (CPU, RAM, Disk), Snapshoterstellung, Remotezugriff auf den Monitor, BIOS-Einstellungen, etc. Eben alle Features die eine Virtualisierung mit sich bringt.

Ein Windows 10 22H2 hat zur Installation ca. 1 Stunde und 10 Minuten vom Start der VM bis zum Login auf dem Desktop benötigt. Danach aber lässt sich die VM ganz normal bedienen, wenn auch etwas träger als man es heutzutage von Rechnern mit SSD gewohnt ist, aber hier geht es eher um eine absolute Notlösung sollten alle anderen Windows-Rechner im Haus ausgefallen sein.

Es gibt auch die Möglichkeit eine bestehende VM von VMware oder als OVA-Datei zu importieren. So könnte man auch bestehende VMs auf das WNAP migrieren.

Das würde ich aber eher für die größeren NAS-Systeme mit deutlich mehr RAM und einer schnellen CPU sowie SSD-Storage empfehlen. Mit dem hier getesteten TS262-4G ist es eher wie schon erwähnt als Notlösung zu sehen, da die Performance nicht sehr überzeugend ist.

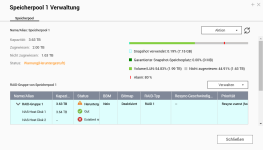

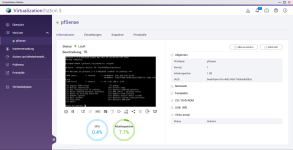

Das habe ich für meine Umgebung durchgeführt und von dem existierenden Storage 1 TB abgezweigt. Aber um den Speicher nicht sofort zu verbrauchen, wurde dieser mit Thin Provisioning bereitgestellt. Das hat den Vorteil, dass nur der Speicher belegt wird, der auch effektiv genutzt wird. Lege ich z.B. 3 VMs mit jeweils 100 GB an, so werden von dem 1 TB nur 300 GB auf dem NAS belegt.

Es gibt auch noch die Möglichkeit des Thick Provisioning, welches etwas performanter ist. Im Unterschied zum Thin Provisioning wird hierbei der gesamte Speicher allokiert und der angeschlossene Client muss nur noch die Daten kopieren. Beim Thin Provisioning kommt hier bei jedem Schreibvorgang noch ein weiterer Schritt hinzu, da der Speichercontainer immer zuerst um einen gewissen Speicherbereich vergrößert werden muss bevor darauf geschrieben werden kann. Bildlich kann man sich das so vorstellen, wie wenn man ein Backup über mehrere DVDs brennt. Hier kann man entweder regelmäßig DVDs nachlegen (Thin Provisioning), was das Schreiben generell verlangsamt, oder man schreibt die Daten auf eine Blu-ray-Disc (Thick Provisioning) und kann die Daten am Stück durchschreiben. Wenn ich nun aber nur 6 GB benötige ist der restliche Platz einer Blu-ray verschenkt, während ich bei den DVDs lediglich 2 Discs genutzt habe und weniger Platz verschenkt habe. Das Beispiel ist vielleicht etwas weit hergeholt, spiegelt aber die Unterschiede sehr gut wieder denke ich.

Natürlich habe ich auch Performancetests durchgeführt und kann mich in keiner Weise beklagen. Auch wenn ich nur ein 1 Gbit/s Netzwerk hier zu Hause habe ist die Performance nie signifikant eingebrochen.

Ein komplett frisch installiertes Windows war noch ca. 25 Minuten fertig installiert und der Desktop geladen. Ein weiterer Start der Windows-VM dauerte ca. 50 Sekunden. Für einen Speicher, der über das Netzwerk angebunden ist, ist dies ein ordentlicher Wert.

Meine Testdaten sind einmal 1 Datei mit ca. 10GB und dann nochmal 13524 Dateien mit insgesamt ca. 130GB.

Die 10GB liefen mit durchschnittlich 116 MB/s auf die Festplatte mit Peaks bis ca. 166 MB/s und hat ca. 1,5 Minuten gebraucht.

Die 13524 Dateien haben natürlich etwas länger gebraucht, hier lagen die Transferraten bei durchschnittlich 11,5 MB/s mit Peaks bis hin zu 60 MB/s, was an der Menge der Dateien liegt. Der Transfer für diese Menge hat ca. 4,5 Stunden gedauert.

Alles in allem kann die USB-Performance auf jeden Fall überzeugen. Das ist vor allem deshalb interessant, weil es dann mittels Hybrid Backup Sync die Möglichkeit hat die Daten auch eine USB-Platte zu sichern.

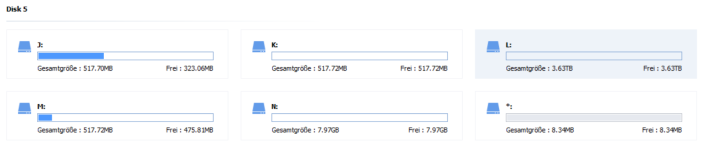

Die Platte habe ich dann direkt an meinen PC angeschlossen. Hier sieht man wie die Festplatte partitioniert wurde.

Interessanterweise wurde die ext4 Partition nicht als solche erkannt, sondern hier als „unformatiert“ angezeigt.

Danach habe ich alle Partitionen darauf gelöscht, die Platte als NTFS umformatiert und sie danach einfach wieder zurück in das Gerät gesteckt.

Nach ein paar Sekunden hat das NAS die Festplatte wieder erkannt und mir mit 3x Piepsen mitgeteilt, dass die Festplatte erkannt wurde. Nach weiteren ca. 30 Sekunden gab es noch 3 Piepser, die den Start der RAID-Synchronisation mitgeteilt haben. Das NAS hat also eigenständig damit begonnen den RAID zu reparieren ohne manuellen Eingriff. Das ist super gelöst aus meiner Sicht da man sich nicht mit der Materie beschäftigen muss. Während der Zeit der Resyncs war das NAS etwas langsamer als üblich, da ein Teil der Festplatten IO für den Rebuild der RAIDs genutzt wurde. Die Priorität des Resync kann man mit der App Speicher & Snapshots einstellen. Der Resync läuft bei mir mit ca. 150-160 MB/s und dauert angeblich nur etwas mehr als 6 Stunden.

Alles in allem kann ich sagen: Das Szenario eines Plattenausfalls ist aus meiner Sicht perfekt gelöst. Die Daten sind dabei weiter verfügbar durch die Spiegelung der Daten und der Rebuild des RAIDs funktioniert problemlos. Ich habe aber auch nichts anderes erwartet, da genauso auch der Austausch einer Festplatte vorn statten geht, sollte diese wirklich einmal defekt sein.

Dazu habe ich ca. 300GB mit unkomprimierten TS-Files kopiert, eingescannt und mit anschauen losgelegt.

Beim Streamen habe ich darauf geachtet, dass die Medien auch wirklich transkodiert werden. Das klappt erstaunlich gut und die Videofiles laufen ohne Probleme über den Monitor. Während der Pufferung verbraucht dabei ein in 1808i aufgenommenes Video und zu 1080p transkodiertes Video ca. 20% CPU-Leistung. Damit sind also ohne Probleme mindestens 5 paarallele Streams möglich. Das reicht auch für eine kleine Familie.

Das bedeutet auch dass ich das QNAP ohne Probleme als neuen Plex-Server einsetzen kann und mein Synology davon erlösen kann, damit es sich um die anderen Aufgaben wie Backup und dergleichen kümmern kann.

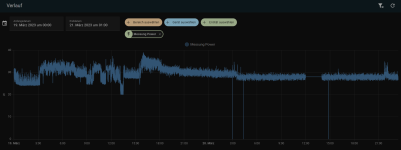

Leider kann ich diese Werte nicht nachvollziehen und auch nicht messen. Ich habe dazu einen Strommesser angeschlossen und in mein Smart Home eingebunden, damit ich den Verbrauch im Testzeitraum auswerten kann. Den Zähler habe ich dazu vorher genullt.

Folgende Werte sind dabei herausgekommen:

Mit diesem Verbrauch wird das NAS aber vermutlich nächtlich ausgeschaltet und nur tagsüber aktiviert.

Besonders gut hat mir die Möglichkeit der Erweiterung und zwei NVMe SSDs gefallen, da sich damit das NAS in vielen Fällen, vor allem beim Lesen, deutlich beschleunigen lässt im Vergleich zum reinen Plattenzugriff. Auch die Option eine PCIe Karte nachzurüsten, finde ich super, da man so z.B. einen weiteren Netzwerk Port, mehr USB-Ports oder andere Dinge nachrüsten kann. Mit dem HDMI-Ausgang und dem hier nicht getesteten Ubuntu als Ausgabesystem kann man zusammen mit einer Maus/Tastatur Kombination aus dem NAS einen vollwertigen Rechner machen. Auch der HybridMount finde ich eine perfekte Lösung, mit der man alle seine Cloud-Dienste zentral auf dem NAS verwalten kann und auch die Daten von A nach B schieben kann ohne sich um ein Multi-Cloud-Abo zu kümmern, dass die Arbeit übernehmen würde.

Aber wo Licht ist, ist bekanntlich auch Schatten. Ein paar Dinge haben mit leider nicht so gut gefallen. Auch wenn es etwas Subjektiv klingen mag, aber die meisten Oberflächen haben auf mich einen etwas angestaubten Eindruck gemacht, da diese von der Aufmachung eher an die Webseiten von vor 10 Jahren oder älter erinnern. Auch dass viele der Apps, selbst direkt aus der Systemsteuerung heraus, in eigenen Fenstern geöffnet werden hat mich am Ende dann doch etwas genervt. Auch von der HD Station war ich leider etwas enttäuscht, ich hatte mir etwas mehr erwartet außer Links, die einen veralteten Chrome öffnen, in dem man sich dann wieder an seinem NAS anmelden muss, obwohl man direkt darauf arbeitet. Und dass ich mit dem Hybrid Backup Sync keine Cloud-Konten verbinden konnte, ist schade, dass lässt sich aber sicher gemeinsam mit dem Support lösen. Auch eine Erweiterung des Arbeitsspeichers wäre noch super gewesen, da 4GB in manchen Fällen doch etwas eng werden, vor allem wenn man auch Docker Container auf dem NAS betreiben möchte.

Alle in Allem aber hat QNAP hier ein solides Multimedia-NAS auf die Beine gestellt, mit dem man seine Musik, Bilder und Filme sortieren und anschauen kann. Durch den SSD-Cache läuft das auch sehr flott ab und man hat so gut wie keine Wartezeit. Auch PCIe Karten lassen sich problemlos nachrüsten und der HDMI-Ausgang schafft 4K bei 60Hz ohne Probleme. Damit ist das NAS einsatzbereit für einen Platz in der Nähe meines Fernsehers.

Vielen Dank an dieser Stelle noch einmal an die Hardwareluxx Media GmbH und QNAP-Systems, Inc. für die großartige Hardware und die Möglichkeit dieses Reviews. Ich hatte sehr viel Spaß mit den Tests und werde auch in Zukunft weiterhin meine Freude damit haben.

Euer Sascha (Man-in-Black)

vielen Dank für die Möglichkeit, das QNAP NAS ausgiebig testen zu dürfen.

Ich habe eine kleine Navigationshilfe in Form eines Inhaltsverzeichnisses erstellt mit Sprungmarken zu den einzelnen Kapiteln.

Ein bisschen was zu mir

Begonnen hat mein Weg in der IT im Alter von 8 Jahren. Dabei hat mich meine IT-Laufbahn über meinen ersten PC mit 10 Jahren, kurze Ausflüge in die Linux-Welt, meinen ersten selbst zusammengebauten Rechner, ein Studium in technischer Informatik inkl. Abschluss geführt und schlussendlich habe ich mein Hobby zum Beruf gemacht und bin nun seit über 14 Jahren hauptberuflicher Systemadministrator. Dabei konnte ich mein Wissen in vielen Gebieten der IT vertiefen.In meine Bewerbung habe ich zudem noch folgendes geschrieben:

Mein Name ist Sascha, ich bin 36 Jahre jung, habe Frau und zwei Kinder und als Systemadministrator mein Hobby zum Beruf gemacht.

Schon als Kind haben mich Computer begeistert und so habe ich seit meinem 10. Lebensjahr einen eigenen Computer. Dabei habe ich auch einige Tiefs durchlebt, bei denen mir aber mein Vater immer geholfen hat (Windows zerstört, eine CPU falsch eingebaut, usw.). Deshalb habe ich das Ganze dann später auch als AG in der Schule belegt und danach noch ein Studium in der technischen Informatik absolviert. Seit 2008 bin ich hauptberuflich Systemadministrator und durfte in der Laufbahn viele spannende Projekte in vielen Bereichen durchführen: Firewalls, Netzwerke, VMware, Windows, Linux, Citrix, Infrastruktur (Strom, Klima, etc.), Storage-Netzwerke, Storage-Administration, ISO- & TÜV-Zertifizierung, Shell-Scripting, usw.

Dokumentationen der Tätigkeiten sind mein tägliches Brot und werden auch immer gewissenhaft durchgeführt und mit Screenshots ergänzt, so dass diese auch allgemeinverständlich sind.

Aber Hobbys wären keine Hobbys, wenn man sich nicht auch in seiner Freizeit damit beschäftigt.

Ich habe mich sehr gefreut, dass ich für den Lesertest ausgewählt wurde, da ich nach viel Erfahrung mit Synology NAS Geräten nun endlich mal ein QNAP testen darf. Hier hat sich seit meinen letzten QNAP-Berührungspunkten vor über 10 Jahren denke ich einiges getan. Umso mehr freue ich mich darauf nun direkt mit dem Test loslegen zu dürfen.

QNAP TS-262-4G

Technische Daten

| CPU | Intel® Celeron® N4505 2-Core/2-Thread Prozessor, Turbo bis zu 2,9 GHz |

| CPU-Architektur | 64-Bit x86 |

| Grafikprozessor | Intel® UHD Graphics |

| Verschlüsselungsengine | AES-NI |

| Hardware-beschleunigte Transkodierung | Ja |

| Arbeitsspeicher | 4 GB RAM |

| Maximaler Arbeitsspeicher | 4 GB |

| Flash-Speicher | 4GB (Dual Boot OS Schutz) |

| Laufwerksschacht | 2 x 3,5-Zoll SATA 6Gb/s |

| Laufwerkskompatibilität | 3.5-inch SATA hard disk drives 2.5-inch SATA solid state drives |

| Hot-Swap-fähig | Ja |

| M.2 Steckplatz | 2 x M.2 2280 PCIe Gen 3 x1 |

| Unterstützung für SSD-Cache-Beschleunigung | Ja |

| 2,5 Gigabit Ethernet Port (2,5G/1G/100M) | 1 (2,5G/1G/100M/10M) |

| PCIe-Steckplatz | 1x PCIe Gen 3 x2 |

| USB 2.0 Port | 2 |

| USB 3.2 Gen 2 (10 Gbit/s) Port | 2 x Typ-A |

| IR-Sensor | (Optionale QNAP RM-IR004 Fernbedienung) |

| HDMI-Ausgang | 1, HDMI 2.0 (bis zu 4096 x 2160 @ 60Hz) |

| Netzteil | 65W Netzteil, 100-240V |

| Stromverbrauch: Festplattenruhezustand | 8,198 W |

| Stromverbrauch: Betriebsmodus, typisch | 12,448 W - Getestet mit vollständig bestückten Laufwerken. |

Unboxing & Aufbau

Das QNAP NAS wurde in einem großen Karton geliefert, den die liebe DHL, ohne zu klingeln, direkt in die Filiale gebracht hat ☹. Meine Frau hat das Paket dankenswerterweise für mich am Folgetag abgeholt. Alles nur damit ich gleich mit den Tests anfangen kann 😊.In dem großen Paket waren 2 Pakete vorhanden, eines mit den von Hardwareluxx gesponsorten 2x WD RED Plus 4 TB Festplatten sowie der Originalkarton mit dem eigentlichen NAS. Beides, sowohl die Festplatten als auch das NAS waren super verpackt mit genügend Schutzmaterial.

Folgende Inhalte lagen dem Paket außerdem noch bei:

- 1x QNAP TS-262-4G

- 1x 65W Netzteil

- 1x Kaltgerätekabel

- 1x CAT.5e Netzwerkkabel

- 8x kleine Schrauben für 2,5‘‘ Festplatten

Das NAS selbst kommt in einem weißen Grundkörper mit goldenen Applikationen. Damit soll das Gerät auch dafür geeignet sein, um es z.B. direkt neben den Fernseher im Wohnzimmer aufstellen zu können.

An der Vorderseite kann man klein geschrieben das Firmenlogo lesen und findet außerdem die Status-LEDs für Power, Netzwerk, Copy & die beiden HDDs sowie 2 kleine Knöpfe, einmal den Powerbutton und ein USB-Copy-Button. Ein USB 3.2 Gen 2 Port.

Auf der Rückseite befinden sich der Netzteilanschluss, ein 2,5 Gbit/s Netzwerk Port, 2 USB 2.0 Ports, ein USB 3.2 Gen 2 Port, ein HDMI-Port und der obligatorische Kensington Lock.

Innen findet man wie bei vielen 2-bay NAS-Systemen die beiden Festplattenkäfige, in die sich sowohl 3,5 Zoll als auch 2,5 Zoll Festplatten einbauen lassen. Für letztere kann man die mitgelieferten Schrauben nutzen. 3,5 Zoll Festplatten lassen sich mit dem einfachen Klicksystem einfach einsetzen. Dazu werden die Festplatten in die Festplattenkäfige eingelegt und dann einfach mit den Klemmen befestigt.

Hat man beide Festplattenkäfige entfernt kann man einen Blick auf die Backplane mit den 2 SATA-Ports erhaschen. Außerdem sieht man auf dem Mainboard die beiden Slots für die NVMe SSDs im M.2 Format, die allerdings nur mit PCIe Gen 3 x1 angebunden sind und damit nur ca. 1 GByte/s an Durchsatz liefern.

Für den Arbeitsspeicher gibt es keinen Erweiterungsslot und damit auch keine Erweiterungsmöglichkeit.

Die Erweiterungsmöglichkeit mittels eine PCI-Karte mit PCIe Gen 3 x2 angebunden ist und damit ca. 16 Gbit/s an Durchsatz schafft finde ich eine klasse Sache. Allerdings kann dort leider nicht jede Karte verbaut werden, da die Blende zwar Low-Profile ist, allerdings am Montage-Ende gerade sein muss und nicht wie üblich um 90° geknickt.

Die Festplatten von Western Digital, in diesem Fall die WD Red Plus 4TB stelle ich hier nicht explizit vor, da der Fokus auf dem NAS liegt. Außerdem wurden die Festplatten schon anderswo ausgiebig getestet, so wie ich es vermutlich nie hinbekommen würde 😊, z.B. hier: Western Digital Red Plus, 4 TB, WD40EFZX im Test. WDs aktuelle Red Plus mit Luft. – Firebls wunderbare Welt der Hardware (fireblsblog.de).

Inbetriebnahme

Installation

Für die Inbetriebnahme muss das NAS angeschlossen werden. Hierbei reichen der Strom und ein Netzwerkkabel. Das NAS benötigt ein paar Gedenksekunden und meldet sich dann mit mehreren Piep-Geräuschen. Sobald das NAS 2x mal piepst ist es hochgefahren und bereit zur Einrichtung. Das hat bei mir ca. 1 Minute gedauert.Die Installation des NAS gestaltet sich denkbar einfach. Hierbei gibt es 2 Varianten:

- Installation über die Cloud

- Lokale Installation im eigenen LAN

Installation über die Cloud

Auf der Seite des NAS befindet sich ein kleiner Sticker mit einem QR-Code. Wenn man diesen scannt, landet man direkt auf der Seite von QNAP. Die Seite kann natürlich auch am PC geöffnet werden, das Schema ist immer das folgende: https://service.qnap.com/de-de/install/[Seriennummer]@?#[Seriennummer].Hierbei startet sich ein Webassistent, bei dem man im weiteren Verlauf auf die myQNAPcloud umgeleitet wird.

Hier ist nun allerdings ein Cloud Account nötig, um die Einrichtung weiter durchführen zu können. Ich selbst bin ein Freund dieser Cloud-Anbindungen, da man so auch von extern auf das NAS zugreifen kann, ohne einen Port auf dem Router bzw. der Firewall öffnen zu müssen. Sollte man das später nicht mehr wollen kann der Zugang auch einfach wieder deaktiviert werden.

Im nächsten Schritt vergibt man nun einen eindeutigen Namen für das NAS, mit dem es später auch über myQNAPcloud-Adresse erreichbar sein wird.

Klickt man sich weiter durch den Assistenten kommt man irgendwann an die Stelle, an der man die entsprechende QTS-Version auswählen soll. QTS ist das Betriebssystem für die QNAP-NAS-Modelle.

Im folgenden Schritt muss noch der Systemname für das NAS, ein Benutzername und ein Kennwort vergeben werden. Damit wird der erste Admin für das NAS angelegt mit dem man sich auch nach der Fertigstellung der Installation direkt anmelden kann.

Die restlichen Schritte sind weitestgehend selbsterklärend: Zeit einstellen, IP-Adresse vergeben (DHCP oder statisch), Zusammenfassung prüfen, Initialisierung starten.

Die Initialisierung hat bei mir ca. 8 Minuten gedauert. Das Ganze lief bei meinem Synology-NAS etwas flotter (3:30 Minuten), ist aber dennoch aus meiner Sicht im Rahmen.

Nach Ablauf der Zeit befindet man sich im Anmeldefenster und kann sich mit dem vorher angelegten Admin-Account einloggen.

Lokale Installation im eigenen LAN

Entscheidet man sich für die Installation ohne die Cloud Funktionen ist der Ablauf fast der gleiche.Allerdings wird für die lokale Installation eine Software mit dem Namen Qfinder pro benötigt, um das NAS im lokalen Netzwerk aufzuspüren und sich damit zu verbinden.

Ansonsten läuft die Installation ähnlich ab, außer dass die die Punkte für das myQNAPcloud Konto wegfallen. Bedeutet man startet direkt mit der Auswahl des Betriebssystems. Die Schritte dazu können im Detail einen Punkt weiter oben nachgelesen werden.

Netzwerk

Die Grundeinrichtung ist nun abgeschlossen und es ist Zeit das NAS an die persönliche Netzwerkumgebung anzupassen.Ich habe mich dazu entschlossen dem NAS eine statische IP-Adresse außerhalb des DHCP-Bereiches meines Routers zu geben. Dazu startet man die App „Netzwerk- und virtueller Switch“ > Virtueller Switch und klickt dann in der Mitte auf das 3-Dot-Menü und wählt dort konfigurieren aus.

Hier wird man nun von einem Wizard durch die Netzwerkkonfiguration begleitet und kann die gewünschten Daten hinterlegen.

Portbündelung

Mit einer Portbündelung lassen sich mehrere physikalische Netzwerkanschlüsse zu einem logischen Anschluss verbinden. Der Vorteil dabei ist, dass man eine Ausfallsicherheit erhält, sollte aus unbekannten Gründen ein Kabel rausrutschen und die Bandbreite erhöht mit einer weiteren Karte um das doppelte, so dass theoretisch Übertragungsgeschwindigkeiten von 5 Gbit/s möglich sind (bei 2x 2,5 Gbit/s Netzwerk-Adaptern).Da das QNAP TS-262-4G nur einen Netzwerk-Anschluss hat kann hier ohne eine zusätzliche Karte keine Portbündelung eingerichtet werden. Ich habe mir extra dafür eine solche Karte besorgt (diese landet später dann in meinem PC) um die Portbündelung testen zu können.

Die Einrichtung gestaltet sich denkbar einfach. Man verbindet beide Netzwerkanschlüsse des NAS mit einem oder auch mit unterschiedlichen Switchen und öffnet wieder die App „Netzwerk- und virtueller Switch“ und wählt unter Schnittstellen rechts oben den Punkt Portbündelung aus.

Hier wird man nun wieder von einem Wizard begleitet.

- Netzwerkkarten auswählen

- Switch-Typ auswählen

- NSA-Direktverbindung (für JBODs gedacht)

- Allgemeiner Switch

- Verwalteter Switch mit LACP

- Bündelungsmodus

- Active-Backup

- Balance-tlb

- Balance-alb

Das Ergebnis sieht dann wie folgt aus:

myQNAPcloud

Mit der myQNAPcloud ist ein einfacher Zugriff auf das QNAP-NAS über das Internet möglich, ohne wie oben schon erwähnt einen Port auf dem Router oder der Firewall öffnen zu müssen.Alle Einstellmöglichkeiten dazu findet man in der gleichnamigen App myQNAPcloud. Hier lässt sich die über einen Wizard die Verbindung des NAS mit der Cloud herstellen. Der Wizard besteht aus 5 Schritten, in denen man sich zuerst an der Cloud anmeldet (und ggfs. einen Account erstellt), einen Namen für das QNAP NAS vergibt, die Dienste und Berechtigungen vergibt und etwas wartet.

Hat man die myQNAPcloud eingerichtet kann man noch ein Zertifikat mittels Let’s Encrypt installieren und den myQNAPcloud Link einrichten, mit dem man von extern auf das NAS ohne Portfreigabe zugreifen kann.

Hat man alles eingerichtet sieht das Dashboard wie folgt aus:

Ergänzend möchte ich noch erwähnen, dass bei einer Verbindung über den DDNS-Namen an erster Stelle versucht eine Direktverbindung zwischen dem User und der QNAP herzustellen. Dies ist aber nur an Anschlüssen mit einem IPv4 oder IPv6 bzw. Dual Stack möglich. Bei einem Dual Stack Lite wird die Verbindung über die QuickConnect Server aufgebaut, natürlich SSL-verschlüsselt.

Storage-Einrichtung

Nun kommen wir zum wichtigsten Punkt, bei dem aus dem NAS endlich ein NAS wird: Der Einrichtung der Festplatten.Damit die NAS genutzt werden kann, muss aus den Festplatten zuerst ein Speicherpool erstellt werden, in den man im Anschluss das oder die Volumes platzieren kann. Die Einrichtung dazu wird mit der App Speicher & Snapshots durchgeführt. In dieser App kann man sich auch die verbauten Festplatten und deren Zustand anschauen sowie einen Leistungstest durchführen.

Die Erstellung eines Speicherpools sollte man gewisser Weise planen, da QNAP einem mehrere Optionen zur Wahl lässt:

- Nutzung der Auto-Tiering Funktion QTier

Mit QTier können Sie einem Speicherpool verschiedene Arten von Laufwerken (SSD, SAS, SATA) zufügen. Häufig abgerufene Daten werden automatisch auf schnellere und weniger aktive Daten auf langsamere Laufwerke mit höherer Kapazität verschoben. - Auswahl der Festplatten und des RAID-Typs

Bei dem hier genutzten NAS würde ich auf jeden Fall den RAID 1 nutzen, um die Datensicherheit zu gewährleisten. - Reservierter Snapshot-Speicher

Dieser Speicher wird fest reserviert für die Snapshot-Funktion und steht nicht als Speicher zur Verfügung.

Nach der Erstellung des Storage-Pools wird man wiederum mit einem Wizard durch die Erstellung des ersten Volumes geführt. Bei einem Volume kann man auswählen zwischen folgenden Einstellungen:

- Speicherplatz nach Bedarf

- Bietet flexible Speicherplatzverwaltung, wenn Sie mehrere Volumes erstellen müssen

- Geeignet zum Erstellen von Snapshots zur Verbesserung der Datensicherheit

- Vorkonfigurierter Speicherplatz

- Der Speicherplatz wird für eine bessere Zugriffsleistung vorab zugeordnet

- Kann später erweitert werden, um mehr Daten aufzunehmen

- Traditionelle Konfiguration

- Direkt auf einer RAID-Gruppe erstellt

- Unterstützt keine erweiterten Speicherpoolfunktionen wie Snapshot-Schutz oder LIJNs auf Blockebene

Dasa hat aber auch einen Nebeneffekt: Man sollte die Speicherauslastung immer im Blick behalten. Durch das sogenannte Thin Provisioning ist es möglich, Volumes mit mehr Speicherplatz anzulegen als das NAS physikalisch zur Verfügung hat. In der hier getesteten Konfiguration sind zwei 4 TB Festplatten verbaut, mit einem RAID1 habe ich ca. 3,83TB zur Verfügung. Nun kann ich allerdings problemlos 8 Volumes mit je 1TB anlegen. Gelange ich aber an den Punkt, dass der Speicher voll ist, kann ich auf den anderen Volumes keine Daten mehr ablegen, obwohl mir noch freier Speicher angezeigt wird.

Beim Thick Provisioning hingegen wird der gewünschte Speicher direkt allokiert und steht nicht mehr für andere Volumes zur Verfügung. Damit kann man hier auch immer Daten ablegen, egal ob der physikalische Speicher durch andere Volumes aufgebraucht wurde oder nicht. Außerdem erhält man eine bessere Festplattenperformance. Das liegt daran, dass hier nicht wie bei der Thin-Variante die Speicherblöcke vor dem Schreiben zuerst allokiert werden müssen.

Weiter im Wizard kann ich nun die Größe angeben und ob ich das Volume verschlüsseln möchte.

Der letzte Schritt besteht nun darin die Snapshots zu aktivieren oder auch nicht. Damit wird in regelmäßigen Abständen ein Snapshot des Volumes erstellt. Dieser sorgt dafür, dass die Daten festgehalten werden und man jederzeit auf diesen Snapshot zurückspringen kann oder Daten aus diesem Wiederherstellen kann, sofern man versehentlich etwas gelöscht hat. Das ist super, wenn man eine große Bildergalerie hat und ggfs. ein wichtiges Bild gelöscht hat. Diese Snapshots lassen sich schnell anlegen, so dauert die Erstellung meistens nur wenige Sekunden. Dennoch sollte man zusätzlich ein Backup der Daten erstellen, denn die Snapshots liegen auf denselben Datenträgern. Sollte diesen etwas passieren wären die Daten trotzdem verloren. Zu den Backups aber später mehr.

Eine Auswahl eines Filesystems gibt es hier nicht, alle Volumes werden ausschließlich mit ext4 angelegt. Das schränkt zwar einige Funktionen ein, allerdings ist ext4 ein langjähriges, stabiles Filesystem.

SSD Cache

Das QNAP TS-262-4G bietet die Möglichkeit, NVMe SSDs als Cache Laufwerke zu nutzen. Dadurch kann sowohl der Lese- als auch der Schreib-Durchsatz deutlich erhöht werden, da die Daten zuerst auf die SSDs geschrieben werden und dann im Hintergrund auf die langsamen HDDs verschoben werden.

Dazu habe ich mir 2 günstige SSDs auf Amazon ohne DRAM-Cache besorgt und diese eingebaut. Die SSDs haben jeweils nur 256GB, das sollte aber als Cache Laufwerk mehr als ausreichend sein, es sei denn man bewegt regelmäßig mehr als 250GB über das NAS. Das sollte aber im normalen Tagesbetrieb nicht der Fall sein.

Der Wizard empfiehlt zwar eine Verteilung von 1:3 (also pro 100GB HDD sollten 33GB SSD-Cache verfügbar sein), das halte ich allerdings für etwas übertrieben.

Mit meinen 2 bestückten NVMe Slots (welche übrigens mit den Clips perfekt gelöst sind, so benötigt man keine Schrauben um die SSD in dem M.2 Slot zu fixieren) habe ich mir also über den Menüpunkt Cache-Beschleunigung einen Lese-/Schreibcache eingerichtet. Dazu werden beide SSDs automatisch mindestens zu einem RAID1 zusammengefasst. Es wäre auch ein RAID0 möglich, aber im Falle des Ausfalls einer der beiden SSDs wären die Daten futsch, bevor diese auf die HDDs geschrieben werden können.

Man wird nun noch nach dem SSD Overprovisioning gefragt und zum Schluss noch für welches Volume der Cache aktiviert werden soll. Ist der SSD-Cache dann aktiviert kann man den Füllgrad sowie die Volumes mit aktiviertem SSD-Cache in einem Dashboard beobachten.

Performance-Tests

Um die Performance des NAS zu prüfen habe ich mich mehrerer Tools und Konstellationen bedient. Dazu zählen unterschiedliche RAID-Typen und unterschiedliche Funktionen, wie Verschlüsselung und SSD-Cache, um deren Auswirkungen auf die Performance zu prüfen.Und da Bilder bekanntlich mehr als tausend Worte sagen, gibt es zu jedem Test auch mind. einen Screenshot.

mit "dd" auf der Konsole

DD ist ein Linux-Befehl, mit dem direkt auf der Konsole Dateien beliebiger Größe erstellt werden können. Dies habe ich genutzt um die Geschwindigkeit der Festplatten ohne Netzwerk und ohne QTS-Funktionalitäten der Volumes zu testen. In der Tabelle seht ihr die genutzten Storage-Typen und ob eine Datei nur mit Nullen (Zero) oder mit zufälligen Werten (Urandom) gefüllt wurde. Als Ergebnis findet sich am Ende noch die abgelaufene Zeit und der Datendurchsatz.Alle Tests wurden im RAID1 und einer Blockgröße von 1K durchgeführt. Jeder Test wurde 5x durchgeführt mit einer Pause von 10 Sekunden zwischen jedem Test und habe den Mittelwert davon gebildet (Excel sei Dank 😊). Die Befehle dazu, falls es ebenfalls jemand testen möchte, waren die folgenden:

- write: dd if=/dev/zero of=test_none_1G.img bs=1K count=1048576

- read ohne HDD-Cache: echo 3 | sudo tee /proc/sys/vm/drop_caches; dd if=test_none_1G.img of=/dev/null bs=1K

- read mit HDD-Cache: dd if=test_none_1G.img of=/dev/null bs=1K

| Funktion | Typ | Größe | Zeit write | Durchsatz write | Zeit read w/o | Durchsatz read w/o | Zeit read w/ | Durchsatz read w/ |

| - | Zero | 1 G | 5,84 s | 171,2 MB/s | 3,95 s | 259,1 MB/s | 0,63 s | 1,6 GB/s |

| - | Zero | 10 G | 68,43 s | 149,6 MB/s | 40,5 s | 252,8 MB/s | - | - |

| - | Zero | 100 G | 692,75 s | 147,8 MS/s | 396,9 s | 258 MB/s | - | - |

| - | Urandom | 1 G | 27,81 s | 36,8 MB/s | 4,04 s | 253,4 MB/s | 0,62 s | 1,6 GB/s |

| Encryption | Zero | 1 G | 5,88 s | 174,5 MB/s | 4,51 s | 227 MB/s | 1,38 s | 1,3 GB/s |

| Encryption | Zero | 10 G | 65,67 s | 155,9 MB/s | 40,97 s | 249,9 MB/s | - | - |

| Encryption | Zero | 100 G | 688,51 s | 148,8 MB/s | 412,59 s | 248,2 MB/s | - | - |

| Encryption | Urandom | 1 G | 28,62 s | 35,9 MB/s | 3,99 s | 256,2 MB/s | 0,63 s | 1,6 GB/s |

| Cache | Zero | 1 G | 2,65 s | 386,7 MB/s | 2,05 s | 1 GB/s | 0,66 s | 1,5 GB/s |

| Cache | Zero | 10 G | 27,33 s | 374,7 MB/s | 24,85 s | 964,8 MB/s | 26,36 s | 919,8 MB/s |

| Cache | Zero | 100 G | 824,75 s | 126,5 MB/s | 314,84 s | 871,9 MB/s | - | |

| Cache | Urandom | 1 G | 28,40 s | 36,1 MB/s | 0,80 s | 1,25 GB/s | 0,65 s | 1,55 GB/s |

| Cache + Encryption | Zero | 1 G | 4,40 s | 267,1 MB/s | 1,94 s | 835,5 MB/s | 1,83 s | 1,3 GB/s |

| Cache + Encryption | Zero | 10 G | 88,32 s | 116,9 MB/s | 28,16 s | 683,7 MB/s | 28,72 s | 711 MB/s |

| Cache + Encryption | Zero | 100 G | 959,52 s | 107,5 MB/s | 318,38 s | 707,1 MB/s | - | |

| Cache + Encryption | Urandom | 1 G | 28,43 s | 36 MB/s | 2,30 s | 767,7 MB/s | 1,74 s | 1,3 GB/s |

In dem Diagramm ist die orangene Linie (linke Reihe) die Übertragungsgeschwindigkeit und die blauen Balken (rechte Reihe) die Zeit in Sekunden.

Mit aktivierter Encryption sieht das Bild sehr ähnlich aus, lediglich die Leseperformance war etwas geringer mit 235,6 MB/s in der Spitze.

Interessanter gestaltet sich ganze, wenn ich die eingebauten SSDs als Cache dazuschalte. Hier ergibt sich auch ein sehr spannendes Bild, je nachdem wie viel ich den SSDs zumute. Ich habe hier recht billige SSDs hergenommen, dazu nachher noch ein Satz dazu.

Schreibe ich nun das 1GB große Test File habe ich Spitzenwerte von 405,5 MB/s, das ist ganze 2,32x so flott. Das funktioniert auch mit den 10GB großen Testfiles noch super. Bei den 100GB Testfiles merkt man aber, dass die Performance der SSDs stark einbricht. Hier konnte ich dann nur noch einen Maximalwert von 155 MB/s verzeichnen, Tendenz zu weniger. Hier bringt der SSD-Cache also nichts. Das liegt aus meiner Sicht an dem ca. 60 GB großen SLC-Cache, der hier verbaut ist. Sobald dieser erschöpft ist, bricht die Performance massiv ein. Bei den Random Schreibzugriffen gibt es keinen Unterschied zu den reinen Festplatten.

Wenn alle Daten auf die SSD geschrieben wurden werden diese natürlich im Hintergrund auf die Festplatten geschrieben. Das kann je nach Menge auf den SSDs etwas Zeit in Anspruch nehmen, da wir hier wieder nur mit den oben gemessenen ca. 170 MB/s insgesamt schreiben.

Beim Lesenden Zugriff merkt man dann aber die Stärken des SSD-Cache. In den Diagrammen sieht man schon, wie der erste Zugriff noch recht langsam ist, alle folgenden Zugriffe dann aber extrem Flott von statten gehen. Gerade bei den Zugriffen auf das 100G File merkt man wie die Geschwindigkeit mit jedem Zugriff zunimmt. Der Erste Lesezugriff dauert noch knapp 20 Minuten bei ca. 90 MB/s, der Zweite Zugriff dauert noch nur noch etwas über 2 Minuten mit fast 600 MB/s und restlichen Zugriffe sind in jeweils 84 Sekunden erledigt bei 1,2 GB/s.

Bei dem Test mit SSD-Cache + Encryption habe ich die Tests mehrfach wiederholt, aber das Ergebnis war immer dasselbe: Die Verschlüsselung fordert hier ihren Tribut und lässt die Schreibleistung selbst bei den 5 Durchläufen von 344 MB/s auf 125,9 MB/s einbrechen.

Beim Lesen allerdings sieht das Bild wieder genauso aus wie ohne Encryption, auch wenn ich hier statt 1,2 GB/s nur auf ca. 900 MB/s komme. Das ist aber schon der ganze Unterschied dabei.

Mein Fazit aus diesen synthetischen Tests: Ich werden den Cache auf jeden Fall nutzen, da er mir im „normalen“ Alltagsbetrieb ein besseres Look-and-Feel für das QNAP beschert. Auch sollten viele der Random-Zugriff schneller über die Bühne laufen. Das wird aber die Zeit erst wirklich zeigen.

Nachtrag: Den SSD-Cache habe ich zwischen jedem Test komplett geleert, damit die Werte nicht verfälscht werden.

Mit schnelleren SSDs wäre sicher ein besseres Ergebnis möglich, vielleicht tausche ich diese noch in Zukunft aus. Aber die SSDs haben mich pro Stück 21€ gekostet, also quasi geschenkt 😊

Einen Test der SSD gibt es bei Tom’s Hardware (zwar die 512GB Variante, aber die sollten sich nicht so viel schenken): 512GB Performance Results - Silicon Power P34A60 M.2 NVMe SSD Review: Mid-Range Performance at Rock-Bottom Pricing | Tom's Hardware (tomshardware.com)

Kopieren auf der Weboberfläche

Ich habe mir auch den Einfluss der Weboberfläche auf die Geschwindigkeiten angeschaut. Hierzu habe ich die bestehenden Testfiles zwischen den einzelnen Volumes hin und her kopiert. Die Ergebnisse habe ich hier in der Tabelle aufgelistet.| # | Quelle | Ziel | Größe | Max. Geschw. (write) | IOPS (R / W) | CPU (System) | CPU (IO wait) |

| 1 | None | Enc | 10 G | 85 MB/s | 183 / 201 | ~ 15% | ~ 66% |

| 2 | Enc | None | 10 G | 86,5 MB/s | 184 / 231 | ~ 10% | ~ 50% |

| 3 | None | Cache | 10 G | 10 GB/s (?) | - | - | - |

| 4 | Cache | None | 10 G | 10 GB/s (?) | - | - | - |

| 5 | None | Cache+Enc | 10 G | to cache: 166 MB/s from cache: 139,7 MB/s | to cache: 385 / 875 from cache: 558 / 279 | ~ 11% | ~ 75% |

| 6 | Cache+Enc | None | 10 G | 1. 67,7 MB/s 2. 135,8 MB/s | 1. 329 / 239 2. 612 (SSD) / 493 (HDD) | 1. ~ 10% 2. ~ 15% | 1. ~ 75% 2. ~ 55% |

| 7 | Cache | Cache+Enc | 10 G | to cache: 182,4 MB/s from cache: 124,4 MB/s | to cache: 447 / 942 from cache: 500 / 250 | ~ 8% | ~ 80% |

| 8 | Cache+Enc | Cache | 10 G | 131,8 MB/s | 723 / 263 | ~ 8% | ~ 70% |

Generell kann man festhalten, dass die Übertragungsraten in alle Richtungen recht ähnlich ausgefallen sind. Das liegt in diesem Test daran, dass ich mich direkt auf dem NAS bewegt habe und hier die Daten von einem Volume auf das andere kopiert habe. Am Ende mussten die Daten aber immer von den HDDs gelesen und auch wieder darauf geschrieben werden.

Lediglich das Kopieren von und auf den Cache war etwas seltsam, da hier selbst ein 100GB großes File innerhalb von 1s fertig kopiert war. Hierzu habe ich leider keine Erklärung und auch wiederholte Tests haben immer wieder das Gleiche erbracht.

Tests im Produktivbetrieb

Die meisten Tests habe ich über mein 1 Gbit/s Netzwerk durchgeführt und ebenfalls die Unterschiede zwischen den unterschiedlichen Volumes angeschaut. Dazu wurde unter anderem ein einziges großes File sowie auch mehrere Kleine Files zwischen dem NAS und dem PC hin und her kopiert.Zusätzlich habe ich mir eine 2,5 GBit/s Netzwerkkarte besorgt und werde hier auch mit einer Direktverbindung die Übertragungsraten prüfen. 2,5 GBit/s ist zwar immer mehr im Kommen, aber die Infrastruktur dazu muss auch passen. Da vermutlich die allermeisten hier im Forum noch kein 2,5 GBit/s Netzwerk flächendeckend besitzen werde ich diesen Test auch kurz und knapp halten und mich auf ein 1 GBit/s Netzwerk konzentrieren.

Ich werde die reinen Transferraten testen mit großen Dateien aber auch mit vielen kleinen Dateien, um die IOS zu testen.

einzelne Datei per Freigabe über das Netzwerk

Für diesen Test wurde eine einzelne, 10 GB große Datei genutzt. Außerdem wurde jeder Test auf von Cache beschleunigten HDDs 3x durchgeführt, um den Cache richtig mit einzubeziehen.Als Pendant in meinem Rechner werkelt eine Samsung 970 Evo mit 512 GB.

| Test | Lesen | Schreiben |

| None | 271 MB/s | 150 MB/s |

| Cache | 1. 103 MB/s 2. 283 MB/s 3. 283 MB/s | 1. 117 MB/s 2. 115 MB/s 3. 123 MB/s |

| Enc | 210 MB/s | 146 MB/s |

| Cache+Enc | 1. 127 MB/s 2. 283 MB/s 3. 283 MB/s | 1. 115 MB/s 2. 121 MB/s 3. 118 MB/s |

Bei den verschlüsselten Volumes sieht es ähnlich aus, nur ist hier die Leseperformance direkt von der HDD nicht so hoch wie ohne Verschlüsselung. Bei den SSDs gibt es keine Veränderung nach ab dem 2. Durchgang.

Etwas enttäuscht hat mich die Schreibe-Performance, diese war ohne SSD-Cache besser als mit. Wie schon weiter oben erwähnt liegt das vielleicht an meinen günstigen SSDs, aber ich wollte hier nicht noch mehr ausgeben für einen Test dessen Ergebnis ich beim Kauf noch nicht kannte.

viele Dateien per Freigabe über das Netzwerk

Ab hier nutze ich wieder mein bestehendes 1 Gbit/s Netzwerk, da es eben das ist was ich zu Hause habe. 2,5 Gbit/s wäre natürlich schöner, aber allein entsprechende 5 Port Switche kosten schon zum Teil über 100€, das ist es mir aktuell noch nicht wert, da ich die Bandbreite theoretisch sowieso nicht benötige.In diesem Test wurde ein Ordner mit einer Größe von 1,4 GB bei 7154 Dateien gewählt. Diese sind unterschiedlich groß, von wenigen KB bis hin zu einigen MB.

Hier ist wie zu erwarten kein konstanter Datenstrom möglich. Hier hätten die 2,5 Gbit/s keinen Mehrwert gebracht.

In der folgenden Tabelle habe ich die Unterschiede nochmal aufgeschrieben.

| Volume | Dauer schreiben | Dauer lesen |

| None | 2:45 | 1:40 |

| Cache | 2:50 | 1. 1:45 2. 1:45 |

| Enc | 2:55 | 1:50 |

| Cache+Enc | 2:50 | 1. 1:45 2. 1:45 |

Datenmigration & Volume Layout

Nachdem ich nun die Tests abgeschlossen hatte, habe ich mich daran gesetzt einige der Daten von meinem DS220+ auf das TS-262 zu migrieren. Damit die Migration gestartet werden kann musste ich zuerst einmal ein Volume-Layout passend für mich finden und habe mich für den folgenden Weg entschieden.

Warum mehrere Volumes statt nur eines? Ganz einfach: Ich würde gerne entscheiden welches Volume den SSD-Cache erhält, wie die Snapshots erstellt werden sollen usw. Das geht nur auf Volume-Basis, deshalb gibt es eben mehrere Volumes statt nur eines großen Volumes.

Auf den Volumes müssen nun noch Freigabeordner erstellt werden, in diesen landen dann die effektiv die Daten. Ohne diese Freigabeordner wäre das Volume nur eine leere Hülle.

Die Daten selbst habe ich ganz einfach per Freigabe von meinem Synology auf das QNAP kopiert. Dabei hat mir eine App mit dem Namen HybridMount geholfen. Damit lassen sich recht einfach externe Speicher einbinden, egal ob CIFS, Google Drive, OneDrive, usw. Details zu der App folgen weiter unten.

Für die Migration habe ich einfach die CIFS-Freigaben eingebunden und diese dann mit der File Station einfach per Drag&Drop kopiert. Fertig.

QNAP Anwendungen

Kommen wir zu einem wichtigen Teil heutiger NAS-Systeme: Den nachinstallierbaren Anwendungen. Diese machen ein NAS in meinen Augen erst zu einem echten Multitalent, da hiermit zusätzliche Funktionen nachinstalliert werden können. Anderenfalls wäre es nur ein Plattenspeicher (JBOD), den ich per CIFS oder per Web-Schnittstelle ansprechen kann und darauf meine Daten ablegen kann.Mit der Software allerdings kann das NAS zusätzlich noch eine Sync-Station, Medienserver, SetTopBox, Backupserver, etc. werden.

Der App Center wirkt recht strukturiert, allerdings sind die Namen der Apps mit den eingebetteten Versionsnummern manchmal etwas verwirrend.

Ich werde hier bei vielen der Apps nicht auf die Details eingehen, sondern nur grob den Funktionsumfang umreisen und beschreiben. Außerdem werde ich hier auch nicht alle Apps vorstellen (können), das würde den Rahmen sprengen.

HybridMount

Mit der Software HybridMount kann man wie oben schon erwähnt sehr einfach verschiedene Speicheranbieter direkt in das QNAP einbinden. Dabei ist es egal ob es sich um einen CIFS-Mount, Google Drive, OneDrive oder weitere Anbieter handelt. Diese tauchen nach erfolgreicher Kopplung direkt in der File Station auf und lassen sich dort wie in lokales Laufwerk behandeln.

Dabei kann man auswählen, ob man das Laufwerk direkt einbinden möchte oder mit eine Cache Funktion. Direkt eingebunden werden alle Änderungen direkt in die Cloud geschrieben oder von dort gelesen.

Mit dem Cache Modus, der allerdings auf die zwei verfügbaren Lizenzen für die App angerechnet wird, werden die Daten in einem eigens dafür erstellten Speicher zwischengespeichert und asynchron geschrieben oder werden lokal einfach weiter vorgehalten sollte man öfter darauf zugreifen müssen. Die Größe des Cache Laufwerks lässt sich dabei einstellen, kann aber nach der Erstellung nicht mehr verkleinert werden.

Da mein Cloud-Laufwerk nur als Backup genutzt wird verzichte ich hier auf das Cache Laufwerk.

Mit dieser Funktion lässt sich das NAS quasi zu einem Multi Cloud Portal aufrüsten, mit dem sich die Daten von z.B. Dropbox auf OneDrive kopieren oder verschieben lassen, ohne dass man sich auf dem jeweiligen Portal anmelden muss.

Weiterhin lassen sich einzelne Mounts dediziert ein- oder aushängen, wenn man sie nicht mehr braucht oder das Quellsystem nicht mehr existieren sollte. Für mich allerdings war es die perfekte Methode meine Daten von meinem Synology auf das QNAP zu migrieren, da es sich am Ende nur um einen einfachen Kopierprozess handelt. Man sollte allerdings in der Zeit darauf achten, dass sich im Quellordner keine Dateien mehr verändern. Anderenfalls muss man den Kopiervorgang nochmal starten.

HybridDesk Station (HD Station) über HDMI

Die HybridDesk Station ist eine Sammlung mehrerer Apps, die man über den HDMI-Port des QNAP direkt auf einem Fernseher darstellen kann. Hierzu gibt es im App Center eine eigene Kategorie, in der nur die dafür passenden Apps gelistet werden.Nach Aktivierung sieht die Startoberfläche wie folgt aus und erinnert ein bisschen an die frühen Smart TVs:

Von hier aus können nun die installierten Apps gestartet werden. Die Bedienung kann dabei entweder über eine lokal am NAS angeschlossene Maus und Tastatur erfolgen oder mittels einer Fernbedienung, die man separat erwerben kann. Vermutlich funktioniert das auch mit einer Universalfernbedienung, aber das konnte ich leider mangels USB-B Datenkabel für meine alte Logitech Harmony One nicht testen ☹.

Was ich allerdings etwas schade fand: Sie internen Apps wie MusicStation und PhotoStation wurden immer über einen Browser geladen. Es handelt sich also um reine Webapps, was ich persönlich etwas schade finde, diese kann ich auch direkt von meinem PC aus starten oder über den eingebauten Browser meines SmartTV, das läuft auch deutlich flüssiger.

Ansonsten die HD Station das getan, was sie sollte: Bilder, Music und Videos direkt über HDMI abspielen. Das war es aber leider auch schon. Ich werde hier vermutlich eher ein Ubuntu installieren und über HDMI ausgeben lassen, hier habe ich dann ein volles Betriebssystem im Hintergrund und kann ebenfalls alle Apps öffnen wie mit der HD Station und mehr.