Shevchen

Urgestein

- Mitglied seit

- 20.01.2011

- Beiträge

- 2.955

- Desktop System

- Rotkäppchen

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X @4.7GHz allcore

- Mainboard

- Asus X570 Crosshair VIII Impact

- Kühler

- Custom Wasserkühler 4x480

- Speicher

- 32GB (2x16) G.Skill Samsung B-Die @3800 CL14

- Grafikprozessor

- AMD Radeon 5700XT 50th Anniversary edition

- Display

- LG 38GN950-B

- SSD

- 2x2TB Samsung 970 Evo Plus

- Soundkarte

- RME ADI-2 pro FS

- Gehäuse

- Corsair 1000D

- Netzteil

- Corsair AX1600i

- Keyboard

- Das Keyboard 5Q

- Mouse

- Logitech G502

- Betriebssystem

- Win10 pro/Arch Linux

Ja, ich bin mir dieser Tatsache bewusst, weshalb ich auch versuche zu vermeiden meine Ansprüche auf andere zu übertragen. Funktioniert natürlich nicht immer. xDAber damit bist du garantiert ein Einzelfall.

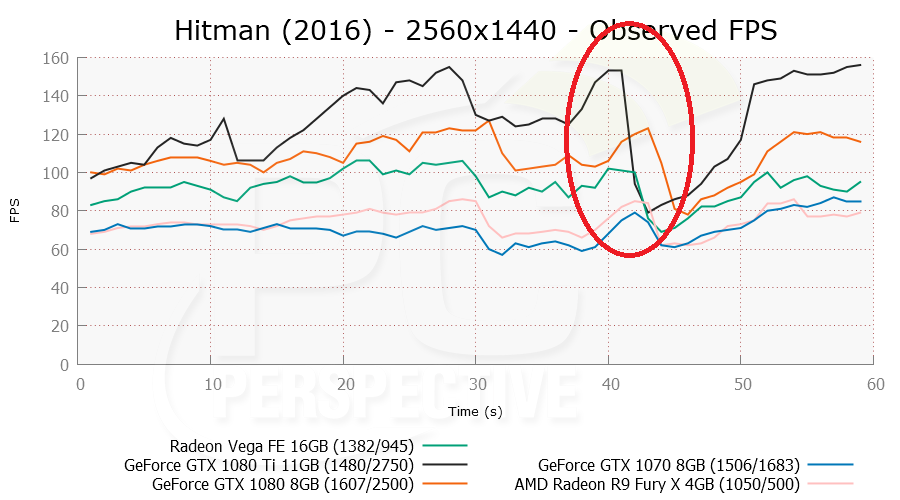

Wie schlägt sich AMD ggü. Nvidia?

Linux selbst hat keine Performance-Einbuße zu Windows. Das OS ist äquivalent schnell und hat in einigen Benchmarks sogar leichte Vorteile, wenn man Äpfel mit Äpfel vergleicht (Open GL - Nvidia - gleiche Anwendung)

Wenn wir die Birne hinzufügen - aka AMD Treiber mit OS-Treiber austauschen, hat der OS-Treiber bei OpenGL teilweise enorme Leistungsgewinne, wenn man native Anwendungen betrachtet (von denen gibt es aber nur sehr wenige). Die häufigsten OpenGL-Spiele auf Linux sind entweder geportet (was direkt mal ~30% Leistung kostet) oder laufen über Wine (kein offizieller Support und Frickelarbeit für den User)

Trotzdem kommen diese Ports recht nahe an die Windows Performance ran - was für den OS-Treiber spricht. Kurz gesagt ist Linux eigentlich die bessere gaming-Platform, WENN die Spiele OS-agnostisch geschrieben werden würden. Werden sie aber nicht, außer bei ein paar Indie-Titeln und nun ja... Star Citizen. xD

Also kurz gesagt:

Nvidia auf Linux = Nvidia auf Windows (bei nativen OpenGL Anwendungen)

AMD blob auf Linux < AMD-blob auf Windows

AMD OS auf Linux > AMD-blob auf Windows (Open GL nativ)

Gilt noch nicht für Vulkan, da Vulkan auf Linux noch nicht ganz fertig ist. Der Vergleich AMD OS vs. Nvidia auf Linux ist nicht so einfach zu ziehen, aber relativ-Benches zeigen beide auf Augenhöhe zueinander.

Zuletzt bearbeitet:

Aber das kann sich ja mit VegaRX noch ändern ...

Aber das kann sich ja mit VegaRX noch ändern ...