Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Erste Bestätigung - NVIDIA GeForce GTX 780 Ti hat 2880 CUDA-Kerne

- Ersteller Don

- Erstellt am

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Genau so ist es. Wieso gibt es diese "Vollausbau-Diskussion" eigentlich beim GK110?! Gabs die auch beim GF110 und bei den >500mm² GPUs davor? Meines Wissens hatte nV bisher immer den dicksten Chip als Vollausbau auf "günstigen Consumer Karten verramscht", sofern man nicht aufgrund von Wafer Ausbeute oder anderen technischen Problemen (z.b. GF100) gebremst wurde.Indem man beides verkauft.

Zuletzt bearbeitet:

S

Sharif

Guest

Letztes Jahr haben viele gesagt 2GB langt dicke zweck GTX580 und bei AMD hat man gesagt wozu 3Gb braucht kein Mensch

Unrockstar

Enthusiast

- Mitglied seit

- 16.01.2005

- Beiträge

- 2.762

- Desktop System

- Haupt_PC

- Details zu meinem Desktop

- Prozessor

- 5700X

- Mainboard

- MSI X470 Gaming Plus Max

- Kühler

- Arctic Freezer 2 240

- Speicher

- Crucial Ballistix Sport 32GB DDR 3200

- Grafikprozessor

- EVGA 3060Ti

- Display

- HP Envy 32

- SSD

- PNY 1TB M.2 SSD, Crucial MX300 500GB (Div SSD)

- Soundkarte

- Steinberg UR22 MK2

- Gehäuse

- Fractal Define R5

- Netzteil

- Corsair TX550M

- Keyboard

- Corsair Strafe RGB

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Chrome

- Internet

- ▼100Mbit ▲19Mbit

Genau so ist es. Wieso gibt es diese "Vollausbau-Diskussion" eigentlich beim GK110?! Gabs die auch beim GF110 und bei den >500mm² GPUs davor? Meines Wissens hatte nV bisher immer den dicksten Chip als Vollausbau auf "günstigen Consumer Karten verramscht", sofern man nicht aufgrund von Wafer Ausbeute oder anderen technischen Problemen (z.b. GF100) gebremst wurde.

Die Gab es.. Grade beim GF110 dem Thermi sogar massiv.. Ja da magst du recht haben mit den Gens davor, aber Effizienz wird eben durch perf/W erreicht, und wenn man einen günstigeren Chip dank etwas mehr Takt zu einer besseren Performance verhilft, würde jeder Kaufmann dies einem Risikobehafteten Vollausbau vorziehen. Leider ist wenig über die Yields des GK110 bekannt, nichts desto Trotz waren sie ja nicht ausreichend hoch genug, sonst hätte NV kaum Tesla/Quadro den Consumer Karten vorgezogen. Auch TITAN hätte man als Vollausbau bringen können, denn das hätte ein Zeichen gesetzt.

Bisher bin ich aber sowohl von AMD als auch NV enttäuscht. Maxwell verschiebt sich bis Sommer, Hawaii nur in 28nm und wohl mit Halfnode in 2014 auf 20nm (was auf die NEWS bezüglich Tahiti bis Ostern hindeutet). Alles derzeit sehr verworren.

DaLexy

Enthusiast

- Mitglied seit

- 17.08.2007

- Beiträge

- 439

Jetzt erklär mir nochmal was du mit Risikobehafteten Vollausbau meinst !

Und wie du schon sagst, es ist wenig über die Yieldrate bekannt, gut möglich das sich aus der schlechten Ausbeute nun eine Überproduktion ergeben hat oder nicht soviele Teslas und Quadros verkaufen wie gewünscht, was macht man da dann ? Richtig man verkauft mit Verlust als besser garnix zu verkaufen.

Da man nix genaures weiss sind es alles nur mutmaßungen.

Und wie du schon sagst, es ist wenig über die Yieldrate bekannt, gut möglich das sich aus der schlechten Ausbeute nun eine Überproduktion ergeben hat oder nicht soviele Teslas und Quadros verkaufen wie gewünscht, was macht man da dann ? Richtig man verkauft mit Verlust als besser garnix zu verkaufen.

Da man nix genaures weiss sind es alles nur mutmaßungen.

Zuletzt bearbeitet:

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Was Effizienz angeht, sprich Performance per Watt, wiedersprichst du dir irgendwie gerade selber. Da gar ein teildeaktivierter größerer GK110 (Titan) grob das gleiche leistet bei weniger Leistungsaufnahme als der kleinere Hawaii-XT (290X). Pauschal kann man das also sicherlich nicht sagen. Ich behaupte mal das wir solange keinen GK110 Vollausbau gesehen haben, weil es bis zur 290X schlicht und einfach keinen Sinn machte, da keine Konkurrenz seitens AMD vorhanden war. Der GK104 war leistungsfähig genug um mit Tahiti mitzuhalten, sodass man erstmal in aller Ruhe mit dem GK110 den Profi-Markt bedienen konnte. Hätte Tahiti deutlich mehr geleistet, wäre nV schon zeitnah genötigt wurden mit dem GK110 zu reagieren.Die Gab es.. Grade beim GF110 dem Thermi sogar massiv.. Ja da magst du recht haben mit den Gens davor, aber Effizienz wird eben durch perf/W erreicht, und wenn man einen günstigeren Chip dank etwas mehr Takt zu einer besseren Performance verhilft, würde jeder Kaufmann dies einem Risikobehafteten Vollausbau vorziehen. Leider ist wenig über die Yields des GK110 bekannt, nichts desto Trotz waren sie ja nicht ausreichend hoch genug, sonst hätte NV kaum Tesla/Quadro den Consumer Karten vorgezogen. Auch TITAN hätte man als Vollausbau bringen können, denn das hätte ein Zeichen gesetzt.

Die sollen sich lieber beide mit den 20nm GPUs Zeit nehmen und ausgereifte Produkte auf den Markt bringen als irgendwas halbfertig wirkendes siehe R9-290 Gerüchte. Die aktuelle Generation bietet noch genug Power bis Mitte oder Q3 2014.Bisher bin ich aber sowohl von AMD als auch NV enttäuscht. Maxwell verschiebt sich bis Sommer, Hawaii nur in 28nm und wohl mit Halfnode in 2014 auf 20nm (was auf die NEWS bezüglich Tahiti bis Ostern hindeutet). Alles derzeit sehr verworren.

Zuletzt bearbeitet:

Und wieso? Man hat jeweils immer den Vollausbau der stärksten GPU als Desktop Geforce gebracht. Immer. Nach Nvidias Praxis ist genau das nachvollziehbar. Alles andere wäre das genaue Gegenteil, was Nvidia seit Jahren gemacht hat.GK110 im Vollausbau wäre Fail hoch 10Und Entgegen NVs Praxis auch nicht Nachvollziehbar...

So sieht es aus.Genau so ist es. Wieso gibt es diese "Vollausbau-Diskussion" eigentlich beim GK110?! Gabs die auch beim GF110 und bei den >500mm² GPUs davor? Meines Wissens hatte nV bisher immer den dicksten Chip als Vollausbau auf "günstigen Consumer Karten verramscht", sofern man nicht aufgrund von Wafer Ausbeute oder anderen technischen Problemen (z.b. GF100) gebremst wurde.

Die GTX 780 Ti kommt als vollausbau - mit mehr Takt und 1/24 DP-Performance - und dann eben in 3GiB oder 6GiB. Nvidia weiß sicherlich am besten, was für sie am wirtschaftlichsten ist - schließlich war die gesamte Kepler-Generation bis jetzt ein voller Erfolg.Ich erwarte TITAN LE also GK110-400 mit mehr Takt und weniger DP Leistung und weniger VRAM.. Alles andre wäre nicht im Wirtschaftlichen Sinne logisch

Und genau das ist dein Fehler. Ein breites design mit weniger Takt wird immer! Effizienter als ein kleinerer Chip mit mehr Takt sein. Nicht umsonst ist eine Titan stock effizienter als die GTX 680.aber Effizienz wird eben durch perf/W erreicht, und wenn man einen günstigeren Chip dank etwas mehr Takt zu einer besseren Performance verhilft, würde jeder Kaufmann dies einem Risikobehafteten Vollausbau vorziehen.

Zuletzt bearbeitet:

MikelMolto

Neuling

- Mitglied seit

- 17.11.2009

- Beiträge

- 832

Versuche doch einfach damit zu leben! Was machst Du Dir überhaupt Gedanken über das Marketing von NV?Bisher bin ich aber sowohl von AMD als auch NV enttäuscht.

Man schimpft auch nicht über NV Trolle in einem NV Thread. Wo sonst sollen wir denn trollen wenn nicht hier!

Huggenknubbel

Experte

- Mitglied seit

- 28.05.2012

- Beiträge

- 59

So Leute, damit ihr mal Kapiert wie Preise zustande kommen eine kleine Beispielrechnung:

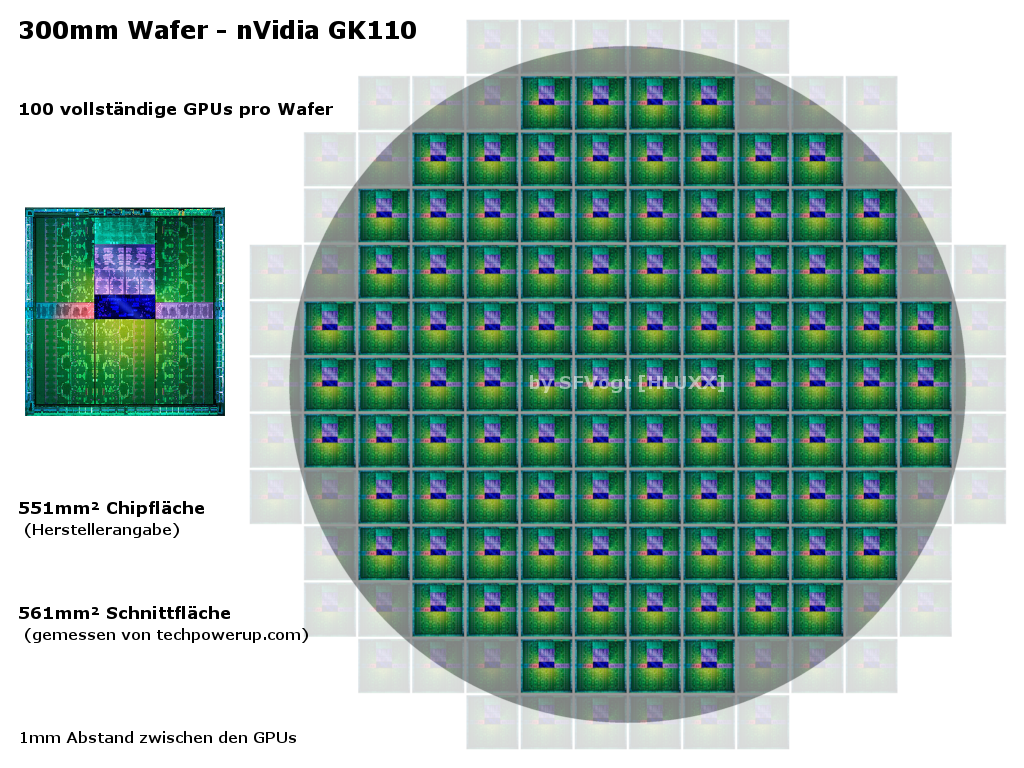

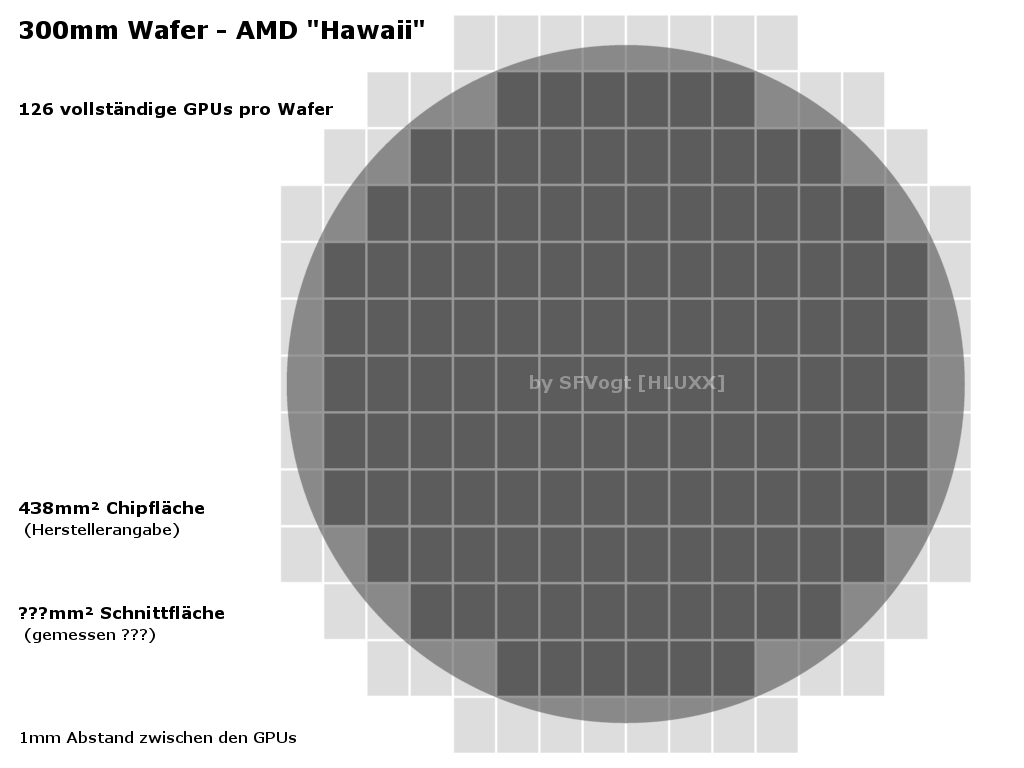

der Grafikchip selbst wird auf Wafern hergestellt. Momentan haben diese einen Durchmesser von 300mm. Darauf werden die einzelnen Chips gefertigt. Im Fall von einer 780GTX Pro Chip 551mm². Würde Rechnerisch 128 Chips auf einen Wafer ergeben. Da dieser aber rund ist und man so nicht die gesammte Fläche nutzen kann Schätze ich die Tatsächliche anzahl mal auf 100Chips Sicher gibts da auch Formeln aber so gut bin ich nicht gebildet :P

Pro Wafer kann NV also 100 Chips verkaufen. Wäre da nicht der Yield. Der bezeichnet die anzahl der Chips welche letztenendlich voll funktionsfähig sind. Am Anfang wenn ein produkt Hochgefahren wird liegt der im Bereich von 10-30%! und Es braucht Zeit bis dieser Steigt.

Einen Wafer zu fertigen kostet je nach art des Prozessors und der anzahl der "schichten" bis zu 4500€. Und ja, da kommen solche Preise schnell zusammen da nicht nur die Prozessmaschienen sehr teuer sind, sondern auch die verwendeten Chemikalien. Nehmen wir bei der GPU von NV mal 3500€ an da GPU´s in der regel nicht sehr schwierig zu fertigen sind.

Das ergibt dann letztenendes im Bestfall die Formel:

3500€/100/0,3%

Wo wir bei 116,66€ herrauskommen. ja, das klingt erstmal ziemlich wenig, aber mal kurz darüber nachgedacht:

Dazu Kommen noch enorme Entwicklungskosten. Damit meine ich nicht auf dem Papier sondern nur die Herstellungsprozesse. Da sind wir auch schon im 7-8 Stelligen Bereich.

So wenn wir die GPU an und für sich haben, ist noch nichts drum herum sprich: kein PCB, kein Kühlkörper, Keine Software wie Treiber, BIOS, kein Marketing, kein Gewinn (sowohl von NV als auch von Zwischenhändler und letztenendes dem Einzelhändler.

AMD hatte mit der R9 (x) Reihe glück mit dem Yield weshalb man die Karten Günstiger anbieten kann (und vielleicht muss?) Zahlen darf ich leider nicht verraten.

der Grafikchip selbst wird auf Wafern hergestellt. Momentan haben diese einen Durchmesser von 300mm. Darauf werden die einzelnen Chips gefertigt. Im Fall von einer 780GTX Pro Chip 551mm². Würde Rechnerisch 128 Chips auf einen Wafer ergeben. Da dieser aber rund ist und man so nicht die gesammte Fläche nutzen kann Schätze ich die Tatsächliche anzahl mal auf 100Chips Sicher gibts da auch Formeln aber so gut bin ich nicht gebildet :P

Pro Wafer kann NV also 100 Chips verkaufen. Wäre da nicht der Yield. Der bezeichnet die anzahl der Chips welche letztenendlich voll funktionsfähig sind. Am Anfang wenn ein produkt Hochgefahren wird liegt der im Bereich von 10-30%! und Es braucht Zeit bis dieser Steigt.

Einen Wafer zu fertigen kostet je nach art des Prozessors und der anzahl der "schichten" bis zu 4500€. Und ja, da kommen solche Preise schnell zusammen da nicht nur die Prozessmaschienen sehr teuer sind, sondern auch die verwendeten Chemikalien. Nehmen wir bei der GPU von NV mal 3500€ an da GPU´s in der regel nicht sehr schwierig zu fertigen sind.

Das ergibt dann letztenendes im Bestfall die Formel:

3500€/100/0,3%

Wo wir bei 116,66€ herrauskommen. ja, das klingt erstmal ziemlich wenig, aber mal kurz darüber nachgedacht:

Dazu Kommen noch enorme Entwicklungskosten. Damit meine ich nicht auf dem Papier sondern nur die Herstellungsprozesse. Da sind wir auch schon im 7-8 Stelligen Bereich.

So wenn wir die GPU an und für sich haben, ist noch nichts drum herum sprich: kein PCB, kein Kühlkörper, Keine Software wie Treiber, BIOS, kein Marketing, kein Gewinn (sowohl von NV als auch von Zwischenhändler und letztenendes dem Einzelhändler.

AMD hatte mit der R9 (x) Reihe glück mit dem Yield weshalb man die Karten Günstiger anbieten kann (und vielleicht muss?) Zahlen darf ich leider nicht verraten.

slidchen

Enthusiast

- Mitglied seit

- 05.04.2009

- Beiträge

- 1.534

- Ort

- Wald

- Desktop System

- QWERTZUIO

- Details zu meinem Desktop

- Prozessor

- Ryzen 7700X

- Mainboard

- B650E Steel Legend

- Kühler

- Galahad 360

- Speicher

- Kingston 32GB DDR5 6000

- Grafikprozessor

- RTX 3080 Ti

- Display

- AW3420

- SSD

- Kingston Fury 1TB

- HDD

- -

- Opt. Laufwerk

- -

- Soundkarte

- Creative G5

- Gehäuse

- O11D

- Betriebssystem

- W11

- Sonstiges

- iPhone 13 Pro Max / MacBook 14" M1 Pro / PS 5

- Internet

- ▼300 ▲50

Wie ist das eigentlich mit den Wafern, brechen die die Chips mit der Hand da raus wie bei ner Tafel Schokolade oder wie läuft das so?

B3ndix

Neuling

- Mitglied seit

- 27.01.2013

- Beiträge

- 28

Ich glaube nicht ganz ^^

Hier, finde das Video dazu ganz gut, da ist der Herstellungsprozess relativ genau beschrieben:

How a CPU is made - YouTube

Hier, finde das Video dazu ganz gut, da ist der Herstellungsprozess relativ genau beschrieben:

How a CPU is made - YouTube

So Leute, damit ihr mal Kapiert wie Preise zustande kommen eine kleine Beispielrechnung:

der Grafikchip selbst wird auf Wafern hergestellt. Momentan haben diese einen Durchmesser von 300mm. Darauf werden die einzelnen Chips gefertigt. Im Fall von einer 780GTX Pro Chip 551mm². Würde Rechnerisch 128 Chips auf einen Wafer ergeben. Da dieser aber rund ist und man so nicht die gesammte Fläche nutzen kann Schätze ich die Tatsächliche anzahl mal auf 100Chips Sicher gibts da auch Formeln aber so gut bin ich nicht gebildet :P

Pro Wafer kann NV also 100 Chips verkaufen. Wäre da nicht der Yield. Der bezeichnet die anzahl der Chips welche letztenendlich voll funktionsfähig sind. Am Anfang wenn ein produkt Hochgefahren wird liegt der im Bereich von 10-30%! und Es braucht Zeit bis dieser Steigt.

Einen Wafer zu fertigen kostet je nach art des Prozessors und der anzahl der "schichten" bis zu 4500€. Und ja, da kommen solche Preise schnell zusammen da nicht nur die Prozessmaschienen sehr teuer sind, sondern auch die verwendeten Chemikalien. Nehmen wir bei der GPU von NV mal 3500€ an da GPU´s in der regel nicht sehr schwierig zu fertigen sind.

Das ergibt dann letztenendes im Bestfall die Formel:

3500€/100/0,3%

Wo wir bei 116,66€ herrauskommen. ja, das klingt erstmal ziemlich wenig, aber mal kurz darüber nachgedacht:

Dazu Kommen noch enorme Entwicklungskosten. Damit meine ich nicht auf dem Papier sondern nur die Herstellungsprozesse. Da sind wir auch schon im 7-8 Stelligen Bereich.

So wenn wir die GPU an und für sich haben, ist noch nichts drum herum sprich: kein PCB, kein Kühlkörper, Keine Software wie Treiber, BIOS, kein Marketing, kein Gewinn (sowohl von NV als auch von Zwischenhändler und letztenendes dem Einzelhändler.

AMD hatte mit der R9 (x) Reihe glück mit dem Yield weshalb man die Karten Günstiger anbieten kann (und vielleicht muss?) Zahlen darf ich leider nicht verraten.

Die Entwicklungskosten der Herstellungsprozesse schlagen sich auf der Sollseite von Tsmc zu Buche und diese stellen einen integralen Bestandteil desPreises dar den Nvidia zahlt. Die darf man also nicht zum Einstandspreis dazuzählen. Oder muss Nvidia nicht nur die Chips bezahlen, sondern auch Summe X an Tsmc überweisen damit die entsprechende Entwicklung finanziert wird.

Zuletzt bearbeitet:

Pickebuh

Enthusiast

- Mitglied seit

- 27.07.2008

- Beiträge

- 3.375

Hier erste Benchmarks zur GTX 780Ti.

GTX 780 Ti

Wenn jetzt noch einer behauptet, das AMDs R9 290X ein Stromschlucker wäre...

AMD hat mit der Brechstange die Leistungskrone geholt und nun kommt NVIDIA mit C4-Sprengstoff um sie zurück zu hohlen.

GTX 780 Ti

Wenn jetzt noch einer behauptet, das AMDs R9 290X ein Stromschlucker wäre...

AMD hat mit der Brechstange die Leistungskrone geholt und nun kommt NVIDIA mit C4-Sprengstoff um sie zurück zu hohlen.

Zuletzt bearbeitet:

Warten wir ab auf richtige Werte, also auf die tests am Donnerstag. Ich sage schon jetzt: Die Stock 780 Ti wird nicht wirklich mehr als eine Titan verbrauchen, und somit effizienter als diese sein. Alles andere würde mich auch arg überraschen.

Lustigerweise verbraucht die 290X im 3DMark 11 eben nicht weniger als die 780 oder Titan

Also wie imemr noch etwas abwarten.

Lustigerweise verbraucht die 290X im 3DMark 11 eben nicht weniger als die 780 oder Titan

Also wie imemr noch etwas abwarten.

Zuletzt bearbeitet:

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Hier erste Benchmarks zur GTX 780Ti.

GTX 780 Ti

Wenn jetzt noch einer behauptet, das AMDs R9 290X ein Stromschlucker wäre...

Anhang anzeigen 255097

AMD hat mit der Brechstange die Leistungskrone geholt und nun kommt NVIDIA mit C4-Sprengstoff um sie zurück zu hohlen.

Wo sonst braucht Titan mehr Saft als die 290X? Mir ist kein einziges Review bekannt, das so ein Verhalten zeigt - allein das ist merkwürdig. Und die 780 Ti wurde übertaktet, womöglich mit Spannungserhöhung.

Aber darauf achtest du nicht, es wird sich nur das herausgepickt, was in die eigene Überzeugung passt...etwas mehr Recherche und Objektivität würden dir zur Abwechslung mal wirklich gut zu Gesicht stehen, statt mit unüberlegtem Geschwafel den Postcounter hochzutreiben.

WENN die Reviews am 7. der 780 Ti einen überproportional höheren Verbrauch als Titan bescheinigen, dann kann man immer noch darüber diskutieren.

Zuletzt bearbeitet:

haudi

Urgestein

Die Titan ist ja auch mit 106% PT beschnitten!!!!!! Die R9 290X ist diesbezüglich nicht beschnitten! Ergo sind die ganzen Vergleiche für die Kátz! Und die Mehrzahl der Titan User nimmt nen Mod Bios - und warum das? Weil da PT viel zu niedrig ist..Aber die Diskussion ist es eigentlich nicht wert...

Und was die Ti angeht - da wird einfach nen anderes PT Limit sein ... Leistung kostet eben

... Leistung kostet eben

Und was die Ti angeht - da wird einfach nen anderes PT Limit sein

... Leistung kostet eben

... Leistung kostet eben

Zuletzt bearbeitet:

S

Sharif

Guest

Das stimmt dann wird auch mehr Power verbraucht. Dann sind wir + - gleich auf mit AMD und NV

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Mit den 100 Stück GK110 pro 300mm Wafer liegst du gar richtig. Yield schön und gut, aber selbst teildeaktivierte GPUs sind ja nicht unbedingt schlecht, liefern gute Leistung und lassen sich gut vermarkten siehe 780 und Titan. Interessant wäre mal zu erfahren, wieviel von den vollständigen (im Beispiel des GK110) 100 GPUs wirklich Schrott sind, weil man sie gar nicht mehr verwenden kann.So Leute, damit ihr mal Kapiert wie Preise zustande kommen eine kleine Beispielrechnung:

der Grafikchip selbst wird auf Wafern hergestellt. Momentan haben diese einen Durchmesser von 300mm. Darauf werden die einzelnen Chips gefertigt. Im Fall von einer 780GTX Pro Chip 551mm². Würde Rechnerisch 128 Chips auf einen Wafer ergeben. Da dieser aber rund ist und man so nicht die gesammte Fläche nutzen kann Schätze ich die Tatsächliche anzahl mal auf 100Chips Sicher gibts da auch Formeln aber so gut bin ich nicht gebildet :P

Pro Wafer kann NV also 100 Chips verkaufen. Wäre da nicht der Yield. Der bezeichnet die anzahl der Chips welche letztenendlich voll funktionsfähig sind. Am Anfang wenn ein produkt Hochgefahren wird liegt der im Bereich von 10-30%! und Es braucht Zeit bis dieser Steigt.

Einen Wafer zu fertigen kostet je nach art des Prozessors und der anzahl der "schichten" bis zu 4500€. Und ja, da kommen solche Preise schnell zusammen da nicht nur die Prozessmaschienen sehr teuer sind, sondern auch die verwendeten Chemikalien. Nehmen wir bei der GPU von NV mal 3500€ an da GPU´s in der regel nicht sehr schwierig zu fertigen sind.

Das ergibt dann letztenendes im Bestfall die Formel:

3500€/100/0,3%

Wo wir bei 116,66€ herrauskommen. ja, das klingt erstmal ziemlich wenig, aber mal kurz darüber nachgedacht:

Dazu Kommen noch enorme Entwicklungskosten. Damit meine ich nicht auf dem Papier sondern nur die Herstellungsprozesse. Da sind wir auch schon im 7-8 Stelligen Bereich.

So wenn wir die GPU an und für sich haben, ist noch nichts drum herum sprich: kein PCB, kein Kühlkörper, Keine Software wie Treiber, BIOS, kein Marketing, kein Gewinn (sowohl von NV als auch von Zwischenhändler und letztenendes dem Einzelhändler.

AMD hatte mit der R9 (x) Reihe glück mit dem Yield weshalb man die Karten Günstiger anbieten kann (und vielleicht muss?) Zahlen darf ich leider nicht verraten.

Und wie lange läuft der GK110 schon vom Band?! Wie lange konnte nVidia schon vollfunktionsfähige GPUs sammeln bis zum Release der Quadro K6000 und 780 Ti? Denn auf Teslas kam der Vollausbau ja bisher auch nicht zum Einsatz.

Tenchi Muyo

Enthusiast

- Mitglied seit

- 27.06.2006

- Beiträge

- 4.168

Interessant wäre nur zu wissen WANN es die Karten mit 6GB geben wird, dann vermutlich wieder mit den ca. € 200 Preisaufschlag.

Karten mit 12GB halte ich für ein Gerücht, denn dann läge die TI bei über €1000..

Karten mit 12GB halte ich für ein Gerücht, denn dann läge die TI bei über €1000..

Mit den 100 Stück GK110 pro 300mm Wafer liegst du gar richtig. Yield schön und gut, aber selbst teildeaktivierte GPUs sind ja nicht unbedingt schlecht, liefern gute Leistung und lassen sich gut vermarkten siehe 780 und Titan. Interessant wäre mal zu erfahren, wieviel von den vollständigen (im Beispiel des GK110) 100 GPUs wirklich Schrott sind, weil man sie gar nicht mehr verwenden kann.

Und wie lange läuft der GK110 schon vom Band?! Wie lange konnte nVidia schon vollfunktionsfähige GPUs sammeln bis zum Release der Quadro K6000 und 780 Ti? Denn auf Teslas kam der Vollausbau ja bisher auch nicht zum Einsatz.

Zum ersten, also ich behaupte mal, so viele wirklich "Schrott" GPUs kommen da heute nicht mehr raus.

Warum?

Ganz einfach... Man schaue sich die scheinbar überwiegende Mehrheit der GK110 780er GPUs an.

Das Ding besteht aus fünf sogenannten GPCs. Jeder GPC beherbergt 3x192 ALU Blöcke (unter Anderem)

Bei der 780er gab NV die Meldung raus, das die 780er teilweise mit fünf, teils auch nur mit vier aktiven GPCs daher kommt... Scheinbar ist es nun aber so, das die Masse der 780er GPUs nur vier GPCs aktiv hat. Was Stichprobemmessungen der Filterleistung ergeben haben. Denn diese scheint vermehrt nur auf dem Niveau von vier aktiven GPCs zu sein.

Das deutet aber nun auf folgendes Ergebnis. -> nur vier aktive GPCs heist 4x3x192 ALUs = 2304. Eben das, was die 780er aktiv hat. Was wiederum bedeutet, NV schaltet scheinbar der Einfachheit halber nen ganzen auf die Fläche gesehen, dicht zusammenhängenden 3x192 ALU Block ab anstatt jeweils nur dort einen ALU Block zu deaktiveren, wo wirklich Fehler drin sind.

Die Vermutung liegt also nahe, das das Silizium vollständig funktionsfähig ist.

Denn wären viele echte Fehler vorhanden, so wäre die Warscheinlichkeit deutlich geringer, das diese dicht beisammen in einem GPC zu finden sind, anstatt weit verstreut mal hier und mal dort. Denn das würde nämlich bedeuten, das alle fünf GPCs aktiv wären, und man aus diesen fünf GPCs jeweils in Summe eben 3x192 ALUs deaktiviert hätte. -> was man aber wohl so nicht macht.

Zum letzten, GK110 gibts ja in Form der Tesla K20 und K20X schon seit Oktober? letzten Jahres... Zwar nicht im freien Handel, aber immerhin in stattlichen Größenordnungen im Titan Supercomputer... Das waren doch irgendwo knappe 20k Einheiten von K20X Karten. Sprich grob über den Daumen eben 200 Wafer voll mit funktionsfähigen GPUs -> zuzüglich derer die es nicht schafften eben die 2688 ALUs der K20X zu liefern.

Interessanter ist aber die Frage, ob die 780TI in dem gleichen Stepping bzw. der gleichen Revision vom Band läuft...?

Ich könnte mir gar vorstellen, NV und TSMC haben im letzten Jahr eben massiv Erfahrungen gesammelt. Und man könnte daraus denke ich sicher auch Rückschlüsse ziehen ob man über nen simplen Respin oder ähnliches eben vermehrt fehleranfällige Stellen in der GPU beseitigen kann. Eben um die Ausbeute nochmals zu steigern für voll funktionsfähige GPUs. Denn diese scheint es bei der 780TI nach aktueller Spekulationslage ja zu benötigen.

Unterm Strich bleibt halt noch die Frage, wie viel Reserve NV in die GPUs gebaut hat...

Die werden schon ihre goldene Nase an den Karten verdienen. Beim Referenzlayout kommen ja meistens dann nur die Komponenten zum Einsatz mit dem das Ding einfach funktioniert ohne Reserven.

In der Rechnung fehlen dann natürlich auch die Skalierungseffekte und Mengenrabatte. An der Titan werden die schon gut verdienen genauso GTX 780. Bezweifel, dass man die mit Verlust verkauft.

Die Entwicklungskosten werden durch die Tesla Karten und dann dem ganzen Portfolio das auf dem Chip basiert umgelegt. Die Architektur ist ja so ausgelegt, dass man die Chips anderweitig verwursten kann.

In diesem angeblich Test, weiss man da ob das die TI Black war oder eine normale TI. Sofern das Ding dann letztendlich so heissen wird. Normal müssten die es ja Titan Ti nennen, dann könnte man wenigsten die Titan im Portfolio lassen und das Ding wieder für 999€ ansetzen.

In der Rechnung fehlen dann natürlich auch die Skalierungseffekte und Mengenrabatte. An der Titan werden die schon gut verdienen genauso GTX 780. Bezweifel, dass man die mit Verlust verkauft.

Die Entwicklungskosten werden durch die Tesla Karten und dann dem ganzen Portfolio das auf dem Chip basiert umgelegt. Die Architektur ist ja so ausgelegt, dass man die Chips anderweitig verwursten kann.

In diesem angeblich Test, weiss man da ob das die TI Black war oder eine normale TI. Sofern das Ding dann letztendlich so heissen wird. Normal müssten die es ja Titan Ti nennen, dann könnte man wenigsten die Titan im Portfolio lassen und das Ding wieder für 999€ ansetzen.

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Mit der Einführung des B1 Stepping beim GK110 werden doch sowieso alle GPUs in diesem Stepping vom Band rollen oder nicht?! Was es mit diesem auf sich hat bzw. welche Änderungen es inne hat, haben hoffentlich eins zwei Tester bei nVidia abgefragt und werden die Leser der 780 Ti Reviews einweihen.Zum ersten, also ich behaupte mal, so viele wirklich "Schrott" GPUs kommen da heute nicht mehr raus.

Warum?

Ganz einfach... Man schaue sich die scheinbar überwiegende Mehrheit der GK110 780er GPUs an.

Das Ding besteht aus fünf sogenannten GPCs. Jeder GPC beherbergt 3x192 ALU Blöcke (unter Anderem)

Bei der 780er gab NV die Meldung raus, das die 780er teilweise mit fünf, teils auch nur mit vier aktiven GPCs daher kommt... Scheinbar ist es nun aber so, das die Masse der 780er GPUs nur vier GPCs aktiv hat. Was Stichprobemmessungen der Filterleistung ergeben haben. Denn diese scheint vermehrt nur auf dem Niveau von vier aktiven GPCs zu sein.

Das deutet aber nun auf folgendes Ergebnis. -> nur vier aktive GPCs heist 4x3x192 ALUs = 2304. Eben das, was die 780er aktiv hat. Was wiederum bedeutet, NV schaltet scheinbar der Einfachheit halber nen ganzen auf die Fläche gesehen, dicht zusammenhängenden 3x192 ALU Block ab anstatt jeweils nur dort einen ALU Block zu deaktiveren, wo wirklich Fehler drin sind.

Die Vermutung liegt also nahe, das das Silizium vollständig funktionsfähig ist.

Denn wären viele echte Fehler vorhanden, so wäre die Warscheinlichkeit deutlich geringer, das diese dicht beisammen in einem GPC zu finden sind, anstatt weit verstreut mal hier und mal dort. Denn das würde nämlich bedeuten, das alle fünf GPCs aktiv wären, und man aus diesen fünf GPCs jeweils in Summe eben 3x192 ALUs deaktiviert hätte. -> was man aber wohl so nicht macht.

Zum letzten, GK110 gibts ja in Form der Tesla K20 und K20X schon seit Oktober? letzten Jahres... Zwar nicht im freien Handel, aber immerhin in stattlichen Größenordnungen im Titan Supercomputer... Das waren doch irgendwo knappe 20k Einheiten von K20X Karten. Sprich grob über den Daumen eben 200 Wafer voll mit funktionsfähigen GPUs -> zuzüglich derer die es nicht schafften eben die 2688 ALUs der K20X zu liefern.

Interessanter ist aber die Frage, ob die 780TI in dem gleichen Stepping bzw. der gleichen Revision vom Band läuft...?

Ich könnte mir gar vorstellen, NV und TSMC haben im letzten Jahr eben massiv Erfahrungen gesammelt. Und man könnte daraus denke ich sicher auch Rückschlüsse ziehen ob man über nen simplen Respin oder ähnliches eben vermehrt fehleranfällige Stellen in der GPU beseitigen kann. Eben um die Ausbeute nochmals zu steigern für voll funktionsfähige GPUs. Denn diese scheint es bei der 780TI nach aktueller Spekulationslage ja zu benötigen.

Unterm Strich bleibt halt noch die Frage, wie viel Reserve NV in die GPUs gebaut hat...

Wenn ich mich jetzt nicht grob vertan habe, gewinnt AMD 26% mehr Hawaii GPUs aus einem 300mm Wafer als nVidia an GK110 Chips. Das nur mal als Info am Rande.

Schaffe89

Banned

- Mitglied seit

- 12.12.2010

- Beiträge

- 5.644

boxleitnerb schrieb:Wo sonst braucht Titan mehr Saft als die 290X? Mir ist kein einziges Review bekannt, das so ein Verhalten zeigt - allein das ist merkwürdig. Und die 780 Ti wurde übertaktet, womöglich mit Spannungserhöhung.

Aber darauf achtest du nicht, es wird sich nur das herausgepickt, was in die eigene Überzeugung passt...etwas mehr Recherche und Objektivität würden dir zur Abwechslung mal wirklich gut zu Gesicht stehen, statt mit unüberlegtem Geschwafel den Postcounter hochzutreiben.

Die Reviews die die Lautstärke aus einem Gehäuse messen, messen im Vergleich zur Titan nicht unbedingt mehr Sone oder lautere dB Werte, ganz einfach weil die restliche Hardware/Lüfter von der 290x weniger aufgewärmt werden als von einer Titan.

Das ist im übrigen auch der Grund für die Leistungsaufnahmemessungen bei Hardwareluxx, hier sind die Gesamtsysteme bei AMD tendenziell verbrauchsärmer im Vergleich zu anderen Messungen, weil sich die Komponenten weniger erhitzen, jedenfalls klingt das für mich plausibel und erklärt die untersch. Leistungsaufnahmemessungen.

Und zudem hat nur eine einzige Seite wirklich ernshafte Messungen gemacht ( Tomshardware ), die geben keine Peakwerte an, sondern Durschnittswerte und da ist eine R9 290x kaum stromschluckender wie ne Titan, die gleichen Erfahrungen mache ich übrigens mit meinem Strommessgerät und alternativen Kühlern auf Grafikkarten.

Schraubst du einen alternativen Kühler auf die Karte erhitzen sich alle Komponenten im Gehäuse um 5 bis 10 Grad mehr ( in meinem Fall ) ( ausgelesen mit AIDA64) und der Stromverbrauch geht 10 bis 20 Watt in die Höhe, anstelle wenn du einen DHE Kühler nutzt.

Drehst du nun den DHE Kühler auf das Maximum hast du den niedrigsten Stromverbrauch den man erreichen kann, Innenleben recht kühl, Karte recht kühl, aber leider recht laut ( zumindest für manche, für mich macht das nun wirklich keinen Unterschied, da ich mit Kopfhörern spiele ).

Das DHE Kühlerkonzept ist nach wie vor das mit Abstand beste ( Lautstärke ausgenommen ), was man am Markt bekommen kann.

Titan hat das Konzept bereits aufgeweicht und nur deswegen ist die Karte leiser wie eine 290x, eben weil einiges an warmer Luft ins Gehäuse strömt.

Zuletzt bearbeitet:

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Wer hat von Lautstärke gesprochen? Niemand, es geht um Leistungsaufnahme. Abgesehen davon sind beides Kühler, die die warme Luft nach draußen blasen, warum soll da eine Karte das Gehäuse weniger stark aufheizen als die andere? Macht keinen Sinn.

Woher weißt du, welche Seiten Peakwerte und welche Durchschnittswerte angeben? Manchmal steht es dran (TPU), meist weiß man darüber aber gar nichts. Von Computerbase weiß ich es aber, die geben einen Wert von einem stationären Szenario an, sprich Savegame laden, warten bis sich alles eingependelt hat und dann Wert ablesen. Leider halt Gesamtsystemmessung. Was genau PCGH, HT4U, hardware.fr, Heise messen, wie sie vorgehen, ist unbekannt. Wie kommst du überhaupt dazu, zu beurteilen, wer "ernsthaft" misst und wer nicht? Das ist ja schon ein ziemlich starkes Stück so eine Aussage.

Und du hast immer noch nicht verstanden, dass du die Messungen von Tomshardware nicht benutzen kannst, um irgendwas abzuleiten. Die Karte verbraucht mehr bei der niedrigeren Temperatur durch den nun höheren Boost und weniger durch die niedrigere Temperatur. In der Summe aber immer noch mehr. Viel Erfolg, das nun aufzudröseln und zu sagen, was nun wieviel beiträgt - das ist nicht möglich. Und deren Ergebnisse weichen wie gesagt sowieso recht deutlich von den Ergebnissen anderer Seiten ab. Man kann natürlich unterstellen, dass alle anderen Mist messen. Man kann aber ebenso überlegen, dass die Ergebnisse von THG es sind, die Mist sind. Der Geisterfahrer denkt auch, er fährt richtig, nur sieht die Realität halt anders aus.

Woher weißt du, welche Seiten Peakwerte und welche Durchschnittswerte angeben? Manchmal steht es dran (TPU), meist weiß man darüber aber gar nichts. Von Computerbase weiß ich es aber, die geben einen Wert von einem stationären Szenario an, sprich Savegame laden, warten bis sich alles eingependelt hat und dann Wert ablesen. Leider halt Gesamtsystemmessung. Was genau PCGH, HT4U, hardware.fr, Heise messen, wie sie vorgehen, ist unbekannt. Wie kommst du überhaupt dazu, zu beurteilen, wer "ernsthaft" misst und wer nicht? Das ist ja schon ein ziemlich starkes Stück so eine Aussage.

Und du hast immer noch nicht verstanden, dass du die Messungen von Tomshardware nicht benutzen kannst, um irgendwas abzuleiten. Die Karte verbraucht mehr bei der niedrigeren Temperatur durch den nun höheren Boost und weniger durch die niedrigere Temperatur. In der Summe aber immer noch mehr. Viel Erfolg, das nun aufzudröseln und zu sagen, was nun wieviel beiträgt - das ist nicht möglich. Und deren Ergebnisse weichen wie gesagt sowieso recht deutlich von den Ergebnissen anderer Seiten ab. Man kann natürlich unterstellen, dass alle anderen Mist messen. Man kann aber ebenso überlegen, dass die Ergebnisse von THG es sind, die Mist sind. Der Geisterfahrer denkt auch, er fährt richtig, nur sieht die Realität halt anders aus.

Zuletzt bearbeitet:

Mick_Foley

Semiprofi

- Mitglied seit

- 10.02.2008

- Beiträge

- 15.045

Wie kommst du überhaupt dazu, zu beurteilen, wer "ernsthaft" misst und wer nicht? Das ist ja schon ein ziemlich starkes Stück so eine Aussage.

Er ist mal wieder in seinem ganz speziellen Troll-Modus...

Unrockstar

Enthusiast

- Mitglied seit

- 16.01.2005

- Beiträge

- 2.762

- Desktop System

- Haupt_PC

- Details zu meinem Desktop

- Prozessor

- 5700X

- Mainboard

- MSI X470 Gaming Plus Max

- Kühler

- Arctic Freezer 2 240

- Speicher

- Crucial Ballistix Sport 32GB DDR 3200

- Grafikprozessor

- EVGA 3060Ti

- Display

- HP Envy 32

- SSD

- PNY 1TB M.2 SSD, Crucial MX300 500GB (Div SSD)

- Soundkarte

- Steinberg UR22 MK2

- Gehäuse

- Fractal Define R5

- Netzteil

- Corsair TX550M

- Keyboard

- Corsair Strafe RGB

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Chrome

- Internet

- ▼100Mbit ▲19Mbit

So Unrecht hat er aber nicht. Fakt ist, dass die Leistungsmessungen immer nur eine Momentaufnahme zeigen, Durchschnitt und Peak ist dank Boost und Turbo immer schwieirger, HT4u hatte mal einen Apadater, womit man Karten ausmessen kann, leider glaube ich haben sie diesen nicht mehr. Sämtliche Leistungswerte sind aber eben nicht Objektiv, denn weder ist die Hardware gleich, noch ist das Gehäuse und die Umgebung identisch. HT4u hat mal herausgefunden dass die TITAN z.b. ihren Boosttakt nicht ohne Erhöhung des Powerleveln halten kann, also eine Art Boost für Benches, danach normal.. Gleiches sieht man bei AMD leider, wobei ich mir von Custom Modelle nun keine 20W weniger bei weniger Sone erwarte.. Eher werden die Custom Modelle zeigen, was sie unter Wasser können, denn ich erwarte mir wieder verbesserte Designs bei gleichzeitig geringerer TDP

Alles in allem derzeit keine Wirkliche Alternative, auch eine 3GB 780Ti klingt für mich einfach nur nach Holzhammer..

Alles in allem derzeit keine Wirkliche Alternative, auch eine 3GB 780Ti klingt für mich einfach nur nach Holzhammer..

Mick_Foley

Semiprofi

- Mitglied seit

- 10.02.2008

- Beiträge

- 15.045

Das Problem ist auch eher, dass er sich mal wieder anmaßt eine Richtinstanz zu sein...