Mal 'ne dumme Frage: ich habe am Wochenende ein wenig mit meinem System herumgespielt und jetzt verabschiedet sich der ESXi nach einiger Zeit (10 Minuten oder auch 2 Stunden) mit einem hübschen Purple Screen.

Was habe ich gemacht: im Prinzip habe ich nur einen vorhandenen SAS-HBA (Dell crossflashed H310) physisch herausgenommen und einen aktuellen Broadcom HBA (9305-24i bzw. 3224) in den gleichen Slot eingesetzt, den auf Passthrough gestellt. Weil das nicht wie gewünscht funktionierte, hab ich dann die Kiste physisch wieder zurückgebaut. Ich habe jeweils NICHT vor dem Wechsel Passthrough deaktiviert oder sonstige Konfigurationen in ESXi geändert.

Davor lief das System monatelang unauffällig (jaja, ... "never change"...). Einen Hardware-defekt würde ich eigentlich gerne ausschließen, habe ja nur an einem Steckplatz gefummelt. Memtest lief auch ca. 2-3 Stunden (64GB RAM).

In der /etc/vmware/esx.conf hab ich jetzt folgende Einträge:

Code:

/device/00000:179:00.1/vendor = "10de"

/device/00000:179:00.1/device = "fb9"

/device/00000:179:00.1/owner = "passthru"

/device/00000:180:00.1/vmkname = "vmnic3"

/device/00000:179:00.0/owner = "passthru"

/device/00000:179:00.0/device = "1cb3"

/device/00000:179:00.0/vendor = "10de"

/device/00000:026:00.1/vmkname = "vmnic1"

/device/00000:026:00.0/vmkname = "vmnic0"

/device/00000:001:00.0/vendor = "1912"

/device/00000:001:00.0/device = "14"

/device/00000:001:00.0/owner = "passthru"

/device/00000:023:00.0/vmkname = "vmhba2"

/device/00000:023:00.0/vendor = "1000"

/device/00000:023:00.0/device = "72"

/device/00000:023:00.0/owner = "passthru"

/device/00000:000:17.5/vmkname = "vmhba0"

/device/00000:000:23.0/vmkname = "vmhba1"

/device/00000:180:00.0/vmkname = "vmnic2"

/device/00000:004:00.0/vmkname = "vmhba4"

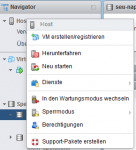

So sieht die passthrough-Konfig in der Weboberfläche aus:

Messerscharf kombiniert mit der passthrough.map heisst das für mich:

1.

Die Geräte an ...179:00... vom Vendor "10de" sind die Nvidia Quadro P400.

2.

026, und 180 sind auch logisch, das sind die 4 NICs (2x Onboard und 2x mit X540-T2).

3.

An ...001:00... sitzt die USB3-Steckkarte.

4.

Was mich irritiert: ich habe offenbar 4 HBAs, nämlich an 000 (HBA 0+1), 004 (HBA4) und 023 (HBA3) - von denen nur der vmhba2 als "passthru" markiert ist. Der HBA sitzt aber angeblich auf 0000:17:00.0 bzw. 0000:16:00.0 (Parent).

Der Host verabschiedet sich bisher nur in den Purple Screen, wenn (mindestens) eine der VMs mit Passthrough-Geräten läuft. Dabei himmelt es den Host auch, wenn nur die Windows-VM mit der durchgereichten Graka/USB-Karte läuft, zu der ich ja gar keine Veränderungen hardwareseitig vorgenommen hatte.

Hatte sowas (ähnliches) schon jemand / ist da irgendetwas durcheinander geraten? Was kann ich noch tun, um dem Fehler auf die Spur zu kommen (oder muss ich den Host neu aufsetzen - nervig aber machbar)?

Danke vorab für sachdienliche Hinweise!

Sofern die Storageseite entsprechend mit min. 2x Wegen angebunden ist...

Sofern die Storageseite entsprechend mit min. 2x Wegen angebunden ist...

6:1d:a9 auf 00:0c:29:56:0b:e1 oder d7 zu kommen, sollte das gehen.

6:1d:a9 auf 00:0c:29:56:0b:e1 oder d7 zu kommen, sollte das gehen.