Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Hinter verschlossenen Türen: NVIDIAs Kepler auf der CES?

- Ersteller Stegan

- Erstellt am

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Da hat sich AMD ja Ruby in den tech Demos schön gerendert ^^

Da hat sich AMD ja Ruby in den tech Demos schön gerendert ^^Blediator16

Enthusiast

- Mitglied seit

- 19.09.2005

- Beiträge

- 629

Was ist an dem Bild so lustig? Scheint über meinen Horizont zu reichen.

AcrAnoX

Neuling

Weil sie ne Kuh darstellen soll (Kuh=Fett).. angekommen?

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

snaapsnaap

Enthusiast

- Mitglied seit

- 07.03.2007

- Beiträge

- 4.720

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 12700K

- Mainboard

- MSI PRO Z790-A WIFI

- Kühler

- Thermalright Frozen Magic 280mm Scenic V2

- Speicher

- 32GB Corsair Vengeance 6000Mhz CL36

- Grafikprozessor

- Palit 4060Ti 8GB StormX - GhettoMod

- Display

- Acer Predator XB273KGP, LG 27UL500

- SSD

- Kingston Fury Renegade 1TB, Corsair MP600 Pro 2TB, Corsair MP600 2TB

- Soundkarte

- Sony 1000-XM4, Soundcore P20i, Sony XB900N, Sony CT60BT

- Gehäuse

- Lian Li O11 Dynamic Mini

- Netzteil

- Corsair SF600 Platinum

- Keyboard

- fnatic Streak65

- Mouse

- ASUS ROG Keris

- Betriebssystem

- Windows 11 Pro x64

- Webbrowser

- Brave

- Sonstiges

- Series X Controller

- Internet

- ▼~950mbit

400$ wäre etwas viel für den Nachfolger der 560ti. Ok, wird schneller als die 580 aber so ist die eigentlich etwas zu teuer für den Nachfolger der 560er.

Da hätte ich doch an Preise bis 250€ bzw 300$ gedacht und Verbrauch wäre ebenfalls ziemlich heftig für die Mittelklasse/Performance...

Da hätte ich doch an Preise bis 250€ bzw 300$ gedacht und Verbrauch wäre ebenfalls ziemlich heftig für die Mittelklasse/Performance...

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Oh nein nicht schon wieder OBR. Ich weiß ja nicht wie man diesen Kasper noch ernst nehmen kann, nicht nur wegen seinem kindischen Gezanke mit AMD.

Und deshalb müssen die Daten falsch sein? Deshalb muss man immer einen auf moralisch machen und sich so künstlich aufregen? Sorry, aber das geht mir langsam auf den Sack. Nachher wird das von einer anderen Seite wiedergekäut und ihr lest es auch interessiert. So eine blöde Heuchelei...

Und deshalb müssen die Daten falsch sein? Deshalb muss man immer einen auf moralisch machen und sich so künstlich aufregen? Sorry, aber das geht mir langsam auf den Sack. Nachher wird das von einer anderen Seite wiedergekäut und ihr lest es auch interessiert. So eine blöde Heuchelei...

Es geht darum, dass man einen Typen der bewußt gefälschte Daten in Umlauf gebracht hat nicht auch noch auf die Bühne helfen muss. Der ist einfach komplett unseriös u. ein ertappter Lügner ganz gleich ob sich seine Daten am Ende sogar bestätigen. Sowas gehört abgestraft u. nicht noch m. Klicks belohnt.

Er hatte in letzter Zeit aber recht, Stichwort: BulldozerOh nein nicht schon wieder OBR. Ich weiß ja nicht wie man diesen Kasper noch ernst nehmen kann, nicht nur wegen seinem kindischen Gezanke mit AMD.

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Es geht darum, dass man einen Typen der bewußt gefälschte Daten in Umlauf gebracht hat nicht auch noch auf die Bühne helfen muss. Der ist einfach komplett unseriös u. ein ertappter Lügner ganz gleich ob sich seine Daten am Ende sogar bestätigen. Sowas gehört abgestraft u. nicht noch m. Klicks belohnt.

Ist mir komplett egal. Ich hab kein Interesse, irgendjemanden abzustrafen, was soll das, ist doch kindisch. Tut niemandem weh, wenn man Infos postet. Du kannst dich ja dran halten und ihn nicht beachten, mir ist das wie gesagt völlig wurscht

Zuletzt bearbeitet:

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

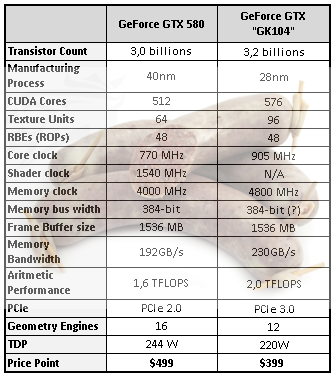

Sieht ja aus wie ein 1,5facher GF114 in 28nm und bisl höherem Takt laut den GK104 Daten?!

...müßter der dann nicht immernoch den doppelten Shadertakt haben bei der geringen Mehrzahl an Cores um ne GTX 580 um 10-15% zu schlagen?

...müßter der dann nicht immernoch den doppelten Shadertakt haben bei der geringen Mehrzahl an Cores um ne GTX 580 um 10-15% zu schlagen?

Zuletzt bearbeitet:

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Oder die Shader selbst müssten fetter sein. Das Fragezeichen beim Shadertakt hab ich beim ersten Drüberlesen glatt übersehen. Das ist scheinbar noch nicht klar.

Neurosphere

Enthusiast

- Mitglied seit

- 06.11.2008

- Beiträge

- 4.324

Demnach wären die Hotclocks also noch drin. Hmm...

SFVogt

Enthusiast

- Mitglied seit

- 27.01.2005

- Beiträge

- 5.636

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 12900K delided

- Mainboard

- Gigabyte Z690M AORUS Elite AX DDR4

- Kühler

- Heatkiller 4 Basic Acetal direct-DIE

- Speicher

- 2x16GB G.Skill F4-3600C14D-32GVK

- Display

- 65" 8K LG 65QNED999PB

- SSD

- 2TB M.2 Samsung 980 Pro

- Gehäuse

- Jonsbo RM3 black

- Netzteil

- 850W BeQuiet Dark Power Pro 11

- Keyboard

- Roccat Sova

- Mouse

- Roccat Kone Pure Ultra

- Betriebssystem

- Win10 64Bit

- Sonstiges

- Logitech Z906 5.1

- Internet

- ▼1.000Mit/s ▲50 MBit

Das würde eventuell auch die 220W Angabe erklären?!

10% weniger TDP bei 10-15% Mehrleistung als ne GTX580?! Hmm...

...die DIE Size müßte ja im Vergleich zum Tahiti mit 4,3 Milliarden Transistoren ein Stück weit kleiner sein?!

10% weniger TDP bei 10-15% Mehrleistung als ne GTX580?! Hmm...

...die DIE Size müßte ja im Vergleich zum Tahiti mit 4,3 Milliarden Transistoren ein Stück weit kleiner sein?!

Neurosphere

Enthusiast

- Mitglied seit

- 06.11.2008

- Beiträge

- 4.324

Nachdem das mit dem Wegfall der Hotclocks alles so plausibel klang kann ich mir garnicht vorstellen das sie nun wirklich dabei bleiben sollen.

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

TDP ist schon wichtig, weil im Endeffekt ist TDP=Leistung, ganz grob jedenfalls. Die 590 z.B. könnte schneller sein, würde sie nicht soviel nuckeln.

boxleitnerb

Enthusiast

- Mitglied seit

- 11.01.2007

- Beiträge

- 6.546

Am Schluss vielleicht...

RediMischa

Enthusiast

- Mitglied seit

- 08.06.2008

- Beiträge

- 2.751

- Ort

- Vorarlberg

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- Asus ROG Strix X670E-A

- Kühler

- Custom WaKü

- Speicher

- 32GB G.Skill Trident Z5 RGB silber DDR5-6400 30-37-37-46

- Grafikprozessor

- MSI GeForce RTX 4090 Suprim X

- Display

- LG OLED 42" C27LA

- SSD

- Samsung 990 PRO 2TB + 4TB / Western Digital SN850X 2x 4TB

- Gehäuse

- Corsair Obsidian 900D

- Netzteil

- Corsair AX1500i

- Keyboard

- SteelSeries Apex Pro TKL 2023

- Mouse

- Razer Viper V2 Pro white

- Betriebssystem

- Windows 10 Home

- Webbrowser

- Mozilla Firefox

- Internet

- ▼300 MBit ▲50 MBit

Das wärs doch...eine art "Bombe" die alle Themen zufuhr aus dem Gedächtnis löscht und alle Zuhörer wie sabbernde Hunde da sitzen lässt

Keine Angst...ich schlafe nur leicht

Keine Angst...ich schlafe nur leicht

Chezzard

Semiprofi

Dürftest du denn überhaupt was sagen wenn es soweit wäre Don?

Ich mag dich übrigens deine News sind immer Super, weiter so!

Die GK104 Tabelle kommt mir komisch vor.

Kann es mir wer erklären?

Fermi hat 3.2 Milliarden transen (Der alte, Die GTX580er hat nur mehr 3 Milliarden)

Kepler soll auch nur 3 Milliarden haben aber mehr Shader und mehr Rops?

Anscheinend wurde die SI-Rops-Shaderkonstellation geändert ist aber immernoch sinnfrei laut der Tabelle.

Etweder ist die Tabelle "Handgemacht" oder nVidia hat selbst noch keinen Plan (Ich bezweifle die 2. Möglichkeit sehr)

Ich mag dich übrigens deine News sind immer Super, weiter so!

Die GK104 Tabelle kommt mir komisch vor.

Kann es mir wer erklären?

Fermi hat 3.2 Milliarden transen (Der alte, Die GTX580er hat nur mehr 3 Milliarden)

Kepler soll auch nur 3 Milliarden haben aber mehr Shader und mehr Rops?

Anscheinend wurde die SI-Rops-Shaderkonstellation geändert ist aber immernoch sinnfrei laut der Tabelle.

Etweder ist die Tabelle "Handgemacht" oder nVidia hat selbst noch keinen Plan (Ich bezweifle die 2. Möglichkeit sehr)

scully1234

Banned

Oder die Shader selbst müssten fetter sein. Das Fragezeichen beim Shadertakt hab ich beim ersten Drüberlesen glatt übersehen. Das ist scheinbar noch nicht klar.

Die Folie von OBR sieht eher aus wie ein aufgebohrter und geshrinkter 580 dem man 2 zusätzliche 32er Shadercluster verpasst hat mit weiterhin bestehenden Hotclock

Zuletzt bearbeitet:

Neurosphere

Enthusiast

- Mitglied seit

- 06.11.2008

- Beiträge

- 4.324

Kann es mir wer erklären?

Fermi hat 3.2 Milliarden transen (Der alte, Die GTX580er hat nur mehr 3 Milliarden)

Kepler soll auch nur 3 Milliarden haben aber mehr Shader und mehr Rops?

Anscheinend wurde die SI-Rops-Shaderkonstellation geändert ist aber immernoch sinnfrei laut der Tabelle.

Etweder ist die Tabelle "Handgemacht" oder nVidia hat selbst noch keinen Plan (Ich bezweifle die 2. Möglichkeit sehr)

Nvidia weiß schon seit über einem Jahr wie Kepler aussehen wird, davon kann man ausgehen. Mit dem gleichen Transistorbudget müsste man schon alles Handdesignen damit auch ja kein Transistor zuviel gesetzt wird um auf die Werte der Tabelle zu kommen, da haste recht, sofern es dann keine Änderungen zu Fermi gab. Wobei ja eben letzteres die Tabelle sugerieren wil. Ich denke mal OBR wollte einfach mal was in den Raum werfen.

FortissimoIV

Neuling

SOLLTE - und ich schreibe bewusst sollte - diese Tabelle von OBR richtig sein, haben wir eben keine Hotclock mehr, denn dort steht ein N/A für not available. Im Umkehrschluss glaube ich dann kaum, daß 576 Shader ohne Hotclock an die GTX580 mit 512 Hotclock-Shadern heranreichen können. Grob braucht man zwei Non-Hotclock-Shader, um einen Hotclock-Shader zu ersetzen; bei gesteigerter Shadereffizienz etwas weniger. 576 Shader würden aber mit an Sicherheit grenzender Wahrscheinlichkeit nicht ausreichen, um GTX580 zu erreichen.

Entweder ist diese Tabelle Grütze, oder GK104 ist ein gutes Stück langsamer als GTX580; allenfalls GTX570-Niveau.

Entweder ist diese Tabelle Grütze, oder GK104 ist ein gutes Stück langsamer als GTX580; allenfalls GTX570-Niveau.

Chezzard

Semiprofi

Wobei ich bei deiner Argumentation darauf hinweisen möchte, dass du den TAKT aus der Rechnung gelassen hast.

Sollte bei gleichem Verbrauch das Doppelte an Takt bei gleicher Takt-Performance Verhältnissmaßigkeit herrschen, wäre dass dann wiederrum sehr gut.

Sollte bei gleichem Verbrauch das Doppelte an Takt bei gleicher Takt-Performance Verhältnissmaßigkeit herrschen, wäre dass dann wiederrum sehr gut.

Unrockstar

Enthusiast

- Mitglied seit

- 16.01.2005

- Beiträge

- 2.762

- Desktop System

- Haupt_PC

- Details zu meinem Desktop

- Prozessor

- 5700X

- Mainboard

- MSI X470 Gaming Plus Max

- Kühler

- Arctic Freezer 2 240

- Speicher

- Crucial Ballistix Sport 32GB DDR 3200

- Grafikprozessor

- EVGA 3060Ti

- Display

- HP Envy 32

- SSD

- PNY 1TB M.2 SSD, Crucial MX300 500GB (Div SSD)

- Soundkarte

- Steinberg UR22 MK2

- Gehäuse

- Fractal Define R5

- Netzteil

- Corsair TX550M

- Keyboard

- Corsair Strafe RGB

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Chrome

- Internet

- ▼100Mbit ▲19Mbit

Entweder ist diese Tabelle Grütze, oder GK104 ist ein gutes Stück langsamer als GTX580; allenfalls GTX570-Niveau.

Das wäre aber Mist, denn dann würde das preislich mit der alten Gen5 ja garnicht mehr passen.. Ich hoffe mal die OBR Folie ist einfach nur Mist. Das mitn Takt wäre natürlich zu berücksichtigen, aber nunja die CES geht ja nochn bissl, also vllt gibts ja gegen ende im verborgenen etwas

FortissimoIV

Neuling

Doppelter Takt? Ich sehe in dieser ominösen OBR-Tabelle 770MHz (GTX580) vs. 905MHz (GK104) als Taktangabe. Was ich in meiner Argumentation außenvor gelassen habe ist tatsächlich, daß dafür der gleiche Takt zugrunde gelegt wäre - aber ich bin davon ausgegangen, daß das soweit logisch und klar ist.

Kurz: Legen wir zugrunde, daß GK104 die Hotclocks wirklich fehlen (N/A), dann ist ein Chip mit den von OBR genannten Werten nichtmal so schnell wie GTX580 (was er als Performance-Chip IMHO auch nicht sein muss).

Kurz: Legen wir zugrunde, daß GK104 die Hotclocks wirklich fehlen (N/A), dann ist ein Chip mit den von OBR genannten Werten nichtmal so schnell wie GTX580 (was er als Performance-Chip IMHO auch nicht sein muss).

Ähnliche Themen

- Antworten

- 3

- Aufrufe

- 1K