Anhang anzeigen 961159Anhang anzeigen 961160Anhang anzeigen 961161Anhang anzeigen 961162Anhang anzeigen 961163Anhang anzeigen 961164Anhang anzeigen 961165Anhang anzeigen 961166

Projekt "Müslischachtel" (wurde von einem Freund so getauft)

2 Identische Mini Server, die von der Größe etwa eine Müslischachtel entsprechen. Wolf im Schafspelz..

Erforderte einiges an händischer Nacharbeit und Frickelei, da alles sehr eng ist. Musste den x8-Riser-Slot aufdremeln (x16-Riser passte nicht) und die SATA-Stromstecker ein wenig abdremeln weil zu dick.

Kurze technische Daten:

Board: Supermicro X10SDV-7TP4F (8C Broadwell Xeon-D)

Gehäuse: Supermicro CSE-E301

RAM: 4x32GB DDR4-2933 REG ECC

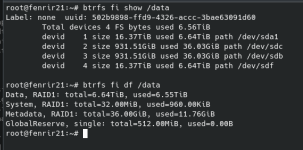

SSDs / Speicher: 2x Intel S4610 1.92TB Enterprise SATA

NIC 1: Intel E810-CQDA2 2x 100G QSFP28 (konfigurierbar in Breakout-Modi! Als eine der ganz wenigen NICs die das können)

NIC 2: Intel X550 2x 10G SFP+ (in die CPU integriert)

NIC 3: Intel i210 2x 1G RJ45 (in die CPU integriert)

OS: Proxmox 8.1 mit verschiedenen Guests

Verwendungszweck: All-In-One für den Aufbau von mobilen Netzwerken & Event-WiFi (WiFi Controller Ruckus Virtual Smartzone, DNS, DHCP, Router, etc)

FAQ:

Frage: Warum dieses Board mit SAS Controller und nicht etwas wie X10SDV-12C+-TP8F oder X10SDV-12C-TLN4F+?

Antwort: Weil ich sie zu einem sehr guten Preis bekommen habe, Supermicro Embedded Boards sind wahnsinnig teuer, ganz zu schweigen von den Varianten mit 8+ Kernen

Frage: Warum 2933er RAM? Er läuft doch nur mit 2133

Antwort: Weil ich ihn zu einem sehr guten Preis bekommen habe. Billiger als 2133er

Frage: Warum Intel E810 und nicht etwas wie Mellanox Connected-4/5/6?

Antwort: Weil die Intel E810 einer der wenigen NICs ist, die Breakout unterstützen (z.B. 8x10G oder 4x25G) und ich diese Funktion haben wollte, da sie praktisch sein könnte.

D) ganz fein geworden... also zweckmäßig.

D) ganz fein geworden... also zweckmäßig. ...

... ...

...

Deine Zigbee Geräte kommen dann auch mit beiden Coordinators klar? Bin mir grade nicht mehr sicher woran das Pairing genau hängt...

Deine Zigbee Geräte kommen dann auch mit beiden Coordinators klar? Bin mir grade nicht mehr sicher woran das Pairing genau hängt...