Ich bin vorrangig gespannt, wie es praktisch im Alltag funktioniert. Wenn ich mir das Prinzip in meinem Arbeits-Notebook vorstelle, könnte ich mir allerhand Vorteile ausmalen, allerdings bin ich äußerst skeptisch, dass der Scheduler von Windows das jeweils so hinbekommt, gerade mit Software, die nicht unbedingt speziell optimiert wurde.

Sehe ich weniger stark ein Problem mit. Der Scheduler "kennt" jetzt ja schon SMT und unterscheidet auch SMT und CMT von Bulldozer. Auch respektiert er bei AMD bspw. die Besten Cores und versucht die Last Peaks darauf abzubilden (maximaler Takt). Er respektiert auch die CCD Geschichte bei AMD, sodass die Last eines Tasks idealerweise im selben CCD gehalten wird.

Die Frage ist dann am Ende eher, wie funktioniert die Technik. Laufen alle Cores auch gleichzeitig? Oder schläft der "Mont" Part bei Last auf den "Lakes" Kernen?

Rein vom Prinzip her ist es zumindest einfacher so ein Prinzip mit in Summe vielen vielen Cores abzubilden als mit weniger vielen. Einfach weil idR die Käufer von großen Many Core CPUs in der Lage sein dürften entsprechend quasi beliebig in der Breite zu skalieren. Ein Cinebench skaliert relativ gleich über die Core Anzahl. Und es spielt auch quasi gar keine Rolle, wie hoch der Speed einer einzelnen Berechnung ist, weil die Gesamtzeit dsa Maß der Dinge sind. Im Desktop 8C + 8C mit weniger Bumms zu paaren, gibt dann einfach weniger als 16C mit viel Bumms aber immernoch entsprechend mehr wie nur die ersten 8C zu nutzen.

Im Mobile schaut das anders aus, da geht es idR nicht um massiv Multithread Woarkloads, sodass es eher darauf ankommt, wie gut die CPU interne Reglung zum Parken und Schlafenlegen der Cores funktioniert und wie viel Leistung man verliert, wenn die Lastpeaks zwischen den beiden Parts hin und her switchen - bzw. ob überhaupt?

Was ich mir vorstellen könnte, wenn der Prozessor Workload Muster versteht, dann könnte er diese Woarkloads anhand von Messwerten auf die langsamen Cores packen, wenn sie eine Schwelle unterschreiten. Zum Beispiel nach sagen wir gemessenen Taktzyklen mit Arbeit in den ALUs oder der FPU. Last die niedrig genug ist, würde auch der "Mont" Part ohne Nachteile abbilden.

Zusätzlich könnte eine intelligente Reglung der Leistungsaufnahme einfach nur durch Ausnutzen von physischen Gegebenheiten dafür sorgen, dass der Spaß deutlich! effizienter wird. Denn anstatt die letzten 100, 200, 300MHz aus dem Silizium zu prügeln um da unbedingt Allcore 5GHz und mehr zu sehen wäre vllt ein runter fahren der Taktrate auf 4,5GHz ratsam, oder gar nur 4GHz, um dann bei (gesponnen) nur halbem Verbrauch die anderen 8C unter Last mitrechnen zu lassen.

Die CPUs heute saufen nur so viel oben, weil sie ans Max. geprügelt werden. Schon zwei drei hundert MHz weniger und die Effizienz steigt extrem. Bei Zen machen 500MHz von knapp unter 4GHz auf 4,4-4,5GHz so viel Effizienzgewinn, dass der 5950X in der Lage ist 60, 70, 80% mehr MT Leistung zu liefern ggü. dem 5800X, ohne auch nur ansatzweise so viel mehr zu verbrauchen. Klappt bei Intel exakt genau so - nur haben sie atm nix, was breiter ist

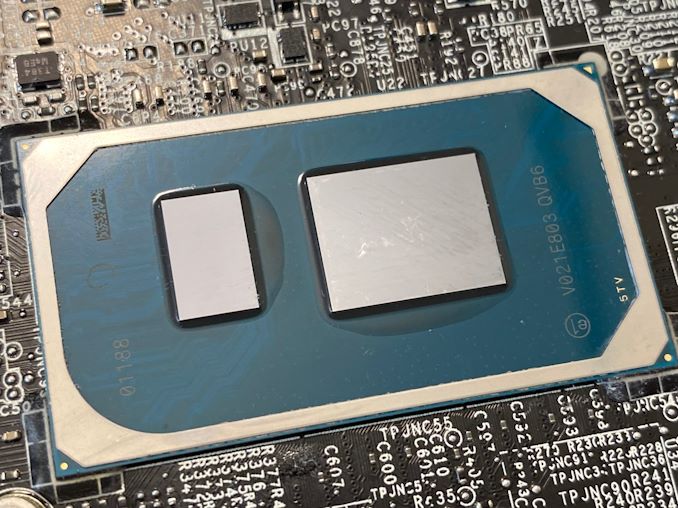

Alder Lake wird das fixen. Ob besser oder schlechter als vollwertige Kerne - abwarten.

) , lässt nichts Gutes erahnen - vorausgesetzt natürlich, die Folie ist echt.

) , lässt nichts Gutes erahnen - vorausgesetzt natürlich, die Folie ist echt.