NVIDIA GeForce GTX 690 + FAQ (Dual GK104) -Sammelthread

Impressionen der Karte:

Technische Daten der GeForce GTX 690

- Chip = Dual GK104

- Fertigung = 28 nm (TSMC)

- Transistoren = 2x 3,54 Milliarden

- Die-Größe = 2x 294 mm²

- Chiptakt = 915 MHz + Boost (1019 MHz)

- Shadertakt = Chiptakt (915 MHz + Boost (1019 MHz))

- Speichertakt = 1502 MHz

- Speichergröße = 2x 2048 MB

- Speichertyp = GDDR5 (Samsung)

- Speicherinterface = 2x 256 Bit

- Speicherbandbreite = 192,2 GB/Sek.

- Shader Model = 5.1

- DirectX = 11.1

- Shader-Einheiten = 2x 1536 (1D)

- Texture Mapping Units (TMUs) = 2x 128

- Raster Operations (ROPs) = 2x 32

- Rechenleistung Single Precision (SP) (MADD) = 2x 2,811 GFLOPs

- Pixelfüllrate = 2x 29,280 MPix/s

- Texelfüllrate = 2x 117,120 MTex/s

- Leistungsaufnahme 3D (TDP) = 300 Watt

- Leistungsaufnahme 2D = 15 Watt

- Versorgung über zwei 8-Pin PCI-Express Anschluss

- Anschlussmöglichkeiten = 3 x DVI (Dual-Link), 1 x mini-DisplayPort 1.2

- Hinweis: Multi-Monitoring = Die Karte kann bis zu vier Monitore gleichzeitig ansteuern, im 3D Modus maximal drei.

- Hinweis: Je nach Taktraten können Rechenleistung SP und DP, Pixelfüllrate und Texelfüllrate sowie Stromverbrauch abweichen

- Die Karte nutzt PCIe 3.0, ist aber völlig abwärtskompatibel

Reviews zur Karte:

Einzelkartentests - Referenz-Design:

- deutsch:

- HardwareLUXX - Test: NVIDIA GeForce GTX 690

- ComputerBase - Test: Nvidia GeForce GTX 690 Die 1.000-Euro-Karte

- NVIDIA GeForce GTX 690 im Test

- Test der Nvidia Geforce GTX 690: Die schnellste Grafikkarte der Welt

- Tom's Hardware - GeForce GTX 690 4 GB im Test: Doppelt so schnell, dreimal so schick

- -

- englisch:

- Guru3D - GeForce GTX 690 review

- Anandtech - NVIDIA GeForce GTX 690 Review: Ultra Expensive, Ultra Rare, Ultra Fast

- [H]ard|OCP - NVIDIA GeForce GTX 690 Dual GPU Video Card Review

- TechPowerUp! - NVIDIA GeForce GTX 690 4 GB

- Hardwareheaven - NVIDIA GeForce GTX 690 Dual-GPU

- -

Einzelkartentests - Non-Referenz-Design:

- deutsch:

- - im Moment keine

- englisch:

- - im Moment keine

Multi-GPU-Tests - Quad SLI:

- deutsch:

- - im Moment keine

- englisch:

- - im Moment keine

Geizhals Links:

Treiber:

Alle Infos und neuste Treiber findet ihr in diesem Thread hier

Aktuelle finale Treiber

Windows XP x86/x64, Windows Vista x86/x64 und Windows 7 x86/x64:

klick mich

Tools:

DX11 Benchmarks / Techdemos:

- Futuremark 3D Mark 11 (Basic Edition)

- Unigine Heaven 2.5 Benchmark

- Unigine Heaven 2.1 Benchmark

- Stone Giant 1.0 Techdemo (leider keine Benchmark Auswertung a la Heaven integriert -> per OSD via FRAPS lassen sich z.B. zusätzlich auch min. und max. fps aufzeichnen, Stone Giant kann nur current & avg. fps !

)

- Hinweis zur Bedienung in Stone Giant: Wichtigste Tasten -> F1 (Wireframe Modus ON/OFF), F2 (Tesselation Modi), F3 (Diffusion DoF (Depth of Field = Tiefenunschärfe) ON/OFF), F4 (current & avg. fps Counter ON/OFF), Pfeiltasten + Maus = freier Flug, ENTER = Benchmark Run)

- S.T.A.L.K.E.R. - Call of Pripyat Benchmark-Tool (getestet wird Day, Night (Gewitter), Rain und Sun - Ergebnisse als min., avg. und max. fps)

- Aliens vs. Predator DirectX 11 Benchmark Tool

- Lost Planet 2 Benchmark

FAQ (Frequently Asked Questions):

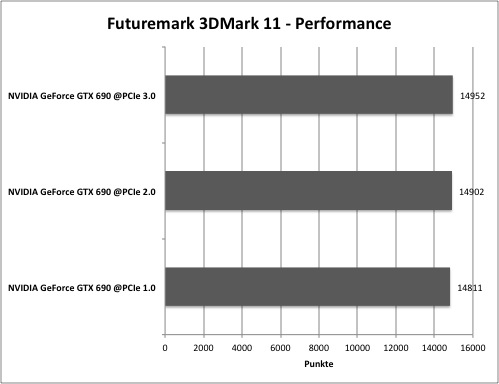

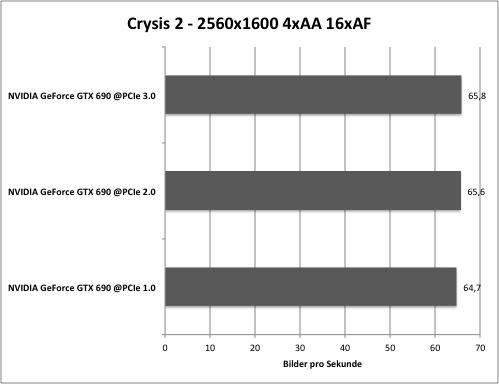

Brauche ich nun unbedingt ein Mainboard mit PCI-E 3.0?

Laut dem Test von VR-Zone bringt der PCI-E 3.0 Slot bei einer Radeon 7970 keine Leistungssteigerung.

Auch die Messungen auf Hardwareluxx mit einer GTX 690 bestätigen dieses Ergebnis. Hardwareluxx - Seite 19: Sondertests: PCI-Express 3.0

Damit kann man die Messungen anderer Reviews der aktuellen Grafikkartengeneration, ob Single oder Dual GPU 1:1, an der Stelle übernehmen und muss für eine Grafikkarte nicht extra umrüsten. Tests zur Quad-SLI Performance sind aber noch nicht verfügbar.

Zumindest mit einer GeForce GTX 690 bringt PCI-E 3.0 im besten Fall in Benches einen absolut minimalen Vorteil, spürbar ist es keines Falls. Das womöglich dadurch gesparte Geld steckt man an der Stelle lieber in mehr CPU Power oder in bessere Kühlung um dann mit OC mehr Performance raus kitzeln zu können.

Wie laut ist die Karte?

"Die GeForce GTX 690 profitiert offenbar von der guten Effizienz der GPUs und auch beim Lüfter scheint NVIDIA einiges richtig gemacht zu haben. Mit 35,4 dB(A) liegen wir nur etwas über der GeForce GTX 680, sind aber bereits leiser als eine Radeon HD 7970. Auch der Vergleich zum SLI-System bestehend aus zwei GeForce GTX 680 kann sich sehen lassen.

...

Das Testfeld wird unter Last etwas durcheinandergewirbelt, aber grundsätzlich ändert sich an der hervorragenden Ausgangsposition der GeForce GTX 690 nichts. Sie bewegt sich auf Niveau der Single-GPU-Karten - ein Ergebnis, das wir so nicht erwartet hätten. Gerade der Vergleich zu den Multi-GPU-Systemen, bestehend aus GeForce GTX 680 und Radeon HD 7970 sowie zu den Vorgänger-Karten GeForce GTX 590 sowie Radeon HD 6990, fällt positiv aus."

Wie hoch sind die Temperaturen der Karte?

Die Temperaturen liegen im Idle Betrieb im sehr guten Bereich für eine Dual GPU Karte (~34°C) und bewegt sich unter Last mit ~77°C sogar unter der Single GK104 GTX 680 bzw. dem SLI Gespann aus zwei dieser Karten.

Wie hoch ist der Stromverbrauch?

Hinweis: Die Verbrauchsmessungen (Karte only) stammen von HT4U -> klick

Die GeForce GTX 690 hat Dual GPU typisch mit einem höheren Idle-Stromverbrauch von ~25 Watt zu kämpfen. Die Konkurenz in Form der Top Single GPU Karten aktuell am Markt "schlucken" da ca. 10W weniger. AMDs GPUs dank Zero Core Technologie im abgeschalteten Zustand sogar unter 5W. Unter Spielelast nimmt die Karte (HT4U-Testmuster) mit Referenztaktraten ~ 290 Watt auf - in Furmark sind es ~325 Watt. Bemerkenswert sind die Lastverbrauchswerte im Vergleich zu den Dual GPU Karten der vergangenen Generation. Diese sprengten teilweise sogar die 400W Marke, wohingegen man die GTX 690 schon mit Furmark quälen muss, damit die 300W fallen.

Hier die Messungen (gesamtes System) von Hardwareluxx:

Wichtiger Hinweis: Die Verbrauchsmessungen sind immer von den eingesetzten Komponenten, etwa dem Netzteil, abhängig und somit eher als Anhaltspunkt zu sehen!

Passt die Karte in mein Gehäuse?

Das PCB der NVIDIA GeForce GTX 690 misst in der Länge 28 cm.

Wie gut läßt sich die Karte übertakten?

Wie auch die Single GK104 Karte GTX 680 lässt sich bei der Dual GK104 GTX 690 der Takt von Speicher und GPU/Shader nicht mehr direkt absolut einstellen. Man arbeitet stattdessen über einen "Offset" zur Basistaktrate. Oben drauf gewährt NVIDIA dem Nutzer noch einen Turbo-Mode, welcher dem OC Ergebnissen mal mehr, mal weniger im Weg steht.

Der Höhe der Turbotaktrate wird vollständig durch die Hardware geregelt. Es halten aber Messwerte wie Temperatur und anliegende Last in der Ermittlung der Höhe mit Einzug. So schankt die Taktrate der GPUs um ganz paar MHz während der Anwendung.

Im Hardwareluxx Test ließ sich für die GPU ein Offset von 106MHz und für den Speicher ein Offset von 104MHz erreichen. Bei optimalen Turbobedingungen erreichen die GPUs damit Taktraten von ~1176MHz.

Die Spannung gibt NVIDIA mit 1,175V als Maximum an. Diese Spannung liegt bei optimalen Turbobedingungen ebenso an den GPUs an. Ein weiteres steigern der Spannung ist hingegen kontraproduktiv, obwohl manche Tools Veränderungen an der vGPU Spannung zulassen. (auch nach oben hin)

Overclocking im Test

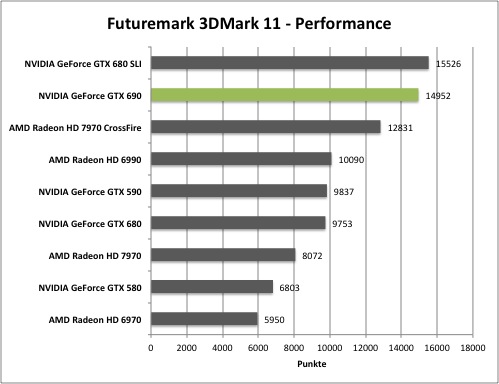

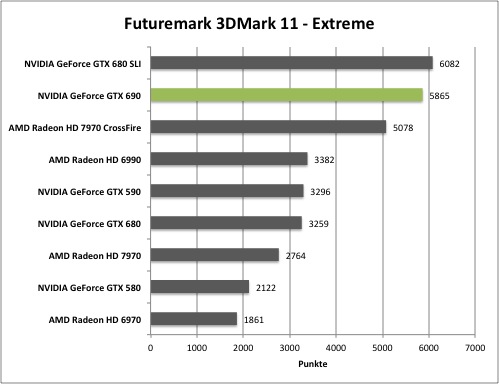

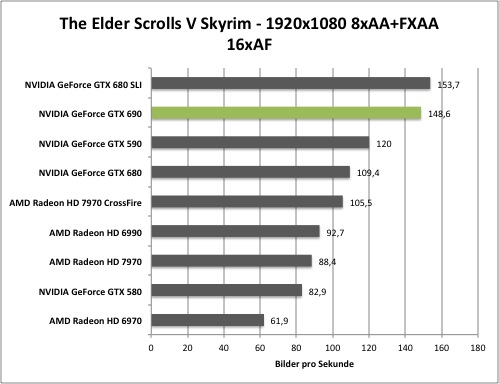

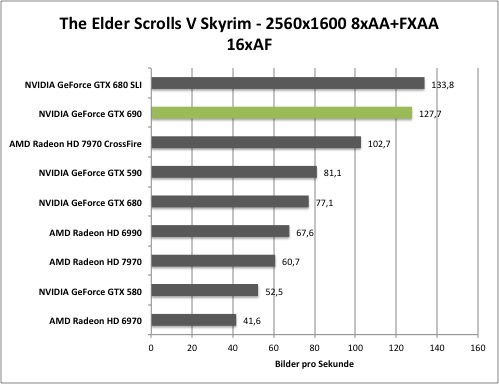

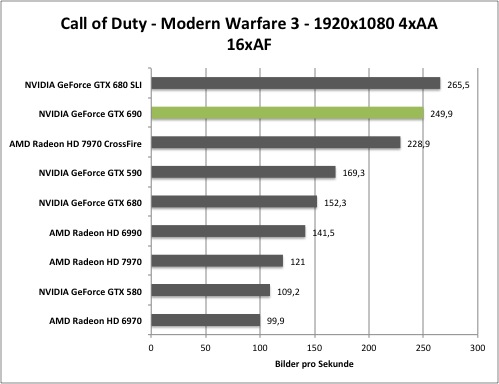

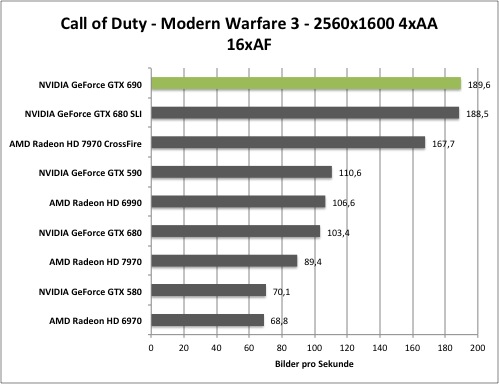

Die Performance:

Hier findet ihr eine kleine Auswahl von unseren Benchmarks um euch erstmal einen Überblick zu verschaffen, wo sich die Karte Leistungstechnisch einordnet. Alle weiteren Infos und Benchmarks findet ihr im Hardwareluxx Artikel zur GeForce GTX 690!

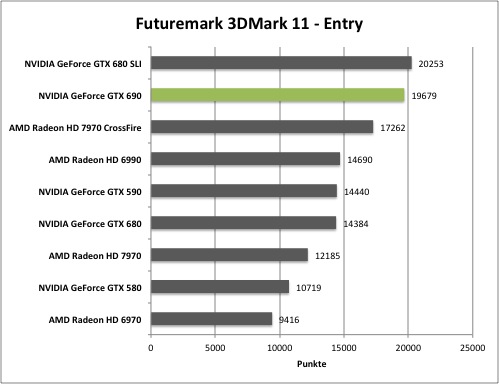

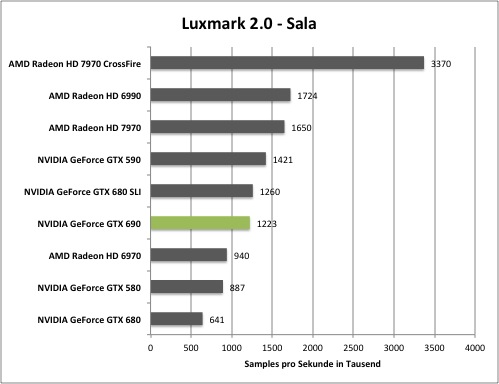

Synthetische Benchmarks

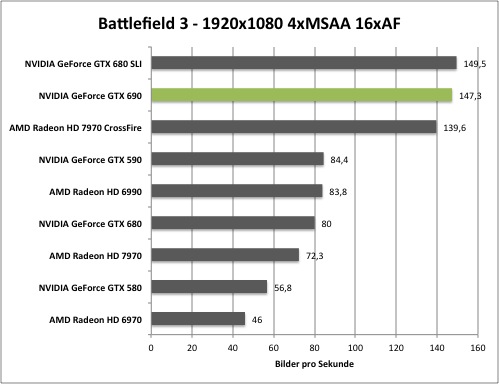

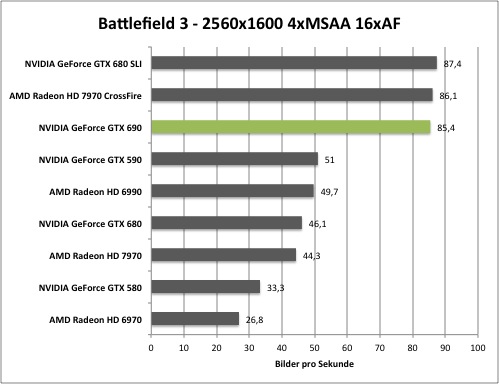

Game Benchmarks

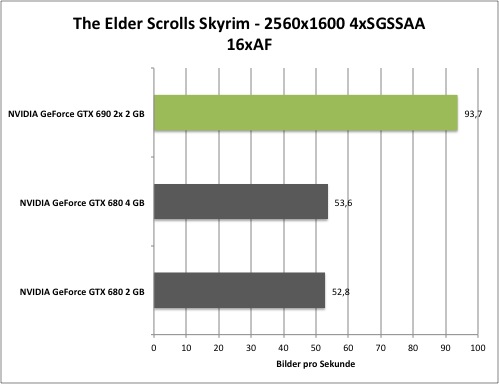

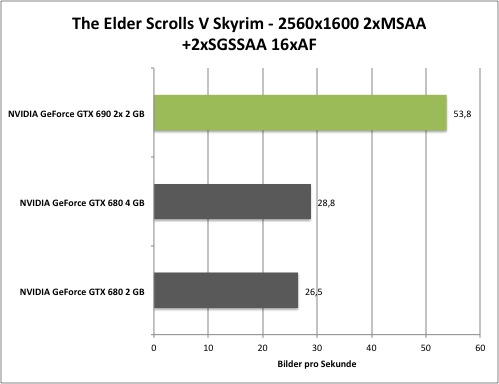

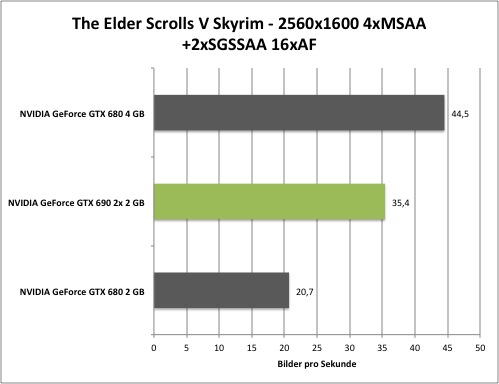

SSAA Benchmarks

Andere Kühllösungen

aktuell noch keine am Markt (05.05.2012)

Erhältliche WaKü-Blocks für die GeForce GTX 690:

Koolance: VID-NX690 (GeForce GTX 690)

Allgemeine Hinweise

Dies ist ein Sammelthread für die Geforce GTX 690. Das heißt, es darf und soll hier über die Karte diskutiert werden und den Usern auch als Kaufberatung dienen.

Natürlich ist ein Vergleich, etwa in Sachen Leistung, zu anderen Karten (GTX 6x0 und Radeon HD 7xx0 uvm.) angemessen.

Um das Geflame, Gespame oder sonstige Unannehmlichkeiten zu minimieren wird gebeten, im Falle eines Verstoßes gegen die Forenregeln den „Beitrag-melden“ - Button (http://www.abload.de/img/beitragmeldenz3p9c.png) zu benutzen!

Solche oder nicht themenbezogene Beiträge werden dann entfernt. Ggfls. können mehrmalig auffällige User auch aus dem Thread ausgeschlossen werden.

Gruß

Die Moderation des Grafikkarten-Unterforums

Zuletzt bearbeitet:

Perlen vor die Säue nennt man das....

Perlen vor die Säue nennt man das....

ODER eine ordentliche Multi-Kern Optimierung für das Spiel

ODER eine ordentliche Multi-Kern Optimierung für das Spiel ...na was kommt wohl als erstes

...na was kommt wohl als erstes