Da das Undervolten so viel Spaß macht und ein netter Zeitvertreib ist (wie für andere das Autotunen; bei mir um Spulenfiepen zu mindern und Stromverbrauch zu senken), habe ich mich die letzte Woche auch daran gemacht.

Igorslab Guide ist hier sehr hilfreich (aber teils mau erklärt), die Kommentare hier und anderswo auch. Danke dafür.

@Sodo

@Sodo

Das mit dem teils merkwürdigem (interessant, verwirrend) Verhalten ist mir auch aufgefallen.

Die Erklärung dazu (denke ich) habe ich in den Vermutungen/Erklärungen einiger Menschen hier gefunden, und meinen nun teils mehr als 80 Benchmarkdurchläufen.

Die Dinge die mir aufgefallen sind, sind den anderen ähnlich, aber allen voran mein eigenen.

1) Die Leistung der Amd Mitarbeiter bezüglich der Rdna2 Mikroarchitektur und der zahlreichen Algorithmen, Software, Sensoren etc. die im Hintergrund alles zu Stromverbrauch, Takt, Temperatur und unzählbaren weiteren Faktoren, ausloten und berechnen, ist exzellent. Da passieren abertausende Dinge im Nanosenkunden-Takt im Hintergrund, ohne Zutun des Benutzers.

Deutlich ausgefeilter als noch bei RX 5000.

So exzellent dass hier der Benutzer in 99 % der Fälle gar nichts mehr selber einstellen muss. Die restlichen 10 % an Effizienz/Übertaktung quetscht man nur noch selbst aus Ändern, der Vorgabe, der min./max. Werte zu Spannung/Frequenz der GPU/SoC (im MPT) selbst ein. Selbst hier macht die Mikroarchitektur etc. dann alles selbst.

2) Man quetscht also als Benutzer nur noch 10 % Effizienz/Übertaktung (meine Grafikkarte, bei gleichem Stromverbrauch) aus den Vorgaben zu den Werten aus.

Aus den Vorgaben macht die Mikroarchitektur etc. dann alles selbst.

Wie anderen aufgefallen ist der Regler im Wattman deswegen auch nur noch ein Spannungs-Offset-Schieber, kein Spannungs-slider und viele Einstellungen die bei RX 5000 (MPT) noch möglich waren, sind es nicht mehr.

3) Stromverbrauch ist das A und O. Jegliche Anpassung der zahlreichen Algorithmen, Software, Sensoren etc. orientiert sich beim Setzen des Takts etc. vor allem am Stromverbrauch.

4) Die Mikroarchitektur etc. passt die Werte nicht nur granular an (bei 70 °C Gpu-Temperatur läuft der Benchmark nur mit 2450 MHz-Slider und 1020 mV Spannungsschieber durch, bei bei 72 °C Gpu-Temperatur läuft der Benchmark nur mit 2430 MHz-Slider und 1030 mV Spannungsschieber durch, etc.)

sondern auch

deutlich grobkörniger.

5) Einstellung x für Benchmark y, funktioniert nicht für Benchmark z und Spiel p.

Benchmark/Spiel hat andere Auslastungen, beansprucht die GPU anders. Treibt man Effizienz/Übertaktung etc. auf die Spitze, benötigt jedes Programm, Spiel usw. andere Einstellungen.

Bei mir läuft z.B. gar kein Benchmark unter > 960 mV Spannungschieber im Wattman durch. Egal ob 2500 MHz Max. Frequenz, ob 2300 MHz, oder gar 2000 MHz.

MPT Maximum Voltage GFX, ob nun mit 1000 mV, 1025, 1050, 1075, 1100 etc. ist alles unterschiedlich. Mal Absturz nach 5 Sekunden, mal nach 5 Minuten.

Seltsamerweise läuft bei einigen Einstellungen im MPT/Wattman (hier unzählige ausprobiert), der Benchmark unter gleichen Einstellungen mit z.B. Max. Frequenz 2480 MHz mehrmals durch, stürzt aber nach Sekunden (immer wieder reproduzierbar) unter 2420 MHz ab.

Verwirrend könnte man meinen, da ein niedrigerer Takt eigentlich weniger Spannung benötigen sollten, und so weniger Stromverbrauch.

Erhöhe ich aber den Stromverbrauch um 5 Watt, läuft der Benchmark durch, unter anderen beinahe gleichen Einstellungen, dann aber wieder nicht. Dann läuft er aber bei - 10 W durch, dann wieder nicht.

Die Erklärung aus meinen Erkenntnissen ist die: Die Mikroarchitektur, Algorithmen, Software etc. steuern alles nicht nur sehr feinkörnig, sondern auch sehr grobkörnig.

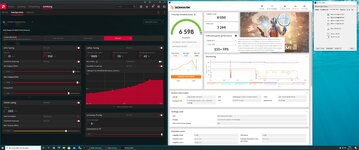

Die rote Linie hier im Bild wären die Vorgaben zu Stromverbrauch, Takt, Temperatur etc. Der Benchmark/Spiel das hiermit laufen soll. Die Spalte.

Die Zeilen sind alle unzähligen Vorgaben zu Stromverbrauch, Spannung, Takt, Temperatur und tausende andere.

Man schlängelt sich also durch diese Spalten und Zeilen durch und versucht eine bestimmte Spanne (Bereiche) zu finden welche die Einstellungen zulässt, welche tausendfach, alle voneinander abhängig sind (mal größer/kleiner die Bereiche, mal enger/breiter) und sich im Nano-/Mikrosekundentakt ändern.

Wie ich gemerkt habe ist wahrscheinlich deswegen, die Vorgabe zum Stromverbrauch, der wichtigste Einstellunsmöglichkeit.

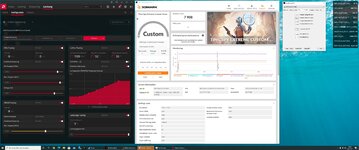

Setze ich das Limit auf 230 W GPU (+40 W alles andere, Gesamt ~270 W), Maximum Voltage GFX auf 1050 mW, Spannungs-Offset-Schieber auf 970 mV, max. GPU-Frequenz auf 2480 MHz, stürzt Timespy nach 20 Sekunden reproduzierbar ab.

Verringere ich die Maximum Voltage GFX auf 1030 mV, stürzt Timespy nach 1 Minute ab.

GPu schafft es den Takt unter den Vorgaben bei Szenen x 1 Minute lang zu halten, läuft dann aber bei Szene y in ein Szenario wo es denn Takt unter Stromverbrauch 230 W nicht mehr halten kann und Fehler verursacht.

Max. GPU-Frequenz auf 2400 MHz, könnte man meinen sollte laufen; stürzt aber nach 5 Sekunden ab. Der niedrige Takt gemeinsam mit der niedrigeren Temperatur sorgt hier dafür dass die GPU den Takt nun fast immer halten kann (dieser also größtenteils höher ist).

Ergo die Grafikkarte verbraucht mehr Strom, obwohl die Einstellung zu GPU-Frequenz niedriger ist. Die Bildrate ist höher.

Zwar wird der Takt also höher und länger gehalten, aber die GPU läuft wieder in das Stromlimit.

@Sodo

Das ist was dir, mir und vielen anderen hier im Thread und anderen Foren aufgefallen ist.

Was mich jetzt halt so richtig verwirrt, ist dass die Karte mit der geringsten Taktfrequenz auf einmal säuft als gäbe es morgen keinen Strom mehr.

Mehr Leistung obwohl die Einstellungen genau das Gegenteil vermuten lassen.

Das ist ein erheblicher Wechsel der Spielregeln zu vorherigen Mikroarchitekturen, Algorithmen etc. der vorherigen Generationen wie RX 5000 usw.

Erhöhe ich das Stromlimit um 10 W, läuft es alles durch. Stürzt beim dritten Benchmark aber ab. Ursache? Wohl die Temperatur von 72 °C.

Wieder Spannung runter. Läuft. Mist - stürzt nach 20 Minuten wieder ab.

Dann gesellt sich noch der SoC dazu. Stromverbrauch erfolgreich um 8 Watt gesenkt. Mist, stürzt hier und da auch ab, läuft wiederum mit anderer Einstellung problemlos.

Kurz: Die Angelegenheit ist wirklich ein spaßiger Spießrutenlauf, bei die Lanzen mal kürzer, mal länger sind.

Die Erkenntnis ist, die Mikroarchitektur, Algorithmen etc. sind die

Dirigenten. Sie erledigen alles selber. Der Benutzer ordnet sich immer unter; die zweite Geige.

Der Benutzer kann nur noch die Vorgaben zu einigen wenigen Faktoren ändern (im MPT) - selbst der Spannungschieber ist nur noch ein Offset-, aus denen die Grafikkarte dann schlussendlich auch alles selber erledigt.

Wenn die Entwicklung weiter anhält, könnte man zukünftig vllt. nur noch Vorgaben zum Stromverbrauch machen.

Ob solch eine Änderung vorgesetzt wird, ist natürlich fraglich, da es die Kunden nicht mögen würden.

Erstaunliche Entwicklung.

also Voltage wieder etwas hoch

also Voltage wieder etwas hoch