Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

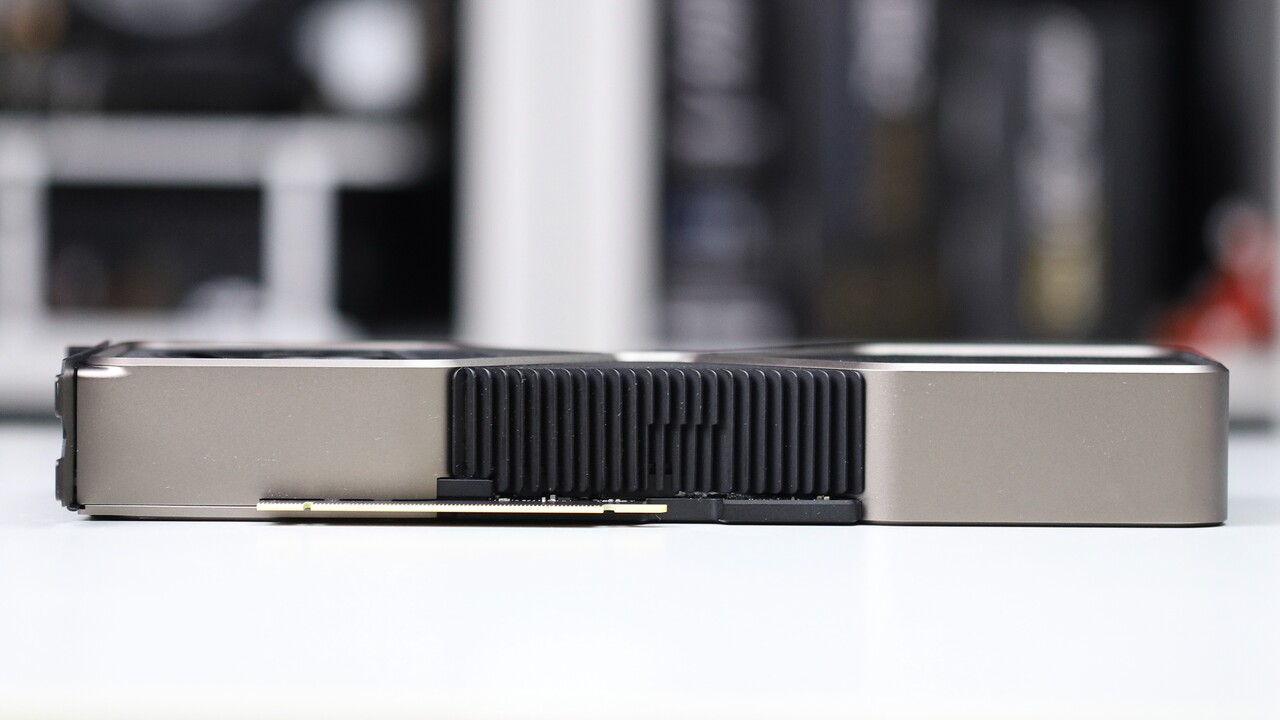

RTX 4080/4070 nun doch geringerer Verbrauch - Mögliche RTX 4080 Ti mit 20 GB bahnt sich an

- Ersteller HWL News Bot

- Erstellt am

Ich war auch mit der 3090 dick dabei, konnte aber meine 3 Karten GUT weiterverkaufen, sehe das irgendwo nichtmehr ein. Hab jetzt n kleineres Sys für PC Only Games und ne Series X und PS5 am Oled.

Ist halt lächerlich, 6700XT um 500, da bekomm ich mit derselben Grafikpower ne komplette Series X für..

Ich bastel immernoch gerne ,aber das geht auch mit Gebraucht Hardware. Mobos ist ja auch lächerlich, gute Boards 500++ Euro, mein Best ausgestattetes Z390 Taichi Ultimate inkl 3x Lan und 10G lan, 250 Euro NEU damals

Das immer mehr Leute es nichtmehr Einsehen sieht man ja...

Ja ich weiss auch mining fällt weg, aber nicht nur..

www.computerbase.de

www.computerbase.de

Achja ich weiss ja nicht wies euch geht, aber MEIN Gehalt ist nicht in dem Maße gestiegen wie die HW Preise der letzten Jahre..

Ist halt lächerlich, 6700XT um 500, da bekomm ich mit derselben Grafikpower ne komplette Series X für..

Ich bastel immernoch gerne ,aber das geht auch mit Gebraucht Hardware. Mobos ist ja auch lächerlich, gute Boards 500++ Euro, mein Best ausgestattetes Z390 Taichi Ultimate inkl 3x Lan und 10G lan, 250 Euro NEU damals

Das immer mehr Leute es nichtmehr Einsehen sieht man ja...

Ja ich weiss auch mining fällt weg, aber nicht nur..

ad-hoc-Mitteilung: Nvidias Umsatz und Marge im Bereich Gaming sinken stark

Nvidias 2. Quartal ist ganz anders gelaufen als geplant, wie der Konzern zwei Wochen vor dem offiziellen Termin bekanntgibt.

Achja ich weiss ja nicht wies euch geht, aber MEIN Gehalt ist nicht in dem Maße gestiegen wie die HW Preise der letzten Jahre..

Zuletzt bearbeitet:

VL125

unverhältnismäßig absurd

- Mitglied seit

- 19.05.2005

- Beiträge

- 14.128

- Details zu meinem Desktop

- Prozessor

- 3900x

- Mainboard

- Asus B550-Plus tuf gaming

- Kühler

- Azza 360 AIO oder nhd15 je nach Laune

- Speicher

- 32GB 3200Mhz cl16

- Grafikprozessor

- ASRock 6950XT Phantom Gaming

- SSD

- P1 1TB

- Netzteil

- corsair 1000e

- Betriebssystem

- Windows 10

Also meinst hat sich in den letzten 10 Jahren fast verdoppelt, dennoch bin ich bei weitem nicht bereit mehr wie 500 für sowas auszugeben

Bei uns gabs immer mehr Urlaub, mehr Geld auch aber eher 50% in 10 Jahren , dafür mittlerweile 53 ! Tage Urlaub im Jahr und ich bin kein Lehrer

Selbst bei verdoppeltem Gehalt, die Hardwarepreise haben sich in 10 Jahren MINDESTENS verdreifacht..

Selbst bei verdoppeltem Gehalt, die Hardwarepreise haben sich in 10 Jahren MINDESTENS verdreifacht..

Zuletzt bearbeitet:

ssj3rd

Urgestein

Dein neu erworbener Alienware Monitor kann doch gar kein 4K 😏Meine 1080 möchte wahrlich bald ersetzt werden, um in 4K zu spielen.

Scrush

Legende

- Mitglied seit

- 31.12.2008

- Beiträge

- 60.175

ssds und ram eigentlich nicht. NTs sind nen ticken teurer geworden.Bei uns gabs immer mehr Urlaub, mehr Geld auch aber eher 50% in 10 Jahren , dafür mittlerweile 53 ! Tage Urlaub im Jahr und ich bin kein Lehrer

Selbst bei verdoppeltem Gehalt, die Hardwarepreise haben sich in 10 Jahren MINDESTENS verdreifacht..

monitore gibts für jeden was. 1080p144hz ips freesync sind wir mit 180 € dabei

mainboard sind etwas teurer geworden unten rum ja. oben rum leider immens....

grakas.. ja kennen wir ja.

cpus haben wir mehr auswahl statt fürher nen 6600k und ab zur kasse.

BimboJones

Enthusiast

- Mitglied seit

- 09.10.2013

- Beiträge

- 255

warte schon sehnsüchtig auf die 4090.

DocOc

Enthusiast

- Mitglied seit

- 08.09.2005

- Beiträge

- 477

- Ort

- Krefeld

- Desktop System

- k. A.

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- ASUS ROG Strix X670E-A

- Kühler

- NZXT Kraken Z63

- Speicher

- Kingston FURY Renegade RGB DDR5-6000, CL32-38-38 Kit 32GB

- Grafikprozessor

- Gainward GeForce RTX 4090 Phantom GS

- Display

- Samsung 65S95B QD-Oled, LG 38UC99-W, 37.5

- SSD

- Samsung M.2 1TB u. 2TB 980 Pro

- Gehäuse

- Lian Li PC-O11 Dynamic Mini

- Netzteil

- ASUS ROG Loki Platinum 850W

- Keyboard

- Logitech Craft

- Mouse

- Logitech G305

- Betriebssystem

- Win11

- Sonstiges

- AV Receiver Denon AVC-X4700H, 5.1.4 Lautsprecher Monitor Audio Silver und Dali Alteco C1, Subwoofer SVS SB2000

Bei der vorletzten Generation machte die RTX 2080ti den Anfang, daher tippe ich mal auf die 4080ti im Oktober...

MeisterOek

Experte

- Mitglied seit

- 05.09.2016

- Beiträge

- 144

Mein TV aberDein neu erworbener Alienware Monitor kann doch gar kein 4K 😏

Aktuell sehe ich PC Gaming auch irgendwie am Scheideweg. Für die breite Masse passt da Vieles überhaupt nicht mehr zusammen.

Die Preise für Hardware sind insgesamt deutlich gestiegen, es gibt kaum empfehlenswerte Low-Budget Konfigurationen (sowas wie

einen Ryzen 2600 + 90€ für ein nettes B450 Board), seit ~3 Jahren ist keine gute Einsteiger-GPU alla´ GTX 970, GTX 1060 oder AMD

R 460/470 mehr rausgekommen und der Stromverbrauch vieler Komponenten ist dazu gestiegen.

Gebrauchtmarkt ist sicher immer eine Möglichkeit, aber viele schrecken vorm Gebrauchtkauf zurück. In meinem Umfeld geht der

Trend schon seit 2019/2020 ganz deutlich zum kleinen Office-Laptop und zur Konsole fürs Zocken. Vorallem wenn es um Kinder

und Jugendliche geht, einen 1000€+ Gaming PC, der dann 300-400w verbrät, sind immer weniger Eltern bereit zu kaufen.

Ich selbst hänge irgendwie immer noch an meinen hochpreisigen Rechnern, aber langsam fällt es mir schwer mir eine 1000€ "High-End"

und 700€ "Mittelklasse" GPU pro Generation schön zu reden. Vielleicht liegt es am Alter, aber die Spiele, welche ich umbedingt nahe

des Releases auf dem PC spielen musste und die meinen Rechner dann auch wirklich voll gefordert haben, kann ich in den letzten 5

Jahren an zwei Händen abzählen . Jetzt spiele ich gerade Dark Star One und wieder mal World of Warcraft am PC und hänge sonst

. Jetzt spiele ich gerade Dark Star One und wieder mal World of Warcraft am PC und hänge sonst

häufig an meiner Switch und an der Playstation Vita .

.

Die Preise für Hardware sind insgesamt deutlich gestiegen, es gibt kaum empfehlenswerte Low-Budget Konfigurationen (sowas wie

einen Ryzen 2600 + 90€ für ein nettes B450 Board), seit ~3 Jahren ist keine gute Einsteiger-GPU alla´ GTX 970, GTX 1060 oder AMD

R 460/470 mehr rausgekommen und der Stromverbrauch vieler Komponenten ist dazu gestiegen.

Gebrauchtmarkt ist sicher immer eine Möglichkeit, aber viele schrecken vorm Gebrauchtkauf zurück. In meinem Umfeld geht der

Trend schon seit 2019/2020 ganz deutlich zum kleinen Office-Laptop und zur Konsole fürs Zocken. Vorallem wenn es um Kinder

und Jugendliche geht, einen 1000€+ Gaming PC, der dann 300-400w verbrät, sind immer weniger Eltern bereit zu kaufen.

Ich selbst hänge irgendwie immer noch an meinen hochpreisigen Rechnern, aber langsam fällt es mir schwer mir eine 1000€ "High-End"

und 700€ "Mittelklasse" GPU pro Generation schön zu reden. Vielleicht liegt es am Alter, aber die Spiele, welche ich umbedingt nahe

des Releases auf dem PC spielen musste und die meinen Rechner dann auch wirklich voll gefordert haben, kann ich in den letzten 5

Jahren an zwei Händen abzählen

. Jetzt spiele ich gerade Dark Star One und wieder mal World of Warcraft am PC und hänge sonst

. Jetzt spiele ich gerade Dark Star One und wieder mal World of Warcraft am PC und hänge sonsthäufig an meiner Switch und an der Playstation Vita

- Mitglied seit

- 01.01.2007

- Beiträge

- 11.372

- Ort

- Exil

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 9800X3D (@ 5,375 GHz)

- Mainboard

- ASRock X870E Taichi

- Kühler

- Watercool Heatkiller IV & MO-RA3

- Speicher

- G.Skill Trident Z5 RGB 48GB @ DDR5-6000 / CL30

- Grafikprozessor

- MSI GeForce RTX 4090 Suprim X (@ 2,95 GHz)

- Display

- Dell Alienware AW3423DW QD-OLED

- SSD

- Seagate FireCuda 530 1TB | Corsair MP400 4TB | WD Black SN850X 4TB

- Soundkarte

- Creative Sound Blaster X4

- Gehäuse

- Phanteks Enthoo Primo

- Netzteil

- Corsair HX850i Platinum

- Keyboard

- Corsair K70 RGB MK.2 Rapidfire Low Profile

- Mouse

- Mionix Naos 7000

Meinen die bei der 4090 Verkaufsstart im Oktober oder nur Vorstellung? Könnte ja doch eher November werden

- Mitglied seit

- 26.07.2017

- Beiträge

- 742

Der reduzierte Verbrauch ist eine erfreuliche Entwicklung, das war notwendig. Ansonsten hat Nvidia die Kunden in den letzten Jahren zu stark gemolken in meinen Augen. Die originalen Ampere MSRP Preise (3060, 3070, 3080, 3090) waren fair, aber durch den Mining Dreck ging eh alles weg, weshalb Nvidia mehrfach die MSRP Preise erhöht hat und weil das ja nicht genug war wurden sinnlose Ti-Karten völlig ohne Mehrwert mit erheblichem Aufpreis rausgebracht. Bei Verfügbarkeit der Non-Ti Karten wären das üble Ladenhüter geworden.

- 3070 Ti 20% Aufpreis für 5-10% mehr Leistung bei 20% mehr Verbrauch

- 3080 Ti 70% Aufpreis für 5-10% mehr Leistung bei 10% mehr Verbrauch (wenigstens 2GB mehr VRAM)

- 3090 Ti 36% Aufpreis für 5-10% mehr Leistung bei 28% mehr Verbrauch

- Mitglied seit

- 26.07.2017

- Beiträge

- 742

Die 3080 war mit 699€ schon Spitze, in 95% reicht der Speicher und wenn nicht einfach Texturdetails eine Stufe runter.

Insgesamt war das Ampere Release Roundup gelungen, da war für fast jeden was dabei und auch bezahlbar. Auch die 3060 für 339€ war top, oder die 3060Ti für 399€. Nur der Speicher war etwas mager.

Ich befürchte nur eben, dass Nvidia nicht begreift, dass die Mining-Preise nur deshalb bezahlt wurden, weil die Krypto Spekulanten die Spielerkarten zur Gelddruckmaschine gemacht haben. Preise jenseits der 500€ zahlen nur wenig „Mainstream Gamer“ und jenseits der 1000€ ist selbst von den leidenschaftlichen Gamern nur noch ein Bruchteil dabei. Und es stößt mir einfach auf, dass dieses winzige Segment immer weiter separiert wird. Die 3080 wird dank Inflation und Euroschwäche 899€ kosten und darüber haben wir noch 80Ti, 90, 90Ti und Titan.

Eine GTX 1070 mit 104 Chip und 8GB@256bit gabs 2016 für 450€ und dafür wird man 2022 bei Ada wohl einen 106er Chip mit 10GB@160bit bekommen 🤮

Insgesamt war das Ampere Release Roundup gelungen, da war für fast jeden was dabei und auch bezahlbar. Auch die 3060 für 339€ war top, oder die 3060Ti für 399€. Nur der Speicher war etwas mager.

Ich befürchte nur eben, dass Nvidia nicht begreift, dass die Mining-Preise nur deshalb bezahlt wurden, weil die Krypto Spekulanten die Spielerkarten zur Gelddruckmaschine gemacht haben. Preise jenseits der 500€ zahlen nur wenig „Mainstream Gamer“ und jenseits der 1000€ ist selbst von den leidenschaftlichen Gamern nur noch ein Bruchteil dabei. Und es stößt mir einfach auf, dass dieses winzige Segment immer weiter separiert wird. Die 3080 wird dank Inflation und Euroschwäche 899€ kosten und darüber haben wir noch 80Ti, 90, 90Ti und Titan.

Eine GTX 1070 mit 104 Chip und 8GB@256bit gabs 2016 für 450€ und dafür wird man 2022 bei Ada wohl einen 106er Chip mit 10GB@160bit bekommen 🤮

Sry aber ich gebe keine 700++ aus um irgendwas runterzustellen, wenn man soviel Geld ausgibt will man alles hochstellen, oder nicht ?

Ich glaube bei ner 16GB 3080 hätte ich (und viele Andere) die statt der 3090 genommen..

Ja die GTX 1xxx Serie warn richtiger Knaller, doppelter Vram zur Vorgängergen, richtig fett Mehrleistung und Preise noch ok.

Heute haben die meist noch genug Leistung für Viele.

Ich glaube bei ner 16GB 3080 hätte ich (und viele Andere) die statt der 3090 genommen..

Ja die GTX 1xxx Serie warn richtiger Knaller, doppelter Vram zur Vorgängergen, richtig fett Mehrleistung und Preise noch ok.

Heute haben die meist noch genug Leistung für Viele.

- Mitglied seit

- 10.05.2006

- Beiträge

- 5.575

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D @150 W

- Kühler

- Noctua NH-D15 G2

- Speicher

- 32 GB DDR4

- Grafikprozessor

- PNY 3090 @3x Noctua NF-A9

- Display

- LG OLED42C29LB

- SSD

- Samsung 990 Pro 2TB || Evo 850 4TB || PM981a 1TB

- Soundkarte

- SoundBlaster X7 LE

- Gehäuse

- Jonsbo Z20W

- Netzteil

- Corsair SF750

- Keyboard

- Cherry KW X ULP

- Mouse

- Razer Viper Ultimate

- Sonstiges

- Ora Funky Cat 400 Pro

- Internet

- ▼100 ▲40

Jeden Tag der selbe Typ mit "neuen Spezifikationen".

Jungs, ich gebe es zu: Ich bin das! Und ich saug mit die Daten einfach aus den Fingern.

Wobei: Morgen bin ich es vielleicht nicht mehr. Mal überlegen...

Hauptsache ihr berichtet drüber und subscribed schön. 🤭

Jungs, ich gebe es zu: Ich bin das! Und ich saug mit die Daten einfach aus den Fingern.

Wobei: Morgen bin ich es vielleicht nicht mehr. Mal überlegen...

Hauptsache ihr berichtet drüber und subscribed schön. 🤭

- Mitglied seit

- 03.10.2006

- Beiträge

- 15.185

- Ort

- Pampa

- Desktop System

- PSBOX

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Strix X670E-A

- Kühler

- EK Velocity

- Speicher

- Kingston Fury Renegade 64GB

- Grafikprozessor

- RTX 5090 incoming

- Display

- Asus Rog Swift PG32UCDM

- SSD

- M.2 1TB SIlicon M.2 980Pro 2TB M.2 980Pro 1TB

- Soundkarte

- Soundblaster G6 +HIFIman Arya+Endgear Microfon

- Gehäuse

- Lian Li O11 Vision Chrome Mora 420

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech G915

- Mouse

- G502

- Betriebssystem

- Win11 Pro

- Internet

- ▼100mbit

Jeden Tag der selbe Typ mit "neuen Spezifikationen".

Jungs, ich gebe es zu: Ich bin das! Und ich saug mit die Daten einfach aus den Fingern.

Wobei: Morgen bin ich es vielleicht nicht mehr. Mal überlegen...

Hauptsache ihr berichtet drüber und subscribed schön. 🤭

GPU-Gerüchte: Leaks zu GeForce RTX 4000 sollen mehr Substanz erhalten

Nvidia soll Partner mit Informationen zur Entwicklung von Custom-Designs der Generation GeForce RTX 4000 versorgt haben.

Die nächste Zeit sollten die Infos genauer werden wen wundert es auch man kommt ja auch dem Release näher😂

Zuletzt bearbeitet:

Nordbadener

Experte

Die im Bericht gezeigte Modell-Übersicht von Nvidia wirkt auf mich stimmig und sinnvoll. NV hätte damit 3 AD102-Modelle gegen AMD positioniert, das ebenfalls mit drei Top-Modellen mit Navi 31 starten soll. Die 4080TI wäre der perfekte Gegenpart zur RX 7900XT. Hier würde auch die oft genannte TDP von 420 Watt gut passen.

Da AMD zuerst Navi 31 launched, wäre ein Frühstart der 4080TI naheliegend.

Da AMD zuerst Navi 31 launched, wäre ein Frühstart der 4080TI naheliegend.

Scrush

Legende

- Mitglied seit

- 31.12.2008

- Beiträge

- 60.175

Sry aber ich gebe keine 700++ aus um irgendwas runterzustellen, wenn man soviel Geld ausgibt will man alles hochstellen, oder nicht ?

Ich glaube bei ner 16GB 3080 hätte ich (und viele Andere) die statt der 3090 genommen..

Ja die GTX 1xxx Serie warn richtiger Knaller, doppelter Vram zur Vorgängergen, richtig fett Mehrleistung und Preise noch ok.

Heute haben die meist noch genug Leistung für Viele.

als wir nur 1080p60 monitor hatten war das noch richtig aber wir haben heute von 1080p bis 4k von 60-240hz die große auswahl und somit wird es momente geben wo man die settings runterstellen muss um seine gewünschten fps zu erreichen

Tech Enthusiast

Enthusiast

- Mitglied seit

- 01.01.2016

- Beiträge

- 3.609

- Desktop System

- PC

- Laptop

- Surface

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 - 5950X

- Mainboard

- Asus Dark Hero x570

- Kühler

- Noctua NH D15

- Speicher

- 32gb - Vengeance 3200

- Grafikprozessor

- PNY RTX 4090

- Display

- 4-eckig

- SSD

- 2tb Samsung 970 Evo

- Gehäuse

- Define zu alt

- Netzteil

- Asus Thor 850W

- Betriebssystem

- Windows 10

- Webbrowser

- Chrome

- Internet

- ▼1150 MBit ▲54 MBit

Befürchte, das ist eher ein Marketing "Leak".

320 klingt einfach besser als 420.

Effektiv werden die GPUs beides abkönnen. Bei 320 ist sie halt dann effizienter, aber auch langsamer.

Relevant wird eher: Wie viel FPS gewinnt die GPU mit den 100 Watt? Ist der Unterschied nicht zu krass, lass ich die eh bei 250 oder 200 laufen.

Wird ne spannende Generation. Hoffe AMD liefert nicht zu weit davor / danach. Will nen Upgrade und bin sicher zu ungeduldig, um Monate auf den vergleich zu warten. ;-)

320 klingt einfach besser als 420.

Effektiv werden die GPUs beides abkönnen. Bei 320 ist sie halt dann effizienter, aber auch langsamer.

Relevant wird eher: Wie viel FPS gewinnt die GPU mit den 100 Watt? Ist der Unterschied nicht zu krass, lass ich die eh bei 250 oder 200 laufen.

Wird ne spannende Generation. Hoffe AMD liefert nicht zu weit davor / danach. Will nen Upgrade und bin sicher zu ungeduldig, um Monate auf den vergleich zu warten. ;-)

TheBigG

Enthusiast

- Mitglied seit

- 24.05.2010

- Beiträge

- 2.756

Es gibt keine Reduzierung des Verbrauchs, die Chips existieren ja schon, es ist nur eine Reduzierung des Power limits. Da ist nichts erfreulich dran, das bedeutet nur das die Karten stärker eingebremst werden ohne das der Kunde Kontrolle darüber hat.Der reduzierte Verbrauch ist eine erfreuliche Entwicklung, das war notwendig.

Zuletzt bearbeitet:

panopticum

Enthusiast

- Mitglied seit

- 30.09.2003

- Beiträge

- 2.568

- Ort

- Thüringen

- Laptop

- Lenovo ThinkPad E15 G4 AMD Ryzen 7 5825U 16GB 1TB SSD

- Details zu meinem Desktop

- Prozessor

- 5800X3D

- Mainboard

- ASUS ROG STRIX B550-I

- Kühler

- NZXT Kraken X63

- Speicher

- GSkill 3800C14

- Grafikprozessor

- Gigabyte 3080 Gaming OC

- Display

- Dell S2721DGF

- SSD

- Corsair MP600 2TB

- Soundkarte

- onboard

- Gehäuse

- ssupd Meshilicious

- Netzteil

- Corsair SF750

- Keyboard

- Wooting 60HE

- Mouse

- G Pro wireless

- Betriebssystem

- W10

- Webbrowser

- FF

- Sonstiges

- OP12

- Internet

- ▼250 ▲40

Wenn der Kühler dann trotzdem für 420W dimensioniert ist und die Leistung nach nV Ermessen bei 320W genügt wäre das doch ne gute Sache, oder?

Tech Enthusiast

Enthusiast

- Mitglied seit

- 01.01.2016

- Beiträge

- 3.609

- Desktop System

- PC

- Laptop

- Surface

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 - 5950X

- Mainboard

- Asus Dark Hero x570

- Kühler

- Noctua NH D15

- Speicher

- 32gb - Vengeance 3200

- Grafikprozessor

- PNY RTX 4090

- Display

- 4-eckig

- SSD

- 2tb Samsung 970 Evo

- Gehäuse

- Define zu alt

- Netzteil

- Asus Thor 850W

- Betriebssystem

- Windows 10

- Webbrowser

- Chrome

- Internet

- ▼1150 MBit ▲54 MBit

In der Theorie ja.Wenn der Kühler dann trotzdem für 420W dimensioniert ist und die Leistung nach nV Ermessen bei 320W genügt wäre das doch ne gute Sache, oder?

In der Praxis wird kaum ein Kühler "überdimensioniert" sein, wenn man nicht dick draufzahlt. Siehe Strix und Co. Modelle.

Und 100 Watt weniger Powertarget sind auch weniger Leistung. Die bringt nicht einfach identische Leistung, mit 25% weniger Strom.

Relevant wird, wie gesagt, wie viel Leistung man einbüßt. Wenn die 25% Strom nur 2% Leistung bringen, dann ist das sicher ein guter Schritt. So sparen sich Kunden den dicken Aufpreis für kranke Kühler und damit verbundene Raumwärme und Lärm. Und die, die unbedingt diese 2% Leistung wollen, können dann halt draufzahlen und das machen.

In den Reviews sind die 2% aber evtl. mehr Wert als die Sinnhaftigkeit. Und evtl. sind es auch 20%, nicht 2%. Wissen wir ja nicht.

Da wir aber allgemein nur über inoffizielle Leaks reden, ist es auch Schmarren hier von Reduzierung, Steigerung oder sonstwas zu sprechen. Es sind einfach neue Zahlen, über die spekuliert werden kann. Solange nichts bestätigt ist, kann sich alles ändern.

Und dann wären offizielle Zahlen auch nur die Basis und nicht in Stein gemeißelt. Man kann immer undervolten, overclocken, beides zeitgleich machen, ... da wird es dann wieder sehr hart "das Richtige" herauszufinden. Die offiziellen Zahlen sind immer die Basis, aber selten die beste Wahl für die Nutzer.

Ganz banal gesprochen:

Wenn Team Grün sagt, sie haben 300 Watt für 15.000 Benchmarkpunkte und Team Rot sagt, sie haben 250 Watt für 14.500 Benchmarkpunkte.

Ist dann Team Rot besser? Oder Team Grün? Oder kann man es gar nicht sagen, weil wichtige Details fehlen?

Ich würde sagen: Letzteres.

Ist in diesem fiktiven Beispiel Team Rot so aufgestellt, dass der Kühler am Anschlag ist und ein OPC auf mehr als 255 Watt gar nicht geht?

Ist evtl. Team Grün so aufgestellt, dass sie (um den längeren Balken zu haben) die 300 Watt gar nicht brauchen, sondern auch auf 14.500 kommen,... mit 230 Watt? Dazu kann man das Ding dann auf 450 OCen und bekommt nennenswerte Mehrleistung?

Wir wissen es einfach nicht. Selbst nach den meisten Reviews, sollte man schon auch ein Auge darauf haben, wie hart am Limit die offiziellen Specs sind. Meist sind die zugunsten der Benchmarks außerhalb der sinnvollen Effizienz. Meist kann man gute 25-30% Powertarget weg nehmen, ohne nennenswerte Leistungseinbußen. Und meist handhaben das beide Teams etwas unterschiedlich.

Langer Text, nur um zu sagen:

Wir wissen es einfach nicht, ob das nun gut oder schlecht ist. Aber erst mal ist es nur neutral, da Gerücht und nicht released. ;-)

TheBigG

Enthusiast

- Mitglied seit

- 24.05.2010

- Beiträge

- 2.756

Nö. nvidia lässt einen ja nur minimal das power target erhöhen, runterschrauben geht aber ziemlich stark. Somit hätten Leute die das Power target einschränken wollen das Problemlos machen können, es aber wieder hochdrehen wird nicht Problemlos werden.Wenn der Kühler dann trotzdem für 420W dimensioniert ist und die Leistung nach nV Ermessen bei 320W genügt wäre das doch ne gute Sache, oder?

- Mitglied seit

- 03.10.2006

- Beiträge

- 15.185

- Ort

- Pampa

- Desktop System

- PSBOX

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Strix X670E-A

- Kühler

- EK Velocity

- Speicher

- Kingston Fury Renegade 64GB

- Grafikprozessor

- RTX 5090 incoming

- Display

- Asus Rog Swift PG32UCDM

- SSD

- M.2 1TB SIlicon M.2 980Pro 2TB M.2 980Pro 1TB

- Soundkarte

- Soundblaster G6 +HIFIman Arya+Endgear Microfon

- Gehäuse

- Lian Li O11 Vision Chrome Mora 420

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech G915

- Mouse

- G502

- Betriebssystem

- Win11 Pro

- Internet

- ▼100mbit

Vielleicht sind das aber einfach nur Fehlinformationen gewesen und die 420 W waren für eine 4080 Ti mit 14848 Shader und 20GB gedacht !Befürchte, das ist eher ein Marketing "Leak".

320 klingt einfach besser als 420.

Effektiv werden die GPUs beides abkönnen. Bei 320 ist sie halt dann effizienter, aber auch langsamer.

Relevant wird eher: Wie viel FPS gewinnt die GPU mit den 100 Watt? Ist der Unterschied nicht zu krass, lass ich die eh bei 250 oder 200 laufen.

Wird ne spannende Generation. Hoffe AMD liefert nicht zu weit davor / danach. Will nen Upgrade und bin sicher zu ungeduldig, um Monate auf den vergleich zu warten. ;-)

Das würde wunderbar zur Karte passen ausgehend von den 450W der 4090 .

Die 4080 muss nicht gedrosselt worden sein um auf irgendwas oder wen zu reagieren die 420 W waren vielleicht schlicht nicht für die Karte vorgesehen!

Ihr interpretiert auch sehr viel hinein in die Infos sie können ja stimmen aber teils mit falscher Zuordnung der Karten wer weis was die Leute da genau aufgeschnappt haben an Infos wo sie weiter gegeben wurden und dann vertauscht und wieder ausgespuckt und zu irreführenden Informationen geführt haben wen überhaupt!

Gruss

Zuletzt bearbeitet:

Tigerfox

Enthusiast

- Mitglied seit

- 29.08.2006

- Beiträge

- 4.292

- Ort

- Bochum

- Desktop System

- i5-4670K

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-4670K

- Mainboard

- Gigabyte GA-Z87X-UD3H @F11c

- Kühler

- Thermalright HR-02 Macho Rev.B.

- Speicher

- 4x8GB G.SKill TridentX DDR-2800 (F3-2800C12Q-32GTXDG)

- Grafikprozessor

- Gigabyte GeForce 670 OC (GV-N670OC-2GD)

- Display

- Dell U2410

- SSD

- WD Black SN750 2TB

- HDD

- 2xSeagate IronWolf 8TB (ST8000VN004, ST8000VN0022), WD40EZRX, 2xWD30EZRX

- Opt. Laufwerk

- LiteOn iHES208

- Soundkarte

- Creative SoundBlaster X-Fi Elite

- Gehäuse

- Lancool K9X

- Netzteil

- be quiet! Straight Power E9-CM 480W ATX 2.4 (E9-CM-480W)

- Keyboard

- QPAD MK-50

- Mouse

- Logitech G400

- Betriebssystem

- Win10 x64

- Webbrowser

- Firefox x64

Es ist nicht abwegig, dass diese wahnwitzigen PT jenseits von 400W oder gar 600W+, die kursierten, nie für den Verkauf oder zumindest nicht für reguläre Versionen gedacht waren. Es könntes Tests gewesen sein, um das Potential auszuloten, vielleicht auch das Maximum dessen, was wir auf OC-Versionen sehen werden.

Für ausgeschlossen halte ich, dass die neuen Werte die Standard-PT auf den Referenzkarten sind und die alten Werte das einstellbare Maximum. Wie @Tech Enthusiast schon sagte, keiner wird einen Kühler so auslegen, dass man mal eben 100W PT drauflegen kann, üblich sind ja so ~+20%, also max +60-80W.

400W+ schreien IMHO auch nach AIO ab Werk.

Angesichts dessen, wieviel Kritik es schon in der letzten Generation an den stark gestiegenen PT und den damit gewachsenen Kühlern gab, war es schon sehr verwunderlich, dass die PT nochmal so erheblich wachsen sollten.

Für ausgeschlossen halte ich, dass die neuen Werte die Standard-PT auf den Referenzkarten sind und die alten Werte das einstellbare Maximum. Wie @Tech Enthusiast schon sagte, keiner wird einen Kühler so auslegen, dass man mal eben 100W PT drauflegen kann, üblich sind ja so ~+20%, also max +60-80W.

400W+ schreien IMHO auch nach AIO ab Werk.

Angesichts dessen, wieviel Kritik es schon in der letzten Generation an den stark gestiegenen PT und den damit gewachsenen Kühlern gab, war es schon sehr verwunderlich, dass die PT nochmal so erheblich wachsen sollten.

Es wäre ja auch irgendwie komisch gewesen, wenn die 4080 mit fast halb so vielen Shadern wie die 4090 trotzdem einen nahezu gleich hohen Verbrauch aufgewiesen hätte. Selbst mit entsprechend hohem Takt wäre das noch überzogen.

Immerhin scheint die neue Generation diesmal kein Speicherkrüppel zu sein, aber wie so oft sind die Gerüchte ja mit Vorsicht zu genießen.

Immerhin scheint die neue Generation diesmal kein Speicherkrüppel zu sein, aber wie so oft sind die Gerüchte ja mit Vorsicht zu genießen.

Ähnliche Themen

- Antworten

- 13

- Aufrufe

- 1K

- Antworten

- 38

- Aufrufe

- 8K

- Antworten

- 12

- Aufrufe

- 1K

- Antworten

- 7

- Aufrufe

- 1K

P