Da ich die meiste Zeit auf dem 2. Monitor ein paar Statistik-Tools offen habe und mich der VRAM-Gebrauch meiner Graka schon immer interessiert hat (woher kommen die Ruckler die ich mich nicht erklären kann) hat sich inzwischen eine recht ansehnliche Sammlung angefunden.

Vielleicht ist es ja für den einen oder anderen genau so interessant.

Und nochmal zum mitmeißeln, VRAM-Gebrauch. Bedeutet wenn 1.5GB benutztes VRAM angezeigt werden bedeutet es nicht dass es auf Karten mit 1GB zu einem völligen Zusammenbruch kommt. Es könnte aber sein^^

Letzte Änderung: 02.03.2013

Spitzenreiter:

Hitman Absolution mit 6GB ohne überzogene AA-Einstellungen (sieht man an der Performance vom Game). Am Ende mit unschönen Textur-Swaps.

Settings: Solange nicht anders genannt Nvidia-Graka, Treiber auf HQ, alle Optimierungen aus, 2xAA 16xAF.

Und noch ein Wunsch von mir:

Dies soll keine Performance-Diskussion werden sondern nur ein empirischer Vergleich. Wer meint das 256MB VRAM für seine Games reichen ... ja, ist toll. Akzeptiere ich voll und ganz. Dass ATI sparsamer mit VRAM umgehen soll als Nvidia (auch wenn die Texturen nicht weniger werden^^) weiß ich auch, allerdings habe ich letztens mit meiner 5970 Vergleiche angestellt und keinen Unterschied gesehen. Ich möchte euch nur meine Beobachtungen zeigen, deshalb sind die meisten Screenshots auch ohne FPS-Anzeige (wobei ich spielbare Settings bevorzuge). Dafür aber noch mit dem tatsächlichen RAM-Verbrauch des Games in der Anzeige vom ProcMon. Vielleicht ein kleiner Leitfaden für die Leute die wissen wollen was ein Programm so an Speicher nutzt.

Neue Beobachtungen

Crysis 2 1.2GB (2560x1600 Extreme, keine Einsteller für AA/AF im Game zur Zeit) DX9

Witcher2

1.4GB

Shogun 2

1.2GB

Settings und Benchmark-Szene

Dirt3, etwas über 1GB

Call of Duty Black Ops

1GB

Starcraft II

Knapp 1GB schon in der 1. Misson der Kampagne

CIV5:

1.25GB

COD6/MW2

1GB schon in einer der 1. Missionen

ARMA 2

800MB im BootCamp

Battlefield 2: Bad Company: Gerade so 600MB

Borderlands, Unreal-Engine-typisch keine 400MB

Dirt II: Etwas über 600MB

NFS Shift

Fast 1GB

Batman Arcam Asylum: 640MB,

Metro 2033: Nur knapp über 600MB in DX9

In DX11 knapp 1GB

Sacred2 fast 900MB

Risen nur 700MB

Spiele mit den Anfangsbuchstaben A bis E

Spiele mit den Anfangsbuchstaben F bis Q

Spiele mit den Anfangsbuchstaben R bis Z

Normalerweise sind die neueren Screens immer in 2560x1600 gemacht, aber das sollte euch nicht stören, die Bildschirm-Größe geht abhängig von der Grafik-Engine nur wenig in den VRAM-Gebrauch ein, der Löwenanteil sind Texturen und AA-Modi (deshalb hab ich den AA-Modi extra klein gehalten, ausserdem geht mir dann auch irgendwann die Performance am 30" aus^^). Eine Textur in 4096x4096 braucht im VRAM immer den gleichen Platz, egal ob sie auf dem Bildschirm auf einem Dreieck mit 2x2x3 oder 2000x2000x3000 Pixel zu sehen ist.

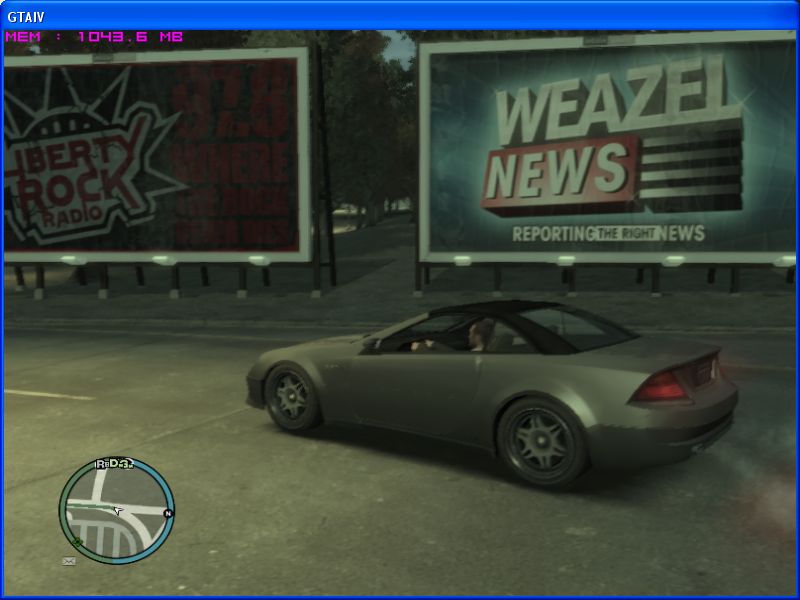

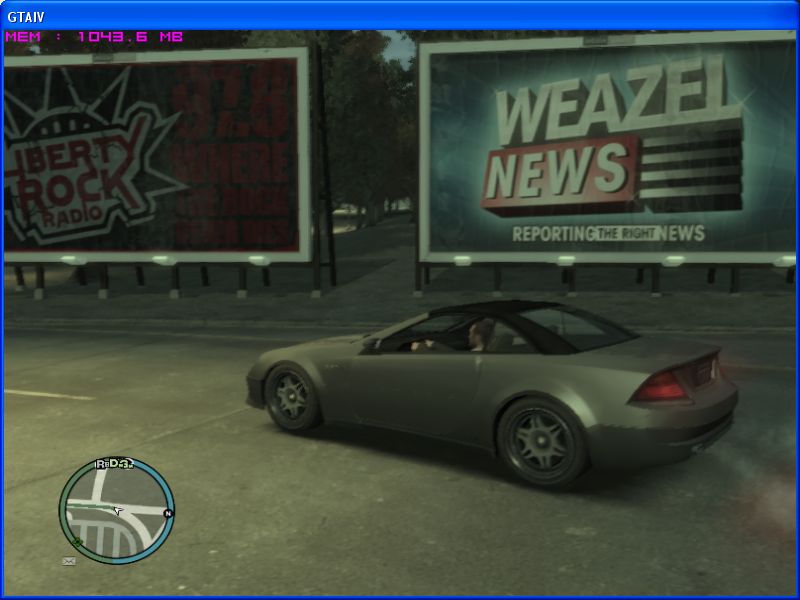

Zum Vergleich das es nicht immer von der Bildschirm-Größe abhängt noch schnell zwei Screenshots in 640x480 bzw 800x600 von einem sehr alten Game und einem Game das gar kein AA unterstützt.

GTA4, mit Ini-Datei-Mod in 800x600. Über 1GB VRAM-Gebrauch

Quake 4 in Ultra-Settings und nur 640x480, hier allerdings 8xAA, 16xAF um zu verdeutlichen was AA wirklich an VRAM frisst. Mit 2xAA sind es nur 750MB

Bevor ihr jetzt die Screens auseinandernehmt:

Vielleicht ist es ja für den einen oder anderen genau so interessant.

Und nochmal zum mitmeißeln, VRAM-Gebrauch. Bedeutet wenn 1.5GB benutztes VRAM angezeigt werden bedeutet es nicht dass es auf Karten mit 1GB zu einem völligen Zusammenbruch kommt. Es könnte aber sein^^

Letzte Änderung: 02.03.2013

Spitzenreiter:

Hitman Absolution mit 6GB ohne überzogene AA-Einstellungen (sieht man an der Performance vom Game). Am Ende mit unschönen Textur-Swaps.

Settings: Solange nicht anders genannt Nvidia-Graka, Treiber auf HQ, alle Optimierungen aus, 2xAA 16xAF.

Und noch ein Wunsch von mir:

Dies soll keine Performance-Diskussion werden sondern nur ein empirischer Vergleich. Wer meint das 256MB VRAM für seine Games reichen ... ja, ist toll. Akzeptiere ich voll und ganz. Dass ATI sparsamer mit VRAM umgehen soll als Nvidia (auch wenn die Texturen nicht weniger werden^^) weiß ich auch, allerdings habe ich letztens mit meiner 5970 Vergleiche angestellt und keinen Unterschied gesehen. Ich möchte euch nur meine Beobachtungen zeigen, deshalb sind die meisten Screenshots auch ohne FPS-Anzeige (wobei ich spielbare Settings bevorzuge). Dafür aber noch mit dem tatsächlichen RAM-Verbrauch des Games in der Anzeige vom ProcMon. Vielleicht ein kleiner Leitfaden für die Leute die wissen wollen was ein Programm so an Speicher nutzt.

Neue Beobachtungen

Crysis 2 1.2GB (2560x1600 Extreme, keine Einsteller für AA/AF im Game zur Zeit) DX9

Witcher2

1.4GB

Shogun 2

1.2GB

Settings und Benchmark-Szene

Dirt3, etwas über 1GB

Call of Duty Black Ops

1GB

Starcraft II

Knapp 1GB schon in der 1. Misson der Kampagne

CIV5:

1.25GB

COD6/MW2

1GB schon in einer der 1. Missionen

ARMA 2

800MB im BootCamp

Battlefield 2: Bad Company: Gerade so 600MB

Borderlands, Unreal-Engine-typisch keine 400MB

Dirt II: Etwas über 600MB

NFS Shift

Fast 1GB

Batman Arcam Asylum: 640MB,

Metro 2033: Nur knapp über 600MB in DX9

In DX11 knapp 1GB

Sacred2 fast 900MB

Risen nur 700MB

Spiele mit den Anfangsbuchstaben A bis E

Spiele mit den Anfangsbuchstaben F bis Q

Spiele mit den Anfangsbuchstaben R bis Z

Normalerweise sind die neueren Screens immer in 2560x1600 gemacht, aber das sollte euch nicht stören, die Bildschirm-Größe geht abhängig von der Grafik-Engine nur wenig in den VRAM-Gebrauch ein, der Löwenanteil sind Texturen und AA-Modi (deshalb hab ich den AA-Modi extra klein gehalten, ausserdem geht mir dann auch irgendwann die Performance am 30" aus^^). Eine Textur in 4096x4096 braucht im VRAM immer den gleichen Platz, egal ob sie auf dem Bildschirm auf einem Dreieck mit 2x2x3 oder 2000x2000x3000 Pixel zu sehen ist.

Zum Vergleich das es nicht immer von der Bildschirm-Größe abhängt noch schnell zwei Screenshots in 640x480 bzw 800x600 von einem sehr alten Game und einem Game das gar kein AA unterstützt.

GTA4, mit Ini-Datei-Mod in 800x600. Über 1GB VRAM-Gebrauch

Quake 4 in Ultra-Settings und nur 640x480, hier allerdings 8xAA, 16xAF um zu verdeutlichen was AA wirklich an VRAM frisst. Mit 2xAA sind es nur 750MB

Bevor ihr jetzt die Screens auseinandernehmt:

Ich glaube wir könne die Diskussion eigentlich beenden denn im Grunde sind wir uns einig, aus gewissen Perspekiven betrachtet.

1. V-Ram ist immer wichtig.

2. Mehr V-Ram "kann" die Performance steigern.

3. Es kommt immer auf die Settings drauf an die man verwenden will oder kann.

4. Gewisse Spiele nutzen derart viel V-Ram das auch eine kleinere Karte durchaus einen Performancezuwachs bekommen "könnte"

5. Wer nicht grade extrem Auflösungen verwendet (jenseits von 1680x1050), nicht Krampfhaft über 4xAA einstellt, kommt bei den "meisten" Spielen (Ausnahmen gibt es immer) auch mit 512MB Karten "noch" gut zurecht.

6. Ein Spiel das mehr als 512MB V-Ram verbraucht, bricht nicht automatisch in den FPS gegenüber dem 1GB Modell ein. Ein Spiel das 600MB benötigt läuft auf einer 1GB Karte nicht unbedingt schneller als auf einer 512MB Karte. Es kommt ganz auf das Spiel drauf an.

7. Grade SSAA und Konsorten, sind Einstellungen die vom durchschnittlichen Spieler nicht wirklich verwendet werden. Das man da sehr viel V-Ram benötigt und es sehr viel Performance kostet, darüber dürfte sich jeder klar sein.

8. Wer mit einer betagen oder mittlerweile schwachen Karte wie einer 3870/4670/8800GT/9800GT mit 512MB erwartet in Full HD mit hohen Settings zu spielen, wird keine Freude haben. Das aber auch nicht mit Karten ihrer Klasse die 1GB V-Ram haben da hier "in der Regel" die GPU zu schwach ist.

Zuletzt bearbeitet:

Der entscheidende Satz nochmal als quote o.g.

Der entscheidende Satz nochmal als quote o.g.