Denke das hängt von dem Produkten ab.

Manche Bereiche werden davon gar nicht betroffen sein (Verbindungen innerhalb / untereinander von Komponenten, Netzwerkkarten). Denke hier geht es wirklich um Referenz Implementierungen von Servern (also Motherboards, Chiplet GPUs - und CPUs inkl. Speicher und Co-Prozessoren als CPU / GPU Beschleuniger etc.)

Es wird halt einfach nicht weiter investiert bzw. weiter geforscht:

Zitate aus den Links des HWLuxx Artikels:

"... man einige Projekte einstellen werde. So wird es keinerlei weitere Investitionen in die Netzwerk-Sparte (NEX) geben. Bestehende Produkte würden weiterhin unterstützt, es wird allerdings keinerlei Weiterentwicklungen mehr geben."

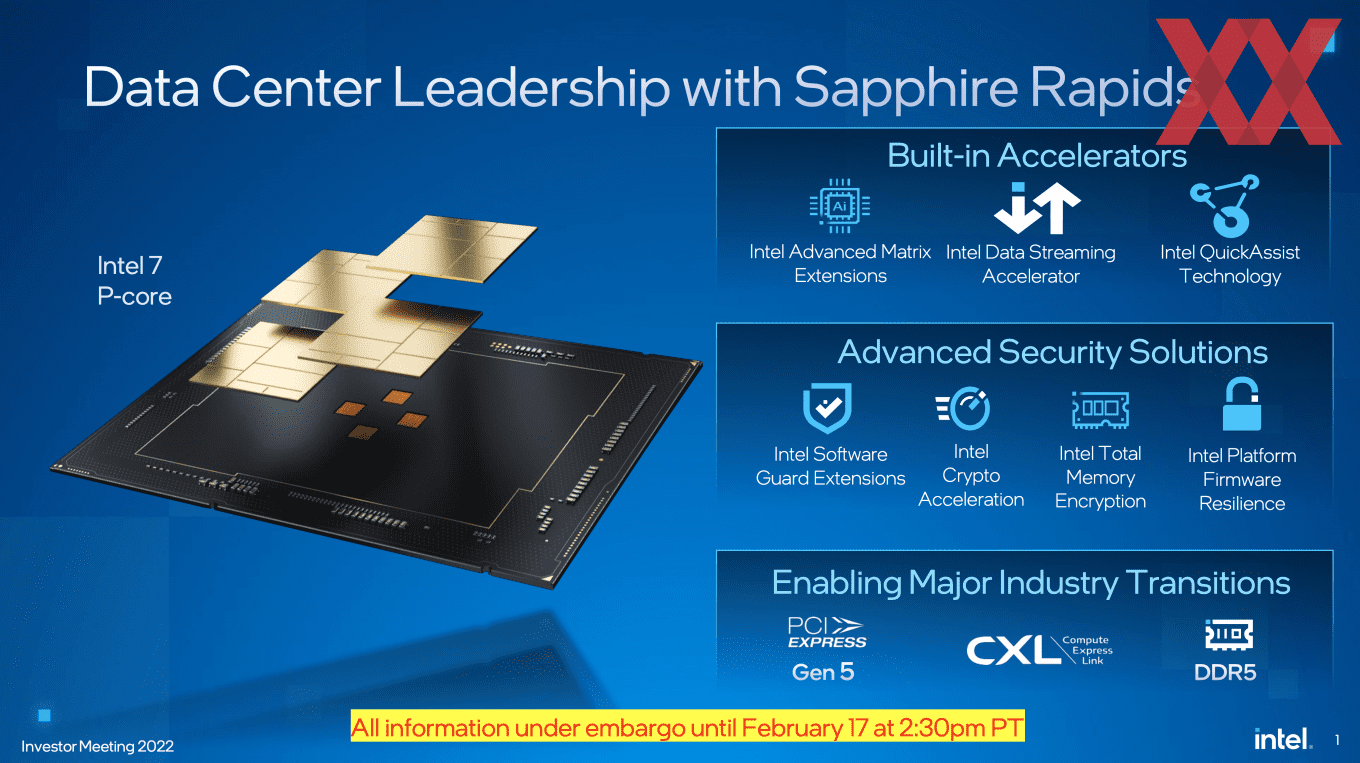

"Falcon Shores soll die aktuelle GPU-Strategie zusammenführen. CPU-, GPU-, AI-, Speicher-Tiles in einem Package sollen die Chips flexibel auf den jeweiligen Anwendungsfalls ausrichten können. x86-Kerne und eine Xe-Architektur in einem Package – dies erinnert stark an AMDs Instinct MI300A, der CDNA-3-Chiplets und Zen-Kerne zusammenbringt.

Geplant ist Falcon Shores ab 2025. Bis dahin wird Intel also keinerlei neue Datancenter-GPU präsentieren. Somit werden AMD mit Instinct MI300A und NVIDIA mit Grace Hopper diesen Bereich (x86-CPU + GPU) bedienen, während Intel mit Ponte Vecchio wird ausharren müssen. Stetige Weiterentwicklungen bei der Software sollen dabei helfen."

Die "geringe" Marge im Client und Enterprise Segment schlägt zu Buche.

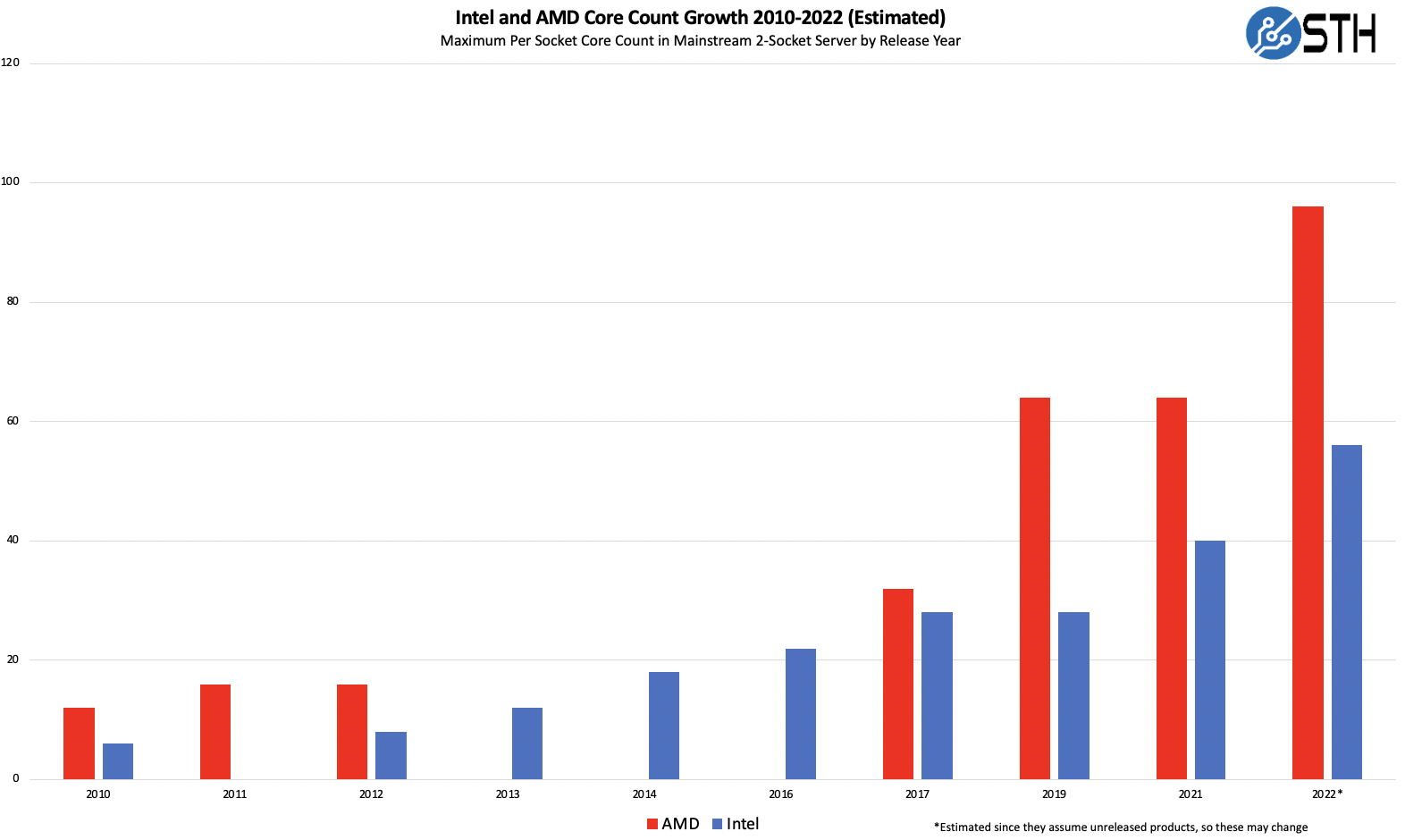

AMD macht länger schon Druck und ARM bedient auch schon länger wichtige Marktbereiche. Die Marge wird nun verteilt und AMD hat endlich auch (verdientermaßen) die OEMs für sich gewinnen können (alleine die Energiekosten haben dafür gesorgt).

Die kleinen Sparten waren jedoch eher stabil.

Jedoch macht hier auch die Masse an kleinen Sparten (selbst mit geringen Verlusten) einfach den Haushalt unflexibel.

Gerade da lässt sich durch temporären Verkauf (und ggfls. spätere neue Einverleibung bei höheren Erfolgschancen von Innovationen) einfach mehr Bewegungsfreiheit zu.

Intel setzt in die Automobilindustrie (Chips) und versucht dort noch etwas von dem Kuchen abzubekommen.

Die aktuelle Chip und Komponenten Knappheit (Asien) wird dazu beitragen, ist für mich aber nur ein Teil der Wahrheit.

Intel wird sich halt eher auf die Partner (hier erwähnt wird ja der Mutterkonzern von Tyan) verlassen, dass Innovationen durch diese (mit Intel Unterstützung) weiterhin in den Bereichen Fuß fassen können.

Nur kann Intel die eigenen Vorstellungen von Innovationen / Forschung nicht mehr nur alleine bestimmten.

Dies wird sich auch auf kommende Produkte (Chiplets mit GPUs und Speicher) auswirken und als Beispiel im mobilen Sektor mit der ARM Partnerschaft versucht zu kompensieren.

Ziel ist eine Optimierung von Chip-Designs für Intels Fertigungsprozess 18A. ARM begründet die Zusammenarbeit mit hohen Anforderungen an die Leistung und Effizienz von Chips.

www.silicon.de

Dies ist aber seit Saphire Rapid wohl schon der Fall.

Ich denke dadurch, daß AMD, Apple und teilweise Samsung exklusiv Verträge in Bezug auf die Fertigungskontigente (über viele Jahre) bei TSMC besitzen, kann Intel die Forschungskosten und Fabriken immer noch nicht auslagern.

Das frisst den Haushalt halt immer weiter auf und zwingt Intel dazu, immer weiter Fabriken hoch zu ziehen, was dem Aktienkurs auch nicht auf Dauer schmecken wird.

Daher befindet sich Intel hier in der Zwickmühle.

Sie müssen weiter Fabs ausbauen und dafür braucht es halt Geld. Sonst zieht AMD halt immer weiter davon durch die Shrinks von TSMC.

Aber Intel erhält hier Geld aus dem EU Haushalt (unserere Steuergelder) und deswegen wird in der EU auch ausgebaut:

Der US-Chiphersteller Intel baut, unterstützt mit öffentlichen Geldern, gleich zwei Werke in Magdeburg. Das soll Europa unabhängiger vom asiatischen Markt machen. Doch es drohen Überkapazitäten

www.capital.de

Ich vermute daher stark, dass alles, was keinen Gewinn bringt (kleine Sparten / kurzsichtige Projekte oder Projekte ohne hohe Innovationskraft) abgeschrieben werden müssen.

Sonst steigen die Aktionäre auf das Dach ohne fette Ausschüttung.

Interessant werden die dedizierten GPUs in diesem Zusammenhang werden.

Alle Hersteller planen auf mehrere Jahre und alles was nicht spätestens Mittelfristig (3 - 5 Jahre) erfolgversprechend wirkt, wird halt abgestoßen oder in Hände übergeben, welche man zu mindestens gut einschätzen kann aufgrund von langer Partnerschaft untereinander.

Verständlicherweise werden durch die letzten vorbeugenden Aktionen wie das Abstoßen von Sparten und Forschung in den Bereichen / Deals / Partnerschaften / Unterstützung durch EU Förderung bei Intel die Löcher füllen können und den Aktienkurs kurz - bis mittelfristig beruhigen.

Ob das wirklich so große Auswirkungen besitzt, kann man vorerst gar nicht genau wissen oder beurteilen. Das werden die nächsten Jahre erst aufzeigen können.

Strategisch ist es ein cleverer Schachzug von Intel.

Auf lange Sicht, werden wir sehen, ob die Strategie aufgeht oder nicht.

"Prestige" Auswirkungen sind auf jeden Fall deutlich vorhandenen und betrifft die Supercomputer / HPC Sparte.

Dort wird angesagt, welcher Hersteller was genau leisten kann.

Das hat weitaus mehr praktische Auswirkungen auf das Enterprise Business als man ggfls. zuerst annimmt.

AMD hat seit der Zen Architektur die Anzahl im Top Ranking verdoppeln können und Intel muss sich auch NVIDIA (dank Übernahmen z.B. von Mellanox für schlanke / schlappe 7 Milliarden US Dollar) dort seit längerer Zeit geschlagen geben.

Intel loses out as Instinct GPUs power the world’s fastest big-iron system

www.theregister.com

Das sind die wahren Gründe für die Probleme von Intel und deren Handeln.

Warum sollten die es auch weiterhin versuchen? Den Krieg können die seit Jahren schon nicht mehr gewinnen.

Also schnappt man der Konkurrenz lieber andere Segmente Mithilfe der Partnerschaft zu ARM weg, um sich zu sanieren und wieder danach forschen zu können mit frischer und sanierter Haushaltkasse.

Das kann sich höchstens mit ARM zusammen ab 2025 ändern. Aber bis dahin hat AMD auch wieder abgeliefert. Bleibt daher spannend.

Intel hat den Mainstream lange genug gemelkt gehabt (4 Cores mit geringer IPC Steigerung vor Zen, kaum PCIe Lanes mehr und DMI Limitierungen) und sich zurück gelehnt = mein Mitleid (was kein Unternehmen verdient hat) hält sich daher stark in Grenzen.

AMD hat damals mit Bulldozer und FX viel riskiert und viel Geld verloren.

Die dazugehörigen Forschungsergebnisse haben sich aber seit Zen ausgezahlt.

Die Auslagerung der Fertigung war dabei als Risikominimierung überaus erfolgreich.

Seitdem wird der Spieß mal umgedreht und Intel darf den Druck gerne spüren.

Das schafft Konkurrenzdruck und Bestenfalls Innovationsdruck.