Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Hi,

ich möchte einen Datenträger eines mirrored Root-Pool tauschen. Wie mache ich das? geht das mit zpool replace old new?

oder funktioniert das hier auch mit einem mirrored pool: ZFS: Tips and Tricks - Proxmox VE

?

ich möchte einen Datenträger eines mirrored Root-Pool tauschen. Wie mache ich das? geht das mit zpool replace old new?

oder funktioniert das hier auch mit einem mirrored pool: ZFS: Tips and Tricks - Proxmox VE

?

Zuletzt bearbeitet:

OpenIndiana 2017.04 ist verfügbar

Setup

http://www.napp-it.org/doc/downloads/setup_napp-it_os.pdf

New

2017.04 Release notes - OpenIndiana - OpenIndiana Wiki

Neu: USB3 support und neue Software releases

Setup

http://www.napp-it.org/doc/downloads/setup_napp-it_os.pdf

New

2017.04 Release notes - OpenIndiana - OpenIndiana Wiki

Neu: USB3 support und neue Software releases

fdiskc2000

Enthusiast

- Mitglied seit

- 30.05.2007

- Beiträge

- 2.231

@gea: gibt es eigentlich Einschränkungen / Verlust an Funktionalitäten von napp-it, wenn man jetzt von omnios auf OpenIndia umsteigt? LX-Container ok, aber sonst etwas?

Ich muss ja zugeben das ich 99% über Deine Oberfläche mache und verwundert wäre wenn dann etwas nicht mehr klappt. Oder sind sich da beide so stark ähnlich, dass es nahezu keinen Unterschied macht?

Und wie lange denkst Du kann man noch mit der 151020 "leben"?

Ich muss ja zugeben das ich 99% über Deine Oberfläche mache und verwundert wäre wenn dann etwas nicht mehr klappt. Oder sind sich da beide so stark ähnlich, dass es nahezu keinen Unterschied macht?

Und wie lange denkst Du kann man noch mit der 151020 "leben"?

Prinzipiell sind OmniOS und OpenIndiana Distributionen die auf einem aktuellen Illumos aufbauen.

Bis auf LX sind die Unterschiede gering, beide enthalten z.B. USB3 Unterstützung das erst gerade in Illumos erschienen ist.

zu OmniOS

Die 151022 LTS soll noch im Mai kommen.

Zur künftigen Entwickling ist noch einiges offen. OmniTi möchte sich aber weiter beteiligen und gibt den Namen OmniOS frei. Auch sollen die Repositories weiter bei OmniTi gehostet werden. Alternativ habe ich bereits einen Repository Mirror aufgesetzt.

Da OmniOS bei kommerziellen Nutzern neben NexentaStor verbreitet ist, gibt es auch bereits ein Funding Projekt um Geld für professionellen Support zu sammeln. Das ist ja das Besondere an OmniOS. Ich hoffe das diese professionelle Option mit festem Personal bleibt.

Wenn man keinen bezahlten Support braucht, kann man OmniOS problemfrei nutzen. Bugfixes wird es ziemlich sicher geben. Sterben wird es eher nicht. Große Eigenentwicklungen wie LX Container wird es wohl eher weniger geben. Für eine endgültige Entscheidung OI vs OmniOS hat man sicher noch ein Jahr Zeit. Im Moment is OmniOS als Produktions-Server die bessere Wahl.

Bis auf LX sind die Unterschiede gering, beide enthalten z.B. USB3 Unterstützung das erst gerade in Illumos erschienen ist.

zu OmniOS

Die 151022 LTS soll noch im Mai kommen.

Zur künftigen Entwickling ist noch einiges offen. OmniTi möchte sich aber weiter beteiligen und gibt den Namen OmniOS frei. Auch sollen die Repositories weiter bei OmniTi gehostet werden. Alternativ habe ich bereits einen Repository Mirror aufgesetzt.

Da OmniOS bei kommerziellen Nutzern neben NexentaStor verbreitet ist, gibt es auch bereits ein Funding Projekt um Geld für professionellen Support zu sammeln. Das ist ja das Besondere an OmniOS. Ich hoffe das diese professionelle Option mit festem Personal bleibt.

Wenn man keinen bezahlten Support braucht, kann man OmniOS problemfrei nutzen. Bugfixes wird es ziemlich sicher geben. Sterben wird es eher nicht. Große Eigenentwicklungen wie LX Container wird es wohl eher weniger geben. Für eine endgültige Entscheidung OI vs OmniOS hat man sicher noch ein Jahr Zeit. Im Moment is OmniOS als Produktions-Server die bessere Wahl.

morumbinas

Enthusiast

- Mitglied seit

- 01.12.2007

- Beiträge

- 403

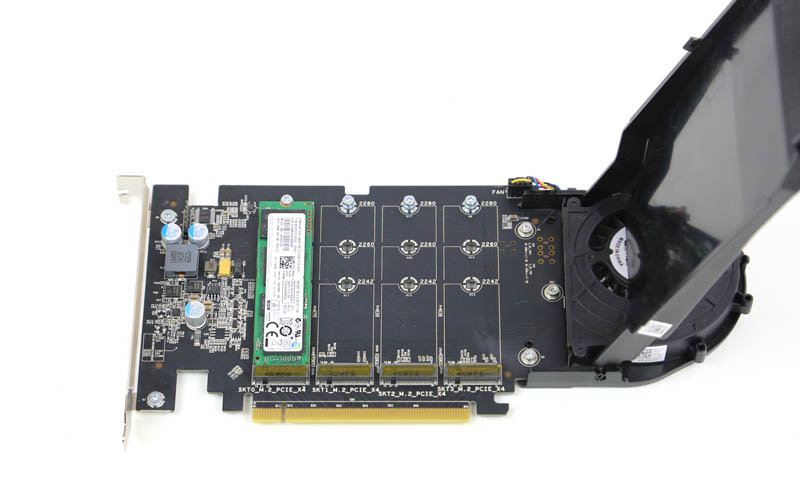

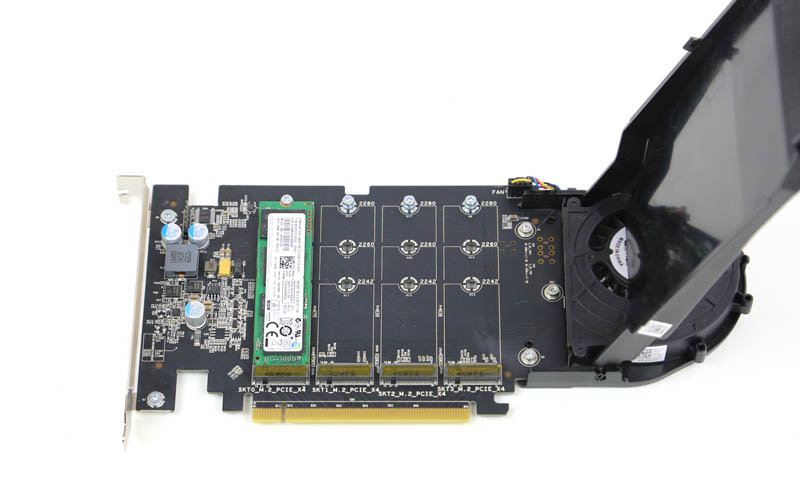

Jemand schon mit NVMe Storage herumgespielt?

Bin bei meinen Recherchen u.a. auf den "Dell 4x m2 NVMe Drive PCIe Card" und auf den "HP Z Turbo Quad Pro" Controller gestoßen.

Damit lässt sich dann ein NVMe Raid aufbauen und vermutlich dann auch auch ne Storage VM durchreichen.

Der Durchsatz kommt ja dann fast an RAM ran 😀Siehe hier: Dell Quad M.2 PCIe card. | [H]ard|Forum

Und man müsste dann gleich auf zB 40Gbit Ethernet SFP gehen...

Bin bei meinen Recherchen u.a. auf den "Dell 4x m2 NVMe Drive PCIe Card" und auf den "HP Z Turbo Quad Pro" Controller gestoßen.

Damit lässt sich dann ein NVMe Raid aufbauen und vermutlich dann auch auch ne Storage VM durchreichen.

Der Durchsatz kommt ja dann fast an RAM ran 😀Siehe hier: Dell Quad M.2 PCIe card. | [H]ard|Forum

Und man müsste dann gleich auf zB 40Gbit Ethernet SFP gehen...

Hi,

ich möchte einen Datenträger eines mirrored Root-Pool tauschen. Wie mache ich das? geht das mit zpool replace old new?

oder funktioniert das hier auch mit einem mirrored pool: ZFS: Tips and Tricks - Proxmox VE

?

keiner eine Ahnung?

Jede Distribution/ OS handhabt das eventuell anders.

Die sicherste Option wäre, die Mirrorplatte per zpool detach pool platte zu entfernen und die neue Platte als Bootmirror hinzuzufügen. Das aktualisiert auch eventuell nötige Anpassungen im Bootbereich.

Die sicherste Option wäre, die Mirrorplatte per zpool detach pool platte zu entfernen und die neue Platte als Bootmirror hinzuzufügen. Das aktualisiert auch eventuell nötige Anpassungen im Bootbereich.

fdiskc2000

Enthusiast

- Mitglied seit

- 30.05.2007

- Beiträge

- 2.231

Prinzipiell sind OmniOS und OpenIndiana Distributionen die auf einem aktuellen Illumos aufbauen.

Bis auf LX sind die Unterschiede gering, beide enthalten z.B. USB3 Unterstützung das erst gerade in Illumos erschienen ist.

zu OmniOS

Die 151022 LTS soll noch im Mai kommen.

Zur künftigen Entwickling ist noch einiges offen. OmniTi möchte sich aber weiter beteiligen und gibt den Namen OmniOS frei. Auch sollen die Repositories weiter bei OmniTi gehostet werden. Alternativ habe ich bereits einen Repository Mirror aufgesetzt.

Da OmniOS bei kommerziellen Nutzern neben NexentaStor verbreitet ist, gibt es auch bereits ein Funding Projekt um Geld für professionellen Support zu sammeln. Das ist ja das Besondere an OmniOS. Ich hoffe das diese professionelle Option mit festem Personal bleibt.

Wenn man keinen bezahlten Support braucht, kann man OmniOS problemfrei nutzen. Bugfixes wird es ziemlich sicher geben. Sterben wird es eher nicht. Große Eigenentwicklungen wie LX Container wird es wohl eher weniger geben. Für eine endgültige Entscheidung OI vs OmniOS hat man sicher noch ein Jahr Zeit. Im Moment is OmniOS als Produktions-Server die bessere Wahl.

Vielen Dank für die klärenden Worte. Dann kann ich ja erstmal beruhigt weiter machen

Jede Distribution/ OS handhabt das eventuell anders.

Die sicherste Option wäre, die Mirrorplatte per zpool detach pool platte zu entfernen und die neue Platte als Bootmirror hinzuzufügen. Das aktualisiert auch eventuell nötige Anpassungen im Bootbereich.

kannst du mir sagen, wie ich das mache? Wie finde ich heraus, welche von beiden die Mirrorplatte ist? Im Bios nachschauen, welche die Bootplatte ist?

edit: wenn es jemanden interessiert: Das aus dem Link funktioniert einwandfrei.

Zuletzt bearbeitet:

fdiskc2000

Enthusiast

- Mitglied seit

- 30.05.2007

- Beiträge

- 2.231

Moin, ich bin mir nicht sicher wo genau das Problem liegt, aber nach diversen Tests habe ich folgendes Problem.

Mein ML310e hat eine X520-DA2 bekommen. Diese soll zwischen Keller und Büro quasi einen Switch ersetzen (bis wieder Geld da ist) und die Idee war, das mir der Bridge Funktion in Napp-IT zu realisieren.

Wenn ich aber die X520 an Napp-IT durchreiche UND mich in der Oberfläche einloge, schaltet sich die VM sofort aus.

Loge ich mich nicht ein, ist alles ok und ich kann die ZFS-Dateisysteme über SMB/NTFS nutzen. Eben so lange bis ich mich in der Oberfläche anmelde.

Allerdings bin ich ohne die Oberfläche hilflos und würde die Bridge nicht hinbekommen.

Hat jemand eine Idee, was das sein könnte?

Mein ML310e hat eine X520-DA2 bekommen. Diese soll zwischen Keller und Büro quasi einen Switch ersetzen (bis wieder Geld da ist) und die Idee war, das mir der Bridge Funktion in Napp-IT zu realisieren.

Wenn ich aber die X520 an Napp-IT durchreiche UND mich in der Oberfläche einloge, schaltet sich die VM sofort aus.

Loge ich mich nicht ein, ist alles ok und ich kann die ZFS-Dateisysteme über SMB/NTFS nutzen. Eben so lange bis ich mich in der Oberfläche anmelde.

Allerdings bin ich ohne die Oberfläche hilflos und würde die Bridge nicht hinbekommen.

Hat jemand eine Idee, was das sein könnte?

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Da OmniOS bei kommerziellen Nutzern neben NexentaStor verbreitet ist, gibt es auch bereits ein Funding Projekt um Geld für professionellen Support zu sammeln. Das ist ja das Besondere an OmniOS. Ich hoffe das diese professionelle Option mit festem Personal bleibt.

@gea, ich nehme an, dass du dich mit dem Funding auf die Anregung von Tobias Ötiker beziehst. Leider scheinen sich da aber nicht sehr Viele bis jetzt beteiligen zu wollen, denn bis jetzt kommen wir gerade mal auf $53420 im Jahr. Das wird nicht reichen - um Dan und Dale bezahlen zu können.

besterino

Legende

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.843

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

@fdisk2000: warum realisierst du den "pseudo Switch" nicht einfach in ESXi? Ist wahrscheinlich einfacher als in der VM und der Passthrough von einer NIC erscheint mir eher gekünstelt.

Zuletzt bearbeitet:

fdiskc2000

Enthusiast

- Mitglied seit

- 30.05.2007

- Beiträge

- 2.231

Weil ich es nicht hinbekomme  siehe ESXI-Thread, wenn Du helfen magst

siehe ESXI-Thread, wenn Du helfen magst

siehe ESXI-Thread, wenn Du helfen magst

siehe ESXI-Thread, wenn Du helfen magstbesterino

Legende

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.843

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

Oh ok. Ich guck mal!

@gea, ich nehme an, dass du dich mit dem Funding auf die Anregung von Tobias Ötiker beziehst. Leider scheinen sich da aber nicht sehr Viele bis jetzt beteiligen zu wollen, denn bis jetzt kommen wir gerade mal auf $53420 im Jahr. Das wird nicht reichen - um Dan und Dale bezahlen zu können.

OmniOS ist ja derzeit neuestes Illumos (wie bei OpenIndiana auch)

+ LX/Linux Container

+ regelmäßige Stables/LTS je mit eigenem Repository das in der Support Laufzeit nachgepflegt wird

+ kommerzieller Voll-Support rund um OS, ZFS und Services bei OmniTi mit festem Personal (2500$/ Jahr/ System)

Für die ersten zwei Punkte sieht es gar nicht so schlecht aus. OmniOS 151022 LTS kommt wie geplant noch im Mai und OmniTi nutzt das auch weiter intern, will den Markennamen OmniOS freigegeben und will die Repositories weiter hosten. Für den Voll-Support gab es jedoch einfach zu wenige die das bezahlen wollten.

Wie es genau mit Dan und Dale, den Support Software Ingenieuren für OmniOS bei OmniTi weitergeht ist ja auch noch offen. Wenn die ein entsprechendes Angebot für eine Festanstellung wo auch immer erhalten, sind die eh weg. Auch sind 50k USD/ Jahr Zusagen in einer internen schnellen Umfrage gar nicht so wenig. Das sind ja nur ganz wenige Nutzer und davon gibt es deutlich mehr. OmniOS ist letzlich die führende freie Solaris Distribution bei professionellen Nutzern. Das bisherige Preisgefüge stimmte aber auch nicht. Es muss billiger werden, dafür kann der Leistungsumfang geringer ausfallen. Der Pflegeaufwand für die stable Repositories selbst ist ja auch bei weitem nicht so hoch wie etwa bei OpenIndiana da die ja die gesamte Desktopsoftware mitpflegen. Die OS Entwicklung läuft ja ohnehin woanders (Illumos).

Letzlich läuft auch Solarish und ZFS viel zu problemfrei für so teuren Support.

Ich habe noch einige Benutzer mit einem Uralt OpenIndiana und napp-it das einfach seit Jahren durchläuft.

MrDeluxe

Enthusiast

- Mitglied seit

- 01.04.2006

- Beiträge

- 1.474

- Laptop

- Thinkpad E480, E14, T14s

- Details zu meinem Desktop

- Prozessor

- AMD 3700x @ 4,3 Boost-Overdrive + Thermal Grizzly Aeronaut

- Mainboard

- Gigabyte Aorus Pro X570

- Kühler

- Scythe Fuma 2

- Speicher

- G.Skill - F4-3200C14D-16GFX

- Grafikprozessor

- 5700 XT

- Display

- 1xBenq G2411HD, 1xLG 27GL850-B, 1xBenq G2411HD @ Icy Box Monitor Arm IcyBox 3 – IB-MS405-T

- SSD

- WD Black SN750

- HDD

- Samsung 850Evo, Crucial 120GB @ Linux EOS

- Opt. Laufwerk

- N/A

- Soundkarte

- OnBoard

- Gehäuse

- Fractal Design Define R6 USB-C Blackout

- Netzteil

- be quiet straight power 650W

- Keyboard

- CMSTORM

- Mouse

- MX518

- Betriebssystem

- Win11 + Linux Elementary OS

- Sonstiges

- Mobile Phone - Mi 11 Lite 5G @ lineageOS nightly

- Internet

- ▼1000 ▲500

@gea: Gibt es schon Bestrebungen ähnlich deiner ESXi All-in-One Lösung mit OmniOS auch für Proxmox anzubieten?

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

So wie ich das sehe, sind da eher massive Managementfehler gemacht worden und Robert hat als CEO offensichtlich viel zu spät reagiert. Jetzt ist das Geld ausgegangen und es ist zu spät noch was zu retten. Und was macht der Ami - einfach Laden dicht und weg.Für den Voll-Support gab es jedoch einfach zu wenige die das bezahlen wollten.

Mich würde nur interessieren, welche Möglichkeiten die Kundschaft von OmniTi hat, die einen Vertrag abgeschlossen und bezahlt hat.

Wenn ich lese, dass die beiden zusammen so um die $500.000 bis $600.000 verdienen, da muss ich mich schon fragen -- gehts noch.Wie es genau mit Dan und Dale, den Support Software Ingenieuren für OmniOS bei OmniTi weitergeht ist ja auch noch offen. Wenn die ein entsprechendes Angebot für eine Festanstellung wo auch immer erhalten, sind die eh weg. Auch sind 50k USD/ Jahr Zusagen in einer internen schnellen Umfrage gar nicht so wenig. Das sind ja nur ganz wenige Nutzer und davon gibt es deutlich mehr. OmniOS ist letzlich die führende freie Solaris Distribution bei professionellen Nutzern. Das bisherige Preisgefüge stimmte aber auch nicht. Es muss billiger werden, dafür kann der Leistungsumfang geringer ausfallen. Der Pflegeaufwand für die stable Repositories selbst ist ja auch bei weitem nicht so hoch wie etwa bei OpenIndiana da die ja die gesamte Desktopsoftware mitpflegen. Die OS Entwicklung läuft ja ohnehin woanders (Illumos).

Richtig die 53k sind in knapp einer Woche zusammen gekommen, aber wiederum seit über einer Woche trägt sich kein weiterer mehr ein. Richtig bedenklich finde ich es, dass so manchem dieses Solarish, das so problemfrei durchläuft, gerade mal $50 wert ist.

Also von dem Gehalt der beiden habe ich noch nichts gelesen. Ich bezweifle auch dass es annähernd so hoch ist, auch wenn das absolute OS und System-Spezialisten für Solaris/OmniOS sind und davon gibts nicht so viele.

Eine Aussage über benötigte 500k USD/ Jahr stammt von den Initiatoren der spontanen Sammelaktion. Das sehe ich aber eher als Gesamtkosten einer Firma. Dazu gehören auch Gebäude, Equippment, Strom, Steuern, Labor, Reisen und letztlich auch Telefondame und Buchhaltung.

Ansonst sind 50$/Jahr für Privat so hoch anzusehen wie 5000$/Jahr für eine größere Firma. Das sind in Stunden gerechnet für die 4-5 zu bezahlende Arbeitsstunden pro Monat (Bei niedrig angesetzten 100$/Stunde).

keine Frage zum Management von OmniTi

Das war wie Sun. Tolles Produkt, zuwenig Kunden. Deren anvisierter Markt war aber auch eher einzelne High-Performance Webservice Kunden und weniger normale Storage Kunden

@ MrDeluxe

Napp-it gibt es in einer Basisversion für Debian. Die sollte auch unter Proxmox laufen.

Den Umfang der Solarisversion wird die Linuxversion aber wohl nie erhalten zumal ich selber ausschliesslich Solarish Storage-Installationen einsetze oder betreue.

Eine Aussage über benötigte 500k USD/ Jahr stammt von den Initiatoren der spontanen Sammelaktion. Das sehe ich aber eher als Gesamtkosten einer Firma. Dazu gehören auch Gebäude, Equippment, Strom, Steuern, Labor, Reisen und letztlich auch Telefondame und Buchhaltung.

Ansonst sind 50$/Jahr für Privat so hoch anzusehen wie 5000$/Jahr für eine größere Firma. Das sind in Stunden gerechnet für die 4-5 zu bezahlende Arbeitsstunden pro Monat (Bei niedrig angesetzten 100$/Stunde).

keine Frage zum Management von OmniTi

Das war wie Sun. Tolles Produkt, zuwenig Kunden. Deren anvisierter Markt war aber auch eher einzelne High-Performance Webservice Kunden und weniger normale Storage Kunden

@ MrDeluxe

Napp-it gibt es in einer Basisversion für Debian. Die sollte auch unter Proxmox laufen.

Den Umfang der Solarisversion wird die Linuxversion aber wohl nie erhalten zumal ich selber ausschliesslich Solarish Storage-Installationen einsetze oder betreue.

Zuletzt bearbeitet:

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Bei Appliance Map kann doch in den Eigenschaften eine Info hinterlegt werden. Wie ist es möglich, dass diese Info in der Map auch angezeigt wird?

@gea, besteht noch die Möglichkeit, dass in dieser Map außer "sas_slot" auch noch "vdev" angezeigt wird? Bei einem Mirror-Pool ist diese ergänzende Info sehr hilfreich.

@gea, besteht noch die Möglichkeit, dass in dieser Map außer "sas_slot" auch noch "vdev" angezeigt wird? Bei einem Mirror-Pool ist diese ergänzende Info sehr hilfreich.

Zuletzt bearbeitet:

MrDeluxe

Enthusiast

- Mitglied seit

- 01.04.2006

- Beiträge

- 1.474

- Laptop

- Thinkpad E480, E14, T14s

- Details zu meinem Desktop

- Prozessor

- AMD 3700x @ 4,3 Boost-Overdrive + Thermal Grizzly Aeronaut

- Mainboard

- Gigabyte Aorus Pro X570

- Kühler

- Scythe Fuma 2

- Speicher

- G.Skill - F4-3200C14D-16GFX

- Grafikprozessor

- 5700 XT

- Display

- 1xBenq G2411HD, 1xLG 27GL850-B, 1xBenq G2411HD @ Icy Box Monitor Arm IcyBox 3 – IB-MS405-T

- SSD

- WD Black SN750

- HDD

- Samsung 850Evo, Crucial 120GB @ Linux EOS

- Opt. Laufwerk

- N/A

- Soundkarte

- OnBoard

- Gehäuse

- Fractal Design Define R6 USB-C Blackout

- Netzteil

- be quiet straight power 650W

- Keyboard

- CMSTORM

- Mouse

- MX518

- Betriebssystem

- Win11 + Linux Elementary OS

- Sonstiges

- Mobile Phone - Mi 11 Lite 5G @ lineageOS nightly

- Internet

- ▼1000 ▲500

@ MrDeluxe

Napp-it gibt es in einer Basisversion für Debian. Die sollte auch unter Proxmox laufen.

Den Umfang der Solarisversion wird die Linuxversion aber wohl nie erhalten zumal ich selber ausschliesslich Solarish Storage-Installationen einsetze oder betreue.

@gea: Es ging vielmehr darum, OmniOS inkl. Napp-it als VM unter Proxmox einzurichten als Storage-VM, wie eben bei der ESXi-AiO Lösung.

@gea: Es ging vielmehr darum, OmniOS inkl. Napp-it als VM unter Proxmox einzurichten als Storage-VM, wie eben bei der ESXi-AiO Lösung.

Hier stellt sich die Frage, wie gut

- Solaris als Gast läuft

- man optimierte vnic Treiber hat (wie die schnellen vmxnet3 vnics unter ESXi für praktisch jedes OS)

alternativ müsste man eine physische Nic durchreichen

- wie gut pass-through läuft, Storage virtualisieren wäre nicht optimal

- - - Updated - - -

Was mich interessiert: ich nutze aktuell proxmox mit zfs RAID 1 und ein RAIDz1. Würde napp it mir irgendwelche Vorteile bringen?

ZFS ist ZFS vom Dateisystem her.

Das ist bei BSD. Linux und Solaris das gleiche Dateisystem.

napp-it ändert daran nichts. Es ist ein Tool um auf einer Auswahl von Betriebssystemen

(vorzugsweise Solaris) ein einfach bedienbares webbasiertes NAS/SAN zu machen.

Bei Solaris ist aber die Integration von OS, ZFS und Services wie iSCSI, NFS und SMB

viel besser da das alles vom Hersteller (Oracle, Illumos) entwickelt, direkt gepflegt und mitgeliefert wird.

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Bei Appliance Map kann doch in den Eigenschaften eine Info hinterlegt werden. Wie ist es möglich, dass diese Info in der Map auch angezeigt wird?

@gea, besteht noch die Möglichkeit, dass in dieser Map außer "sas_slot" auch noch "vdev" angezeigt wird? Bei einem Mirror-Pool ist diese ergänzende Info sehr hilfreich.

Die Frontansicht einer 2,5" Platte ist zu klein um alles immer anzuzeigen.

Wenn man allerdings mit der Maus über den Platten-Hersteller geht, wird alles eingeblendet.

Und wenn du es nur für die 3,5'' anzeigst?

Die Anzeige bei Maus-over nützt leider nichts, wenn der Server für Wartung down ist oder die Map ausgedruckt werden soll. Auch wenn z.B. die Spare-HDD oder die zugehörige Mirror-HDD gesucht wird, ist das bei größerer Map eine Sucherei.

Die Map selber möchte ich nicht mit Information überladen.

Was ginge wäre eine zusätzliche Liste zum Ausdrucken mit allen Informationen.

update

Ich habe das in einem Menü Disks > Appliance Map > list maps hinzugefügt

(frei verfügbare 17.04dev)

Gibt eine Liste zum Ausdrucken in der Art

Was ginge wäre eine zusätzliche Liste zum Ausdrucken mit allen Informationen.

update

Ich habe das in einem Menü Disks > Appliance Map > list maps hinzugefügt

(frei verfügbare 17.04dev)

Gibt eine Liste zum Ausdrucken in der Art

Code:

Slots

Slot 01.00.02 c3t5d0 c3t5d0 WDC WD1500HLFS-0 WDWX61C80J7478 150 GB

ONLINE rpool mirror-0 S:0 H:41 T:0 139.7 GiB

Smart: 28 °C Smart health, selftest, type: PASSED without error sat,12

Slot 01.00.03 c3t4d0 c3t4d0 WDC WD1500HLFS-0 WDWXC0CA9P2111 150 GB

ONLINE rpool mirror-0 S:0 H:0 T:0 139.7 GiB

Smart: 29 °C Smart health, selftest, type: PASSED without error sat,12

Dies ist die Bootdisk

Slot 01.01.00 c1:e1:s4 c1t5000CCA249CAE42Ad0 HGST HDN724040AL PK2338P4GSYRVC 4 TB

AVAIL b2 spares S:0 H:0 T:0 3.6 TiB

Smart: 32 °C Smart health, selftest, type: PASSED -- sat,12

Zuletzt bearbeitet:

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

@gea vielen Dank für die schnelle Umsetzung.

Ich druck es mir dann aus, wenn es dann in der 17.xxpro enthalten ist.

-------------

Wo finde ich Informationen was der/die errors z.B. "S:0 H:1 T:47" bedeutet und wie bekomm ich die errors wieder weg?

Einen Neustart vom Server AIO hab ich allerdings noch nicht gemacht.

Ich druck es mir dann aus, wenn es dann in der 17.xxpro enthalten ist.

-------------

Wo finde ich Informationen was der/die errors z.B. "S:0 H:1 T:47" bedeutet und wie bekomm ich die errors wieder weg?

Einen Neustart vom Server AIO hab ich allerdings noch nicht gemacht.

Code:

id part partcap diskcap identify stat state pool vdev error vendor product sn

c3t5000CCA23DCCC6BCd0 (!parted) 4 TB via dd ok ONLINE pool_aio mirror-0 S:0 H:0 T:5 ATA HGST HDS724040AL

c3t5000CCA23DCD21A4d0 (!parted) 4 TB via dd ok ONLINE pool_aio mirror-0 S:0 H:1 T:47 ATA HGST HDS724040AL

c3t5000CCA23DCD25A1d0 (!parted) 4 TB via dd ok ONLINE pool_aio mirror-0 S:0 H:0 T:0 ATA HGST HDS724040ALIostat errors siehe Iostat -E, whats that all about? (The dot in ... --- ...)

Iostat protololliert alle Errors (eigentlich sind es eher Treiber Warnungen/Messages) ab Systemstart.

Man kann die also ausser durch Neustart nicht löschen.

Man sollte das wie Smartwerte als Warnung vor möglichen Problemen sehen.

Iostat protololliert alle Errors (eigentlich sind es eher Treiber Warnungen/Messages) ab Systemstart.

Man kann die also ausser durch Neustart nicht löschen.

Man sollte das wie Smartwerte als Warnung vor möglichen Problemen sehen.

Zuletzt bearbeitet:

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

@gea du hast ja inzwischen OI in "How to Setup napp-it on OmniOS, OpenIndiana, Solaris or Linux" aufgenommen.

Gestern hab ich OI Hipster LiveDVD runtergeladen und in VMWare Workstation12 Player und in ESXi 6.5 installiert. Beides Mal hab ich nach der Install und Neustart erst "pkg update" mit Neustart in neues BE, dann "pkg install open-vm-tools" installiert.

- Bei Beiden konnte ich aber nicht das Gastsystem runterfahren.

- Auch ging im Window nicht die Maussteuerung aus dem Fenster raus

- "pkg uninstall open-vm-tools" hat zwar das Paket deinstalliert, die vm-tools waren aber weiterhin am Laufen. Und so konnte ich bei Beiden keine VMware-Tools installieren.

Sind dir auch solche Probleme aufgefallen?

Vielleicht liegt es an der LiveDVD?

Kann ich die "text install" installieren und Mate-Desktop nachträglich installieren?

Edit:

Der Link in deiner PDF http://www.napp-it.org/doc/downloads/setup_napp-it_os.pdf ist nicht ganz richtig

MATE 1.14 Desktop - OpenIndiana - OpenIndiana Wiki der ist aus dem Archiv, der richtige ist MATE 1.18 Desktop - OpenIndiana - OpenIndiana Wiki

Gestern hab ich OI Hipster LiveDVD runtergeladen und in VMWare Workstation12 Player und in ESXi 6.5 installiert. Beides Mal hab ich nach der Install und Neustart erst "pkg update" mit Neustart in neues BE, dann "pkg install open-vm-tools" installiert.

- Bei Beiden konnte ich aber nicht das Gastsystem runterfahren.

- Auch ging im Window nicht die Maussteuerung aus dem Fenster raus

- "pkg uninstall open-vm-tools" hat zwar das Paket deinstalliert, die vm-tools waren aber weiterhin am Laufen. Und so konnte ich bei Beiden keine VMware-Tools installieren.

Sind dir auch solche Probleme aufgefallen?

Vielleicht liegt es an der LiveDVD?

Kann ich die "text install" installieren und Mate-Desktop nachträglich installieren?

Edit:

Der Link in deiner PDF http://www.napp-it.org/doc/downloads/setup_napp-it_os.pdf ist nicht ganz richtig

MATE 1.14 Desktop - OpenIndiana - OpenIndiana Wiki der ist aus dem Archiv, der richtige ist MATE 1.18 Desktop - OpenIndiana - OpenIndiana Wiki

Zuletzt bearbeitet:

- Das gleichzeitige Drücken von STRG + ALT befreit die Maus aus dem ESXi Windows

- Nicht die normale Webconsole in ESXi 6.5 nutzen sondern die Remote Console.

Die kann man wenn man mit der rechten Maustaste in ESXi auf Console klickt alternativ auswählen.

PS

ESXi 6.5d unter Chrome macht richtig Freude

- Nicht die normale Webconsole in ESXi 6.5 nutzen sondern die Remote Console.

Die kann man wenn man mit der rechten Maustaste in ESXi auf Console klickt alternativ auswählen.

PS

ESXi 6.5d unter Chrome macht richtig Freude

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 1K

[Kaufberatung]

Neuer ZFS Homeserver

- Antworten

- 20

- Aufrufe

- 2K

- Antworten

- 16

- Aufrufe

- 917

- Antworten

- 3

- Aufrufe

- 748